File size: 10,304 Bytes

cadb014 aef0847 cadb014 aef0847 cadb014 aef0847 cadb014 aef0847 cadb014 aef0847 cadb014 aef0847 cadb014 aef0847 cadb014 aef0847 cadb014 aef0847 cadb014 aef0847 cadb014 aef0847 cadb014 aef0847 cadb014 aef0847 cadb014 aef0847 cadb014 aef0847 |

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 |

# 使用 Diffusers 通过 Dreambooth 技术来训练 Stable Diffusion

[Dreambooth](https://dreambooth.github.io/) 是一种使用专门的微调形式来训练 [Stable Diffusion](https://huggingface.co/blog/stable_diffusion) 的新概念技术。一些人用他仅仅使用很少的他们的照片训练出了一个很棒的照片,有一些人用他去尝试新的风格。[🧨 Diffusers](https://github.com/huggingface/diffusers)提供一个Dreambooth[训练脚本](https://github.com/huggingface/diffusers/tree/main/examples/dreambooth).这使得训练不会花费很长时间,但是他比较难筛选正确的超参数并且容易过拟合。

我们做了许多实验来分析不同设置下 Dreambooth 的效果。本文展示了我们的发现和一些小技巧来帮助你在用 Dreambooth 微调 Stable Diffusion 的时候提升结果。

在开始之前,请注意该方法禁止应用在恶意行为上,来生成一些有害的东西,或者在没有相关背景下冒充某人。该模型的训练参照 CreativeML Open RAIL-M 许可。

*注意:该帖子的先前版本已出版为 W&B 报告*

## TL;DR:推荐设置

- Dreambooth 很容易快速过拟合,为了获取高质量图片,我们必须找到一个 "sweet spot" 在训练步骤和学习率之间。我们推荐使用低学习率和逐步增加步数直到达到比较满意的状态策略。

- Dreambooth 需要更多的脸部训练步数。在我们的实验中,当 BS 设置为2,学习率设置为1e-6,800-1200步训练的很好。

- 先前提到的对于当训练脸部时避免过拟合非常重要。但对于其他主题可能影响就没那么大了。

- 如果你看到生成的图片噪声很大质量很低。这通常意味着过拟合了。首先,先尝试上述步骤去避免他。如果生成的图片依旧充满噪声。使用 DDIM 调度器或者运行更多推理步骤(对于我们的实验大概100左右就很好了)

- 训练文本编码器对于UNet的质量有很大影响。我们最优的实验配置包括使用文本编码器微调,低学习率和一个适合的步数。但是,微调文本编码器需要更多的内存,所以理想设置是一个至少24G显存的GPU.使用像 8bit adam,fp 16 ,或梯度累计技巧有可能在像Colab或Kaggle提供的16G的GPU上训练。

- EMA 对于微调不重要

- 没有必要用sks词汇训练 Dreambooth 。最早的实现之一是因为它在词汇中是罕见的 token ,但实际上是一种 rifle .我们的实验或其他像[@nitrosocke](https://huggingface.co/nitrosocke)的例子都表明使用自然语言描述你的目标是没问题的。

## 学习率影响

Dreambooth 很容易过拟合,为了获得好的结果,设置针对你数据集合理的学习率和训练步数。在我们的实验中(细节如下),我们微调了四种不同的数据集用不同的高或低的学习率。总的来说,我们在低学习率的情况下获得了更好的结果。

## 实验设置

所有的实验使用[train_deambooth.py](https://github.com/huggingface/diffusers/tree/main/examples/dreambooth)脚本,使用 AdamW 优化器在2X40G的A00机器上运行。我们采用相同的随机种子和保持所有超参相同,除了学习率,训练步骤和先前保留配置。

对于前三个例子(不同对象),我们微调模型配置为 bs = 4(每个GPU分2个),400步。一个高学习率 = 5e-6,一个低学习率 = 2e-6。无先前保留配置。

最后一个实验尝试把人加入模型,我们使用先去保留配置同时 bs = 2(每个GPU分1个),800-1200步.一个高学习率 = 5e-6,一个低学习率 = 2e-6.

你可以使用 8bit adam,fp16 精度训练,梯度累计去减少内存的需要,并执行相同的实验在一个16G显存的机器上。

#### Toy 猫

高学习率(5e-6)

低学习率(2e-6)

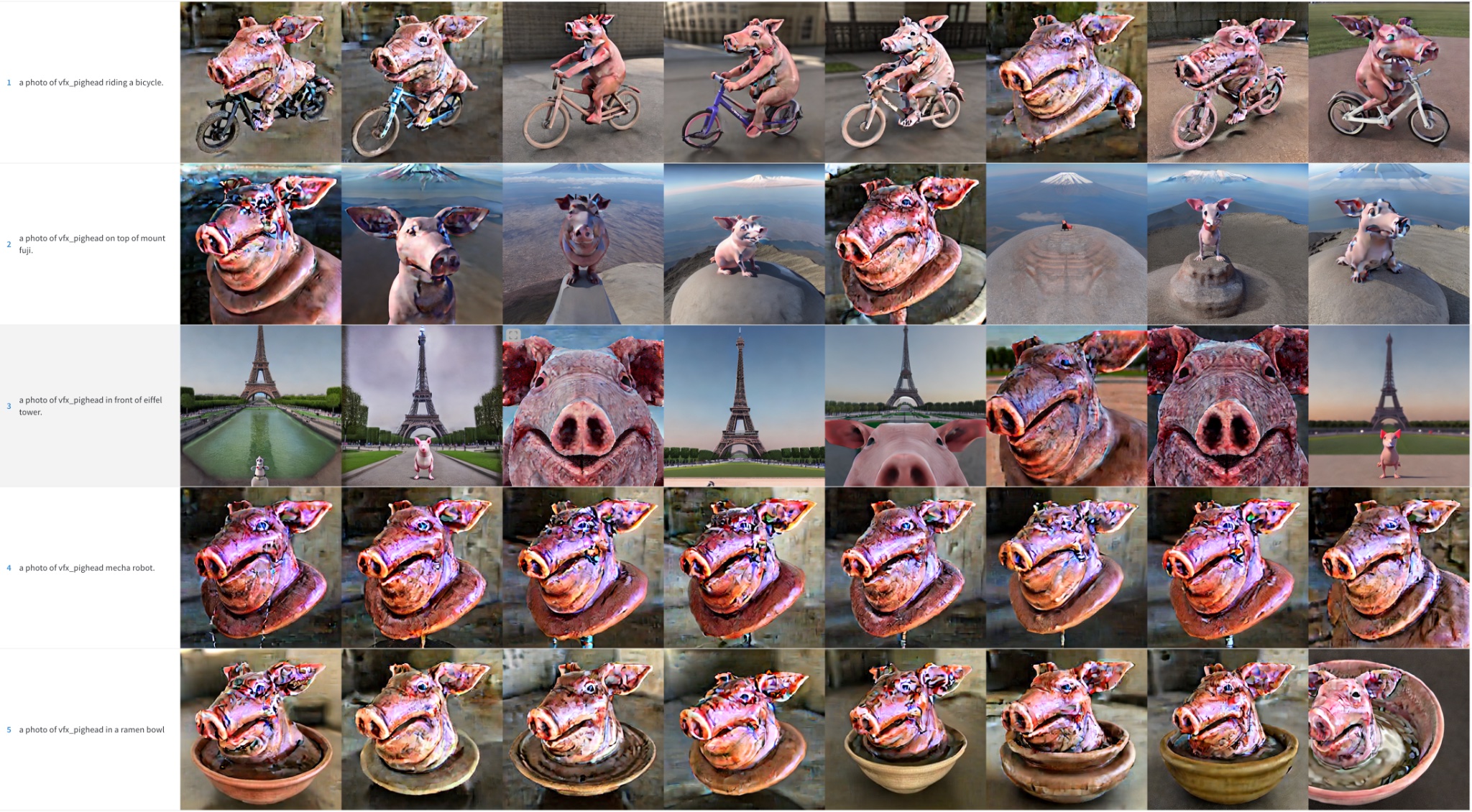

#### 猪头

高学习率(5e-6)请注意,颜色伪像是噪声残余物 - 运行更多的推理步骤可以帮助解决其中一些细节

低学习率(2e-6)

#### 土豆先生的头

高学习率(5e-6)请注意,颜色伪像是噪声残余物 - 运行更多的推理步骤可以帮助解决其中一些细节

低学习率(2e-6)

#### 人脸

我们试图将Seinfeld的Kramer角色纳入Stable Diffusion中。如前所述,我们培训了更小的批量尺寸的更多步骤。即使这样,结果也不是出色的。为了简洁起见,我们省略了这些示例图像,并将读者推迟到下一部分,在这里,面部训练成为我们努力的重点。

### 初始化结果总结

为了用Dreambooth获取更好的Stable Diffusion结果,针对你的数据集调整你的学习率和训练步数非常重要。

- 高学习率多训练步数会导致过拟合。无论使用什么提示,该模型将主要从训练数据中生成图像

- 低学习率少训练步骤会导致欠拟合。该模型将无法生成我们试图组合的概念。

脸部训练非常困难,在我们的实验中,学习率在2e-6同时400步对于物体已经很好了,但是脸部需要学习率在1e-6(或者2e-6)同时1200步才行。

如果发生以下情况,模型过度拟合,则图像质量会降低很多

- 学习率过高

- 训练步数过多

- 对于面部的情况,如下一部分所示,当不使用事先保存时。

## 训练脸部使用先前配置

先前的保存是一种使用我们试图训练的同一类的其他图像作为微调过程的一部分。例如,如果我们尝试将新人纳入模型,我们要保留的类可能是人。事先保存试图通过使用新人的照片与其他人的照片相结合来减少过度拟合。好处是,我们可以使用Stable Diffusion模型本身生成这些其他类图像!训练脚本如果需要的话会自动处理这一点,但是您还可以为文件夹提供自己的先前保存图像

先前配置,1200步数,学习率=2e-6

无先前配置,1200步数,学习率=2e-6

如您所见,当使用先前配置时,结果会更好,但是仍然有嘈杂的斑点。是时候做一些其他技巧了

## 调度程序的效果

在前面的示例中,我们使用 PNDM 调度程序在推理过程中示例图像。我们观察到,当模型过度时,DDIM 通常比 PNDM 和 LMSDISCRETE 好得多。此外,通过推断更多步骤可以提高质量:100似乎是一个不错的选择。附加步骤有助于将一些噪声贴在图像详细信息中。

PNDM, Kramer 脸

LMSDiscrete, Kramer 脸. 结果很糟糕

DDIM, Kramer 脸. 效果好多了

对于其他主题,可以观察到类似的行为,尽管程度较小。

PNDM, 土豆头

LMSDiscrete, 土豆头

DDIM, 土豆头

## 微调文本编码器

原始的 Dreambooth 论文讲述了一个微调 UNet 网络部分但是冻结文本编码部分的方法。然而我们观察到微调文本编码会获得更好的效果。在看到其他 Dreambooth 实施中使用的方法后,我们尝试了这种方法,结果令人惊讶!

冻结文本编码器

微调文本编码器

微调文本编码器会产生最佳结果,尤其是脸。它生成更现实的图像,不太容易过度拟合,并且还可以更好地提示解释性,能够处理更复杂的提示。

## 后记: Textual Inversion+Dreambooth

我们还进行了最后一个实验,将[Textual Inversion](https://textual-inversion.github.io/)与Dreambooth结合在一起。两种技术都有相似的目标,但是它们的方法不同。

在本次实验中我们首先用 Textual Inversion 跑了2000步。接着那个模型我们又跑了 Dreambooth 额外的500步,学习率为1e-6。结果如下:

我们认为,结果比进行简单的 Dreambooth 要好得多,但不如我们调整整个文本编码器时那样好。它似乎可以更多地复制训练图像的样式,因此对它们可能会过度拟合。我们没有进一步探索这种组合,但是这可能是改善 Dreambooth 适合16GB GPU的过程的有趣替代方法。欢迎随时探索并告诉我们您的结果!

<hr>

>>>> 英文原文:[Training Stable Diffusion with Dreambooth using 🧨 Diffusers](https://huggingface.co/blog/dreambooth)

>>>> 译者:innovation64 (李洋)

|