id

int64 2.05k

16.6k

| title

stringlengths 5

75

| fromurl

stringlengths 19

185

| date

timestamp[s] | tags

sequencelengths 0

11

| permalink

stringlengths 20

37

| content

stringlengths 342

82.2k

| fromurl_status

int64 200

526

⌀ | status_msg

stringclasses 339

values | from_content

stringlengths 0

229k

⌀ |

|---|---|---|---|---|---|---|---|---|---|

5,322 | 如何在Ubuntu/CentOS上安装Linux内核4.0 | http://linoxide.com/how-tos/install-linux-kernel-4-0-elrepo-source/ | 2015-04-22T10:08:00 | [

"内核",

"Linux"

] | /article-5322-1.html | 大家好,今天我们学习一下如何从Elrepo或者源代码来安装最新的Linux内核4.0。代号为‘Hurr durr I'm a sheep’的Linux内核4.0是目前为止最新的主干内核。它是稳定版3.19.4之后发布的内核。4月12日是所有的开源运动爱好者的大日子,Linux Torvalds宣布了Linux内核4.0的发布,它现在就已经可用了。由于包括了一些很棒的功能,例如无重启补丁(实时补丁),新的升级驱动,最新的硬件支持以及很多有趣的功能都有新的版本,它原本被期望是一次重要版本。但是实际上内核4.0并不认为是期望中的重要版本,Linus 表示期望4.1会是一个更重要的版本。实时补丁功能已经集成到了SUSE企业版Linux操作系统上。你可以在[发布公告](http://linux.cn/article-5259-1.html)上查看关于这次发布的更多详细内容。

>

> **警告**: 安装新的内核可能会导致你的系统不可用或不稳定。如果你仍然使用以下命令继续安装,请确保备份所有重要数据到外部硬盘。

>

>

>

在Ubuntu 15.04上安装Linux内核4.0

--------------------------

如果你正在使用Linux的发行版Ubuntu 15.04,你可以直接通过Ubuntu内核网站安装。在你的Ubuntu15.04上安装最新的Linux内核4.0,你需要在shell或终端中在root访问权限下运行以下命令。

### 在 64位 Ubuntu 15.04

```

$ wget http://kernel.ubuntu.com/~kernel-ppa/mainline/v4.0-vivid/linux-image-4.0.0-040000-generic_4.0.0-040000.201504121935_amd64.deb

$ wget http://kernel.ubuntu.com/~kernel-ppa/mainline/v4.0-vivid/linux-headers-4.0.0-040000-generic_4.0.0-040000.201504121935_amd64.deb

$ sudo dpkg -i linux-headers-4.0.0*.deb linux-image-4.0.0*.deb

```

### 在 32位 Ubuntu 15.04

```

$ wget http://kernel.ubuntu.com/~kernel-ppa/mainline/v4.0-vivid/linux-image-4.0.0-040000-generic_4.0.0-040000.201504121935_i386.deb

$ wget http://kernel.ubuntu.com/~kernel-ppa/mainline/v4.0-vivid/linux-headers-4.0.0-040000-generic_4.0.0-040000.201504121935_i386.deb

$ sudo dpkg -i linux-headers-4.0.0*.deb linux-image-4.0.0*.deb

```

在CentOS 7上安装Linux内核4.0

----------------------

我们可以用两种简单的方式在CentOS 7上安装Linux内核4.0。

1. 从Elrepo软件仓库安装

2. 从源代码编译安装

我们首先用ElRepo安装,这是最简单的方式:

### 使用 Elrepo 安装

#### **1. 下载和安装ELRepo**

我们首先下载ELRepo的GPG密钥并安装relrepo-release安装包。因为我们用的是CentOS 7,我们使用以下命令安装elrepo-release-7.0-2.el7.elrepo.noarch.rpm。

注: 如果你启用了secure boot,请查看[这个网页获取更多信息](http://elrepo.org/tiki/SecureBootKey)。

```

# rpm --import https://www.elrepo.org/RPM-GPG-KEY-elrepo.org

# rpm -Uvh http://www.elrepo.org/elrepo-release-7.0-2.el7.elrepo.noarch.rpm

```

#### **2. 升级Linux内核到4.0版本**

现在,我们准备从ELRepo软件仓库安装最新的稳定版内核4.0。安装它我们需要在CentOS 7的shell或者终端中输入以下命令。

```

# yum --enablerepo=elrepo-kernel install kernel-ml

```

上面的命令会自动安装为CentOS 7构建的Linux内核4.0。

现在,下面的是另一种方式,通过编译源代码安装最新的内核4.0。

### 从源代码编译安装

#### **1. 安装依赖软件**

首先我们需要为编译linux内核安装依赖的软件。要完成这些,我们需要在一个终端或者shell中运行以下命令。

```

# yum groupinstall "Development Tools"

# yum install gcc ncurses ncurses-devel

```

然后,我们会升级我们的整个系统。

```

# yum update

```

#### **2. 下载源代码**

现在我们通过wget命令从Linux内核的官方仓库中下载最新发布的linux内核4.0的源代码。你也可以使用你的浏览器直接从[kernel.org](http://kernel.org/)网站下载内核。

```

# cd /tmp/

# wget https://www.kernel.org/pub/linux/kernel/v4.x/linux-4.0.tar.xz

```

#### **3. 解压tar压缩包**

文件下载好后我们在/usr/src/文件夹下用以下命令解压。

```

# tar -xf linux-4.0.tar.xz -C /usr/src/

# cd /usr/src/linux-4.0/

```

#### **4. 配置**

配置Linux内核有两种选择的。我们可以创建一个新的自定义配置文件或者使用已有的配置文件来构建和安装Linux内核。这都取决于你自己的需要。

##### **配置新的内核**

现在我们在shell或终端中运行make menuconfig命令来配置Linux内核。我们执行以下命令后会显示一个包含所有菜单的弹出窗口。在这里我们可以选择我们新的内核配置。如果你不熟悉这些菜单,那就敲击ESC键两次退出。

```

# make menuconfig

```

##### **已有的配置**

如果你想用已有的配置文件配置你最新的内核,那就输入下面的命令。如果你对配置有任何调整,你可以选择Y或者N,或者仅仅是按Enter键继续。

```

# make oldconfig

```

#### 5. 编译Linux内核

下一步,我们会执行make命令来编译内核4.0。取决于你的系统配置,编译至少需要20-30分钟。

注:如果编译内核的时候出现`bc command not found`的错误,你可以用**yum install bc**命令安装bc修复这个错误。

```

# make

```

#### 6. 安装Linux内核4.0

编译完成后,我们终于要在你的Linux系统上安装**内核**了。下面的命令会在/boot目录下创建文件并且在Grub 菜单中新建一个内核条目。

```

# make modules_install install

```

#### 7. 验证内核

安装完最新的内核4.0后我们希望能验证它。做这些我们只需要在终端中输入以下命令。如果所有都进展顺利,我们会看到内核版本,例如4.0出现在输出列表中。

```

# uname -r

```

结论

--

好了,我们成功地在我们的CentOS 7操作系统上安装了最新的Linux内核版本4.0。通常并不需要升级linux内核,因为和之前版本运行良好的硬件可能并不适合新的版本。我们要确保它包括能使你的硬件正常工作的功能和配件。但大部分情况下,新的稳定版本内核能使你的硬件性能更好。因此,如果你有任何问题,评论,反馈,请在下面的评论框中注明,让我们知道需要增加或者删除什么问题。多谢!享受最新的稳定版Linux内核4.0吧 :-)

---

via: <http://linoxide.com/how-tos/install-linux-kernel-4-0-elrepo-source/>

作者:[Arun Pyasi](http://linoxide.com/author/arunp/) 译者:[ictlyh](https://github.com/ictlyh) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

| null | HTTPConnectionPool(host='linoxide.com', port=80): Max retries exceeded with url: /how-tos/install-linux-kernel-4-0-elrepo-source/ (Caused by ConnectTimeoutError(<urllib3.connection.HTTPConnection object at 0x7b83275c6770>, 'Connection to linoxide.com timed out. (connect timeout=10)')) | null |

5,328 | 系统管理员的容器时代之殇 | http://www.vitavonni.de/blog/201503/2015031201-the-sad-state-of-sysadmin-in-the-age-of-containers.html | 2015-04-24T11:07:27 | [

"系统管理员",

"Docker",

"容器"

] | https://linux.cn/article-5328-1.html | 系统管理现在处于一个癫狂的时代,一片混乱。

我并不是抱怨老式系统管理员们,他们还是知道如何让系统工作起来,知道怎么更新系统和如何升级扩容。

这篇吐槽是关于容器、预构建虚拟机镜像的,它们真是令人难以置信的混乱,它们的脑子里面就根本没有“可信”和“升级”的概念。

(题图来自 crtdot.com)

举个 Hadoop 的例子,**似乎就没有人知道如何从头构建一份 Hadoop**,它那令人头昏眼花的依赖关系、版本需求和构建工具让人云山雾罩。所有这些“神奇”的工具仍然是通过传统的 make 命令构建的,每个工具都是它自己带的,彼此不兼容,你得按照没有复用意义的“当日路线图”来构建。因为没有人能从头构建,所以现在**大家都从一些不定是哪个的网站去下载已经编译好的二进制**,基本上**没有任何认证和签名**。

这是 NSA 和病毒们的天堂啊!**不需要搞什么破解和漏洞挖掘**,只需要弄个“APP”、虚拟机或 Docker 镜像,人们就会把这些恶意代码弄到他们的网络里面去。

[Debian 的 Hadoop 维基页](https://wiki.debian.org/Hadoop)就是一个典型的例子,基本上,从 2010 年开始人们就已经放弃了从源代码构建一个 Debian 上可用的 Hadoop 包了。

要构建 Apache Bigtop,你首先需要安装 puppet3,然后用它从互联网上下载一些魔法般数据。以 sudo 的权限启动 puppet ,顺便给 NSA 开个后门(举个例子,它会下载和安装一个过期的预编译的 JDK——因为它认为你太笨了,不会安装 Java),然后期待它能顺利构建而不是抛出200行的毫无用处的报错跟踪。

我没有开玩笑,它会试着执行像下面这样的脚本:

```

/bin/bash -c "wget http://www.scala-lang.org/files/archive/scala-2.10.3.deb ; dpkg -x ./scala-2.10.3.deb /"

```

注意,甚至这并没有正常的安装这个包,而只是将其解压缩到你的根目录下!下载时也没有检查任何签名、没有通过 SSL(脚本来自 [Bigtop 的 puppet 清单](https://github.com/apache/bigtop/blob/master/bigtop_toolchain/manifests/scala.pp))。

即便你的构建正常工作了,它也会通过 Maven 下载来自互联网的没有签名的二进制代码,并用这些来构建。

不再写一些干净的、模块化的架构,所有这些现在都牵扯在混乱的依赖里面。我上次看到, hadoop 的类路径已经有 100 多个 jar 了,现在?我打赌它肯定有 150 个了。那些 HBaseGiraphFlumeCrunchPigHiveMahoutSolrSparkElasticsearch 以及 Apache 家族的其它东东都是这样混乱。

所谓**软件栈**,现在的意思是“我也不知道我实际上用的是啥”。

**Maven** 、**ivy** 和 **sbt** 这些即用的工具其实就是让你的系统从互联网下载那些无签名的二进制数据并运行在你的计算机上。

再加上容器,哦天哪,更乱了。

是否想过给容器进行**安全更新**?

基本上,Docker 的思路就是下载一个未签名的二进制并运行它,然后期望它不要将任何后门放到你的公司网络里面去。

这就像是我在90年代时在 Windows 上下载的共享软件一样。什么时候会出现第一个带有 Ask 工具条的 Docker 镜像呢?第一个通过 Docker 镜像传播的互联网蠕虫呢?

回到前些年,Linux 发行版努力着提供一个安全的操作系统,带有签名的软件包、可信的网络、甚至还能完全的重新构建。

而现在呢?什么东西都已经 Windows 化了,到处是疯狂的“App”,你下载,你运行,根本不管是否安全,是否能升级到下个版本。因为你就是“过把瘾就死”!

**更新**:其实在 Docker 之前就有这样的作法了,Docker 只是一个新的 'curl | sudo bash' 而已。是的,这就是主流的、在你的数据中心下载并运行一个不可信软件的方法。这太糟糕了,真的。之前,系统管理员还在努力的防御安全漏洞,现在,他们自称“devops”了,然后很 happy 地把这些东西弄到他们的网络里面了!

| 301 | Moved Permanently | null |

5,329 | 只有几百个字节大小的国际象棋程序 | http://www.linuxlinks.com/article/20150222033906262/ChessBytes.html | 2015-04-25T18:40:10 | [

"游戏",

"国际象棋"

] | https://linux.cn/article-5329-1.html | 当我在这里提到了 ZX81 电脑时,我已经暴露了我的年龄。ZX81 是一个由英国开发者(Sincilair 研究所)生产的家庭电脑,它拥有"高达" 1KB 的内存!上面的 1KB 并不是打印错误,这个家庭电脑确实只配置有 1KB 的板载内存。但这个内存大小上的限制并没有阻止爱好者制作种类繁多的软件。事实上,这个机器引发了一代编程奇才的出现,这让他们掌握了让程序在该机上运行起来的技能。这个机器可以通过一个 16 KB 的内存卡来进行升级,这就提供了更多的编程可能。但未经扩展的 1KB 机器仍然激励着编程者们发布卓越的软件。

我最喜爱的 ZX81 游戏有: 模拟飞行(Flight Simulation), 3D 版怪物迷宫(3D Monster Maze), 小蜜蜂(Galaxians), 以及最重要的 1K ZX Chess。 只有最后一个程序是为未扩展版的 ZX81 电脑设计的。事实上,David Horne 开发的 1K ZX Chess 只使用了仅仅 672 字节的 RAM(LCTT 译注:如果读者有兴趣,可以看看[这里](http://users.ox.ac.uk/%7Euzdm0006/scans/1kchess/)对该程序的代码及解释)。尽管如此,该游戏尽力去实现大多数的国际象棋规则,并提供了一个计算机虚拟对手。虽然一些重要的规则被忽略了(如:王车易位,兵的升变,和吃过路兵) (LCTT 译注:参考了[这里](http://zh.wikibooks.org/zh/%E5%9B%BD%E9%99%85%E8%B1%A1%E6%A3%8B/%E8%A7%84%E5%88%99)和[这里](http://en.wikipedia.org/wiki/Rules_of_chess)),但能够和人工智能相对抗,这仍然令人惊讶。这个游戏占据了我逝去的青春里的相当一部分。

1K ZX Chess 保持了在所有计算机上国际象棋的最小实现的地位长达 33 年之久,直到今年由 BootChess 打破了该记录,紧接着由 Toledo AtomChess 打破。这三个程序都没有实现所有的国际象棋规则,所以为了完整性,我介绍了我最喜爱的那些实现了所有国际象棋规则的极小的国际象棋。

Linux 有着一系列极其强大的国际象棋引擎,如 Stockfish, Critter, Togo II, Crafty, GNU Chess 和 Komodo 。 在这篇文章精选的国际象棋程序虽敌不过这些好的国际象棋程序,但它们展示了使用微不足道的代码库究竟可以实现多少东西。

---

### Toledo Atomchess

你可能已经看到了大量有关 BootChess 新闻报道,这个只用 487 字节写就的国际象棋程序,一举打破了先前最小的国际象棋程序 1K ZX Chess 的记录。所以,Óscar Toledo Gutiérrez 挽起袖子自己编写了一个更加紧凑的国际象棋游戏。Toledo Atomchess 是仅有 481 字节的 x86 汇编代码,都能放到引导扇区里。 在难以置信的代码大小下,这个引擎实现了一个可玩的国际象棋游戏。

特点包括:

* 基本的棋子移动

* 用 ASCII 文本表现的棋盘

* 以代数形式来输入移动(注:如 D2D4)

* 3 层的搜索深度

显然,为了将这个国际象棋程序压缩到 481 字节中,作者必须做出某些牺牲,这些局限包括:

* 没有兵的升变

* 没有王车易位

* 没有吃过路兵

* 没有移动确认

该作者也使用 C,JavaScript 和 Java 来写这个国际象棋程序,每种实现都非常小。

* 网站: [nanochess.org/chess6.html](http://nanochess.org/chess6.html)

* 开发者: Óscar Toledo Gutiérrez

* 协议: 非商业用途可免费使用

* 版本号: -

---

### BootChess

BootChess 是一个国际象棋的极其小巧的计算机实现。这个程序被塞进到仅仅 487 字节里,并可运行在 Windows, Mac OS X 和 Linux 等操作系统。BootChess 的棋盘和棋子单独用文本表示,其中 P 代表兵, Q 用来代表王后,以及“点”代表空白格子。

特点包括:

* 象棋棋盘和用户输入的形象的文本表示

* 引导扇区大小(512 字节)的可玩的象棋游戏

* 只需 x86 bios 硬件引导程序(没有软件依赖)

* 所有主要的正规移动包括双兵开局

* 兵升变为王后(与 1k ZX Chess 相反)

* 名为 taxiMax > minMax half-ply 的 CPU 人工智能

* 硬编码的西班牙白子开局

同样,它也存在一些重要的限制。这些遗漏的功能包括:

* 兵的低升变(升变为非王后的棋子)

* 吃过路兵

* 没有王车易位

* 3 次位置重复和局规则(注:下一步之前,同样的移动出现了两次;可以参考[这里](http://www.netplaces.com/chess-basics/ending-the-game/three-position-repetition.htm))

* 50 步移动和局规则(注:在连续的50个回合内,双方既没有棋子被吃掉,也没有兵被移动过,则和局;可以参考[这里](http://www.chessvariants.org/d.chess/chess.html))

* 没有开放式和封闭式布局

* 一个或多个 minMAX/negaMax 全层人工智能

* 网站: [www.pouet.net/prod.php?which=64962](http://www.pouet.net/prod.php?which=64962)

* 开发者: Olivier "Baudsurfer/RSi" Poudade

* 协议: WTFPL v2

* 版本号: .02

---

### Micro-Max

Micro-Max 是一个用 133 行 C 语言写就的象棋源程序。

作者实现了一个 hash 变换表,该引擎检查输入移动的合法性,以及支持 FIDE(注: World Chess Federation 缩写,参见其[官网](https://www.fide.com/)) 的全部规则,除了低升变。

特点包括:

* 递归的 negamax 搜索

* 反夺的静态搜索

* 反夺规则的扩展

* 迭代深化

* 最佳移动优先的 `排序`

* 存储分数和最佳移动的 Hash 表

* 完整的 FIDE 规则(除了低位升变)和移动合法性检查

还有一个 1433个字符的较大版本,但允许你使用完整的 FIDE 规则的低升变。

* 网站: [home.hccnet.nl/h.g.muller/max-src2.html](http://home.hccnet.nl/h.g.muller/max-src2.html)

* 开发者: Harm Geert Muller

* 协议: The MIT License

* 版本号: 3.2

---

via: <http://www.linuxlinks.com/article/20150222033906262/ChessBytes.html>

作者:Frazer Kline 译者:[FSSlc](https://github.com/FSSlc) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

| 301 | Moved Permanently | null |

5,330 | Mydumper - MySQL数据库备份工具 | http://www.ubuntugeek.com/mydumper-mysql-database-backup-tool.html | 2015-04-25T19:59:00 | [

"MySQL",

"Mydumper"

] | https://linux.cn/article-5330-1.html | Mydumper 是 MySQL 数据库服务器备份工具,它比 MySQL 自带的 mysqldump 快很多。它还有在转储的同时获取远程服务器二进制日志文件的能力。

### Mydumper 的优势

* 并行能力 (因此有高速度) 和性能 (高效的代码避免了耗费 CPU 处理能力的字符集转换过程)

* 更容易管理输出 (每个表都对应独立的文件,转储元数据等,便于查看/解析数据)

* 一致性 :跨线程维护快照, 提供精确的主从日志定位等。

* 可管理性 : 支持用 PCRE 来包含/排除指定的数据库和表(LCTT译注:PCRE,Perl Compatible Regular Expression,Perl兼容正则表达式)

### 在Ubuntu上安装 mydumper

打开终端运行以下命令

```

sudo apt-get install mydumper

```

### 使用 Mydumper

#### 语法

```

mydumper [options]

```

应用程序选项:

* -B, --database 要转储的数据库

* -T, --tables-list 逗号分隔的转储表列表(不会被正则表达式排除)

* -o, --outputdir 保存输出文件的目录

* -s, --statement-size 插入语句的字节大小, 默认是1000000个字节

* -r, --rows 把表按行数切块

* -c, --compress 压缩输出文件

* -e, --build-empty-files 空表也输出文件

* -x, --regex 匹配‘db.table’的正则表达式

* -i, --ignore-engines 以逗号分隔的被忽略的存储引擎列表

* -m, --no-schemas 不转储表架构

* -k, --no-locks 不执行临时共享读锁。警告: 这会导致备份的不一致性

* -l, --long-query-guard 设置长查询的计时器秒数,默认是60秒

* --kill-long-queries 杀死长查询 (而不是退出程序)

* -b, --binlogs 获取二进制日志文件快照并转储数据

* -D, --daemon 开启守护进程模式

* -I, --snapshot-interval 每个转储快照之间的间隔时间(分钟), 需要开启 --daemon, 默认是60分钟

* -L, --logfile 日志文件的名字,默认是stdout

* -h, --host 要连接的主机

* -u, --user 有转储权限的用户名

* -p, --password 用户密码

* -P, --port 连接的TCP/IP端口

* -S, --socket 用于连接的Unix套接字文件

* -t, --threads 使用的线程数,默认是4

* -C, --compress-protocol 在MySQL连接上使用压缩

* -V, --version 查看程序版本号

* -v, --verbose 输出信息的等级, 0 = silent, 1 = errors, 2 = warnings, 3 = info, 默认是2

#### Mydumper 例子

```

mydumper \

--database=$DB_NAME \

--host=$DB_HOST \

--user=$DB_USER \

--password=$DB_PASS \

--outputdir=$DB_DUMP \

--rows=500000 \

--compress \

--build-empty-files \

--threads=2 \

--compress-protocol

```

Mydumper 输出数据的说明

Mydumper 不直接指定输出的文件,而是输出到文件夹的文件中。--outputdir 选项指定要使用的目录名称。

输出分为两部分

**表结构**

对数据库中的每个表,创建一个包含 CREATE TABLE 语句的文件。文件命名为:

dbname.tablename-schema.sql.gz

**数据**

每个表名跟着按 --rows 参数所切块的数量, 创建文件名字为:

dbname.tablename.0000n.sql.gz

"n"从0开始.

你可以使用Myloader恢复这些备份

```

myloader \

--database=$DB_NAME \

--directory=$DB_DUMP \

--queries-per-transaction=50000 \

--threads=10 \

--compress-protocol \

--verbose=3

```

---

via: <http://www.ubuntugeek.com/mydumper-mysql-database-backup-tool.html>

作者:[ruchi](http://www.ubuntugeek.com/author/ubuntufix) 译者:[ictlyh](https://github.com/ictlyh) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

| 200 | OK | # Mydumper – Mysql Database Backup tool

**Sponsored Link**

**Mydumper advantages**

o Parallelism (hence, speed) and performance (avoids expensive character set conversion routines, efficient code overall)

o Easier to manage output (separate files for tables, dump metadata,etc, easy to view/parse data)

o Consistency -- maintains snapshot across all threads, provides accurate master and slave log positions, etc

o Manageability -- supports PCRE for specifying database and tables inclusions and exclusions

**Install mydumper on ubuntu**

Open the terminal and run the following command

sudo apt-get install mydumper

**Using Mydumper**

**Syntax**

mydumper [options]

Application Options:

-B, --database Database to dump

-T, --tables-list Comma delimited table list to dump (does not exclude regex option)

-o, --outputdir Directory to output files to

-s, --statement-size Attempted size of INSERT statement in bytes, default 1000000

-r, --rows Try to split tables into chunks of this many rows

-c, --compress Compress output files

-e, --build-empty-files Build dump files even if no data available from table

-x, --regex Regular expression for ‘db.table' matching

-i, --ignore-engines Comma delimited list of storage engines to ignore

-m, --no-schemas Do not dump table schemas with the data

-k, --no-locks Do not execute the temporary shared read lock. WARNING: This will cause inconsistent backups

-l, --long-query-guard Set long query timer in seconds, default 60

--kill-long-queries Kill long running queries (instead of aborting)

-b, --binlogs Get a snapshot of the binary logs as well as dump data

-D, --daemon Enable daemon mode

-I, --snapshot-interval Interval between each dump snapshot (in minutes), requires --daemon, default 60

-L, --logfile Log file name to use, by default stdout is used

-h, --host The host to connect to

-u, --user Username with privileges to run the dump

-p, --password User password

-P, --port TCP/IP port to connect to

-S, --socket UNIX domain socket file to use for connection

-t, --threads Number of threads to use, default 4

-C, --compress-protocol Use compression on the MySQL connection

-V, --version Show the program version and exit

-v, --verbose Verbosity of output, 0 = silent, 1 = errors, 2 = warnings, 3 = info, default 2

**Mydumper Example**

mydumper \

--database=$DB_NAME \

--host=$DB_HOST \

--user=$DB_USER \

--password=$DB_PASS \

--outputdir=$DB_DUMP \

--rows=500000 \

--compress \

--build-empty-files \

--threads=2 \

--compress-protocol

Description of Mydumper's output data

Mydumper does not output to files, but rather to files in a directory. The --outputdir option specifies the name of the directory to use.

The output is two parts

Schema

For each table in the database, a file containing the CREATE TABLE statement will be created. It will be named:

dbname.tablename-schema.sql.gz

Data

For each table with number of rows above the --rows parameter, you will have a file called:

dbname.tablename.0000n.sql.gz

Where "n" starts with 0 up to the number of.

If you want to restore these backup you can use Myloader

myloader \

--database=$DB_NAME \

--directory=$DB_DUMP \

--queries-per-transaction=50000 \

--threads=10 \

--compress-protocol \

--verbose=3

mydumper –daemon

not running as daemon, it just creates two folders 0 and 1 with databases dups inside, but only once, it does not repeats as it should as per instruction:

mydumper –daemon –snapshot-interval=30

It should run every 30minutes, but it doesnt. |

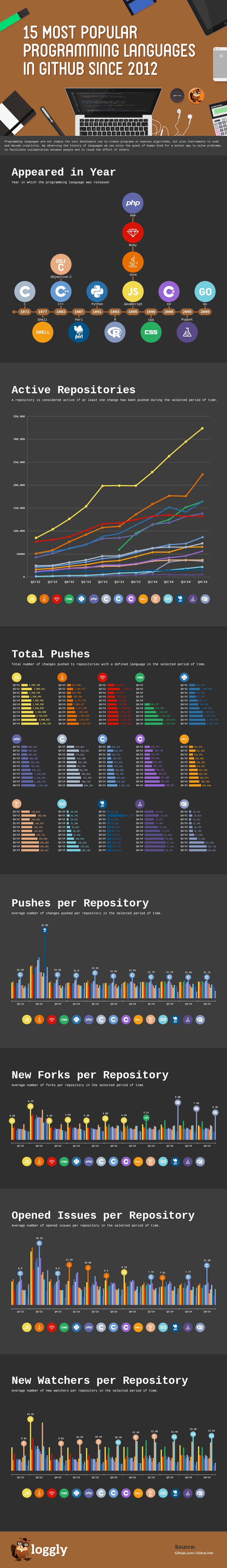

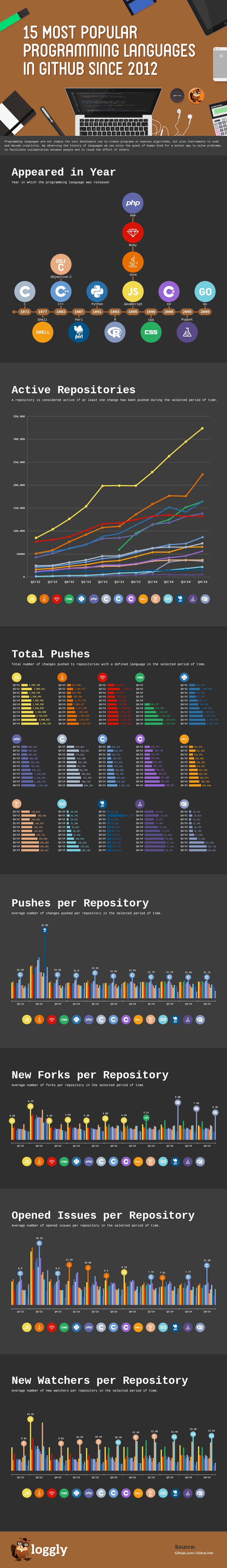

5,331 | GitHub 上最流行的编程语言 | https://www.loggly.com/blog/the-most-popular-programming-languages-in-to-github-since-2012/ | 2015-04-25T21:56:00 | [

"GitHub",

"编程语言"

] | https://linux.cn/article-5331-1.html |

编程语言不仅仅是开发者用来创建程序或表达算法的工具,它们也是对创造力进行编码和解码的仪器。通过观察编程语言的历史,我们在追求为解决问题找到一个更好的方法,促进协作,构建好的产品以及重用他人的工作上得到一个独特的观点。

我们有大约 70% 的客户向我们的服务发送应用日志,因此我们能追踪哪种语言是最流行的,以及哪种语言获得了开发人员的关注。

基于从2012年以来的历史的[GitHub 归档](https://www.githubarchive.org/)和[GitHut](http://githut.info/)数据,我们分析了GitHub上大部分开发者的动作并绘制成你下面看到的信息图表。我们主要关注:

* 活跃库的数量,这是反应了人们正在研究的项目的有用度量。

* 每种语言总的推送数量以及每个库的平均推送次数。这些指标是由某种语言编写的项目的创新效率的指示器。

* 每个库新的fork数和发现的问题数目,这也显示了活跃度和创新性。

* 每个库新的观察者,这是开发人员兴趣的指示器。

查看信息图表并告诉我们你的想法!在你的同龄人中是怎么选择你使用的语言的?

---

via: <https://www.loggly.com/blog/the-most-popular-programming-languages-in-to-github-since-2012/>

作者:[Justin Mares](https://www.loggly.com/blog/author/guest/) 译者:[ictlyh](https://github.com/ictlyh) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

| 200 | OK | # Most popular programming languages in GitHub

Programming languages are not simply the tools that developers use to create programs or express algorithms. They’re also instruments to code and decode creativity. By observing the history of programming languages, we gain a unique perspective on our quest to find better ways to solve problems, facilitate collaboration, build great products, and reuse the efforts of others.

About 70% of our customers send application logs to our service, so Loggly is interested in tracking which are the most popular programming languages and which ones are gaining traction among developers.

Based on the historical [GitHub Archive](https://www.githubarchive.org/) and [GitHut](https://githut.info/) data starting in 2012, we analyzed the most common developer actions within GitHub and turned it into the infographic you see below. We looked at:

- The number of active repositories, a useful proxy for the projects that people are working on right now.

- The total number of pushes per language as well as the average number of pushes per repository. These metrics are indicators of the rate of innovation occurring with projects being written in a particular language.

- New forks and open issues per repository, which also show active use and innovation.

- New watchers per repository, an indicator of developer interest.

** Check out the infographic and let us know what you think! How does your programming language of choice fare among your peers? **

*Click on image to view at full size.*

### Share this Image On Your Site

*The Loggly and SolarWinds trademarks, service marks, and logos are the exclusive property of SolarWinds Worldwide, LLC or its affiliates. All other trademarks are the property of their respective owners.*

**Justin Mares** |

5,332 | 怎样用 WPScan,Nmap 和 Nikto 扫描和检查一个 WordPress 站点的安全性 | http://www.unixmen.com/scan-check-wordpress-website-security-using-wpscan-nmap-nikto/ | 2015-04-26T07:52:00 | [

"WordPress",

"网站安全",

"wpscan",

"nmap"

] | https://linux.cn/article-5332-1.html | ### 介绍

数百万个网站用着 WordPress ,这当然是有原因的。WordPress 是众多内容管理系统中对开发者最友好的,本质上说你可以用它做任何事情。不幸的是,每天都有些吓人的报告说某个主要的网站被黑了,或者某个重要的数据库被泄露了之类的,吓得人一愣一愣的。

如果你还没有安装 WordPress ,可以看下下面的文章。

在基于 Debian 的系统上:

* [如何在 Ubuntu 上安装 WordPress](http://www.unixmen.com/install-wordpress-ubuntu-14-10/)

在基于 RPM 的系统上:

* [如何在 CentOS 上安装 WordPress](http://www.unixmen.com/install-configure-wordpress-4-0-benny-centos-7/)

我之前的文章 [如何安全加固 WordPress 站点](http://www.unixmen.com/secure-wordpress-website/) 里面列出的**备忘录**为读者维护 WordPress 的安全提供了一点帮助。

在这篇文章里面,我将介绍 **wpscan** 的安装过程,以及怎样使用 wpscan 来定位那些已知的会让你的站点变得易受攻击的插件和主题。还有怎样安装和使用一款免费的网络探索和攻击的安全扫描软件 **nmap** 。最后展示的是使用 **nikto** 的步骤。

(题图来自:codersmount.com)

### 用 WPScan 测试 WordPress 中易受攻击的插件和主题

**WPScan** 是一个 WordPress 黑盒安全扫描软件,用 Ruby 写成,它是专门用来寻找已知的 WordPress 的弱点的。它为安全专家和 WordPress 管理员提供了一条评估他们的 WordPress 站点的途径。它的基于开源代码,在 GPLv3 下发行。

#### 下载和安装 WPScan

在我们开始安装之前,很重要的一点是要注意 wpscan 不能在 Windows 下工作,所以你需要使用一台 Linux 或者 OS X 的机器来完成下面的事情。如果你只有 Windows 的系统,拿你可以下载一个 Virtualbox 然后在虚拟机里面安装任何你喜欢的 Linux 发行版本。

WPScan 的源代码放在 Github 上,所以需要先安装 git(LCTT 译注:其实你也可以直接从 Github 上下载打包的源代码,而不必非得装 git )。

```

sudo apt-get install git

```

git 装好了,我们就要安装 wpscan 的依赖包了。

```

sudo apt-get install libcurl4-gnutls-dev libopenssl-ruby libxml2 libxml2-dev libxslt1-dev ruby-dev ruby1.9.3

```

把 wpscan 从 github 上 clone 下来。

```

git clone https://github.com/wpscanteam/wpscan.git

```

现在我们可以进入这个新建立的 wpscan 目录,通过 bundler 安装必要的 ruby 包。

```

cd wpscan

sudo gem install bundler && bundle install --without test development

```

现在 wpscan 装好了,我们就可以用它来搜索我们 WordPress 站点潜在的易受攻击的文件。wpcan 最重要的方面是它能列出不仅是插件和主题,也能列出用户和缩略图的功能。WPScan 也可以用来暴力破解 WordPress —— 但这不是本文要讨论的内容。

#### 更新 WPScan

```

ruby wpscan.rb --update

```

#### 列举插件

要列出所有插件,只需要加上 “--enumerate p” 参数,就像这样:

```

ruby wpscan.rb --url http(s)://www.yoursiteurl.com --enumerate p

```

或者仅仅列出易受攻击的插件:

```

ruby wpscan.rb --url http(s)://www.yoursiteurl.com --enumerate vp

```

下面是一些例子:

```

| Name: ukiscet

| Location: http://********.com/wp-content/plugins/akismet/

| Name: audio-player

| Location: http://********.com/wp-content/plugins/audio-player/

|

| * Title: Audio Player - player.swf playerID Parameter XSS

| * Reference: http://seclists.org/bugtraq/2013/Feb/35

| * Reference: http://secunia.com/advisories/52083

| * Reference: http://osvdb.org/89963

| * Fixed in: 2.0.4.6

| Name: bbpress - v2.3.2

| Location: http://********.com/wp-content/plugins/bbpress/

| Readme: http://********.com/wp-content/plugins/bbpress/readme.txt

|

| * Title: BBPress - Multiple Script Malformed Input Path Disclosure

| * Reference: http://xforce.iss.net/xforce/xfdb/78244

| * Reference: http://packetstormsecurity.com/files/116123/

| * Reference: http://osvdb.org/86399

| * Reference: http://www.exploit-db.com/exploits/22396/

|

| * Title: BBPress - forum.php page Parameter SQL Injection

| * Reference: http://xforce.iss.net/xforce/xfdb/78244

| * Reference: http://packetstormsecurity.com/files/116123/

| * Reference: http://osvdb.org/86400

| * Reference: http://www.exploit-db.com/exploits/22396/

| Name: contact

| Location: http://********.com/wp-content/plugins/contact/

```

#### 列举主题

列举主题和列举插件差不多,只要用"--enumerate t"就可以了。

```

ruby wpscan.rb --url http(s)://www.host-name.com --enumerate t

```

或者只列出易受攻击的主题:

```

ruby wpscan.rb --url http(s)://www.host-name.com --enumerate vt

```

例子的输出:

```

| Name: path

| Location: http://********.com/wp-content/themes/path/

| Style URL: http://********.com/wp-content/themes/path/style.css

| Description:

| Name: pub

| Location: http://********.com/wp-content/themes/pub/

| Style URL: http://********.com/wp-content/themes/pub/style.css

| Description:

| Name: rockstar

| Location: http://********.com/wp-content/themes/rockstar/

| Style URL: http://********.com/wp-content/themes/rockstar/style.css

| Description:

|

| * Title: WooThemes WooFramework Remote Unauthenticated Shortcode Execution

| * Reference: https://gist.github.com/2523147

| Name: twentyten

| Location: http://********.com/wp-content/themes/twentyten/

| Style URL: http://********.com/wp-content/themes/twentyten/style.css

| Description:

```

#### 列举用户

WPscan 也可以用来列举某个 WordPress 站点的用户和有效的登录记录。攻击者常常这么做——为了获得一个用户清单,好进行暴力破解。

```

ruby wpscan.rb --url http(s)://www.host-name.com --enumerate u

```

#### 列举 Timthumb 文件

关于 WPscan ,我要说的最后一个功能是列举 timthub (缩略图)相关的文件。近年来,timthumb 已经成为攻击者眼里的一个常见目标,因为无数的漏洞被找出来并发到论坛上、邮件列表等等地方。用下面的命令可以通过 wpscan 找出易受攻击的 timthub 文件:

```

ruby wpscan.rb --url http(s)://www.host-name.com --enumerate tt

```

### 用 Nmap 扫描你 VPS 的开放端口

**Nmap** 是一个开源的用于网络探索和安全审查方面的工具。它可以迅速扫描巨大的网络,也可一单机使用。Nmap 用原始 IP 数据包通过不同寻常的方法判断网络里那些主机是正在工作的,那些主机上都提供了什么服务(应用名称和版本),是什么操作系统(以及版本),用的什么类型的防火墙,以及很多其他特征。

#### 在 Debian 和 Ubuntu 上下载和安装 nmap

要在基于 Debian 和 Ubuntu 的操作系统上安装 nmap ,运行下面的命令:

```

sudo apt-get install nmap

```

**输出样例**

```

Reading package lists... Done

Building dependency tree

Reading state information... Done

The following NEW packages will be installed:

nmap

0 upgraded, 1 newly installed, 0 to remove and 2 not upgraded.

Need to get 1,643 kB of archives.

After this operation, 6,913 kB of additional disk space will be used.

Get:1 http://mirrors.service.networklayer.com/ubuntu/ precise/main nmap amd64 5.21-1.1ubuntu1 [1,643 kB]

Fetched 1,643 kB in 0s (16.4 MB/s)

Selecting previously unselected package nmap.

(Reading database ... 56834 files and directories currently installed.)

Unpacking nmap (from .../nmap_5.21-1.1ubuntu1_amd64.deb) ...

Processing triggers for man-db ...

Setting up nmap (5.21-1.1ubuntu1) ...

```

#### 举个例子

输出 nmap 的版本:

```

nmap -V

```

或者

```

nmap --version

```

**输出样例**

```

Nmap version 5.21 ( http://nmap.org )

```

#### 在 Centos 上下载和安装 nmap

要在基于 RHEL 的 Linux 上面安装 nmap ,输入下面的命令:

```

yum install nmap

```

**输出样例**

```

Loaded plugins: protectbase, rhnplugin, security

0 packages excluded due to repository protections

Setting up Install Process

Resolving Dependencies

--> Running transaction check

---> Package nmap.x86_64 2:5.51-2.el6 will be installed

--> Finished Dependency Resolution

Dependencies Resolved

================================================================================

Package Arch Version Repository Size

================================================================================

Installing:

nmap x86_64 2:5.51-2.el6 rhel-x86_64-server-6 2.8 M

Transaction Summary

================================================================================

Install 1 Package(s)

Total download size: 2.8 M

Installed size: 0

Is this ok [y/N]: y

Downloading Packages:

nmap-5.51-2.el6.x86_64.rpm | 2.8 MB 00:00

Running rpm_check_debug

Running Transaction Test

Transaction Test Succeeded

Running Transaction

Installing : 2:nmap-5.51-2.el6.x86_64 1/1

Verifying : 2:nmap-5.51-2.el6.x86_64 1/1

Installed:

nmap.x86_64 2:5.51-2.el6

Complete!

```

#### 举个例子

输出 nmap 版本号:

```

nmap --version

```

**输出样例**

```

Nmap version 5.51 ( http://nmap.org )

```

#### 用 Nmap 扫描端口

你可以用 nmap 来获得很多关于你的服务器的信息,它可以让你站在对你的网站不怀好意的人的角度看你自己的网站。

因此,请仅用它测试你自己的服务器或者在行动之前通知服务器的所有者。

nmap 的作者提供了一个测试服务器:

```

scanme.nmap.org

```

有些命令可能会耗时较长:

要扫描一个 IP 地址或者一个主机名(全称域名),运行:

```

nmap 192.168.1.1

```

输出样例:

扫描以获得主机的操作系统:

```

sudo nmap -O 192.168.1.1

```

加上“-”或者“/24”来一次性扫描某个范围里面的多个主机:

```

sudo nmap -PN xxx.xxx.xxx.xxx-yyy

```

扫描某个范围内可用的服务:

```

sudo nmap -sP network_address_range

```

扫描 IP 地址时部进行反向 DNS 解析。多数情况下这会加快你获得结果的速度:

```

sudo nmap -n remote_host

```

扫描一个特定端口而不是所有常用端口:

```

sudo nmap -p port_number remote_host

```

扫描一个网络,找出哪些服务器在线,分别运行了什么服务。

这就是传说中的主机探索或者 ping 扫描:

```

nmap -sP 192.168.1.0/24

```

输出样例:

```

Host 192.168.1.1 is up (0.00035s latency).

MAC Address: BC:AE:C5:C3:16:93 (Unknown)

Host 192.168.1.2 is up (0.0038s latency).

MAC Address: 74:44:01:40:57:FB (Unknown)

Host 192.168.1.5 is up.

Host nas03 (192.168.1.12) is up (0.0091s latency).

MAC Address: 00:11:32:11:15:FC (Synology Incorporated)

Nmap done: 256 IP addresses (4 hosts up) scanned in 2.80 second

```

理解端口配置和如何发现你的服务器上的攻击目标只是确保你的信息和你的 VPS 安全的第一步。

### 用 Nikto 扫描你网站的缺陷

[Nikto](http://www.unixmen.com/install-nikto-web-scanner-check-vulnerabilities) 网络扫描器是一个开源的 web 服务器的扫描软件,它可以用来扫描 web 服务器上的恶意的程序和文件。Nikto 也可以用来检查软件版本是否过期。Nikto 能进行简单而快速地扫描以发现服务器上危险的文件和程序。扫描结束后会给出一个日志文件。`

#### 在 Linux 服务器上下载和安装 Nikto

Perl 在 Linux 上是预先安装好的,所以你只需要从[项目页面](https://cirt.net/nikto/)下载 nikto ,解压到一个目录里面,然后开始测试。

```

wget https://cirt.net/nikto/nikto-2.1.4.tar.gz

```

你可以用某个归档管理工具解包,或者如下同时使用 tar 和 gzip :

```

tar zxvf nikto-2.1.4.tar.gz

cd nikto-2.1.4

perl nikto.pl

```

安装正确的话会得到这样的结果:

```

- ***** SSL support not available (see docs for SSL install) *****

- Nikto v2.1.4

---------------------------------------------------------------------------

+ ERROR: No host specified

-config+ Use this config file

-Cgidirs+ scan these CGI dirs: 'none', 'all', or values like "/cgi/ /cgi-a/"

-dbcheck check database and other key files for syntax errors

-Display+ Turn on/off display outputs

-evasion+ ids evasion technique

-Format+ save file (-o) format

-host+ target host

-Help Extended help information

-id+ Host authentication to use, format is id:pass or id:pass:realm

-list-plugins List all available plugins

-mutate+ Guess additional file names

-mutate-options+ Provide extra information for mutations

-output+ Write output to this file

-nocache Disables the URI cache

-nossl Disables using SSL

-no404 Disables 404 checks

-port+ Port to use (default 80)

-Plugins+ List of plugins to run (default: ALL)

-root+ Prepend root value to all requests, format is /directory

-ssl Force ssl mode on port

-Single Single request mode

-timeout+ Timeout (default 2 seconds)

-Tuning+ Scan tuning

-update Update databases and plugins from CIRT.net

-vhost+ Virtual host (for Host header)

-Version Print plugin and database versions

+ requires a value

Note: This is the short help output. Use -H for full help.

```

这个报错只是告诉我们没有给出必要的参数。SSL 支持可以通过安装相关的 perl ssl 模块得到(sudo apt-get install libnet-ssleay-perl)。

#### 更新 nikto 数据库

在开始使用之前我们需要先更新 nikto 数据库:

```

/usr/local/bin/nikto.pl -update

```

下面的命令可以列出可用的 nikto 插件。

```

nikto.pl -list-plugins // To list the installed plugins //

```

#### 扫描以寻找缺陷

我们用一个 url 来在做个简单的测试。

```

perl nikto.pl -h http://www.host-name.com

```

**输出样例**

会有十分冗长的输出,可能一开始会让人感到困惑。许多 Nikto 的警报会返回 OSVDB 序号。这是由开源缺陷数据库(<http://osvdb.org/>)所指定。你可以在 OSVDB 上找出相关缺陷的深入说明。

```

$ nikto -h http://www.host-name.com

- Nikto v2.1.4

---------------------------------------------------------------------------

+ Target IP: 1.2.3.4

+ Target Hostname: host-name.com

+ Target Port: 80

+ Start Time: 2012-08-11 14:27:31

---------------------------------------------------------------------------

+ Server: Apache/2.2.22 (FreeBSD) mod_ssl/2.2.22 OpenSSL/1.0.1c DAV/2

+ robots.txt contains 4 entries which should be manually viewed.

+ mod_ssl/2.2.22 appears to be outdated (current is at least 2.8.31) (may depend on server version)

+ ETag header found on server, inode: 5918348, size: 121, mtime: 0x48fc943691040

+ mod_ssl/2.2.22 OpenSSL/1.0.1c DAV/2 - mod_ssl 2.8.7 and lower are vulnerable to a remote buffer overflow which may allow a remote shell (difficult to exploit). CVE-2002-0082, OSVDB-756.

+ Allowed HTTP Methods: GET, HEAD, POST, OPTIONS, TRACE

+ OSVDB-877: HTTP TRACE method is active, suggesting the host is vulnerable to XST

+ /lists/admin/: PHPList pre 2.6.4 contains a number of vulnerabilities including remote administrative access, harvesting user info and more. Default login to admin interface is admin/phplist

+ OSVDB-2322: /gallery/search.php?searchstring=<script>alert(document.cookie)</script>: Gallery 1.3.4 and below is vulnerable to Cross Site Scripting (XSS). Upgrade to the latest version. http://www.securityfocus.com/bid/8288.

+ OSVDB-7022: /calendar.php?year=<script>alert(document.cookie);</script>&month=03&day=05: DCP-Portal v5.3.1 is vulnerable to Cross Site Scripting (XSS). http://www.cert.org/advisories/CA-2000-02.html.

+ OSVDB-3233: /phpinfo.php: Contains PHP configuration information

+ OSVDB-3092: /system/: This might be interesting...

+ OSVDB-3092: /template/: This may be interesting as the directory may hold sensitive files or reveal system information.

+ OSVDB-3092: /updates/: This might be interesting...

+ OSVDB-3092: /README: README file found.

+ 6448 items checked: 1 error(s) and 14 item(s) reported on remote host

+ End Time: 2012-08-11 15:52:57 (5126 seconds)

---------------------------------------------------------------------------

+ 1 host(s) tested

$

```

**Nikto** 是一个非常轻量级的通用工具。因为 Nikto 是用 Perl 写的,所以它可以在几乎任何服务器的操作系统上运行。

希望这篇文章能在你检查 wordpress 站点的缺陷的时候给你一些提示。我之前的文章[如何安全加固 WordPress 站点](http://www.unixmen.com/secure-wordpress-website/)记录了一个**清单**,可以让你保护你的 WordPress 站点的工作变得更简单。

有想说的,留下你的评论。

---

via: <http://www.unixmen.com/scan-check-wordpress-website-security-using-wpscan-nmap-nikto/>

作者:[anismaj](http://www.unixmen.com/author/anis/) 译者:[boredivan](https://github.com/boredivan) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

| 301 | Moved Permanently | null |

5,333 | Linux 有问必答:如何在Linux中修复“fatal error: lame/lame.h: No such file or dir | http://ask.xmodulo.com/fatal-error-lame-no-such-file-or-directory.html | 2015-04-26T10:43:25 | [

"lame"

] | /article-5333-1.html |

>

> **提问**: 我尝试着在Linux中编译视频编码器,但是编译提示出错:“fatal error: lame/lame.h: No such file or directory”, 我该如何修复这个错误?

>

>

>

下面的编译错误说明你的系统没有安装LAME库和它的开发文件。

```

fatal error: lame/lame.h: No such file or directory

```

[LAME](http://lame.sourceforge.net/)("LAME Ain't an MP3 Encoder")是一个流行的LPGL授权的MP3编码器。许多视频编码工具使用或者支持LAME,如 [FFmpeg](http://ask.xmodulo.com/compile-ffmpeg-ubuntu-debian.html)、 VLC、 [Audacity](http://xmodulo.com/how-to-cut-split-or-edit-mp3-file-on-linux.html)、 K3b、 RipperX等。

要修复这个编译错误,你需要安装LAME库和开发文件,按照下面的来。

### 在Debian、Ubuntu或者Linux Mint上安装LAME库和安装文件

Debian和它的衍生版在基础库中已经提供了LAME库,因此可以用apt-get直接安装。

```

$ sudo apt-get install libmp3lame-dev

```

### 在Fedora、CentOS/RHEL上安装LAME库和安装文件

在基于RED HAT的版本中,LAME在RPM Fusion的免费仓库中就有,那么你需要先设置[RPM Fusion (免费)仓库](http://xmodulo.com/how-to-install-rpm-fusion-on-fedora.html)。

RPM Fusion设置完成后,如下安装LAME开发包。

```

$ sudo yum --enablerepo=rpmfusion-free-updates install lame-devel

```

在2015年1月,RPM Fusion仓库已经不可以在CentOS/RHEL 7中可用了。因此,这个方法不能用在CentOS/RHEL 7 中。这时你就要从源码安装LAME库了(下面会描述)。

### 在Debian、Ubuntu或者Linux Mint中从源码编译LAME库

如果你希望用不同的编译选项安装自定义的LAME库,你需要自己编译。下面是怎样在基于Debian的系统中编译和安装LAME库(和它的头文件)。

```

$ sudo apt-get install gcc git

$ wget http://downloads.sourceforge.net/project/lame/lame/3.99/lame-3.99.5.tar.gz

$ tar -xzf lame-3.99.5.tar.gz

$ cd lame-3.99.5

$ ./configure --enable-static --enable-shared

$ make

$ sudo make install

```

注意当你运行上面的配置步骤时,你可以根据你的需求启用会禁止不同的选项。运行下面的命令查看不同的编译选项。

```

$ ./configure --help

```

共享/静态的LAME库默认安装在 /usr/local/lib。要让共享库可以被其他程序使用,完成最后一步:

用编辑器打开 /etc/ld.so.conf,加入下面这行。

```

/usr/local/lib

```

接着运行下面的命令,这会将/usr/local/lib中的共享库添加到动态加载缓存中,因此LAME库就可以被其他程序调用了。

```

$ sudo ldconfig

```

### 在Fedora或者CentOS/RHEL中从源码编译LAME库

如果你的发行版(比如 CentOS 7)没有提供预编译的LAME库,或者你想要自定义LAME库,你需要从源码自己编译。下面是在基于Red Hat的系统中编译安装LAME库的方法。

```

$ sudo yum install gcc git

$ wget http://downloads.sourceforge.net/project/lame/lame/3.99/lame-3.99.5.tar.gz

$ tar -xzf lame-3.99.5.tar.gz

$ cd lame-3.99.5

$ ./configure --enable-static --enable-shared

$ make

$ sudo make install

```

运行make之前,你可以在configure中带上合适的选项自定义编译选项。你可以用下面的命令检查可用的选项:

```

$ ./configure --help

```

最后你需要完成最后一步,因为安装在/usr/local/lib的LAME共享库可能在其他程序中不可用。

在/etc/ld.so.conf中添加下面这行:

```

/usr/local/lib

```

接着运行下面的命令。这会添加 /usr/local/lib中的共享库(包括LAME)到动态加载缓存中,让其他程序可以访问到。

```

$ sudo ldconfig

```

---

via: <http://ask.xmodulo.com/fatal-error-lame-no-such-file-or-directory.html>

作者:[Dan Nanni](http://ask.xmodulo.com/author/nanni) 译者:[geekpi](https://github.com/geekpi) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

| null | HTTPConnectionPool(host='ask.xmodulo.com', port=80): Max retries exceeded with url: /fatal-error-lame-no-such-file-or-directory.html (Caused by NameResolutionError("<urllib3.connection.HTTPConnection object at 0x7b83275c6530>: Failed to resolve 'ask.xmodulo.com' ([Errno -2] Name or service not known)")) | null |

5,334 | 如何设置 Linux 上 SSH 登录的 Email 提醒 | http://www.ehowstuff.com/how-to-get-email-alerts-for-ssh-login-on-linux-server/ | 2015-04-26T11:01:08 | [

"SSH",

"安全"

] | https://linux.cn/article-5334-1.html |

虚拟私有服务器 (VPS)上启用 SSH 服务使得该服务器暴露到互联网中,为黑客攻击提供了机会,尤其是当 VPS 还允许root 直接访问时。VPS 应该为每次 SSH 登录成功尝试配置一个自动的 email 警告。 VPS 服务器的所有者会得到各种 SSH 服务器访问日志的通知,例如登录者、登录时间以及来源 IP 地址等信息。这是一个对于服务器拥有者来说,保护服务器避免未知登录尝试的重要安全关注点。这是因为如果黑客使用暴力破解方式通过 SSH 来登录到你的 VPS 的话,后果很严重。在本文中,我会解释如何在 CentOS 6、 CentOS 7、 RHEL 6 和 RHEL 7上为所有的 SSH 用户登录设置一个 email 警告。

1. 使用root用户登录到你的服务器;

2. 在全局源定义处配置警告(/etc/bashrc),这样就会对 root 用户以及普通用户都生效:

```

[root@vps ~]# vi /etc/bashrc

```

将下面的内容加入到上述文件的尾部。

```

echo 'ALERT - Root Shell Access (vps.ehowstuff.com) on:' `date` `who` | mail -s "Alert: Root Access from `who | cut -d'(' -f2 | cut -d')' -f1`" recipient@gmail.com

```

3. 你也可以选择性地让警告只对 root 用户生效:

```

[root@vps ~]# vi .bashrc

```

将下面的内容添加到/root/.bashrc的尾部:

```

echo 'ALERT - Root Shell Access (vps.ehowstuff.com) on:' `date` `who` | mail -s "Alert: Root Access from `who | cut -d'(' -f2 | cut -d')' -f1`" recipient@gmail.com

```

整个配置文件样例:

```

# .bashrc

# User specific aliases and functions

alias rm='rm -i'

alias cp='cp -i'

alias mv='mv -i'

# Source global definitions

if [ -f /etc/bashrc ]; then

. /etc/bashrc

fi

echo 'ALERT - Root Shell Access (vps.ehowstuff.com) on:' `date` `who` | mail -s "Alert: Root Access from `who | cut -d'(' -f2 | cut -d')' -f1`" recipient@gmail.com

```

4. 你也可以选择性地让警告只对特定的普通用户生效(例如 skytech):

```

[root@vps ~]# vi /home/skytech/.bashrc

```

将下面的内容加入到/home/skytech/.bashrc文件尾部:

```

echo 'ALERT - Root Shell Access (vps.ehowstuff.com) on:' `date` `who` | mail -s "Alert: Root Access from `who | cut -d'(' -f2 | cut -d')' -f1`" recipient@gmail.com

```

---

via: <http://www.ehowstuff.com/how-to-get-email-alerts-for-ssh-login-on-linux-server/>

作者:[skytech](http://www.ehowstuff.com/author/mhstar/) 译者:[theo-l](https://github.com/theo-l) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

| 301 | Moved Permanently | null |

5,335 | 怎样在 CentOS 7.0 上安装和配置 VNC 服务器 | http://linoxide.com/linux-how-to/install-configure-vnc-server-centos-7-0/ | 2015-04-26T14:24:00 | [

"VNC"

] | /article-5335-1.html | 这是一个关于怎样在你的 CentOS 7 上安装配置 [VNC](http://en.wikipedia.org/wiki/Virtual_Network_Computing) 服务的教程。当然这个教程也适合 RHEL 7 。在这个教程里,我们将学习什么是 VNC 以及怎样在 CentOS 7 上安装配置 [VNC 服务器](http://en.wikipedia.org/wiki/Virtual_Network_Computing)。

我们都知道,作为一个系统管理员,大多数时间是通过网络管理服务器的。在管理服务器的过程中很少会用到图形界面,多数情况下我们只是用 SSH 来完成我们的管理任务。在这篇文章里,我们将配置 VNC 来提供一个连接我们 CentOS 7 服务器的方法。VNC 允许我们开启一个远程图形会话来连接我们的服务器,这样我们就可以通过网络远程访问服务器的图形界面了。

VNC 服务器是一个自由开源软件,它可以让用户可以远程访问服务器的桌面环境。另外连接 VNC 服务器需要使用 VNC viewer 这个客户端。

一些 VNC 服务器的优点:

* 远程的图形管理方式让工作变得简单方便。

* 剪贴板可以在 CentOS 服务器主机和 VNC 客户端机器之间共享。

* CentOS 服务器上也可以安装图形工具,让管理能力变得更强大。

* 只要安装了 VNC 客户端,通过任何操作系统都可以管理 CentOS 服务器了。

* 比 ssh 图形转发和 RDP 连接更可靠。

那么,让我们开始安装 VNC 服务器之旅吧。我们需要按照下面的步骤一步一步来搭建一个可用的 VNC。

首先,我们需要一个可用的桌面环境(X-Window),如果没有的话要先安装一个。

**注意:以下命令必须以 root 权限运行。要切换到 root ,请在终端下运行“sudo -s”,当然不包括双引号(“”)**

### 1. 安装 X-Window

首先我们需要安装 [X-Window](http://en.wikipedia.org/wiki/X_Window_System),在终端中运行下面的命令,安装会花费一点时间。

```

# yum check-update

# yum groupinstall "X Window System"

```

```

#yum install gnome-classic-session gnome-terminal nautilus-open-terminal control-center liberation-mono-fonts

```

```

### 设置默认启动图形界面

# unlink /etc/systemd/system/default.target

# ln -sf /lib/systemd/system/graphical.target /etc/systemd/system/default.target

```

```

# reboot

```

在服务器重启之后,我们就有了一个工作着的 CentOS 7 桌面环境了。

现在,我们要在服务器上安装 VNC 服务器了。

### 2. 安装 VNC 服务器

现在要在我们的 CentOS 7 上安装 VNC 服务器了。我们需要执行下面的命令。

```

# yum install tigervnc-server -y

```

### 3. 配置 VNC

然后,我们需要在 `/etc/systemd/system/` 目录里创建一个配置文件。我们可以将 `/lib/systemd/sytem/vncserver@.service` 拷贝一份配置文件范例过来。

```

# cp /lib/systemd/system/vncserver@.service /etc/systemd/system/vncserver@:1.service

```

接着我们用自己最喜欢的编辑器(这儿我们用的 **nano** )打开 `/etc/systemd/system/vncserver@:1.service` ,找到下面这几行,用自己的用户名替换掉 。举例来说,我的用户名是 linoxide 所以我用 linoxide 来替换掉 :

```

ExecStart=/sbin/runuser -l <USER> -c "/usr/bin/vncserver %i"

PIDFile=/home/<USER>/.vnc/%H%i.pid

```

替换成

```

ExecStart=/sbin/runuser -l linoxide -c "/usr/bin/vncserver %i"

PIDFile=/home/linoxide/.vnc/%H%i.pid

```

如果是 root 用户则

```

ExecStart=/sbin/runuser -l root -c "/usr/bin/vncserver %i"

PIDFile=/root/.vnc/%H%i.pid

```

好了,下面重启 systemd 。

```

# systemctl daemon-reload

```

最后还要设置一下用户的 VNC 密码。要设置某个用户的密码,必须要有能通过 sudo 切换到用户的权限,这里我用 linoxide 的权限,执行“`su linoxide`”就可以了。

```

# su linoxide

$ sudo vncpasswd

```

**确保你输入的密码多于6个字符**

### 4. 开启服务

用下面的命令(永久地)开启服务:

```

$ sudo systemctl enable vncserver@:1.service

```

启动服务。

```

$ sudo systemctl start vncserver@:1.service

```

### 5. 防火墙设置

我们需要配置防火墙来让 VNC 服务正常工作。

```

$ sudo firewall-cmd --permanent --add-service vnc-server

$ sudo systemctl restart firewalld.service

```

现在就可以用 IP 和端口号(LCTT 译注:例如 192.168.1.1:1 ,这里的端口不是服务器的端口,而是视 VNC 连接数的多少从1开始排序)来连接 VNC 服务器了。

### 6. 用 VNC 客户端连接服务器

好了,现在已经完成了 VNC 服务器的安装了。要使用 VNC 连接服务器,我们还需要一个在本地计算机上安装的仅供连接远程计算机使用的 VNC 客户端。

你可以用像 [Tightvnc viewer](http://www.tightvnc.com/) 和 [Realvnc viewer](https://www.realvnc.com/) 的客户端来连接到服务器。

要用更多的用户连接,需要创建配置文件和端口,请回到第3步,添加一个新的用户和端口。你需要创建 `vncserver@:2.service` 并替换配置文件里的用户名和之后步骤里相应的文件名、端口号。**请确保你登录 VNC 服务器用的是你之前配置 VNC 密码的时候使用的那个用户名**。

VNC 服务本身使用的是5900端口。鉴于有不同的用户使用 VNC ,每个人的连接都会获得不同的端口。配置文件名里面的数字告诉 VNC 服务器把服务运行在5900的子端口上。在我们这个例子里,第一个 VNC 服务会运行在5901(5900 + 1)端口上,之后的依次增加,运行在5900 + x 号端口上。其中 x 是指之后用户的配置文件名 `vncserver@:x.service` 里面的 x 。

在建立连接之前,我们需要知道服务器的 IP 地址和端口。IP 地址是一台计算机在网络中的独特的识别号码。我的服务器的 IP 地址是96.126.120.92,VNC 用户端口是1。

执行下面的命令可以获得服务器的公网 IP 地址(LCTT 译注:如果你的服务器放在内网或使用动态地址的话,可以这样获得其公网 IP 地址)。

```

# curl -s checkip.dyndns.org|sed -e 's/.*Current IP Address: //' -e 's/<.*$//'

```

### 总结

好了,现在我们已经在运行 CentOS 7 / RHEL 7 的服务器上安装配置好了 VNC 服务器。VNC 是自由开源软件中最简单的一种能实现远程控制服务器的工具,也是一款优秀的 Teamviewer Remote Access 替代品。VNC 允许一个安装了 VNC 客户端的用户远程控制一台安装了 VNC 服务的服务器。下面还有一些经常使用的相关命令。好好玩!

#### 其他命令:

* 关闭 VNC 服务。

```

# systemctl stop vncserver@:1.service

```

* 禁止 VNC 服务开机启动。

```

# systemctl disable vncserver@:1.service

```

* 关闭防火墙。

```

# systemctl stop firewalld.service

```

---

via: <http://linoxide.com/linux-how-to/install-configure-vnc-server-centos-7-0/>

作者:[Arun Pyasi](http://linoxide.com/author/arunp/) 译者:[boredivan](https://github.com/boredivan) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

| null | HTTPConnectionPool(host='linoxide.com', port=80): Max retries exceeded with url: /linux-how-to/install-configure-vnc-server-centos-7-0/ (Caused by ConnectTimeoutError(<urllib3.connection.HTTPConnection object at 0x7b83275c5fc0>, 'Connection to linoxide.com timed out. (connect timeout=10)')) | null |

5,336 | Debian 8 "Jessie" 发布! | https://www.debian.org/News/2015/20150426 | 2015-04-26T20:43:05 | [

"Debian",

"Debian 8",

"Jessie"

] | https://linux.cn/article-5336-1.html | **2015年4月25日** ,在经历了近24个月的持续开发之后,Debian 项目自豪地宣布最新的稳定版本8的发布(代号 “**Jessie**” ),归功于[Debian安全团队](http://security-team.debian.org/)和[Debian长期支持](https://wiki.debian.org/LTS)团队的工作,该版本将在接下来的5年内获得支持。

“**Jessie**” 与新的默认 init 系统 `systemd` 一同到来。`systemd` 套件提供了许多激动人心的特性,如更快的启动速度、系统服务的 cgroups 支持、以及独立出部分服务的可能性。不过,`sysvinit` init系统在 “**Jessie**” 中依然可用。

在 “**Wheezy**” 中引入的 UEFI 支持(*“Unified Extensible Firmware Interface”*,统一的可扩展固件接口)同样在 “**Jessie**” 中得到了大幅改进。其中包含了许多已知固件 bug 的临时性解决方案,支持32位系统上的UEFI,也支持64位内核运行在32位 UEFI 固件上(后者仅被包含在我们的 `amd64/i386` “multi-arch” 安装介质中)。

自上个版本发布以来,Debian 项目的成员同样对我们的支持服务做出了重要改进。其中之一是[可浏览所有 Debian 的源码](https://www.debian.org/News/weekly/2013/14/#sources),该服务目前放在 [sources.debian.net](https://sources.debian.net/)。当然,在超过20000个源码包里想要找到正确的文件确实令人望而生畏。因此,我们同样十分高兴地上线 [Debian 代码搜索](https://www.debian.org/News/weekly/2014/17/#DCS),它放在 [codesearch.debian.net](https://codesearch.debian.net/)。这两项服务都由一个完全重写并且更加反应敏捷的[包追踪系统](https://tracker.debian.org/)提供。

该版本包含大量的软件包更新,如:

* Apache 2.4.10

* Asterisk 11.13.1

* GIMP 2.8.14

* 一个GNOME桌面环境 3.14 的升级版本

* GCC 编译器 4.9.2

* Icedove 31.6.0 (一个 Mozilla Thunderbird 的再发布版本)

* Iceweasel 31.6.0esr (一个 Mozilla Firefox 的再发布版本)

* KDE Plasma Workspaces 和 KDE Applications 4.11.13

* LibreOffice 4.3.3

* Linux 3.16.7-ctk9

* MariaDB 10.0.16 和 MySQL 5.5.42

* Nagios 3.5.1

* OpenJDK 7u75

* Perl 5.20.2

* PHP 5.6.7

* PostgreSQL 9.4.1

* Python 2.7.9 和 3.4.2

* Samba 4.1.17

* Tomcat 7.0.56 和 8.0.14

* Xen Hypervisor 4.4.1

* Xfce 4.10桌面环境

* 超过43000个其它可供使用的软件包,从将近20100个源码包编译而来

与如此之多的软件包选择和照例的广泛架构支持,Debian 再次向它的目标:成为通用操作系统迈出正确的一步。Debian 适用于各种不同情形:从桌面系统到上网本;从开发服务器到集群系统;以及数据库,web,或存储服务器。同时,在此基础之上的质量保证工作,如对 Debian 上所有包的自动安装和升级测试,让 “**Jessie**” 可以满足用户拥有一个稳定的 Debian 版本的高期望值。

总共支持十种架构:32位PC/Intel IA-32(`i386`),64位PC/Intel EM64T / x86-64 (`amd64`),Motorola/IBM PowerPC (旧硬件的`powerpc`和新的64位`ppc64el`(little-endian)),MIPS (`mips` 大端和 `mipsel`小端),IBM S/390 (64位 `s390x`)以及 ARM 新老32位硬件的`armel`和`armhf`,加上给新64位 *“AArch64”* 架构的`arm64`。

### 想尝试一下?

如果你仅仅是想在不安装的情况下体验 Debian 8 “**Jessie**”,你可以使用一个特殊的镜像,即 live 镜像,可以用在 CD,U 盘以及网络启动设置上。最先只有 `amd64` 和 `i386` 架构提供这些镜像。Live 镜像同样可以用来安装 Debian。更多信息请访问 [Debian Live 主页](http://live.debian.net/)。

但是如果你想安装 Debian 到你的计算机的话,有不少安装媒介可供你选择,如蓝光碟,DVD,CD 以及 U 盘,或者从网络安装。有几种桌面环境:GNOME,KDE Plasma 桌面及 Plasma 应用,Xfce 以及 LXDE,它们可以从CD镜像中安装,也可以从 CD/DVD 的启动菜单里选择想要的桌面环境。另外,同样提供了多架构 CD 和 DVD,可以从单一磁盘选择安装不同架构的系统。或者你还可以创建可启动 U 盘安装媒介(参看[安装指南](https://www.debian.org/releases/jessie/installmanual)获得更多细节)。对云用户,Debian 还提供了[预构建 OpenStack 镜像](http://cdimage.debian.org/cdimage/openstack/current/)可供使用。

安装镜像现在同样可以通过 [bittorrent](https://www.debian.org/CD/torrent-cd/)(推荐下载方式),[jigdo](https://www.debian.org/CD/jigdo-cd/#which) 或 [HTTP](https://www.debian.org/CD/http-ftp/) 下载,查看[Debian 光盘](https://www.debian.org/CD/)获得更进一步的信息。“**Jessie**” 不久将提供实体 DVD,CD-ROM,以及无数[供应商](https://www.debian.org/CD/vendors)的蓝光碟。

### 升级 Debian

如果从前一个版本 Debian 7(代号 “**Wheezy**” )升级到 Debian 8,大部分配置情况 apt-get 包管理工具都能够自动解决。Debian 系统一如既往地能够就地无痛升级,无需强制停机。强烈推荐阅读[发行注记](https://www.debian.org/releases/jessie/releasenotes)和[安装指南](https://www.debian.org/releases/jessie/installmanual)来了解可能存在的问题,并了解安装和升级建议。发行注记会在发布后的几周内进一步改进,并翻译成其他语言。

关于 Debian

---------

Debian 是一个自由操作系统,由成千上万来自全世界的志愿者通过互联网协作开发。Debian 项目的关键力量是它的志愿者基础,它对 Debian 社群契约和自由软件的贡献,以及对提供最好的操作系统可能的承诺。Debian 8是其前进方向上又一重要一步。

联系信息

----

获取更多信息,请访问 Debian 主页 <https://www.debian.org/> 或发送电子邮件至[press@debian.org](mailto:press@debian.org)。

---

via: <https://www.debian.org/News/2015/20150426>

译者:[alim0x](https://github.com/alim0x) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

| 200 | OK | # Debian 8 Jessie

released

**April 25th, 2015**

After almost 24 months of constant development the Debian project is

proud to present its new stable version 8 (code name Jessie

),

which will be supported for the next 5 years thanks to the combined

work of the [Debian Security

team](http://security-team.debian.org/) and of the [Debian Long Term

Support](https://wiki.debian.org/LTS) team.

Jessie

ships with a new default init system, `systemd`

. The

`systemd`

suite provides many exciting features such as faster

boot times, cgroups for services, and the possibility of isolating part of

the services. The `sysvinit`

init system is still available

in Jessie

.

The UEFI (Unified Extensible Firmware Interface

) support introduced in

Wheezy

has also been greatly improved in Jessie.

This includes workarounds for many known firmware bugs, support

for UEFI on 32-bit systems, and support for 64-bit kernels with 32-bit UEFI

firmware (with the latter being included only on our `amd64/i386`

multi-arch

installation media).

Since the previous release, members of the Debian project have also

made important improvements to our supporting services. One of these is [a browsable

view of all source code shipped in Debian](https://www.debian.org/News/weekly/2013/14/#sources) currently available at

[sources.debian.net](https://sources.debian.net). Of

course, with over 20,000 source packages, it can be quite daunting to

locate the right file. Therefore, we are also very

pleased to present [Debian Code

Search](https://www.debian.org/News/weekly/2014/17/#DCS), available at [codesearch.debian.net](https://codesearch.debian.net/).

Both services are complemented by a completely rewritten and more

responsive [package tracking system](https://tracker.debian.org/).

This release includes numerous updated software packages, such as:

- Apache 2.4.10

- Asterisk 11.13.1

- GIMP 2.8.14

- an updated version of the GNOME desktop environment 3.14

- GNU Compiler Collection 4.9.2

- Icedove 31.6.0 (an unbranded version of Mozilla Thunderbird)

- Iceweasel 31.6.0esr (an unbranded version of Mozilla Firefox)

- KDE Plasma Workspaces and KDE Applications 4.14.2

- LibreOffice 4.3.3

- Linux 3.16.7-ckt9

- MariaDB 10.0.16 and MySQL 5.5.42

- Nagios 3.5.1

- OpenJDK 7u75

- Perl 5.20.2

- PHP 5.6.7

- PostgreSQL 9.4.1

- Python 2.7.9 and 3.4.2

- Samba 4.1.17

- Tomcat 7.0.56 and 8.0.14

- Xen Hypervisor 4.4.1

- the Xfce 4.10 desktop environment

- more than 43,000 other ready-to-use software packages, built from nearly 20,100 source packages.

With this broad selection of packages and its traditional wide architecture support,

Debian once again stays true

to its goal of being the universal operating system. It is suitable

for many different use cases: from desktop systems to netbooks; from

development servers to cluster systems; and for database, web, or

storage servers. At the same time, additional quality assurance

efforts like automatic installation and upgrade tests for all packages

in Debian's archive ensure that Jessie

fulfills the high

expectations that users have of a stable Debian release.

A total of ten architectures are supported: 32-bit PC / Intel IA-32

(`i386`

), 64-bit PC / Intel EM64T / x86-64

(`amd64`

), Motorola/IBM PowerPC (`powerpc`

for

older hardware and `ppc64el`

for the new 64-bit

(little-endian)), MIPS (`mips`

(big-endian) and

`mipsel`

(little-endian)), IBM S/390 (64-bit

`s390x`

) and for ARM, `armel`

and `armhf`

for old and new 32-bit hardware, plus `arm64`

for the new 64-bit

AArch64

architecture.

### Want to give it a try?

If you simply want to try Debian 8 Jessie

without having to install it, you can use a

special image, known as a live image, available for CDs, USB sticks, and netboot

setups. Initially, these images are provided for the `amd64`

and

`i386`

architectures only. It is also possible to use these live

images to install Debian. More information is available from the

[Debian Live homepage](http://live.debian.net/).

If, instead, you want to install it to your computer's permanent storage, you can choose from

a range of installation media, such as Blu-ray Discs, DVDs,

CDs, and USB sticks, or from the network. Several desktop environments —

GNOME, KDE Plasma Desktop and Applications, Xfce, and LXDE — may be

installed through CD images; the desired one may be chosen from the boot menus

of the CDs/DVDs. In addition, multi-architecture CDs and DVDs are available

which support installation of multiple architectures from a single disc.

Or you can always create bootable USB installation media

(see the [Installation Guide](../../releases/jessie/installmanual)

for more details). For cloud users Debian also offers

[pre-built

OpenStack images](https://cdimage.debian.org/cdimage/openstack/current/), ready to use.

The installation images may be downloaded right now via

[bittorrent](../../CD/torrent-cd/) (the recommended method),

[jigdo](../../CD/jigdo-cd/#which), or

[HTTP](../../CD/http-ftp/); see

[Debian on CDs](../../CD/) for further information. Jessie

will

soon be available on physical DVD, CD-ROM, and Blu-ray Discs from

numerous [vendors](../../CD/vendors) too.

### Upgrading Debian

Upgrades to Debian 8 from the previous release, Debian

7 (codenamed Wheezy

), are automatically handled by

the apt-get package management tool for most configurations.

As always, Debian systems may be upgraded painlessly, in place,

without any forced downtime, but it is strongly recommended to read

the [release notes](../../releases/jessie/releasenotes) as well as

the [installation guide](../../releases/jessie/installmanual)

for possible issues, and for detailed instructions on installing and

upgrading. The release notes will be further improved and translated

to additional languages in the weeks after the release.

## About Debian

Debian is a free operating system, developed by thousands of volunteers from all over the world who collaborate via the Internet. The Debian project's key strengths are its volunteer base, its dedication to the Debian Social Contract and Free Software, and its commitment to provide the best operating system possible. Debian 8 is another important step in that direction.

## Contact Information

For further information, please visit the Debian web pages at

[https://www.debian.org/](../../) or send mail to

<press@debian.org>. |

5,337 | 在Linux上安装使用‘Go for it!’备忘软件 | http://itsfoss.com/go-for-it-to-do-app-in-linux/ | 2015-04-27T10:27:41 | [

"备忘软件"

] | https://linux.cn/article-5337-1.html |

你在 Linux 桌面是如何管理任务和备忘的?我喜欢[用 Ubuntu 的粘帖便签](http://itsfoss.com/indicator-stickynotes-windows-like-sticky-note-app-for-ubuntu/)很久了。但是我要面对与其他设备同步的麻烦,特别是我的智能手机。这就是我为什么选择使用 [Google Keep](http://itsfoss.com/install-google-keep-ubuntu-1310/) 的原因了。

Google Keep 是一款功能丰富的软件,我十分喜爱,而且喜欢到把它叫做 [Linux 的 Evernote](http://itsfoss.com/5-evernote-alternatives-linux/) 地步。但是并不是每个人都喜欢一款功能丰富的备忘录软件。极简主义是目前的主流,很多人喜欢。如果你是极简主义的追求者之一,而且正在寻找一款开源的备忘录软件,那么你应该试一试 [Go For It!](http://manuel-kehl.de/projects/go-for-it/)。

### Go For It!高效的Linux桌面软件

Go For It!是一款简洁的备忘软件,借助定时提醒帮助你专注于工作。所以,当你添加一个任务到列表后,可以附上一个定时器。到设定时间后,它就会提醒你去做任务。你可以看看其帅哥开发者 [Manuel Kehl](http://manuel-kehl.de/about-me/) 制作的视频(youtube 视频) : <https://www.youtube.com/watch?v=mnw556C9FZQ>

### 安装 Go For It!

要在 Ubuntu 15.04,14.04 和其他基于 Ubuntu 的Linux 发行版,如Linux Mint, elementary OS Freya 等上面安装 Go For It!请使用这款软件官方的 PPA:

```

sudo add-apt-repository ppa:mank319/go-for-it

sudo apt-get update

sudo apt-get install go-for-it

```

你也可以下载 .deb 包,Windows 安装包和源代码,链接如下:

* [Download source code](https://github.com/mank319/Go-For-It)

* [Download .deb binaries](https://launchpad.net/%7Emank319/+archive/ubuntu/go-for-it)

* [Download for Windows](http://manuel-kehl.de/projects/go-for-it/download-windows-version/)

### 在Linux桌面使用 Go For It!

Go For It!使用真心方便。你只需添加任务到列表中,任务会自动存入 todo.txt 文件中。

每个任务默认定时25分钟。

任务一旦完成,就会被自动存档到 done.txt 文件中。根据设置,它会在规定的时间间隔或者任务过期前不久,发送桌面提醒:

你可以从配置里面修改所有的偏好。

目前一切都看着挺好。但是在智能手机上使用体验怎样呢?如果你不能使它在不同设备间同步,那这款高效软件就是不完整的。好消息是 Go For It!是基于 [todo.txt](http://todotxt.com/) 的,这意味着你可以用第三方软件和像 Dropbox 一样的云服务来使用它。

### 在安卓手机和平板上使用Go For It!

在这里你需要做一些工作。首先的首先,在 Linux 和你的安卓手机上安装 Dropbox,如果之前没有安装的话。下一步你要做的就是要配置 Go For It!和 **修改 todo.txt 的目录到 Dropbox 的路径下**。

然后,你得去下载 [Simpletask Andriod app](https://play.google.com/store/apps/details?id=nl.mpcjanssen.todotxtholo&hl=en)。这是免费的应用。安装它。当你第一次运行 Simletask 的时候,你会被要求关联你的账号到 Dropbox:

一旦你完成了 Simpletask 与 Dropbox 的关联,就可以打开应用了。如果你已经修改了 Go For It 的配置,将文件保存到Dropbox 上,你就应该可以在 Simpletask 里看到。而如果你没有看到,点击应用底部的设置,选择 Open Todo file 的选项:

现在,你应该可以看到 Simpletask 同步的任务了。

### 总结

对于 Simpletask,你就可以以类似[标记语言工具](http://itsfoss.com/install-latex-ubuntu-1404/)的风格使用它。对于小巧和专注而言,Go For It!是一款不错的备忘软件。一个干净的界面是额外的加分点。如果拥有它自己的手机应用就更好了,但是我们也有临时替代方案了。

底层来讲,Go For It! 不会运行在后台。这就是说,你不得不让它一直保持运行。它甚至没有一个最小化的按钮,这有一点小小的烦扰。我想要看到的是有一个小的指示程序,运行在后台,并且快速进入主面板,这肯定会提升其可用性。

试试 Go For It!吧,分享一下你的使用体验。在 Linux 桌面上,你还使用了哪些其他的备忘软件?比起其他你最喜欢的同类应用,Go For It!怎么样?

---

via: <http://itsfoss.com/go-for-it-to-do-app-in-linux/>

作者:[Abhishek](http://itsfoss.com/author/abhishek/) 译者:[wi-cuckoo](https://github.com/wi-cuckoo) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

| 301 | Moved Permanently | null |

5,338 | Papyrus:开源笔记管理工具 | http://itsfoss.com/papyrus-open-source-note-manager/ | 2015-04-28T08:34:00 | [

"笔记软件",

"Papyrus"

] | https://linux.cn/article-5338-1.html |

在上一篇帖子中,我们介绍了[待办事项管理软件Go For It!](http://linux.cn/article-5337-1.html)。今天我们将介绍一款名为**Papyrus的开源笔记软件**

[Papyrus](http://aseman.co/en/products/papyrus/) 是[Kaqaz 笔记管理](https://github.com/sialan-labs/kaqaz/)的一个分支,使用 Qt5 开发。它不仅有简洁、易用的界面,(其宣称)还具备了较好的安全性。由于强调简洁,我觉得 Papyrus 与 OneNote 比较相像。你可以将你的笔记像"纸张"一样分类整理,还可以给他们添加标签进行分组。够简单的吧!

Papyrus 的特性:

------------

虽然 Papyrus 强调简洁,它依然有很多丰富的功能。它的一些主要功能如下:

* 按类别和标签管理笔记

* 高级搜索选项

* 触屏模式

* 全屏选项

* 备份至 Dropbox/硬盘/外部存储

* 允许加密某些页面

* 可与其他软件共享笔记

* 与 Dropbox 加密同步

* 除 Linux 外,还可在 Android,Windows 和 OS X 使用

### 安装 Papyrus

Papyrus 为 Android 用户提供了 APK 安装包。Windows 和 OS X 也有安装文件。Linux 用户还可以获取程序的源码。Ubuntu 及其它基于 Ubuntu 的发行版可以使用 .deb 包进行安装。根据你的系统及习惯,你可以从 Papyrus 的下载页面中获取不同的文件:

* [下载 Papyrus](http://aseman.co/en/products/papyrus/)

### 软件截图

以下是此软件的一些截图:

试试Papyrus吧,你会喜欢上它的。在下方评论区和我们分享你的使用经验吧。

(LCTT译注:此软件暂无中文版)

---

via: <http://itsfoss.com/papyrus-open-source-note-manager/>

作者:[Abhishek](http://itsfoss.com/author/abhishek/) 译者:[KevinSJ](https://github.com/KevinSJ) 校对:[Caroline](https://github.com/carolinewuyan)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

| 301 | Moved Permanently | null |

5,339 | 走向 Docker | http://cocoahunter.com/2015/01/23/docker-1/ | 2015-04-27T10:55:00 | [

"Docker"

] | https://linux.cn/article-5339-1.html |

[TL;DR] 这是系列的第一篇文章,这系列讲述了我的公司如何把基础服务从PaaS迁移到Docker上。如果你愿意,你可以直接跳过介绍(这篇文章)直接看技术相关的话题(链接在页面的底部)。

---

上个月,我一直在折腾开发环境。这是我个人故事和经验,关于尝试用Docker简化Rails应用的部署过程。

当我在2012年创建我的公司 – [Touchware](http://www.touchwa.re/)时,我还是一个独立开发者。很多事情很小,不复杂,他们不需要很多维护,他们也不需要部署到很多机器上。经过过去一年的发展,我们成长了很多(我们现在是是拥有10个人的团队)而且我们的服务端的程序和API无论在范围和规模方面都有增长。

### 第1步 - Heroku

我们还是个小公司,我们需要让事情运行地尽可能平稳。当我们寻找可行的解决方案时,我们打算坚持用那些可以帮助我们减轻对硬件依赖负担的工具。由于我们主要开发Rails应用,而Heroku对RoR、常用的数据库和缓存(Postgres/Mongo/Redis等)有很好的支持,最明智的选择就是用[Heroku](http://www.heroku.com) 。我们就是这样做的。

Heroku有很好的技术支持和文档,使得部署非常轻松。唯一的问题是,当你处于起步阶段,你需要很多开销。这不是最好的选择,真的。

### 第2步 - Dokku

为了尝试并降低成本,我们决定试试Dokku。[Dokku](https://github.com/progrium/dokku),引用GitHub上的一句话

>

> Docker 驱动的 mini-Heroku,只用了一百来行的 bash 脚本

>

>

>

我们启用的[DigitalOcean](http://www.digitalocean.com)上的很多台机器,都预装了Dokku。Dokku非常像Heroku,但是当你有复杂的项目需要调整配置参数或者是需要特殊的依赖时,它就不能胜任了。我们有一个应用,它需要对图片进行多次转换,我们把我们Rails应用的托管到基于Dokku的Docker容器,但是无法安装一个适合版本的imagemagick到里面。尽管我们还有很多应用运行在Dokku上,但我们还是不得不把一些迁移回Heroku。

### 第3步 - Docker

几个月前,由于开发环境和生产环境的问题重新出现,我决定试试Docker。简单来说,Docker让开发者容器化应用、简化部署。由于一个Docker容器本质上已经包含项目运行所需要的所有依赖,只要它能在你的笔记本上运行地很好,你就能确保它将也能在任何一个别的远程服务器的生产环境上运行,包括Amazon的EC2和DigitalOcean上的VPS。

就我个人的看法来说,Docker 特别有意思的原因是:

* 它促进了模块化和关注点分离:你只需要去考虑应用的逻辑部分(负载均衡:1个容器;数据库:1个容器;web服务器:1个容器);

* 在部署的配置上非常灵活:容器可以被部署在各种硬件上,也可以容易地重新部署在不同的服务器和不同的提供商;

* 它允许非常细粒度地优化应用的运行环境:你可以利用你的容器来创建镜像,所以你有很多选择来配置环境。

它也有一些缺点:

* 它的学习曲线非常的陡峭(这是从一个软件开发者的角度来看,而不是经验丰富的运维人员);

* 搭建环境不简单,尤其是还需要自己搭建一个私有的registry/repository (后面有关于它的详细内容)。

下面是一些提示。这个系列的最后一周,我将把他们和一些新的放在一起。

---

在下面的文章中,我们将看到如何建立一个半自动化的基于Docker的部署系统。

* [建立私有的Docker registry](/article-5379-1.html)

* [自动化部署基于 Docker 的 Rails 应用](/article-5408-1.html)

---

via: <http://cocoahunter.com/2015/01/23/docker-1/>

作者:[Michelangelo Chasseur](http://cocoahunter.com/author/michelangelo/) 译者:[mtunique](https://github.com/mtunique) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

| 302 | Found | null |

5,340 | Picty:让图片管理变简单 | http://www.unixmen.com/picty-managing-photos-made-easy/ | 2015-04-27T14:16:11 | [

"Picty",

"图片管理"

] | https://linux.cn/article-5340-1.html |

### 关于Picty

**Picty**是个免费,简单,却强大的照片收藏管理器,它可以帮助你管理你的照片。它是围绕着**元数据**管理和图像**无损**处理设计的。Picty目前同时支持在线(基于网页的)和离线(本地的)收藏集。在本地的收藏集中,图片将被保存在一个本地的文件夹及其子文件夹中。为了加快用户主目录里图片的查询速度,它会维持一个数据库。在在线(基于网页的)收藏集中,你可以通过网页浏览器上传并分享图片。拥有适当权限的个人用户可以把图片分享给任何人,而且用户可以同时打开多个收藏集,收藏集也可以分享给多个用户。有个简单的界面可以通过传输插件在收藏集之间传输图片。

你可以从你的相机或任何设备中下载任何数量的照片。除此之外,Picty允许你在下载前浏览在你相机里的图片集。Picty是个轻量级的应用,界面清爽。它支持Linux和Windows平台。

### 功能

* 支持大相片集(20000张以上)。

* 同时打开多个收藏集,还可以在它们之间传照片。

* 收藏集包括:

+ 本地文件系统中保存图片的文件夹。

+ 相机、电话及其他媒体设备中的图片。

+ 图片保存服务(目前支持Flickr)

* Picty不是把相片“导入”到它的数据库中,它仅仅提供了一个界面来访问它们,不管它们保存在哪。为了保持迅速的反应以及能使你在离线时浏览图片的能力,Picty会保存缩略图和元数据的缓存。

* 以业界标准格式Exif、IPTC和Xmp读写元数据。

* 无损的方法:

+ Picty把所有改变包括图像编辑以元数据的方式写入。例如,一个图片可以以任何方式剪切保存,原来的图像仍然保存在该文件里。

+ 修改会保存在Picty的收藏集缓存中直到你把你对元数据的修改保存到图片中,所以你能很容易撤销你不喜欢的未保存的修改。

* 基本图片编辑功能:

+ 目前支持基本的图像增强,如亮度、对比度、色彩、剪切以及矫正。

+ 将要推出一些工具改进及更多工具。(红眼消除、拉伸、弯曲、噪声消除)

* 图片标签:

+ 使用标准的IPTC和Xmp关键词为图片做标签。

+ 一个树状标签图让你能很容易的管理标签和在收藏集内导航。

* 文件夹视图:

+ 按照目录的结构对你的图片收藏集进行导航

* 支持多屏显示

+ Picty可以设置成让你在一个屏幕上浏览你的收藏集同时在另一个屏幕上全屏显示图片。

* 可个性化

+ 可以为外部工具创建快捷方式

+ 支持插件——目前提供的功能中有许多(标签和文件夹视图以及所有的图片编辑工具)都可以通过插件提供。

+ 使用Python编写——内置电池(batteries included)!

### 安装方法

#### 1、从PPA安装

Picty开发人员为Ubuntu这样的基于 Debian的发行版创建了一个PPA,让安装更简单。

要在Ubuntu和它的衍生版上安装,请运行以下命令:

```

sudo add-apt-repository ppa:damien-moore/ppa

sudo apt-get update

sudo apt-get install picty

```

#### 2、从源文件安装

此外,你还可以从源文件安装。首先安装如下依赖项。

```

sudo apt-get install bzr python-pyinotify python-pyexiv2 python-gtk2 python-gnome2 dcraw python-osmgpsmap python-flickrapi

```

然后,使用下面这个命令得到最新版本:

```

bzr branch lp:picty

```

要运行Picty,先转到Picty所在的目录,然后输入:

```

cd picty

bin/picty

```

要想更新到最新版,请运行:

```

cd picty

bzr pull

```

### 使用方法

可以从目录或Unity Dash启动Picty。

你可以选择已存在的收藏集、设备或目录。这里让我们创建一个**新收藏集** ,请先点击新收藏集(New Collection)按钮。进入收藏集,然后浏览到你保存图片的地方。最后,点击**创建(Create)**按钮。

你可以对每张图片进行修改,旋转,添加/移除标签,设置描述。只需右击任何一个图片然后爱做什么做什么。

访问下面这个Google组可以得到更多关于Picty相片管理器的信息和支持。

* <http://groups.google.com/group/pictyphotomanager>

干杯!

---

via: <http://www.unixmen.com/picty-managing-photos-made-easy/>

作者:[SK](http://www.unixmen.com/author/sk/) 译者:[H-mudcup](https://github.com/H-mudcup) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

| 301 | Moved Permanently | null |

5,341 | 安装完最小化 RHEL/CentOS 7 后需要做的 30 件事情(一) | http://www.tecmint.com/things-to-do-after-minimal-rhel-centos-7-installation/ | 2015-04-27T15:19:00 | [

"CentOS 7",

"RHEL 7"

] | https://linux.cn/article-5341-1.html |

CentOS 是一个工业标准的 Linux 发行版,是红帽企业版 Linux 的衍生版本。你安装完后马上就可以使用,但是为了更好地使用你的系统,你需要进行一些升级、安装新的软件包、配置特定服务和应用程序等操作。

这篇文章介绍了 “安装完 RHEL/CentOS 7 后需要做的 30 件事情”。阅读帖子的时候请先完成 RHEL/CentOS 最小化安装,这是首选的企业和生产环境。如果还没有,你可以按照下面的指南,它会告诉你两者的最小化安装方法。

* [最小化安装 CentOS 7](http://www.tecmint.com/centos-7-installation/)

* [最小化安装 RHEL 7](http://www.tecmint.com/redhat-enterprise-linux-7-installation/)

我们会基于工业标准的需求来介绍以下列出的这些重要工作。我们希望这些东西在你配置服务器的时候能有所帮助。

1. 注册并启用红帽订阅

2. 使用静态 IP 地址配置网络

3. 设置服务器的主机名称

4. 更新或升级最小化安装的 CentOS

5. 安装命令行 Web 浏览器

6. 安装 Apache HTTP 服务器

7. 安装 PHP

8. 安装 MariaDB 数据库

9. 安装并配置 SSH 服务器

10. 安装 GCC (GNU 编译器集)

11. 安装 Java

12. 安装 Apache Tomcat

13. 安装 Nmap 检查开放端口

14. 配置防火墙

15. 安装 Wget

16. 安装 Telnet

17. 安装 Webmin

18. 启用第三方库

19. 安装 7-zip 工具

20. 安装 NTFS-3G 驱动

21. 安装 Vsftpd FTP 服务器

22. 安装和配置 sudo

23. 安装并启用 SELinux

24. 安装 Rootkit Hunter

25. 安装 Linux Malware Detect (LMD)

26. 用 Speedtest-cli 测试服务器带宽

27. 配置 Cron 作业

28. 安装 Owncloud

29. 启用 VirtualBox 虚拟化

30. 用密码保护 GRUB

(LCTT 译注:关于 CentOS/RHEL 7的更多信息,请参考专题:<http://www.linux.cn/topic-centos7.html> )

### 1. 注册并启用红帽订阅

RHEL 7 最小化安装完成后,就应该注册并启用系统红帽订阅库, 并执行一个完整的系统更新。这只当你有一个可用的红帽订阅时才能有用。你要注册才能启用官方红帽系统库,并时不时进行操作系统更新。(LCTT 译注:订阅服务是收费的)

在下面的指南中我们已经包括了一个如何注册并激活红帽订阅的详细说明。

* [在 RHEL 7 中注册并启用红帽订阅](http://www.tecmint.com/enable-redhat-subscription-reposiories-and-updates-for-rhel-7/)

**注意**: 这一步仅适用于有一个有效订阅的红帽企业版 Linux。如果你用的是 CentOS 服务器,请查看后面的章节。

### 2. 使用静态 IP 地址配置网络

你第一件要做的事情就是为你的 CentOS 服务器配置静态 IP 地址、路由以及 DNS。我们会使用 ip 命令代替 ifconfig 命令。当然,ifconfig 命令对于大部分 Linux 发行版来说还是可用的,还能从默认库安装。

```

# yum install net-tools [它提供 ifconfig 工具,如果你不习惯 ip 命令,还可以使用它]

```

(LCTT 译注:关于 ip 命令的使用,请参照:<http://www.linux.cn/article-3631-1.html> )

但正如我之前说,我们会使用 ip 命令来配置静态 IP 地址。所以,确认你首先检查了当前的 IP 地址。

```

# ip addr show

```

现在用你的编辑器打开并编辑文件 /etc/sysconfig/network-scripts/ifcfg-enp0s3 (LCTT 译注:你的网卡名称可能不同,如果希望修改为老式网卡名称,参考:<http://www.linux.cn/article-4045-1.html> )。这里,我使用 vi 编辑器,另外你要确保你是 root 用户才能保存更改。

```

# vi /etc/sysconfig/network-scripts/ifcfg-enp0s3

```

我们会编辑文件中的四个地方。注意下面的四个地方并保证不碰任何其它的东西。也保留双引号,在它们中间输入你的数据。

```

IPADDR = "[在这里输入你的静态 IP]"

GATEWAY = "[输入你的默认网关]"

DNS1 = "[你的DNS 1]"

DNS2 = "[你的DNS 2]"

```

更改了 ‘ifcfg-enp0s3’ 之后,它看起来像下面的图片。注意你的 IP,网关和 DNS 可能会变化,请和你的 ISP(译者注:互联网服务提供商,即给你提供接入的服务的电信或 IDC) 确认。保存并退出。

*网络详情*

重启网络服务并检查 IP 是否和分配的一样。如果一切都顺利,用 Ping 查看网络状态。

```

# service network restart

```

*重启网络服务*

重启网络后,确认检查了 IP 地址和网络状态。

```

# ip addr show

# ping -c4 google.com

```

*验证 IP 地址*

*检查网络状态*

(LCTT 译注:关于设置静态 IP 地址的更多信息,请参照:<http://www.linux.cn/article-3977-1.html> )

### 3. 设置服务器的主机名称

下一步是更改 CentOS 服务器的主机名称。查看当前分配的主机名称。

```

# echo $HOSTNAME

```

*查看系统主机名称*

要设置新的主机名称,我们需要编辑 ‘/etc/hostsname’ 文件并用想要的名称替换旧的主机名称。

```

# vi /etc/hostname

```

*在 CentOS 中设置主机名称*

设置完了主机名称之后,务必注销后重新登录确认主机名称。登录后检查新的主机名称。

```

$ echo $HOSTNAME

```

*确认主机名称*

你也可以用 ‘hostname’ 命令查看你当前的主机名。

```

$ hostname

```

(LCTT 译注:关于设置静态、瞬态和灵活主机名的更多信息,请参考:<http://www.linux.cn/article-3937-1.html> )

### 4. 更新或升级最小化安装的 CentOS

这样做除了更新安装已有的软件最新版本以及安全升级,不会安装任何新的软件。总的来说更新(update)和升级(upgrade)是相同的,除了事实上 升级 = 更新 + 更新时进行废弃处理。

```

# yum update && yum upgrade

```

*更新最小化安装的 CentOS 服务器*

**重要**: 你也可以运行下面的命令,这不会弹出软件更新的提示,你也就不需要输入 ‘y’ 接受更改。

然而,查看服务器上会发生的变化总是一个好主意,尤其是在生产中。因此使用下面的命令虽然可以为你自动更新和升级,但并不推荐。

```

# yum -y update && yum -y upgrade

```

### 5. 安装命令行 Web 浏览器

大部分情况下,尤其是在生产环境中,我们通常用没有 GUI 的命令行安装 CentOS,在这种情况下我们必须有一个能通过终端查看网站的命令行浏览工具。为了实现这个目的,我们打算安装名为 ‘links’ 的著名工具。

```

# yum install links

```

*Links: 命令行 Web 浏览器*

请查看我们的文章 [用 links 工具命令行浏览 Web](http://www.tecmint.com/command-line-web-browsers/) 了解用 links 工具浏览 web 的方法和例子。

### 6. 安装 Apache HTTP 服务器

不管你因为什么原因使用服务器,大部分情况下你都需要一个 HTTP 服务器运行网站、多媒体、用户端脚本和很多其它的东西。

```

# yum install httpd

```

*安装 Apache 服务器*

如果你想更改 Apache HTTP 服务器的默认端口号(80)为其它端口,你需要编辑配置文件 ‘/etc/httpd/conf/httpd.conf’ 并查找以下面开始的行:

```

LISTEN 80

```

把端口号 ‘80’ 改为其它任何端口(例如 3221),保存并退出。

*更改 Apache 端口*

增加刚才分配给 Apache 的端口通过防火墙,然后重新加载防火墙。

允许 http 服务通过防火墙(永久)。

```

# firewall-cmd –add-service=http

```

允许 3221 号端口通过防火墙(永久)。

```

# firewall-cmd –permanent –add-port=3221/tcp

```

重新加载防火墙。

```

# firewall-cmd –reload

```

(LCTT 译注:关于 firewall 的进一步使用,请参照:<http://www.linux.cn/article-4425-1.html> )

完成上面的所有事情之后,是时候重启 Apache HTTP 服务器了,然后新的端口号才能生效。

```

# systemctl restart httpd.service

```

现在添加 Apache 服务到系统层使其随系统自动启动。

```

# systemctl start httpd.service

# systemctl enable httpd.service

```

(LCTT 译注:关于 systemctl 的进一步使用,请参照:<http://www.linux.cn/article-3719-1.html> )

如下图所示,用 links 命令行工具 验证 Apache HTTP 服务器。

```

# links 127.0.0.1

```

*验证 Apache 状态*

---

via: <http://www.tecmint.com/things-to-do-after-minimal-rhel-centos-7-installation/>

作者:[Avishek Kumar](http://www.tecmint.com/author/avishek/) 译者:[ictlyh](https://github.com/ictlyh) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

| 301 | Moved Permanently | null |

5,342 | 安装完最小化 RHEL/CentOS 7 后需要做的 30 件事情(二) | http://www.tecmint.com/things-to-do-after-minimal-rhel-centos-7-installation/2/ | 2015-04-28T10:06:00 | [

"CentOS 7",

"RHEL 7"

] | https://linux.cn/article-5342-1.html |

### 7. 安装 PHP

PHP 是用于 web 基础服务的服务器端脚本语言。它也经常被用作通用编程语言。在最小化安装的 CentOS 中安装 PHP:

```

# yum install php

```

安装完 php 之后,确认重启 Apache 服务以便在 Web 浏览器中渲染 PHP。

```

# systemctl restart httpd.service

```

下一步,通过在 Apache 文档根目录下创建下面的 php 脚本验证 PHP。

```

# echo -e "<?php\nphpinfo();\n?>" > /var/www/html/phpinfo.php

```

现在在 Linux 命令行中查看我们刚才创建的 PHP 文件(phpinfo.php)。

```

# php /var/www/html/phpinfo.php

或者

# links http://127.0.0.1/phpinfo.php

```

*验证 PHP*

### 8. 安装 MariaDB 数据库

MariaDB 是 MySQL 的一个分支。RHEL 以及它的衍生版已经从 MySQL 迁移到 MariaDB。这是一个主流的数据库管理系统,也是一个你必须拥有的工具。不管你在配置怎样的服务器,或迟或早你都会需要它。在最小化安装的 CentOS 上安装 MariaDB,如下所示:

```

# yum install mariadb-server mariadb

```

*安装 MariaDB 数据库*

启动 MariaDB 并配置它开机时自动启动。

```

# systemctl start mariadb.service

# systemctl enable mariadb.service

```

允许 mysql(mariadb) 服务通过防火墙(LCTT 译注:如果你的 MariaDB 只用在本机,则务必不要设置防火墙允许通过,使用 UNIX Socket 连接你的数据库;如果需要在别的服务器上连接数据库,则尽量使用内部网络,而不要将数据库服务暴露在公开的互联网上。)

```

# firewall-cmd –add-service=mysql

```

现在是时候确保 MariaDB 服务器安全了(LCTT 译注:这个步骤主要是设置 mysql 管理密码)。

```

# /usr/bin/mysql_secure_installation

```

*保护 MariaDB 数据库*

请阅读:

* [在 CentOS 7.0 上安装 LAMP (Linux, Apache, MariaDB, PHP/PhpMyAdmin)](http://www.tecmint.com/install-lamp-in-centos-7/)

* [在 CentOS 7.0 上创建 Apache 虚拟主机](http://www.tecmint.com/apache-virtual-hosting-in-centos/)

### 9. 安装和配置 SSH 服务器

SSH 即 Secure Shell,是 Linux 远程管理的默认协议。 SSH 是随最小化 CentOS 服务器中安装运行的最重要的软件之一。

检查当前已安装的 SSH 版本。

```

# SSH -V

```

*检查 SSH 版本*

使用更安全的 SSH 协议,而不是默认的协议,并更改端口号进一步加强安全。编辑 SSH 的配置文件 ‘/etc/ssh/ssh\_config’。

去掉下面行的注释或者从协议行中删除 1,然后行看起来像这样(LCTT 译注: SSH v1 是过期废弃的不安全协议):

```

# Protocol 2,1 (原来)

Protocol 2 (现在)

```

这个改变强制 SSH 使用 协议 2,它被认为比协议 1 更安全,同时也确保在配置中更改端口号 22 为其它。

*保护 SSH 登录*

取消 SSH 中的‘root login’, 只允许通过普通用户账号登录后才能使用 su 切换到 root,以进一步加强安全。请打开并编辑配置文件 ‘/etc/ssh/sshd\_config’ 并更改 PermitRootLogin yes 为 PermitRootLogin no。

```

# PermitRootLogin yes (原来)

PermitRootLogin no (现在)

```

*取消 SSH Root 直接登录*

最后,重启 SSH 服务启用更改。

```

# systemctl restart sshd.service

```

请查看:

* [加密和保护 SSH 服务器的 5 个最佳实践](http://www.tecmint.com/5-best-practices-to-secure-and-protect-ssh-server/)

* [5 个简单步骤实现使用 SSH Keygen 无密码登录 SSH](http://www.tecmint.com/ssh-passwordless-login-using-ssh-keygen-in-5-easy-steps/)

* [在 PuTTY 中实现 “无密码 SSH 密钥验证”](http://www.tecmint.com/ssh-passwordless-login-with-putty/)

### 10. 安装 GCC (GNU 编译器集)

GCC 即 GNU 编译器集,是一个 GNU 项目开发的支持多种编程语言的编译系统(LCTT 译注:在你需要自己编译构建软件时需要它)。在最小化安装的 CentOS 没有默认安装。运行下面的命令安装 gcc 编译器。

```

# yum install gcc

```

*在 CentOS 上安装 GCC*

检查安装的 gcc 版本。

```

# gcc --version

```

*检查 GCC 版本*

### 11. 安装 Java

Java是一种通用的基于类的,面向对象的编程语言。在最小化 CentOS 服务器中没有默认安装(LCTT 译注:如果你没有任何 Java 应用,可以不用装它)。按照下面命令从库中安装 Java。

```

# yum install java

```

*安装 Java*

检查安装的 Java 版本。

```

# java -version

```

*检查 Java 版本*

---

via: <http://www.tecmint.com/things-to-do-after-minimal-rhel-centos-7-installation/2/>

作者:[Avishek Kumar](http://www.tecmint.com/author/avishek/) 译者:[ictlyh](https://github.com/ictlyh) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

| 301 | Moved Permanently | null |

5,348 | GNOME-Pie 0.6.1 应用启动器发布,酷炫新特性[多图+视频] | http://news.softpedia.com/news/GNOME-Pie-0-6-Application-Launcher-Released-with-Many-New-Features-Video-478914.shtml | 2015-04-28T13:37:00 | [

"GNOME-Pie"

] | https://linux.cn/article-5348-1.html | **Simon Schneegans 高兴地[宣布](http://simmesimme.github.io/news/2015/04/18/gnome-pie-061/)他的 GNOME-Pie 0.6.1 已可供下载使用。GNOME-Pie 是一个可以在包括 GNOME 和 Unity 在内的多种桌面环境中作为应用启动器的小工具。**

GNOME-Pie 0.6.1 看起来是个主要版本更新,引入了许多新特性,比如支持半个或四分之一圆,可选择每个启动器想要的形状,也可以自动根据位置调整形状(圆形,半个或四分之一圆),以及多彩的动态图标。