ahm

commited on

Commit

•

87bc1c2

1

Parent(s):

f3f350d

updating model card

Browse files- README.md +19 -1

- assets/novelty.png +0 -0

README.md

CHANGED

|

@@ -18,7 +18,25 @@ tags:

|

|

| 18 |

- bart

|

| 19 |

---

|

| 20 |

|

| 21 |

-

#

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| 22 |

|

| 23 |

## Utilisation

|

| 24 |

|

|

|

|

| 18 |

- bart

|

| 19 |

---

|

| 20 |

|

| 21 |

+

# Résumé automatique d'article de presses

|

| 22 |

+

|

| 23 |

+

Ce modèles est basé sur le modèle [`facebook/mbart-large-50`](https://huggingface.co/facebook/mbart-large-50) et été fine-tuné en utilisant des articles de presse issus de la base de données MLSUM. L'hypothèse à été faite que les chapeau des articles faisaient de bon résumé.

|

| 24 |

+

|

| 25 |

+

## Entrainement

|

| 26 |

+

|

| 27 |

+

Nous avons testé deux architecture de modèles (T5 et BART) avec des textes en entrée de 512 ou 1024 tokens. Finallement c'est le modèle BART avec 512 tokens qui à été retenu.

|

| 28 |

+

|

| 29 |

+

Il a été entrainé sur 2 epochs (~700K articles) sur une Tesla V100 (32 heures d'entrainement).

|

| 30 |

+

|

| 31 |

+

## Résultats

|

| 32 |

+

|

| 33 |

+

|

| 34 |

+

|

| 35 |

+

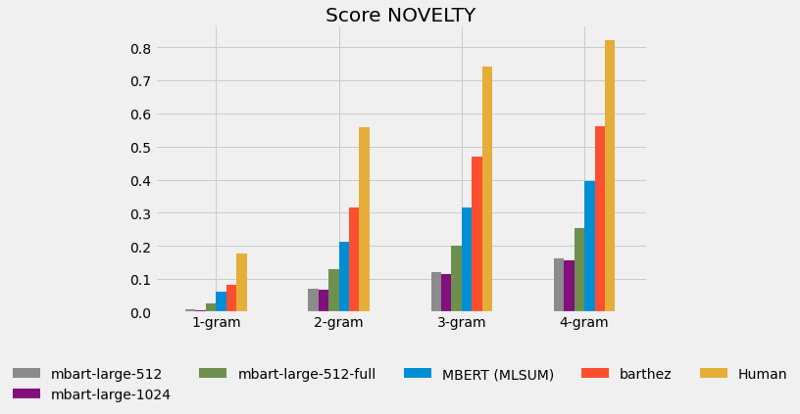

Nous avons comparé notre modèle à deux références:

|

| 36 |

+

* MBERT qui correspond aux performances du modèle entrainé par l'équipe à l'origine de la base d'articles MLSUM

|

| 37 |

+

* Barthez qui est un autre modèle basé sur des articles de presses issus de la base de données OrangeSum

|

| 38 |

+

|

| 39 |

+

On voit que le score de novelty (cf papier MLSUM) de notre modèle n'est pas encore comparable à ces deux références et encore moins à une production humaine néanmoins les résumés générés sont dans l'ensemble de bonne qualité.

|

| 40 |

|

| 41 |

## Utilisation

|

| 42 |

|

assets/novelty.png

ADDED

|