text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

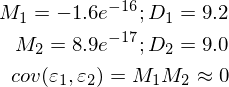

# Симуляция движения и заноса машины в игре на JavaScript

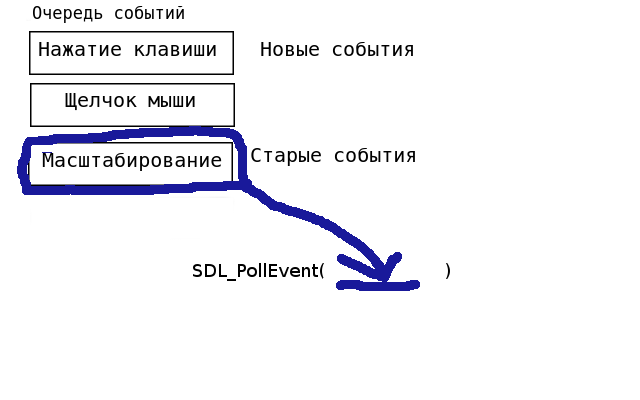

Нужно было написать игру на JavaScript. Решил остановиться на примитивных гоночках. Когда я овладел принципами вращения и перемещения по HTML5 Canvas появилась следующая проблема: управление автомобилем. Делая эту игру я вспоминал игру [Grand Prix Simulator 2 ZX Spectrum](http://zx-games.ru/grand-prix-simulator-2/), в кторую я играл на компьютере «Байт».

Управление там было следующее:

* стрелка вверх: газ;

* стрелка влево: поворот против часовой стрелки;

* стрелка вправо: поворот по часовой стрелке.

Реализовать это было просто: у машины есть направление в радианах, по нажатию кнопки у неё вызывается событие `rotateLeft` или `rotateRight`. Эти методы просто добавляют или вычитают константное значение изменения угла из направления машины.

Но в той игре ещё у машины был занос (поначалу неудобно, но с ним интереснее). И я решил написать какую-нибудь эмуляцию заноса. По сути занос происходит когда сама машина меняет направление, но её движение не меняет направление вместе с ней. Насколько точно нужно воспроизвести движение с точки зрения физики? Я ставил целью сделать такой занос, который будет похож на реальный.

Для начала нужно разделить вектор скорости и направление машины:

`this.carDirection` — угол, задающий ориентацию машины;

`this.linearVelocity` — вектор скорости, заданный в декартовых координатах.

Дальше вешаем событие изменения ориентации машины на клавиши поворота. Когда она отличается от направления вектора скорости, то он начинает поворачиваться по направлению машины. Скорость поворота этого вектора задаётся эмпирическим коэффициентом `SMOOTHING`.

Итак, машину понесло. Тепрь нужно проверить удержался ли пилот на трассе. Трасса представляет собой ломаную, участки которой имеют определённую ширину. Эти линии на трассе находятся под каким-то углом. Таким образом задача формулируется следующим образом: нужно проверить попадает ли точка в прямоугольник, расположеный под каким-то углом.

Одним из способов будет перенос системы координат на участок трассы так, чтобы этот участок трассы лежал на одной из осей. Для этого нужно вычесть из координат машины координаты начала отрезка, а затем умножить их на матрицу поворота:

```

function turnAndTranslate(lineIndex, position) {

return [

trace[lineIndex].cos * (position[0] - trace[lineIndex].begin[0]) +

trace[lineIndex].sin * (position[1] - trace[lineIndex].begin[1]),

trace[lineIndex].sin * (- position[0] + trace[lineIndex].begin[0]) +

trace[lineIndex].cos * (position[1] - trace[lineIndex].begin[1])

];

}

```

Для матрицы поворота умножить вектор координат на матрицу, которая содержит синус и косинус угла поворота. Чтобы не вычислать тригонометрические функции при каждой проверке они вычисляются только один раз при инициализации карты и сохраняются как коэффициенты для каждого отрезка трассы.

Программа сыроватая, но покататься уже можно [тут](http://rghost.net/42694444). | https://habr.com/ru/post/164609/ | null | ru | null |

# Математика для искусственных нейронных сетей для новичков, часть 1 — линейная регрессия

##### Оглавление

Часть 1 — линейная регрессия

[Часть 2 — градиентный спуск](https://habrahabr.ru/post/307312/)

[Часть 3 — градиентный спуск продолжение](https://habrahabr.ru/post/308604/)

#### Введение

Этим постом я начну цикл «Нейронные сети для новичков». Он посвящен искусственным нейронным сетям (внезапно). Целью цикла является объяснение данной математической модели. Часто после прочтения подобных статей у меня оставалось чувство недосказанности, недопонимания — НС по-прежнему оставались «черным ящиком» — в общих чертах известно, как они устроены, известно, что делают, известны входные и выходные данные. Но тем не менее полное, всестороннее понимание отсутствует. А современные библиотеки с очень приятными и удобными абстракциями только усиливают ощущение «черного ящика». Не могу сказать, что это однозначно плохо, но и разобраться в используемых инструментах тоже никогда не поздно. Поэтому моей первичной целью является подробное объяснение устройства нейронных сетей так, чтобы абсолютно ни у кого не осталось вопросов об их устройстве; так, чтобы НС не казались волшебством. Так как это не математический трактат, я ограничусь описанием нескольких методов простым языком (но не исключая формул, конечно же), предоставляя поясняющие иллюстрации и примеры.

Цикл рассчитан на базовый ВУЗовский математический уровень читающего. Код будет написан на Python3.5 с numpy 1.11. Список остальных вспомогательных библиотек будет в конце каждого поста. Абсолютно все будет написано с нуля. В качестве подопытного выбрана база MNIST — это черно-белые, центрированные изображения рукописных цифр размером 28\*28 пикселей. По-умолчанию, 60000 изображений отмечены для обучения, а 10000 для тестирования. В примерах я не буду изменять распределения по-умолчанию.

Пример изображений из MNIST:

Я не буду заострять внимание на структуре MNIST и просто выложу код, который загрузит базу и сохранит в нужном формате. Этот формат в дальнейшем будет использован в примерах:

**loader.py**

```

import struct

import numpy as np

import requests

import gzip

import pickle

TRAIN_IMAGES_URL = "http://yann.lecun.com/exdb/mnist/train-images-idx3-ubyte.gz"

TRAIN_LABELS_URL = "http://yann.lecun.com/exdb/mnist/train-labels-idx1-ubyte.gz"

TEST_IMAGES_URL = "http://yann.lecun.com/exdb/mnist/t10k-images-idx3-ubyte.gz"

TEST_LABELS_URL = "http://yann.lecun.com/exdb/mnist/t10k-labels-idx1-ubyte.gz"

def downloader(url: str):

response = requests.get(url, stream=True)

if response.status_code != 200:

print("Response for", url, "is", response.status_code)

exit(1)

print("Downloaded", int(response.headers.get('content-length', 0)), "bytes")

decompressed = gzip.decompress(response.raw.read())

return decompressed

def load_data(images_url: str, labels_url: str) -> (np.array, np.array):

images_decompressed = downloader(images_url)

# Big endian 4 числа типа unsigned int, каждый по 4 байта

magic, size, rows, cols = struct.unpack(">IIII", images_decompressed[:16])

if magic != 2051:

print("Wrong magic for", images_url, "Probably file corrupted")

exit(2)

image_data = np.array(np.frombuffer(images_decompressed[16:], dtype=np.dtype((np.ubyte, (rows * cols,)))) / 255,

dtype=np.float32)

labels_decompressed = downloader(labels_url)

# Big endian 2 числа типа unsigned int, каждый по 4 байта

magic, size = struct.unpack(">II", labels_decompressed[:8])

if magic != 2049:

print("Wrong magic for", labels_url, "Probably file corrupted")

exit(2)

labels = np.frombuffer(labels_decompressed[8:], dtype=np.ubyte)

return image_data, labels

with open("test_images.pkl", "w+b") as output:

pickle.dump(load_data(TEST_IMAGES_URL, TEST_LABELS_URL), output)

with open("train_images.pkl", "w+b") as output:

pickle.dump(load_data(TRAIN_IMAGES_URL, TRAIN_LABELS_URL), output)

```

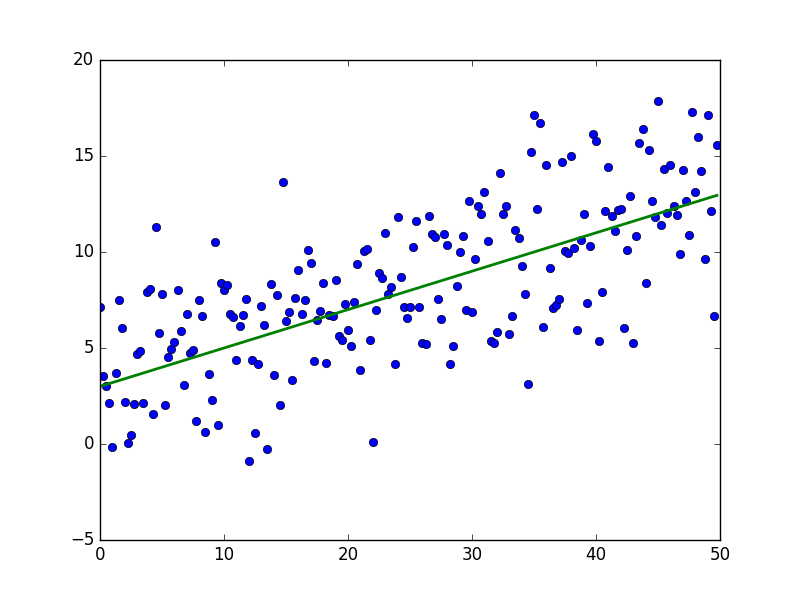

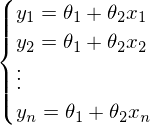

#### Линейная регрессия

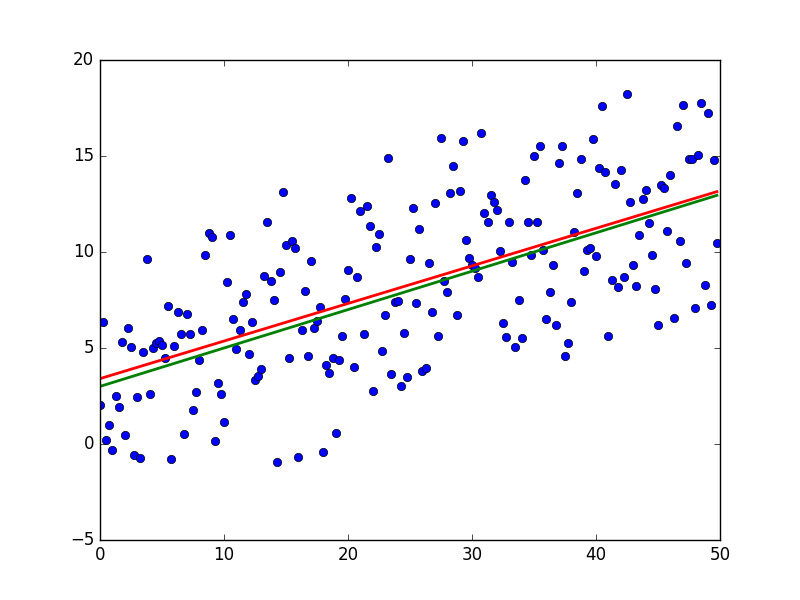

Линейная регрессия — метод восстановления зависимости между двумя переменными. Линейная означает, что мы предполагаем, что переменные выражаются через уравнение вида:  Эпсилон здесь — это ошибка модели. Также для наглядности и простоты будем иметь дело с одномерной моделью — многомерность не прибавляет сложности, но иллюстрации сделать не выйдет. На секунду забудем про MNIST и сгенерируем немного данных, вытянутых в линию. Также перепишем модель (гипотезу) регрессии следующим образом: . y с шапкой — это предсказанное моделью значение.  1 и 2 — неизвестные параметры — основная задача эти параметры отыскать, а x — свободная переменная, ее значения нам известны. Сформулируем задачу еще раз и немного другим языком — у нас есть набор экспериментальных данных в виде пар значений  и нужно найти прямую линию, на которой эти значения располагаются, найти линию, которая бы наилучшим образом обобщала экспериментальные данные. Немного кода для генерации данных:

**generate\_linear.py**

```

import numpy as np

import matplotlib.pyplot as plt

TOTAL = 200

STEP = 0.25

def func(x):

return 0.2 * x + 3

def generate_sample(total=TOTAL):

x = 0

while x < total * STEP:

yield func(x) + np.random.uniform(-1, 1) * np.random.uniform(2, 8)

x += STEP

X = np.arange(0, TOTAL * STEP, STEP)

Y = np.array([y for y in generate_sample(TOTAL)])

Y_real = np.array([func(x) for x in X])

plt.plot(X, Y, 'bo')

plt.plot(X, Y_real, 'g', linewidth=2.0)

plt.show()

```

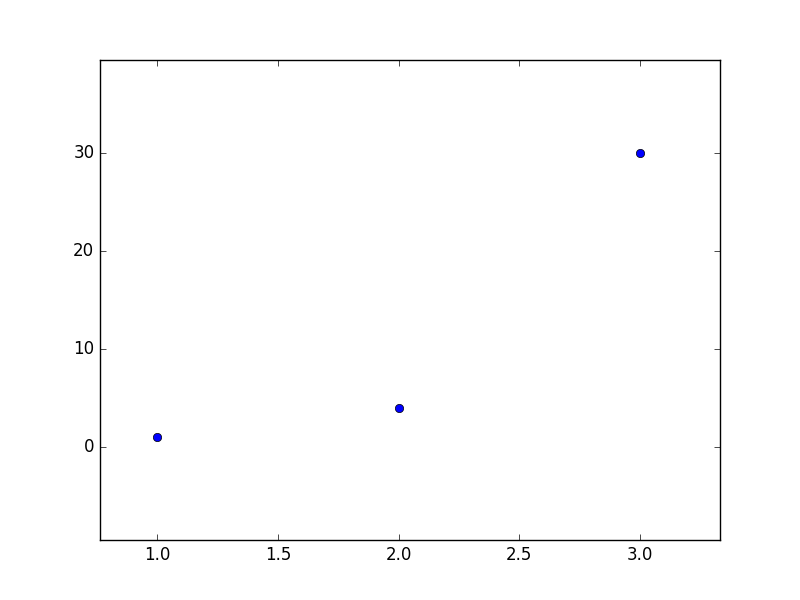

В результате должно получиться что-то вроде этого — достаточно случайно для неподготовленного человеческого глаза:

Зеленая линия — это «база» — сверху и снизу от этой линии случайным образом распределены данные, распределение равномерное. Уравнение для зеленой линии:

#### Метод наименьших квадратов

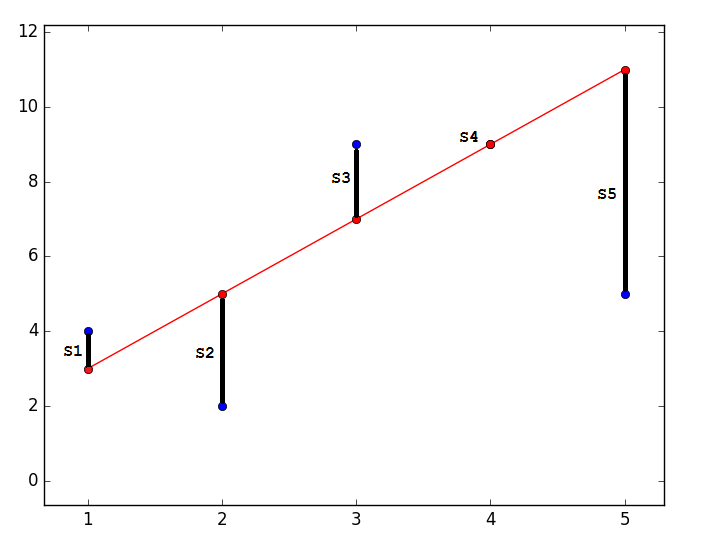

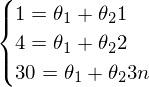

Суть МНК заключается в том, чтобы отыскать такие параметры , чтобы предсказанное значение было наиболее близким к реальному. Графически это выражается как-то так:

**Код**

```

import matplotlib.pyplot as plt

plt.plot([1, 2, 3, 4, 5], [4, 2, 9, 9, 5], 'bo')

plt.plot([1, 2, 3, 4, 5], [3, 5, 7, 9, 11], '-ro')

plt.show()

```

Наиболее близким — значит, что вектор  должен иметь наименьшую возможную длину. Так как вектор не единственный, то постулируется, что сумма *квадратов* длин всех векторов должна стремится к минимуму, учитывая вектор параметров . На мой взгляд, довольно логичный метод, умозрительный. Тем не менее, существует математическое доказательство корректности этого метода *Ремарка*: под длиной будем понимать [Евклидову метрику](https://ru.wikipedia.org/wiki/%D0%95%D0%B2%D0%BA%D0%BB%D0%B8%D0%B4%D0%BE%D0%B2%D0%B0_%D0%BC%D0%B5%D1%82%D1%80%D0%B8%D0%BA%D0%B0), хотя это необязательно. *Ремарка 2*: обратите внимание, что сумма квадратов. Опять-таки, никто не запретит попробовать минимизировать просто [сумму длин](https://ru.wikipedia.org/wiki/%D0%9C%D0%B5%D1%82%D0%BE%D0%B4_%D0%BD%D0%B0%D0%B8%D0%BC%D0%B5%D0%BD%D1%8C%D1%88%D0%B8%D1%85_%D0%BC%D0%BE%D0%B4%D1%83%D0%BB%D0%B5%D0%B9). На этой картинке красные точки — предсказанное значение (), синие — полученные в результате эксперимента(y без шапки).  — это как раз различие между ними, длина вектора.

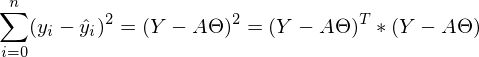

Математически это выглядит так:  — требуется найти такой вектор , при котором выражение  достигает минимума. Функция f в этом выражении — это:

или

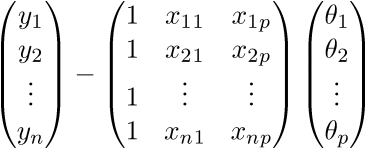

Я долго думал, стоит ли сразу переходить к векторизации кода и в итоге без нее статья слишком удлиняется. Поэтому введем новые обозначения:

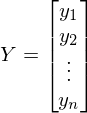

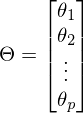

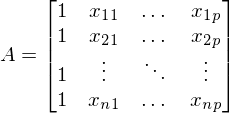

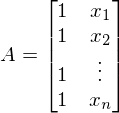

— вектор, состоящий из значений зависимой переменной y —

— вектор параметров —

A — матрица из значений свободной переменной x. В данном случае первый столбец равен 1 (отсутствует x\_0) — . В одномерном случае в матрице A только два столбца —

После новых обозначений уравнение линии переходит в матричное уравнение следующего вида: . В этом уравнении 2 неизвестных — предсказанные значения и параметры. Мы можем попробовать узнать параметры из такого же уравнения, но с известными значениями:  Иначе можно представить как систему уравнений:

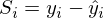

Казалось бы, что все известно — и вектор Y, и вектор X — остается только решить уравнение. Большая проблема заключается в том, что система может не иметь решений — иначе, у матрицы A может не существовать обратной матрицы. Простой пример системы без решения — любые три\четыре\n точки не на одной прямой\плоскости\гиперплоскости — это приводит к тому, что матрица А становится неквадратной, а значит по определению нет обратной матрицы .

Наглядный пример невозможности решения «простым способ» (каким-нибудь методом Гаусса решить систему):

Система выглядит так:  — вряд ли выйдет отыскать решения для такой системы.

Как итог невозможно построить линию через эти три точки — можно лишь построить примерно верное решение.

Такое отступление — это объяснение того, зачем вообще понадобился МНК и его братья. Минимизации функции стоимости (функции потерь) и невозможность (ненужность, вредность) найти абсолютно точное решение — одни из самых базовых идей, что лежат в основе нейронных сетей. Но до них еще далеко, а пока вернемся к методу наименьших квадратов.

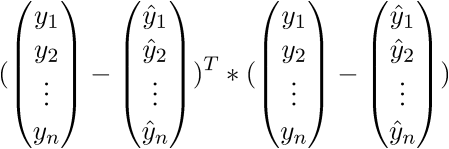

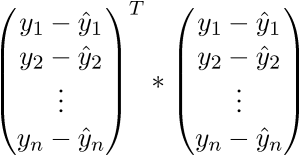

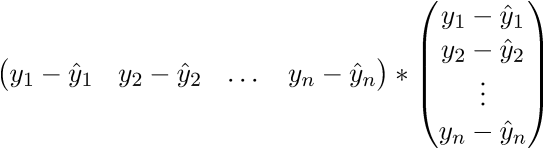

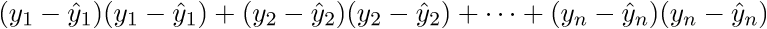

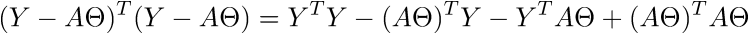

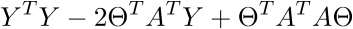

МНК говорит нам, что необходимо найти минимум суммы квадратов векторов вида:  Сумму квадратов с учетом того, что все преобразовано в вектора\матрицы можно записать следующим образом: .

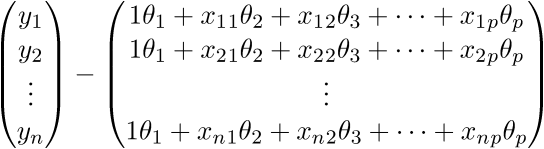

У меня не повернется язык назвать это тривиальным преобразованием, новичкам бывает довольно сложно уйти от простых переменных к векторам поэтому я распишу все это выражение полностью в «раскрытых» векторах. Опять-таки, чтобы ни одна строка не была непонятым «волшебством».

Для начала просто «раскроем» вектора в соответствии с их определением: .

Проверим размерность — для матрицы А она равна (n;p), а для вектора  — (p;1), а для вектора  — (n;1). В результате получим разницу двух векторов размерностью (n;1) —

Сверимся с определением — по определению выходит, что каждая строка правой матрицы равна . Запишем далее:

В итоге последняя строка и есть сумма квадратов длин, как нам и нужно. Каждый раз, конечно же, такие фокусы в уме проворачивать довольно долго, но к векторной нотации можно привыкнуть быстро. У этого есть и плюс для программиста — удобней работать и портировать код для GPU, где ехал вектор через вектор. Я как-то портировал генерацию шума Перлина на GPU и примерное понимание векторной нотации неплохо облегчило работу. Есть и минус — придется постоянно лезть в интернет, чтобы вспомнить тождества и правила линейной алгебры. После доказательства верности векторной нотации перейдем к дальнейшим преобразованиям:

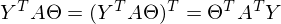

Здесь использованы [свойства транспонирования матриц](https://ru.wikipedia.org/wiki/%D0%A2%D1%80%D0%B0%D0%BD%D1%81%D0%BF%D0%BE%D0%BD%D0%B8%D1%80%D0%BE%D0%B2%D0%B0%D0%BD%D0%BD%D0%B0%D1%8F_%D0%BC%D0%B0%D1%82%D1%80%D0%B8%D1%86%D0%B0) — а именно транспонирование суммы и произведения. А также тот факт, что выражения  и  есть константа. Доказать можно взяв размерность матриц из их определения и посчитав размерность выражения после всех умножений:

Константу можно представить как симметричную матрицу, следовательно:

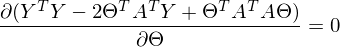

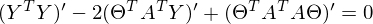

После преобразований и раскрытия скобок, приходит время решить-таки поставленную задачу — найти минимум данного выражения, учитывая . Минимум находится весьма буднично — приравнивая первый дифференциал по  к нулю. По-хорошему, нужно сначала доказать, что этот минимум вообще существует, предлагаю доказательство опустить и подсмотреть его в литературе [самостоятельно](https://ru.wikipedia.org/wiki/%D0%AD%D0%BA%D1%81%D1%82%D1%80%D0%B5%D0%BC%D1%83%D0%BC). Интуитивно и так понятно, что функция квадратичная — парабола, и минимум у нее есть.

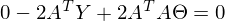

Итак,

Часть  называют псевдообратной матрицей.

Теперь в наличии все нужные формулы. Последовательность действий такая:

1) Сгенерировать набор экспериментальных данных.

2) Создать матрицу A.

3) Найти псевдообратную матрицу .

4) Найти

После этого задача будет решена — у нас в распоряжении будут параметры прямой линии, наилучшим образом обобщающей экспериментальные данные. Иначе, у нас окажутся параметры для прямой, наилучшим образом выражающей линейную зависимость одной переменной от другой — именно это и требовалось.

**generate\_linear.py**

```

import numpy as np

import matplotlib.pyplot as plt

TOTAL = 200

STEP = 0.25

def func(x):

return 0.2 * x + 3

def prediction(theta):

return theta[0] + theta[1] * x

def generate_sample(total=TOTAL):

x = 0

while x < total * STEP:

yield func(x) + np.random.uniform(-1, 1) * np.random.uniform(2, 8)

x += STEP

X = np.arange(0, TOTAL * STEP, STEP)

Y = np.array([y for y in generate_sample(TOTAL)])

Y_real = np.array([func(x) for x in X])

A = np.empty((TOTAL, 2))

A[:, 0] = 1

A[:, 1] = X

theta = np.linalg.pinv(A).dot(Y)

print(theta)

Y_prediction = A.dot(theta)

error = np.abs(Y_real - Y_prediction)

print("Error sum:", sum(error))

plt.plot(X, Y, 'bo')

plt.plot(X, Y_real, 'g', linewidth=2.0)

plt.plot(X, Y_prediction, 'r', linewidth=2.0)

plt.show()

```

И результаты:

Красная линия была предсказана и почти совпадает с зеленой «базой». Параметры в моем запуске равны: [3.40470411, 0.19575733]. Попробовать предсказать значения не выйдет, потому что пока неизвестно распределение ошибок модели. Все, что можно сделать, так это проверить, правда ли для данного случая МНК будет подходящим и лучшим методом для обобщения. [Условий три](https://ru.wikipedia.org/wiki/%D0%A2%D0%B5%D0%BE%D1%80%D0%B5%D0%BC%D0%B0_%D0%93%D0%B0%D1%83%D1%81%D1%81%D0%B0_%E2%80%94_%D0%9C%D0%B0%D1%80%D0%BA%D0%BE%D0%B2%D0%B0):

1) Мат ожидание ошибок равно нулю.

2) Дисперсия ошибок — постоянная величина.

3) Отсутствует корреляция ошибок в разных измерениях. [Ковариация](https://ru.wikipedia.org/wiki/%D0%9A%D0%BE%D0%B2%D0%B0%D1%80%D0%B8%D0%B0%D1%86%D0%B8%D1%8F) равна нулю.

Для этого я дополнил пример вычислением необходимых величин и провел измерения дважды:

**generate\_linear.py**

```

import numpy as np

import matplotlib.pyplot as plt

TOTAL = 200

STEP = 0.25

def func(x):

return 0.2 * x + 3

def prediction(theta):

return theta[0] + theta[1] * x

def generate_sample(total=TOTAL):

x = 0

while x < total * STEP:

yield func(x) + np.random.uniform(-1, 1) * np.random.uniform(2, 8)

x += STEP

X = np.arange(0, TOTAL * STEP, STEP)

Y = np.array([y for y in generate_sample(TOTAL)])

Y_real = np.array([func(x) for x in X])

A = np.empty((TOTAL, 2))

A[:, 0] = 1

A[:, 1] = X

theta = np.linalg.pinv(A).dot(Y)

print(theta)

Y_prediction = A.dot(theta)

error = Y - Y_prediction

error_squared = error ** 2

M = sum(error) / len(error)

M_squared = M ** 2

D = sum([sq - M_squared for sq in error_squared]) / len(error)

print("M:", M)

print("D:", D)

plt.plot(X, Y, 'bo')

plt.plot(X, Y_real, 'g', linewidth=2.0)

plt.plot(X, Y_prediction, 'r', linewidth=2.0)

plt.show()

```

Неидеально, но все без обмана работает так, как и ожидалось.

[Следующая часть.](https://habrahabr.ru/post/307312/)

Полный список библиотек для запуска примеров: numpy, matplotlib, requests.

Материалы, использованные в статье — <https://github.com/m9psy/neural_nework_habr_guide> | https://habr.com/ru/post/307004/ | null | ru | null |

# bash скрипт с поддержкой длинных (gnu-style) опций

Предстала на первый взгляд тривиальная задача: написать скрипт с различными опциями при запуске. Допустим нужно обработать всего две опции: name и dir. И задача действительно тривиальна при условии, что опции у нас короткие. Но если есть жгучее желание использовать длинные опции, то пиши пропало: getopts, который планировалось использовать изначально, в bash совсем на это не годится.

Хотя в ksh всё работает на ура:

```

#!/bin/ksh

while getopts "f(file):s(server):" flag

do

echo "$flag" $OPTIND $OPTARG

done

```

Но у нас bash, поэтому грустно вздыхаем и пытаемся выбраться из сложившейся ситуации.

Вриант парсить самостоятельно с одной стороны привлекателен, но уж слишком скучен и неинтересен: каждый раз нужно думать об обработке ошибок, исключений и многих других вещах. Да и не хочется каждый раз изобретать велосипед, при написании подобного скрипта.

```

#!/bin/bash

while true;

do

case "$1" in

-n | --name ) echo NAME="$2"; shift 2;;

-d | --dir ) echo DIR="$2"; shift 2;;

esac

done

```

Можно попробовать использовать getopts с небольшим хаком для поддержки длинных имён:

```

#!/bin/bash

while getopts ":n:d:-:" OPTION; do

case "$OPTION" in

-) case "$OPTARG" in

name) echo LONG_NAME="${!OPTIND}";;

dir) echo LONG_DIR="${!OPTIND}" ;;

esac;;

n) echo SHORT_NAME="$OPTARG" ;;

d) echo SHORT_DIR="$OPTARG" ;;

esac

done

```

Но назвать рабочим такое решение, язык не поворачивается: одновременно поддерживается только одна длинная опция (первая указанная в параметрах), вторая будет проигнорирована.

Сетуем, что в bash до сих пор не впилили getopts\_long, но гугл подсказывает, что это можно сделать самостоятельно: скачиваем функцию [getopts\_long](http://stchaz.free.fr/getopts_long) и включаем её в наш скрипт:

```

#!/bin/bash

. getopts_long

while getopts_long :d:n::vh opt \

name required_argument \

dir required_argument \

help 0 "" "$@"

do

case "$opt" in

n|name) echo NAME="$OPTLARG";;

d|dir) echo DIR="$OPTLARG";;

help 0 "" "$@"

esac

done

```

Казалось бы вот оно, счастье, но нашлось ещё более элегантное решение: более продвинутая библиотека [shflags](http://code.google.com/p/shflags/), которая помимо парсинга опций умеет так же и проверять значения. Различаются строки, логические переменные, целые числа, нецелые числа (по сути это строки, т.к. в шелле нет понятия нецелых чисел, но проверка на правильность формата есть. Определяется это при указании переменных через DEFINE\_string|\_boolean|\_float|\_integer и даже самостоятельно обзывает переменные для опций согласно длинному имени опции, так же поддерживает кучу различных шеллов (sh, bash, dash, ksh, zsh). Красота да и только. Более подробно о плюшках можно посмотреть в самой библотеке. Там достаточно подробная справка. Пример использования:

```

#!/bin/bash

. ./shflags

DEFINE_string 'name' 'world' 'comment for name' 'n'

DEFINE_string 'dir' 'dir' 'comment for dir' 'd'

FLAGS "$@" || exit 1

eval set -- "${FLAGS_ARGV}"

echo "Name is ${FLAGS_name} and dir is ${FLAGS_dir}"

```

Однако и в этом решении есть ложка дёгтя: библиотека использует getopt для парсинга опций, а негнутый getopt, как пишут в интернетах, не поддерживает длинные опции. Так что возможны проблемы с совместимостью. | https://habr.com/ru/post/133860/ | null | ru | null |

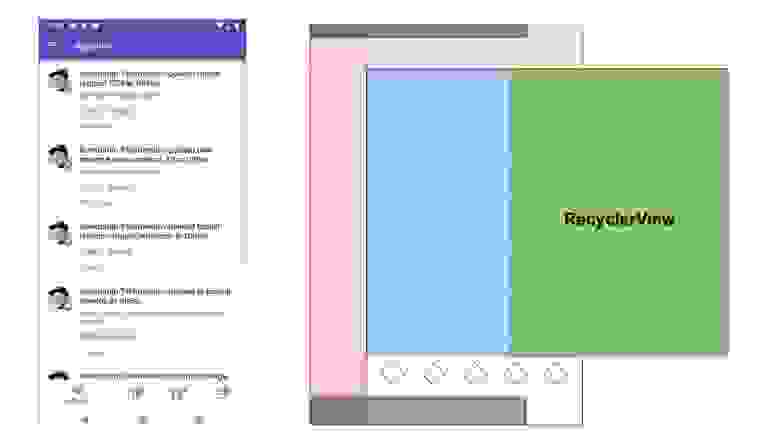

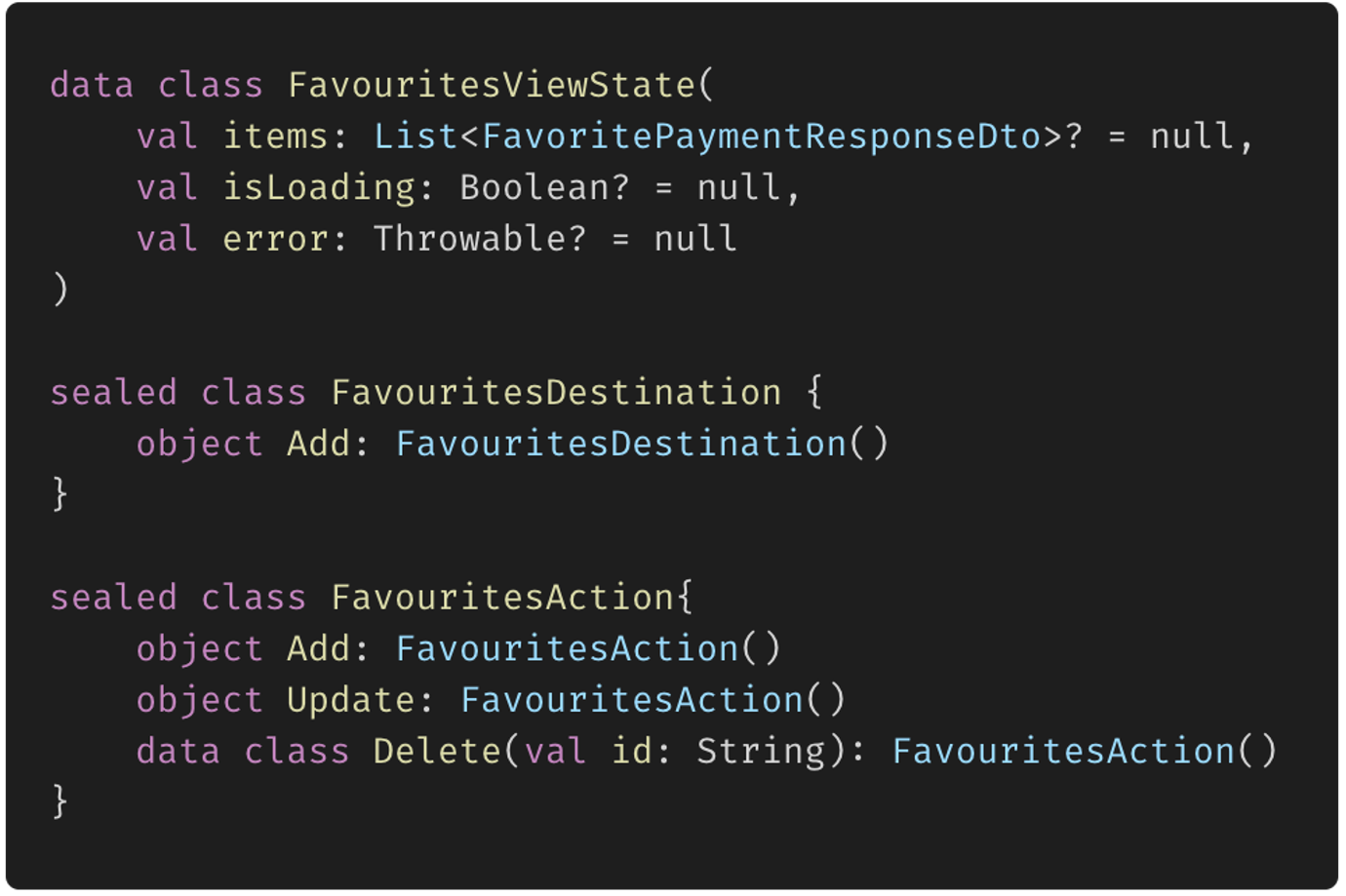

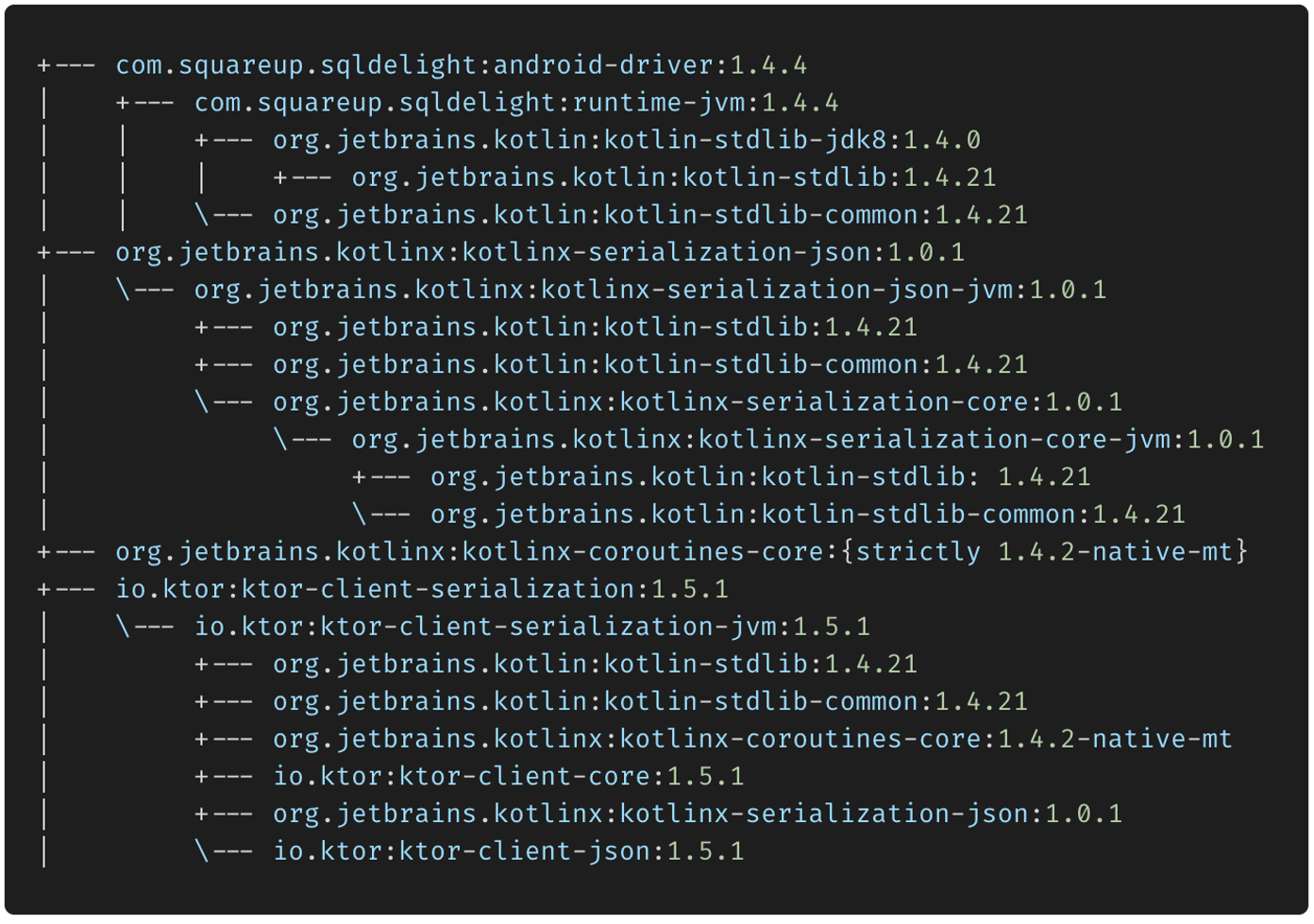

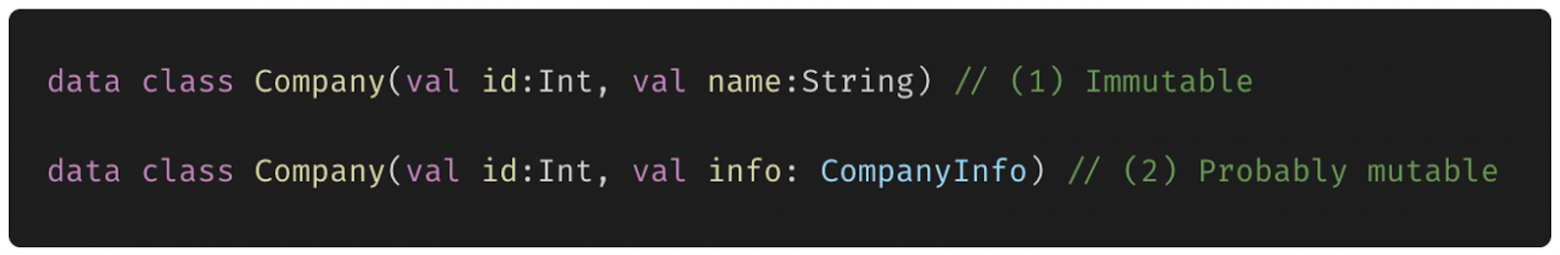

# Внедрение зависимостей (Dependency Injection) с GetIt во Flutter

Внедрение зависимостей - DI - Dependency injection - термин часто встречающийся на собеседованиях. Сам по себе концепт опирается на более объемный принцип инверсии зависимостей (буква D в SOLID), но намного проще и ближе к практике. Кратко можно сказать, что при внедрении зависимостей, мы задаем значения переменных объекта в момент выполнения программы, а не в момент компиляции.

В этой статье я постараюсь показать, что использование специальных библиотек для DI - это легко и удобно, даже для небольших проектов и опишу три случая с кодом ДО и ПОСЛЕ. Надеюсь, даже в небольшом проекте сразу станет понятно, что код после применения внедрения зависимостей стал чуть-чуть лучше.

Часто программисты не понимают, для чего им в их небольших проектах, которые далеки от тысяч файлов корпоративных громад, нужно внедрение зависимостей. В таких проектах не описываются интерфейсы, используются одни и те же классы, экземпляры которых можно передать всем, кому это необходимо. На самый крайний случай, используются синглтоны для получения единственного экземпляра класса во всем приложении.

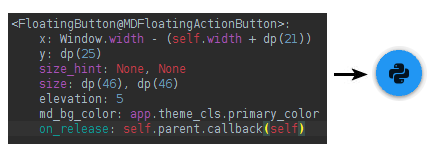

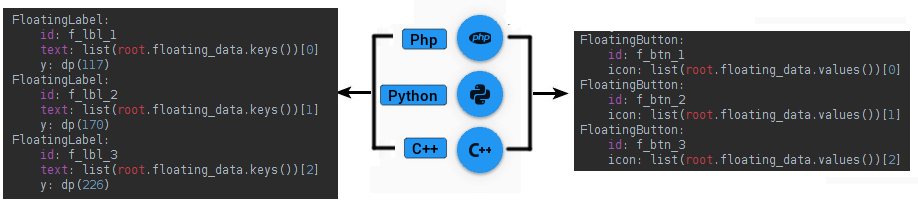

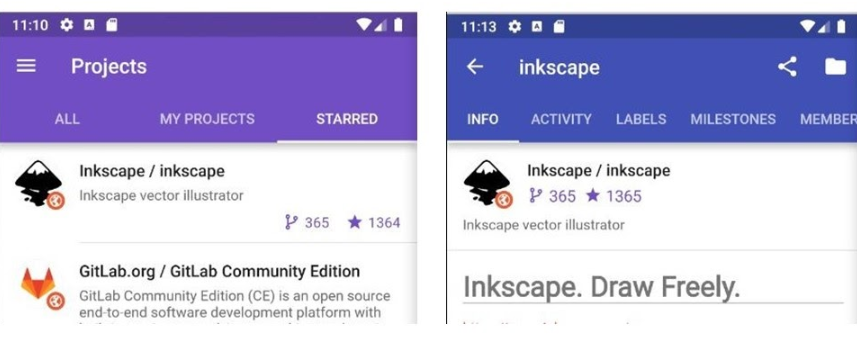

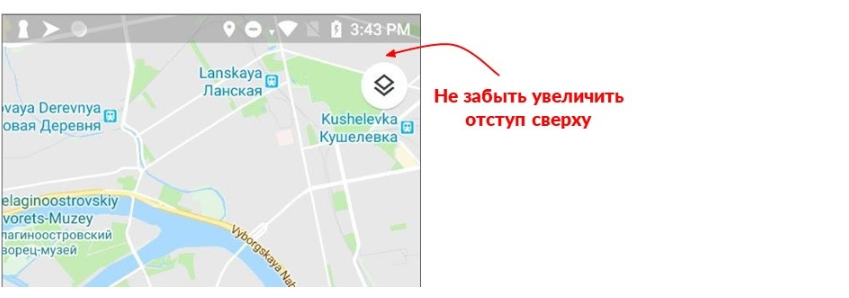

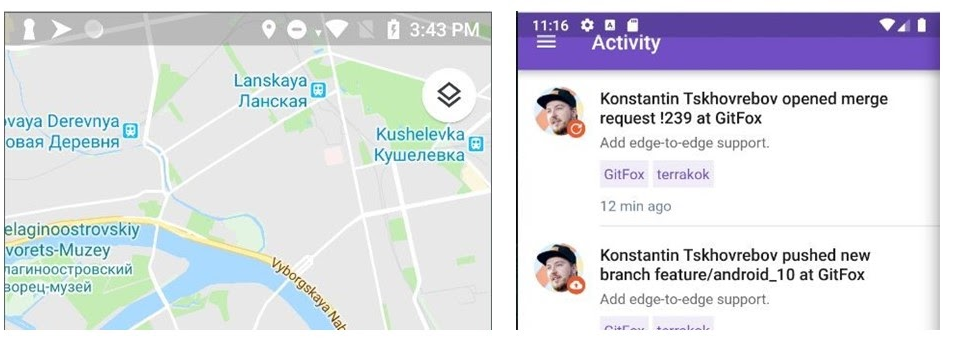

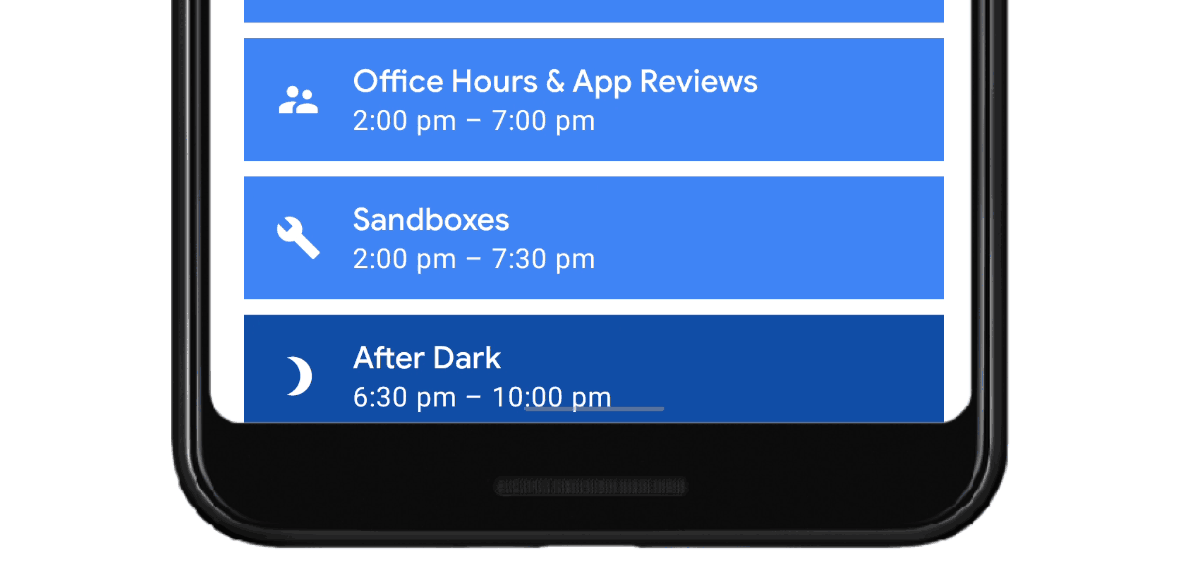

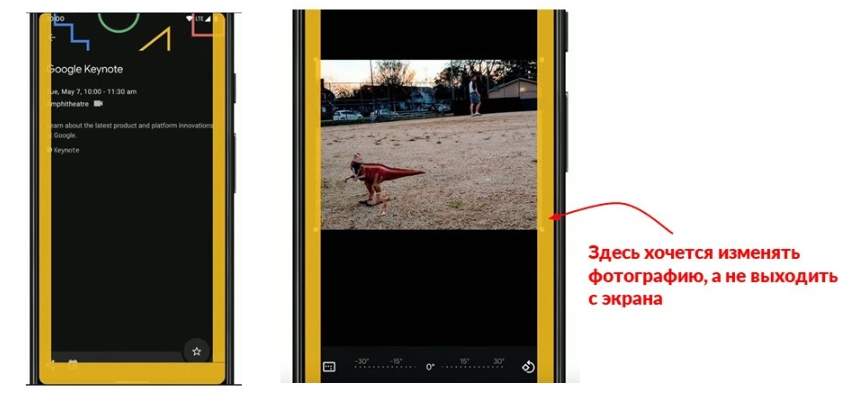

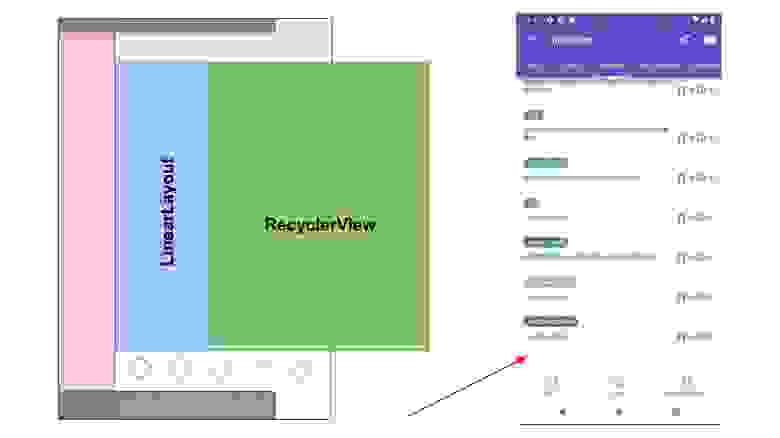

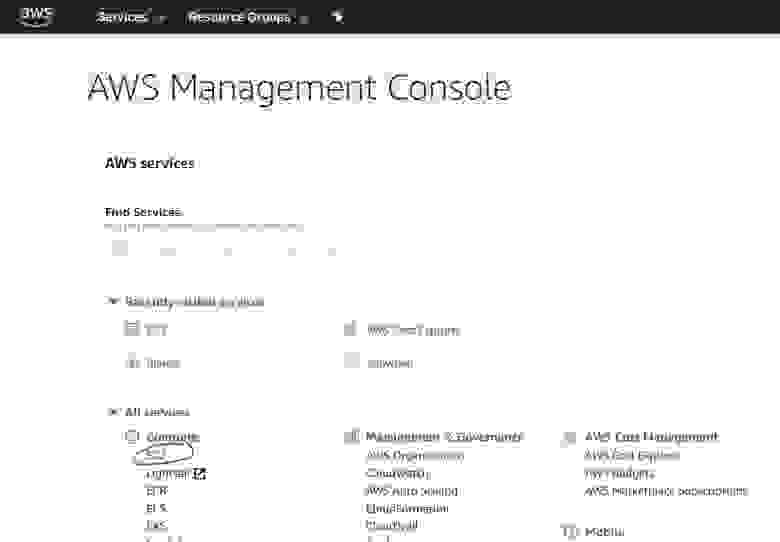

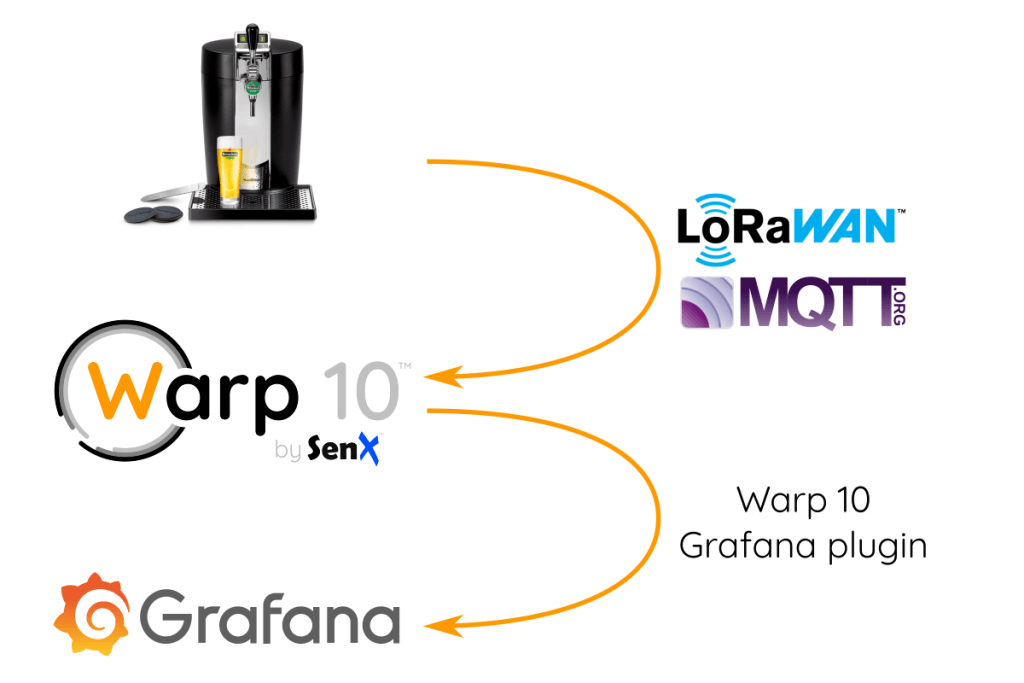

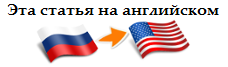

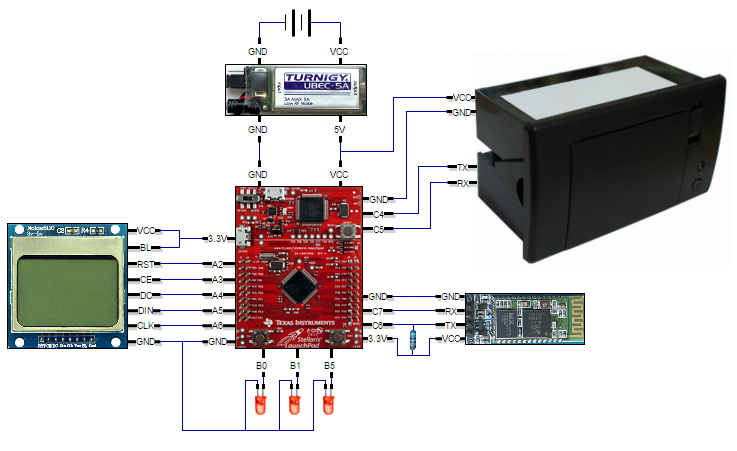

Работать мы будем с достаточно популярной библиотекой [GetIt](https://pub.dev/packages/get_it). [Проект](https://github.com/Yahhi/weather_for_runners) минималистичен: приложение показывает погоду в настоящий момент с использованием одного из двух сервисов: Yandex.Weather или VisualCrossing. Если пользователь разрешит, то учитывается его местоположение и погода будет актуальна для его города.

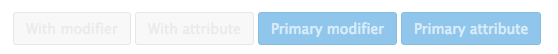

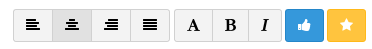

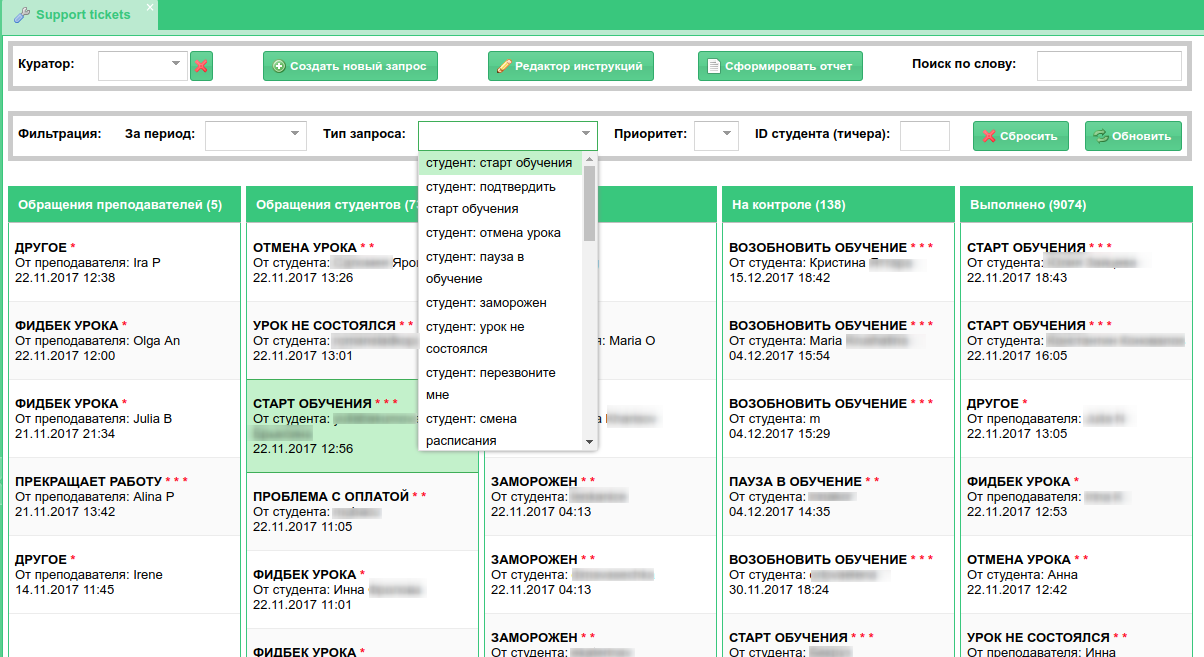

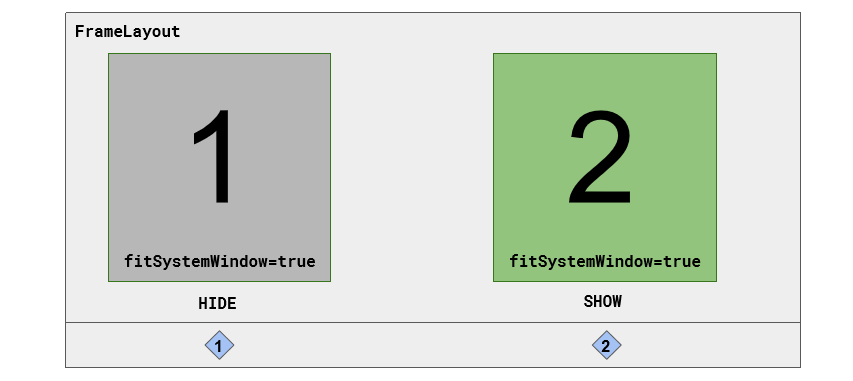

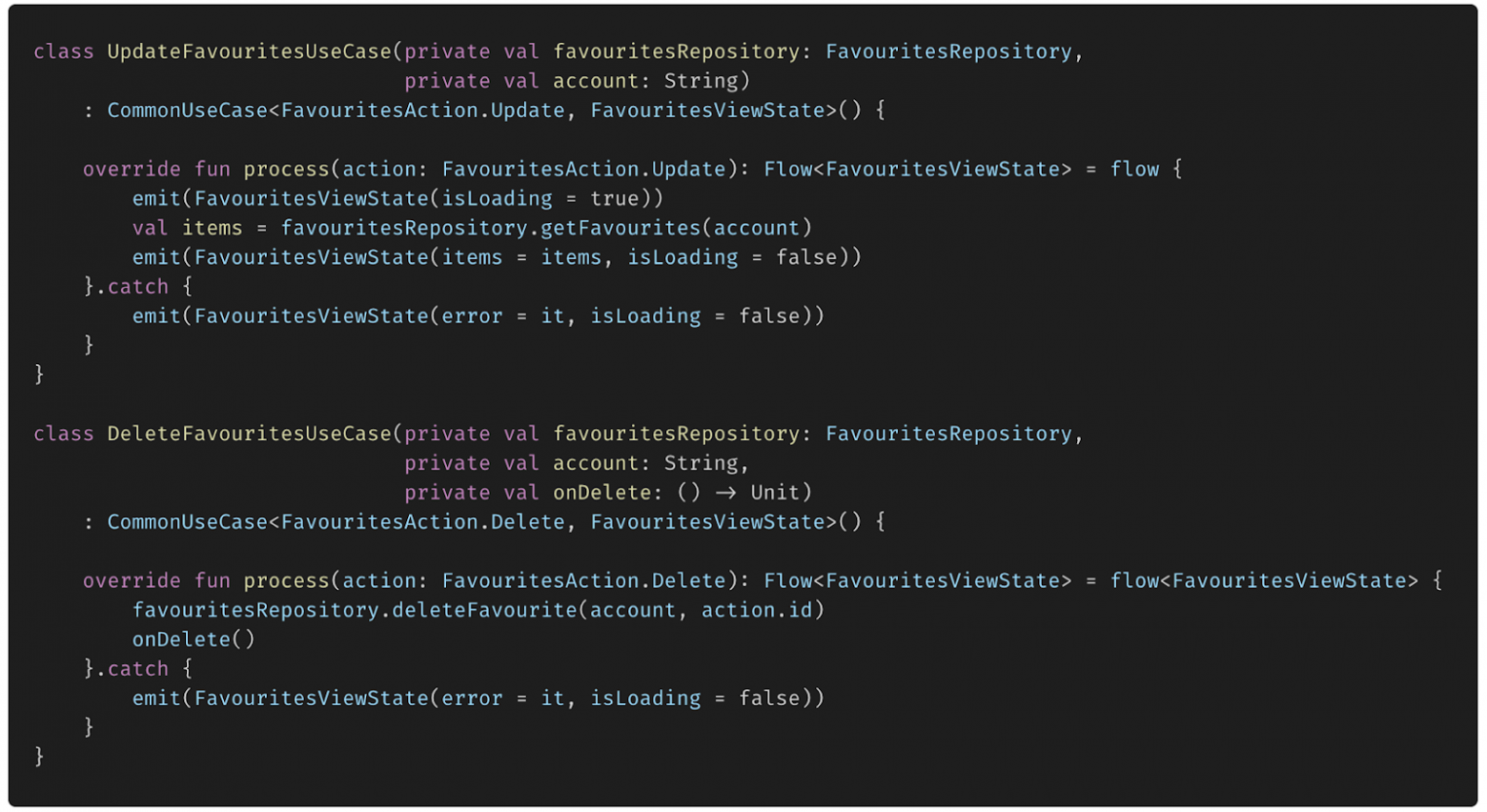

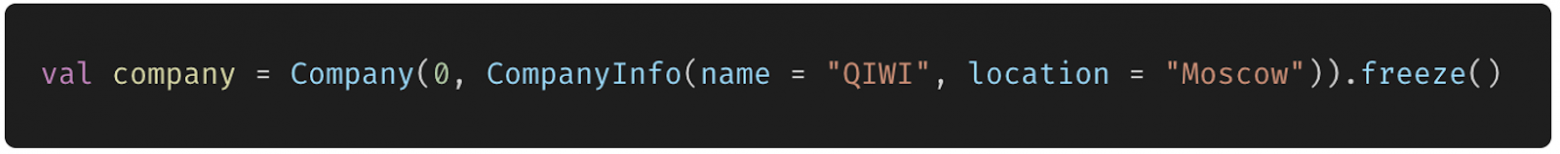

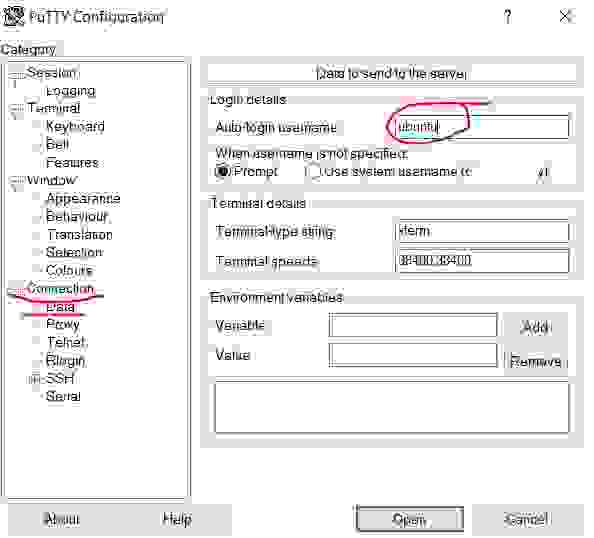

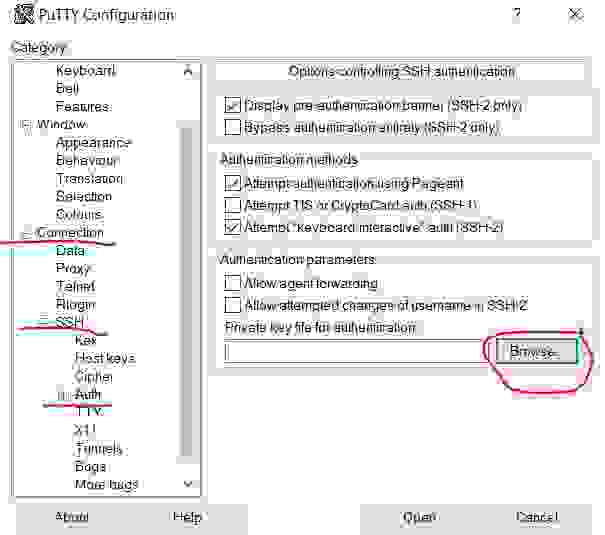

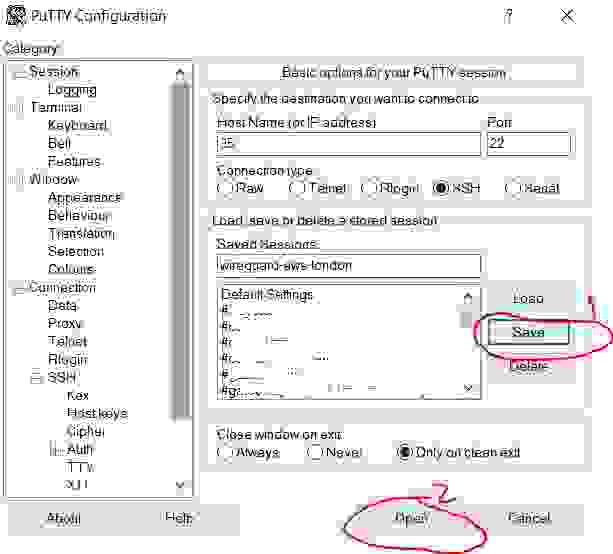

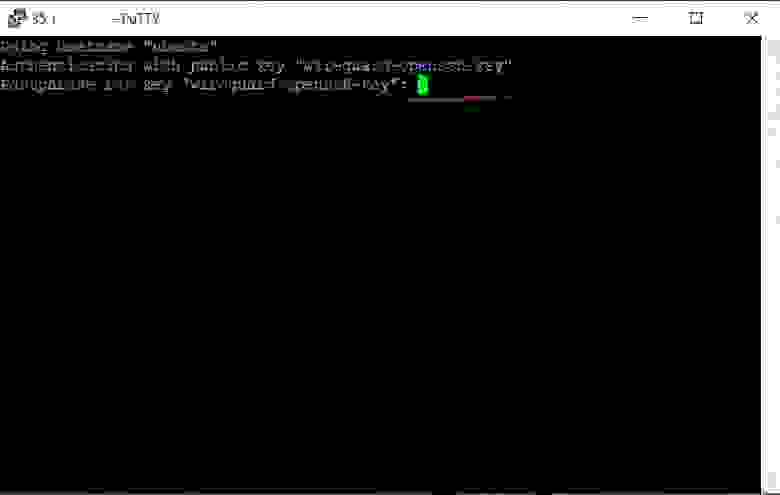

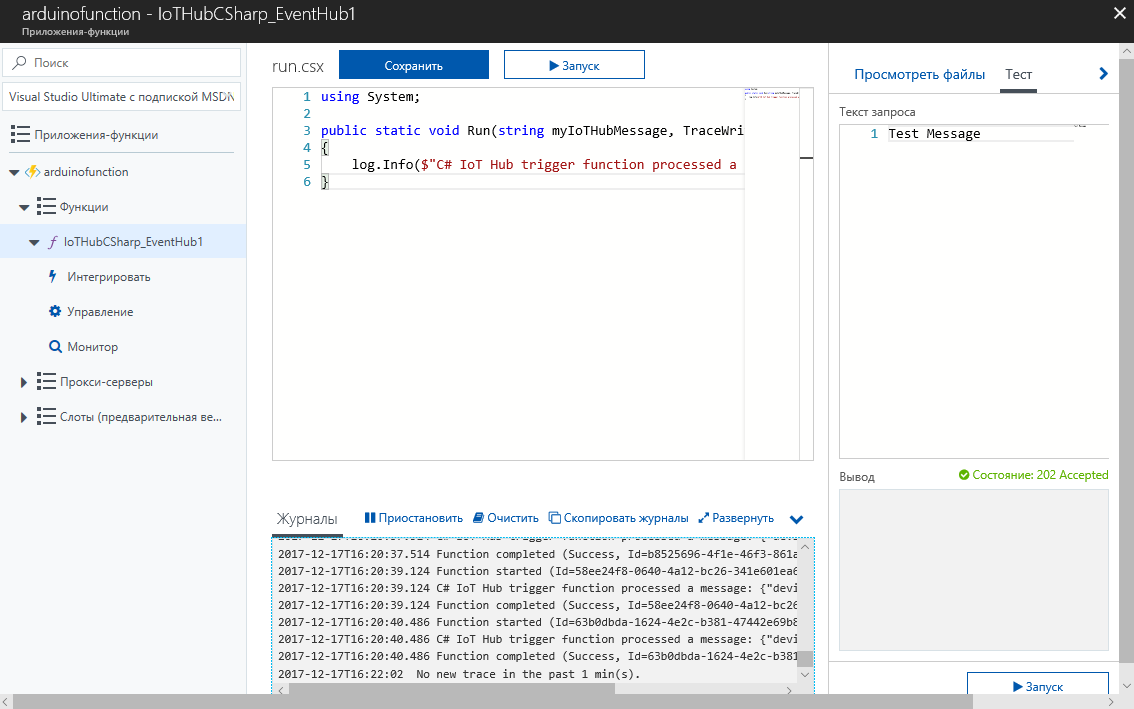

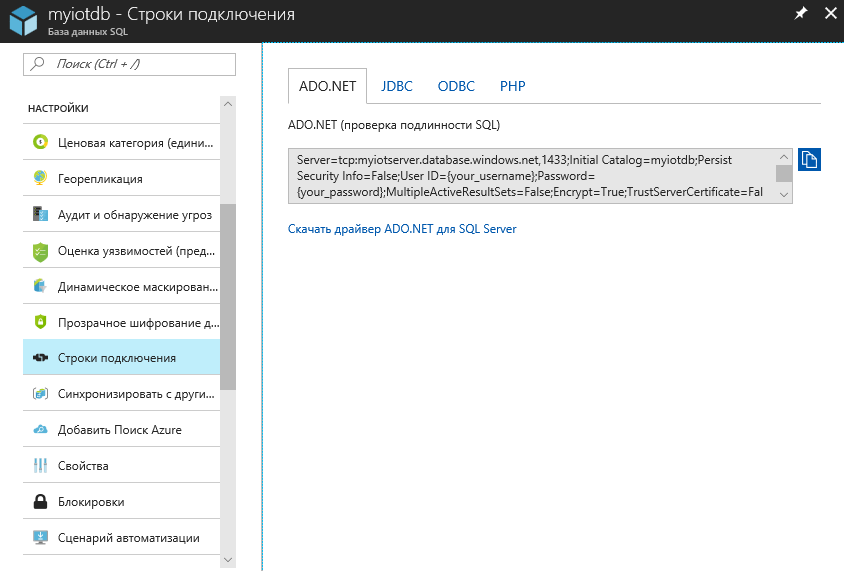

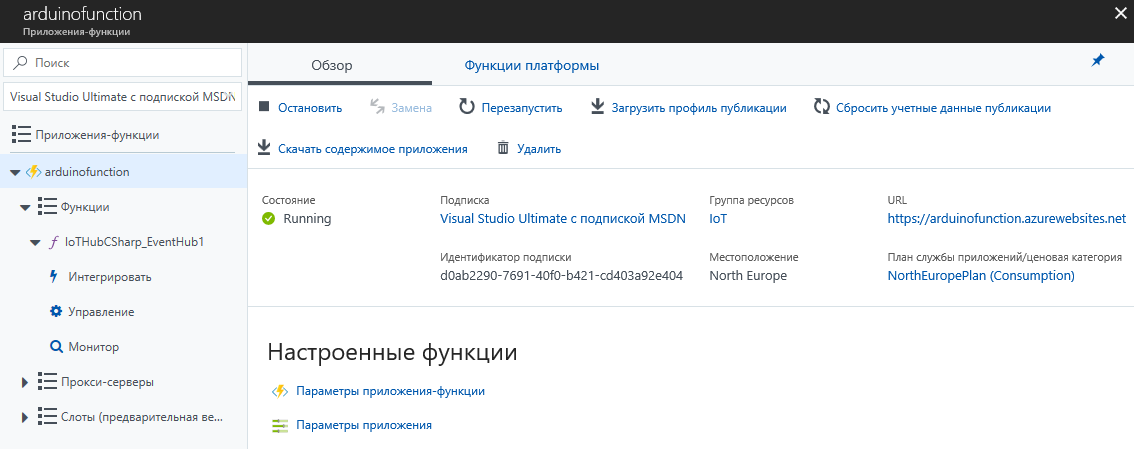

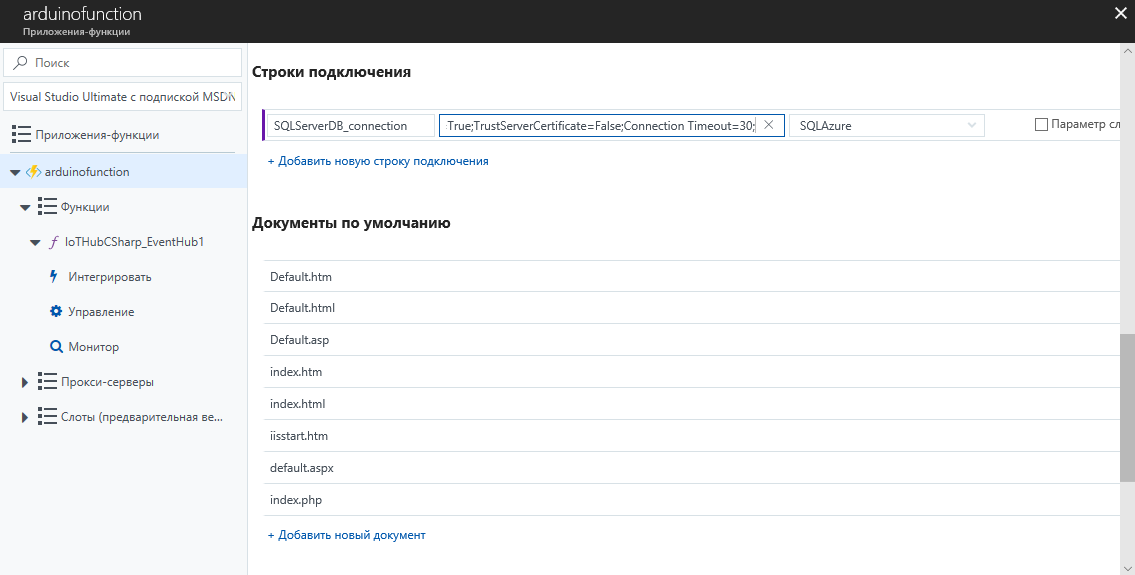

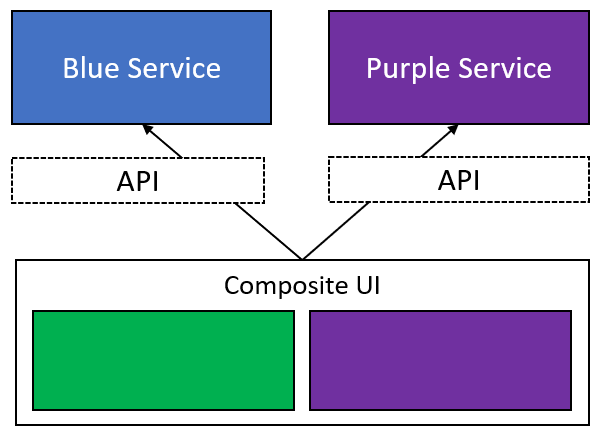

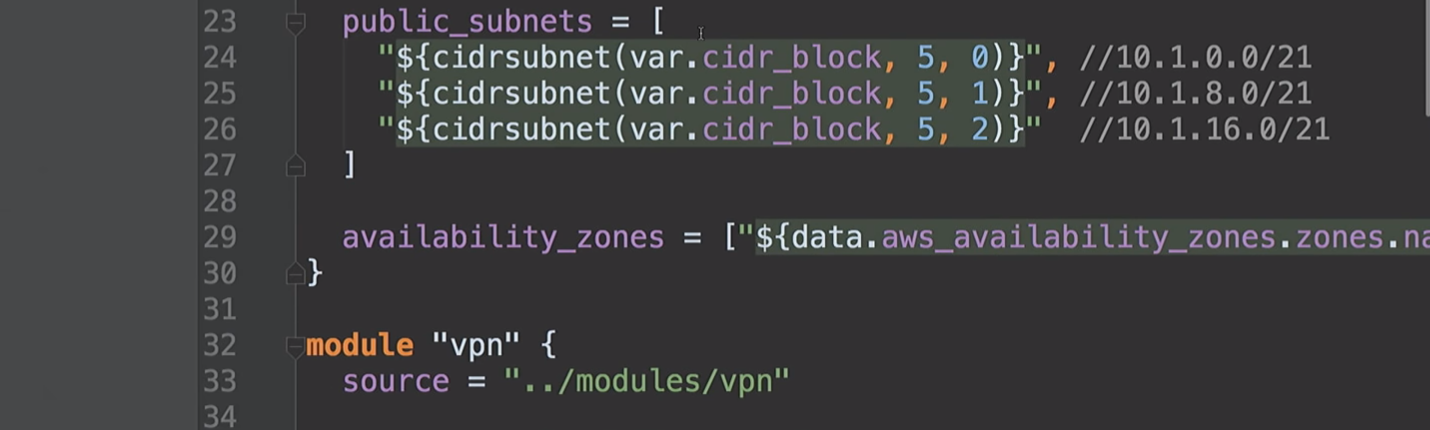

**Пример 1. Переход от внедрения переменных через конструктор и создания их в коде к использованию GetIt.** В нашем случае настройки приложения, а именно - какой сервис для получения погодных данных был выбран пользователем - хранятся в стандартном платформенно-зависимом хранилище - SharedPreferences. При запуске приложения запускается тот сервис, который был выбран ранее. Если ничего не выбрано, запускается сервис по-умолчанию.

До внедрения GetIt класс настроек создавался в main и передавался в остальные классы через конструктор:

```

Future main() async {

WidgetsFlutterBinding.ensureInitialized();

final settings = SettingsRepository();

await settings.loaded;

runApp(MyApp(settingsRepository: settings));

}

class MyApp extends StatelessWidget {

const MyApp({Key? key, required this.settingsRepository}) : super(key: key);

final SettingsRepository settingsRepository;

@override

Widget build(BuildContext context) {

return MaterialApp(

home: HomePage(settingsRepository: settingsRepository),

...

);

}

}

class HomePage extends StatefulWidget {

const HomePage({Key? key, required this.settingsRepository}) : super(key: key);

final SettingsRepository settingsRepository;

...

```

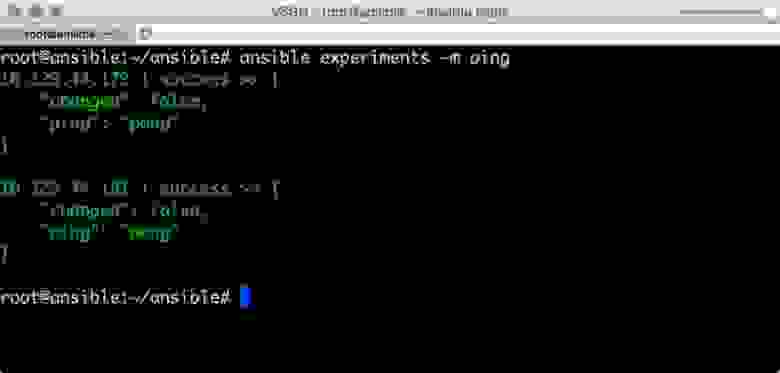

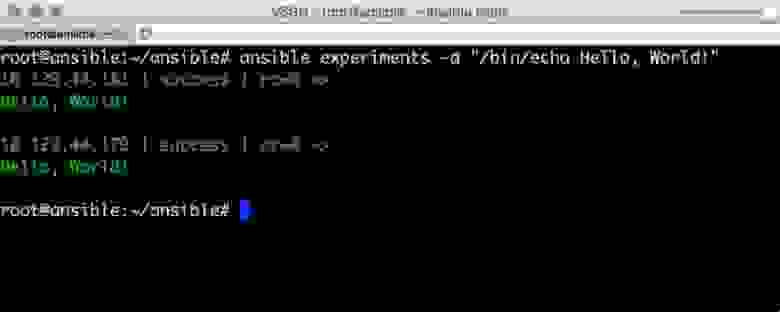

После внедрения GetIt класс настроек регистрируется в нем и затем его получают только там, где он действительно нужен, промежуточные классы не загромождаются лишними переменными.

```

Future main() async {

WidgetsFlutterBinding.ensureInitialized();

final settings = SettingsRepository();

await settings.loaded;

GetIt.instance.registerSingleton(settings);

runApp(const MyApp());

}

class HomePage extends StatefulWidget {

const HomePage({Key? key}) : super(key: key);

@override

\_HomePageState createState() => \_HomePageState();

}

class \_HomePageState extends State {

SettingsRepository get settingsRepository => GetIt.instance.get();

...

```

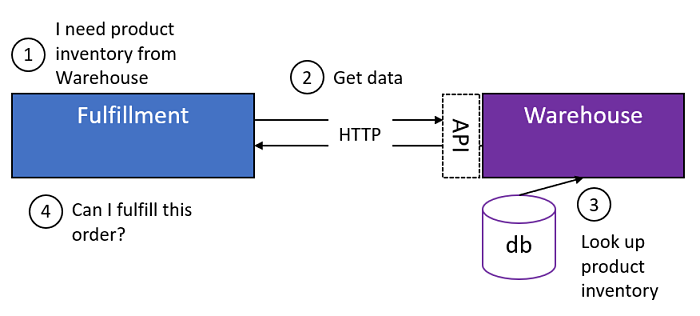

И переход на внедрение зависимостей вместо создания переменной: получение позиции пользователя. Для этой операции в \_HomePageState используется Geolocator. В дальнейшем при юнит-тестировании и виджет-тестировании мы не сможем обращаться к этой библиотеке, поэтому нужно заменить способ получения позиции пользователя на DI. Было:

```

Future \_loadWeather() async {

final knownPosition = await Geolocator.getLastKnownPosition();

...

}

```

Стало:

```

//в main.dart

Future main() async {

...

final position = await geolocator.getLastKnownPosition();

if (position != null) {

GetIt.instance.registerSingleton(position);

//позицию можно было бы получать и из настроек пользователя, если он не согласен давать доступ к GPS

}

...

//в home\_page.dart

Future \_loadWeather() async {

final knownPosition = GetIt.instance.isRegistered() ? GetIt.instance.get() : null;

...

}

```

Аналогично может быть зарегистрирована служба логирования, служба обработки ошибок, клиент http и т.д. Нет нужды упоминать экземпляр класса в конструкторе, а значит меньше параметров, которые необходимо задать при инициализации.

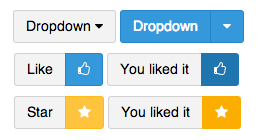

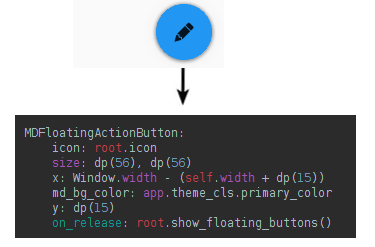

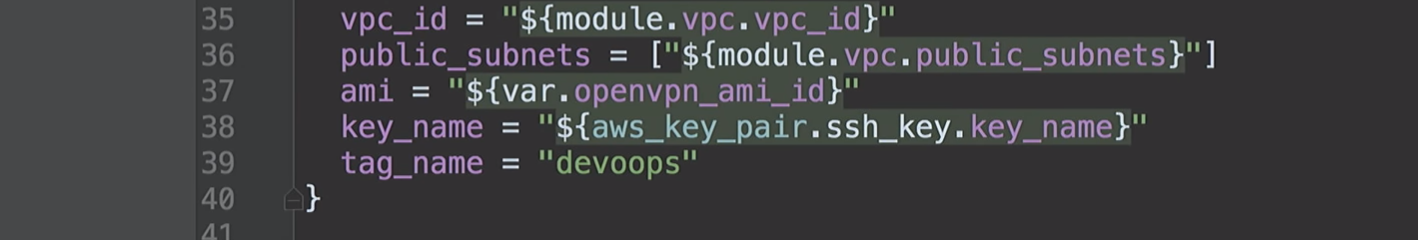

**Пример 2. Использование одного из поставщиков данных.** В приложении описан общий интерфейс получения погодных данных, тем не менее каждый раз определять, к какому конкретно классу надо обратиться для получения данных, - неудобно. Здесь тоже поможет GetIt. Вместо того, чтобы создавать экземпляр класса в виджете, который ответственен за показ погоды и пересоздавать виджет или экземпляр класса, в коде используется геттер, который получает всегда актуальный класс-поставщик погодных данных через GetIt.

Было:

```

Future \_loadWeather() async {

final position = await Geolocator.getLastKnownPosition();

final Map predictions;

if (widget.settingsRepository.remoteServerName == YandexWeatherProvider.providerName) {

predictions = await YandexWeatherProvider().loadPredictions(position?.latitude ?? 0.0, position?.longitude ?? 0.0);

} else {

predictions = await VisualCrossingWeatherProvider().loadPredictions(position?.latitude ?? 0.0, position?.longitude ?? 0.0);

}

currentWeather = predictions[DateTime.now().hourStart];

setState(() {});

}

```

Стало:

```

// в main.dart

Future main() async {

...

GetIt.instance.registerSingleton(settings.remoteServerName == YandexWeatherProvider.providerName ? YandexWeatherProvider() : VisualCrossingWeatherProvider());

...

}

...

// при загрузке погоды

WeatherProvider get weatherProvider => GetIt.instance.get();

Future \_loadWeather() async {

final knownPosition = GetIt.instance.isRegistered() ? GetIt.instance.get() : null;

final predictions = await weatherProvider.loadPredictions(knownPosition?.latitude ?? 0.0, knownPosition?.longitude ?? 0.0);

currentWeather = predictions![DateTime.now().hourStart];

setState(() {});

}

...

// при переключении настроек пользователя

void \_changeServer(String? value) {

if (value == null) return;

settingsRepository.remoteServerName = value;

GetIt.instance.unregister();

GetIt.instance.registerSingleton(value == YandexWeatherProvider.providerName ? YandexWeatherProvider() : VisualCrossingWeatherProvider());

setState(() {});

}

```

Аналогично можно регистрировать онлайн/оффлайн поставщики данных, любые взаимозаменяемые модули.

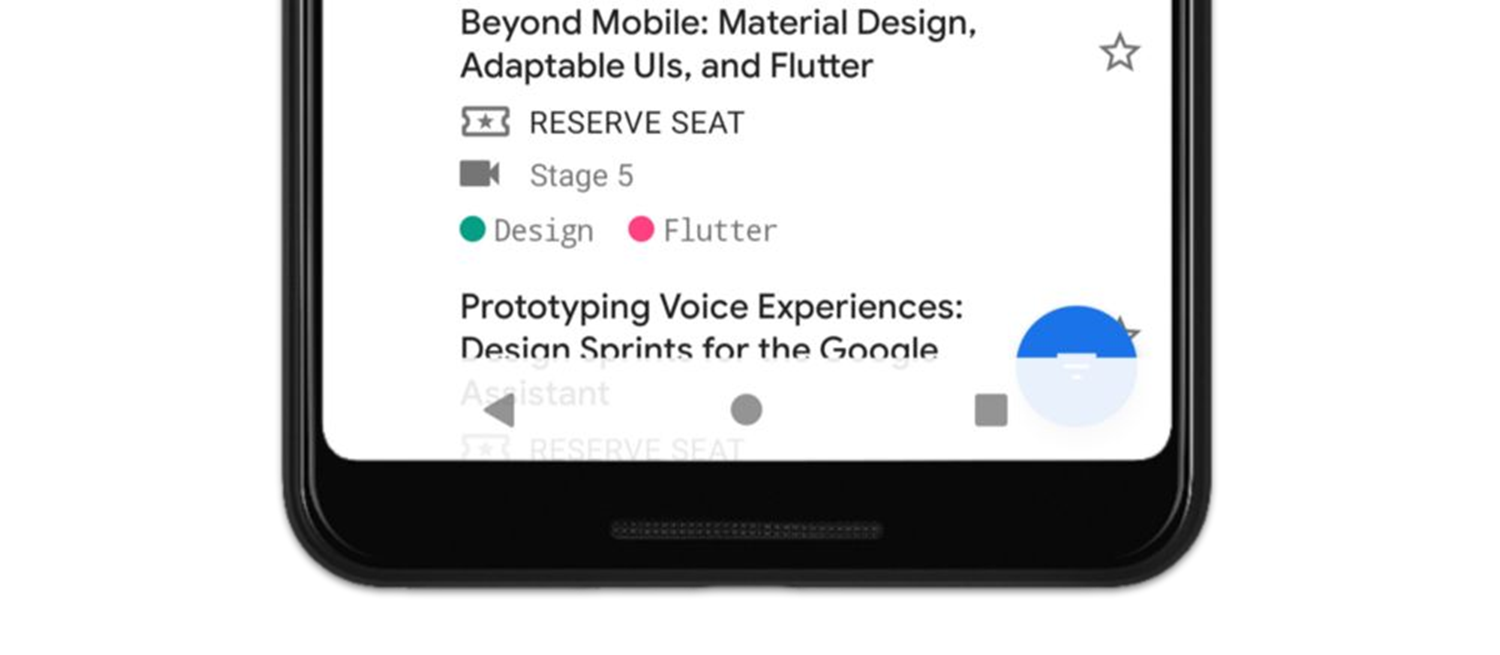

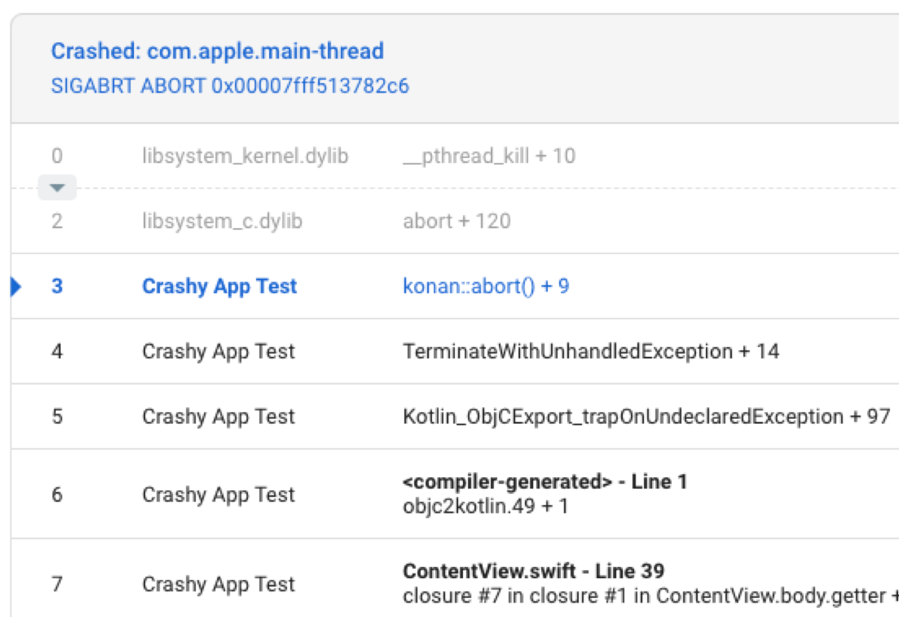

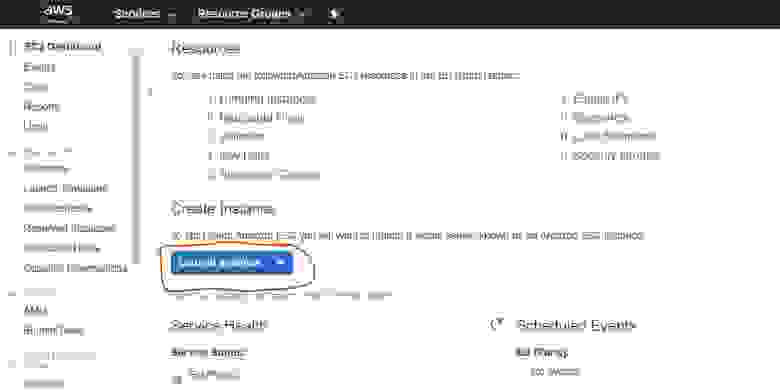

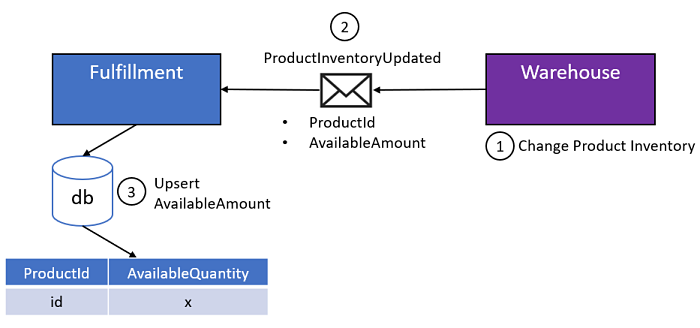

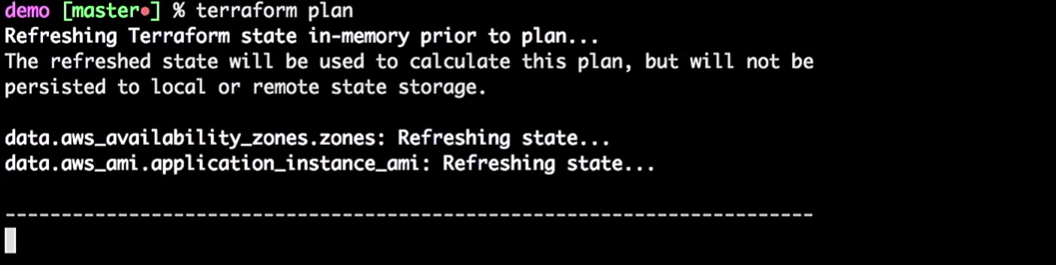

**Пример 3. Использование mock-объектов для тестирования.** А теперь нам нужно написать виджет-тесты. Если бы проект был чуть более сложным и включал например BLoC для управления состоянием, то эти модули тоже нужно было бы тестировать с помощью юнит-тестов. И здесь мы сразу встречаемся с невозможностью сделать это без дополнительного изменения кода, потому что при юнит-тестировании и виджет-тестировании SharedPreferences и Geolocator недоступны, да и предсказать, что ответит бэкенд невозможно. С GetIt тест написать просто - создаем mock-класс для настроек или для поставщика данных, моделируем ответы бэкенда, отображение которых будет легко проверить, через Mockito и можно быть уверенным в корректности работы приложения.

```

class MockProvider extends Mock implements WeatherProvider {}

void main() {

final repository = MockProvider();

setUpAll(() {

final service = GetIt.instance;

service.registerSingleton(repository);

});

testWidgets('отображение данных о погоде', (WidgetTester tester) async {

when(repository.loadPredictions(any, any)).thenAnswer((\_) async {

return {DateTime.now().hourStart: WeatherCondition(windDirection: WindDirection.north, temperature: 10.0, windSpeed: 3.0, windGust: 8.0)};

});

await tester.pumpWidget(const MaterialApp(

home: HomePage(),

));

await tester.pumpAndSettle();

final titleText = find.text('Current weather:');

expect(titleText, findsOneWidget);

final weather = find.text('Ветер: 3.0 N, порывами 8.0, температура: 10.0');

expect(weather, findsOneWidget);

});

}

```

В наших проектах в Россельхозбанке мы применяем GetIt в основном для тестирования и упрощения кода аналогично первому и третьему примеру. Бывают и ситуации, когда используются разные классы, реализующие одинаковый интерфейс, в зависимости от того, какой билд был создан. Например, для debug билда все логирование происходит в консоли, а для release билда используется другой класс логирования, который отправляет информацию о критических ошибках на бэкенд.

Подведу итоги. В применении библиотек для Dependency Injection есть неоспоримые преимущества:

* меньше параметров в классах,

* нет нужды менять код объекта, если зависимый класс поменял что-то в своей реализации или был заменен другим,

* возможность использования mock-объектов при тестировании. | https://habr.com/ru/post/564158/ | null | ru | null |

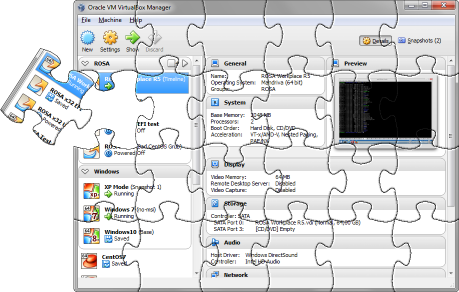

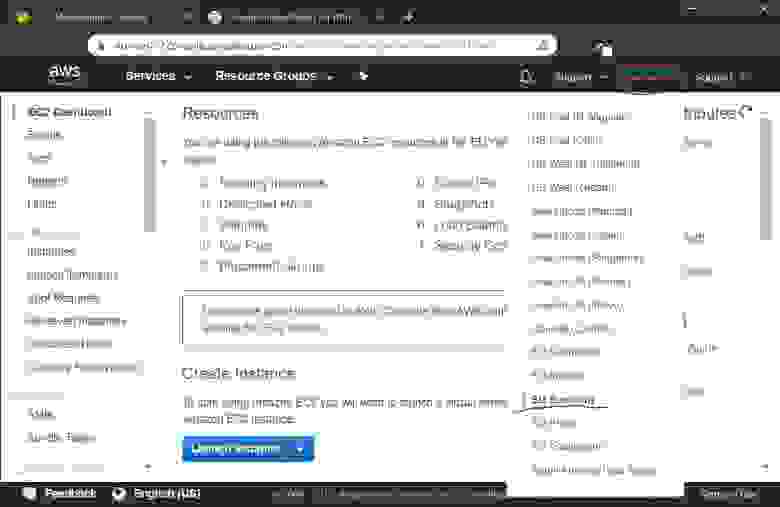

# Собираем VirtualBox под Windows

[](//habr.com/ru/post/357526/)

#### Введение

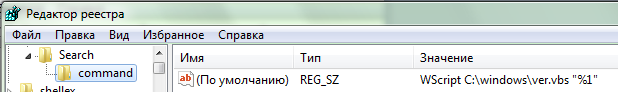

Как известно большинству пользователей Windows-версии VirtualBox (далее — *VB*, не путать с Visual Basic), в релизе 4.3.14 разработчики этой программы добавили дополнительный механизм защиты, называемый «hardening» (что можно перевести как «упрочнение»), который привёл к многочисленным проблемам совместимости VB с антивирусами, драйверами крипто-модулей и даже отдельными обновлениями самой Windows, в результате чего виртуальные машины попросту отказываются запускаться. В лучшем случае пользователю приходится ждать около месяца, пока проблемная программа, о которой он сообщит разработчикам, окажется учтена в следующем релизе VB. В худшем случае придётся либо удалять конфликтующую программу (или системное обновление), либо откатывать VB до версии 4.3.12 — последней, в которой не было этой защиты. Многочисленные предложения к разработчикам о добавлении пользовательского списка исключений или опции, отключающей защиту целиком, остаются без внимания. Единственный внятный ответ с их стороны звучит так: «не хотите защиту — компилируйте из исходников сами». Что ж, придётся этим заняться.

Несмотря на то, что процедура сборки [описана](https://www.virtualbox.org/wiki/Windows%20build%20instructions) на официальной вики, она неполна и кое в чём устарела, а сама сборка так и норовит выдать странные ошибки. Поэтому когда я всё-таки пробился до конца сей процедуры, я решил, что её описание заслуживает отдельной статьи. Инструкция время от времени обновляется и на текущий момент адаптирована для VB версии 6.1.18, но если кого-то заинтересует сборка более ранних версий VB или библиотек, информацию можно выцарапать из [истории правок](https://github.com/CaptainFlint/virtualbox-winbuild-article/).

#### Содержание

> » [Постановка задачи](#task)

>

> » [Пара предупреждений](#warnings)

>

> » [Готовим окружение](#environment)

>

> » [Особенности установки программ](#environment-inst)

>

> » [Последние штрихи](#final-touches)

>

> » [Собираем VirtualBox](#build-vb)

>

> » [Послесловие](#afterword)

>

> » [Дополнения](#history)

>

>

#### Постановка задачи

Изначально я планировал упростить себе задачу и обойтись минимальной пересборкой, чтобы устанавливать официальный дистрибутив и просто подменять в нём бинарные файлы. Однако оказалось, что такой подход не сработает, поскольку не учитывает использование системных механизмов установки и регистрации драйверов и COM-компонентов. Можно было бы попытаться разобраться в деталях и написать автоматизирующий скрипт, но я решил замахнуться на более крупную дичь: самостоятельно собрать полноценный дистрибутив, максимально близкий к официальному и отличающийся от него только отсутствием hardening'а.

Сразу скажу, что на 100% задачу решить не удалось. Слабым звеном оказались гостевые дополнения, которые в официальном пакете собраны под Windows (32- и 64-битную), OS/2, Linux и некоторые другие \*NIX-системы. В комментариях соответствующего Makefile указано, что сборка осуществляется удалённо на разных машинах, а настраивать такой комплект виртуалок мне не улыбалось. В итоге я решил собирать из исходных кодов всё, кроме дополнений, ISO-образ которых буду просто скачивать с сервера Oracle. Я пока не исследовал вопрос наличия hardening'а в дополнениях, но даже если он там есть, сообщений о вызванных им проблемах мне до сих пор не попадалось.

#### Пара предупреждений

##### • Проблемы безопасности

Про hardening известно, что добавили его не просто так, а для закрытия некой уязвимости VB. Подробно рассказать о сути уязвимости Oracle категорически отказывается, несмотря на то, что в официальных дистрибутивах проблема исправлена много лет назад. В общих чертах речь идёт о том, что системный механизм внедрения библиотек в чужие процессы в случае VB может приводить к неавторизованному повышению привилегий на хостовой машине, и что для этой уязвимости VB есть реально использующиеся эксплойты. Если это вас не пугает, можете продолжать чтение, но я вас предупредил.

##### • Подписывание драйверов

Как известно, начиная с Vista, 64-битная Windows в обычном режиме запрещает загрузку драйверов, не подписанных сертификатом с цепочкой доверия, ведущей до корневого сертификата Microsoft (а в Windows 10 при загрузке с включённым Secure Boot драйверы и вовсе должны быть подписаны непосредственно самой Microsoft). Поэтому прежде чем компилировать VB даже для личного использования, необходимо продумать решение этой проблемы: либо купить сертификат, либо попробовать найти сервисы, предоставляющие услугу подписывания драйверов для разработчиков open source (если они, конечно, согласятся подписать заведомо уязвимый драйвер), либо перевести свою Windows в тестовый режим и использовать самоподписанный тестовый сертификат.

Далее я буду ориентироваться на этот последний вариант, но в нужных местах укажу, как поменяется процедура при наличии полноценного сертификата.

##### • Прекращение поддержки 32-битных хостовых систем

Начиная с версии 6.0 в VirtualBox была официально прекращена поддержка 32-битных хостов (к гостевым системам это не относится), однако сама возможность работы в этих системах ещё оставалась. В версии 6.1 сделан следующий шаг, и 32-битная версия пакета окончательно удалена из инсталлятора (за исключением библиотеки программного интерфейса). Я в своей сборке применил аналогичные модификации, а из статьи удалил все ставшие неактуальными инструкции. Если вам нужна поддержка таких систем, вы можете попробовать самостоятельно собрать 32-битный вариант, воспользовавшись предыдущими версиями статьи из репозитория. Но нужно понимать, что чем дальше, тем больше проблем будет возникать, и не все из них можно будет решить самостоятельно. Разумным выходом будет либо оставаться на предыдущих версиях VirtualBox, либо перейти на 64-битную систему.

#### Готовим окружение

Официально в качестве сборочной системы рекомендуется Windows версии 8.1 или 10. Моя сборочная система построена на базе Windows 7 SP1 x64 ещё с тех времён, когда это была рекомендуемая версия, и проблем пока что не возникало. Если вы выделяете для сборки отдельную машину (реальную или виртуальную), имейте в виду, что ей необходим доступ в Интернет.

Для создания сборочного окружения потребуется немаленький набор программ. Если для программы присутствует портабельная версия, я использую её, а не инсталлятор.

Следующий набор программ поставляется только в виде инсталляторов (по крайней мере, официально). Для Visual Studio и SDK/WDK важно соблюдать порядок установки, как указано ниже. После установки крайне желательно установить обновления через Windows Update с включённой опцией поддержки всех продуктов Microsoft.

* **[Visual Studio 2010 Professional](https://my.visualstudio.com/Downloads?q=visual%20studio%202010%20professional)**

Для полноценной сборки требуется именно 2010, причём не ниже Professional. В версии 2010 Express нет библиотеки ATL, необходимой для сборки COM API, через который работают фронт-энды. Я сделал несколько попыток перенести проект на VS 2013 или 2015 Community Edition, чтобы избавиться от необходимости платной лицензии (которую к тому же сейчас крайне проблематично купить), но, увы, безуспешно.

* **[Windows SDK v7.1](https://www.microsoft.com/en-us/download/details.aspx?id=8279)**

* **[Visual Studio 2010 SP1](https://my.visualstudio.com/Downloads?q=visual%20studio%202010%20service%20pack%201)**

* **[Visual C++ 2010 SP1 Compiler Update for SDK 7.1](https://www.microsoft.com/en-us/download/details.aspx?id=4422)**

* **[Windows Driver Development Kit (WDK) v7.1](https://www.microsoft.com/en-us/download/details.aspx?displaylang=en&id=11800)**

* **[Windows SDK v8.1](https://go.microsoft.com/fwlink/p/?LinkId=323507)**

* **[ActivePerl](https://www.activestate.com/products/activeperl/downloads/)**

* **[ActivePython 2.7](https://www.activestate.com/products/activepython/downloads/)**

* **[Cygwin](https://cygwin.com/install.html)**

Остальные программы скачиваются в виде архивов или исходных кодов:

* **[Qt 5.6.3](https://download.qt.io/new_archive/qt/5.6/5.6.3/single/qt-everywhere-opensource-src-5.6.3.zip)** (исходные коды)

* **[MinGW-w64 4.5.4 x86\_64](https://sourceforge.net/projects/mingw-w64/files/Toolchains%20targetting%20Win64/Personal%20Builds/rubenvb/gcc-4.5-release/x86_64-w64-mingw32-gcc-4.5.4-release-win64_rubenvb.7z/download)**

* **[SDL v1.2.x](http://www.libsdl.org/download-1.2.php)** (development-пакет для Visual C++)

* **[cURL](https://curl.haxx.se/download.html)** (исходные коды)

* **[OpenSSL 1.1.1](https://www.openssl.org/source/)** (исходные коды)

* **[gSOAP 2.8.x](https://sourceforge.net/projects/gsoap2/files/gsoap-2.8/)** (рекомендуется 2.8.41 или выше)

* **[libvpx 1.7.0](https://github.com/webmproject/libvpx/releases)** (исходные коды; более новые версии не поддерживают VS 2010)

* **[libopus 1.3.1](http://opus-codec.org/downloads/)** (исходные коды)

* **[MiKTeX Portable](https://miktex.org/download)**

* **[NASM](https://www.nasm.us/)**

Рекомендую 64-битную портативную версию.

* **[WiX](http://wixtoolset.org/)**

Рекомендую портативный набор (архив с именем вида `wix311-binaries.zip`).

Также потребуются два архива:

* **[DocBook XML DTD 4.5](http://www.oasis-open.org/docbook/xml/4.5/docbook-xml-4.5.zip)**

* **[DocBook XSL Stylesheets 1.69.1](https://sourceforge.net/projects/docbook/files/OldFiles/docbook-xsl-1.69.1.zip/download)**

**Зачем оно всё?**

Если вы не планируете собирать такой же пакет, как я, то некоторые из перечисленных инструментов могут вам не потребоваться. Здесь я вкратце перечислю, какую роль они выполняют.

* **SDK 8.1**

Для сборки будет использоваться SDK версии 7.1, версия 8.1 требуется только для утилиты SignTool: в 7.1 отсутствует поддержка двойного подписывания SHA-1/SHA-256. Если у вас есть компьютер с установленным SDK версии 8.1 или более поздней, можно просто скопировать утилиту `signtool.exe` оттуда (со всеми зависимостями) и указать соответствующий путь в файле `LocalConfig.kmk` (см. [ниже](#final-touches-localconfig)).

* **WiX**

Это инструмент для создания MSI-инсталляторов. Хоть финальный вариант инсталлятора и является EXE-файлом, внутри он содержит MSI, так что WiX тут необходим. Если вам достаточно простой компиляции бинарников, то этот пакет не понадобится.

* **SDL**

На этой библиотеке основан фронт-энд `VBoxSDL.exe` — минималистичная альтернатива стандартной оболочке `VirtualBoxVM.exe`. Если вам не требуется VBoxSDL, то, может быть, удастся обойтись без библиотеки SDL, но я это не проверял.

* **gSOAP**

Этот компонент необходим для сборки сервиса удалённого управления VB: `VBoxWebSrv.exe`. Отсутствие gSOAP не является критической ошибкой, VB успешно соберётся без этого сервиса.

* **libvpx**, **libopus**

Видео- и аудиокодек, использующиеся для записи видео с экрана виртуальной машины. При их отсутствии VirtualBox собирается и работает корректно, а функция записи просто игнорируется (хотя и показывает анимацию, будто запись выполняется).

* **Cygwin**

Требуется для сборки libvpx.

* **MiKTeX**

При помощи MiKTeX компилируется справочник в формате PDF (`doc\UserManual.pdf`). Отсутствие MiKTeX не является критической ошибкой, VB успешно соберётся без PDF-документации.

* **NASM**

Этот ассемблер будет использоваться для сборки OpenSSL. Поддерживается и сборка без внешнего ассемблера, но с ним будет создан более оптимальный код.

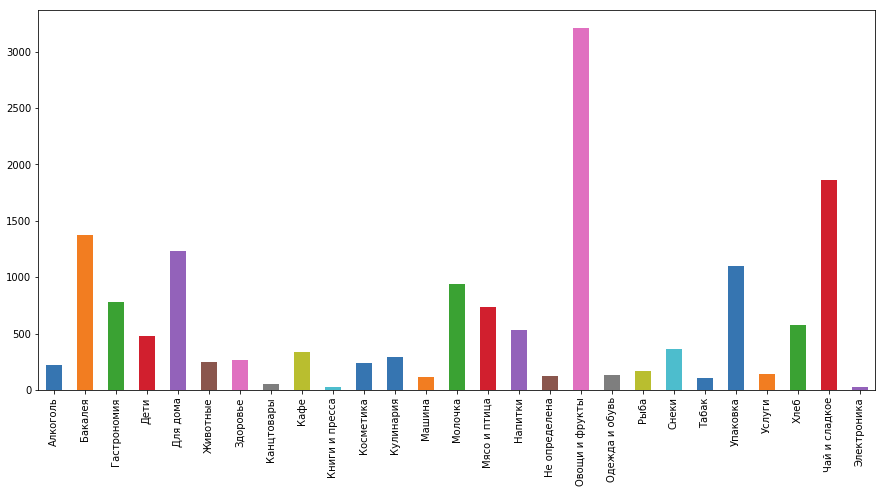

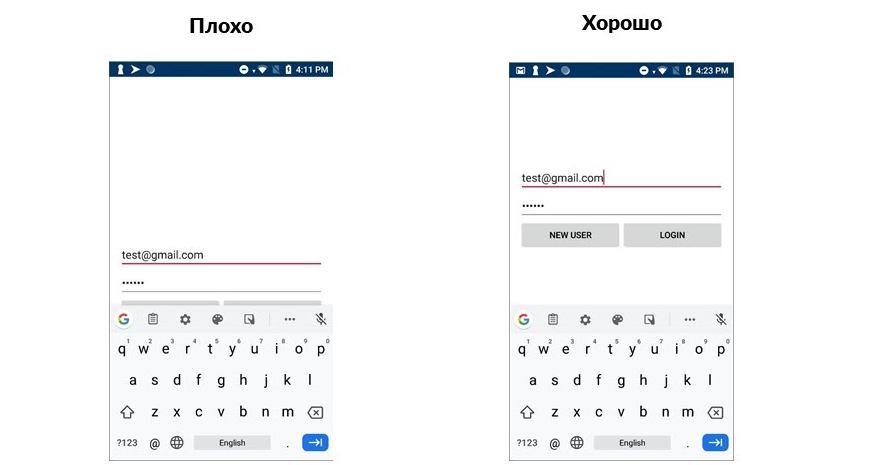

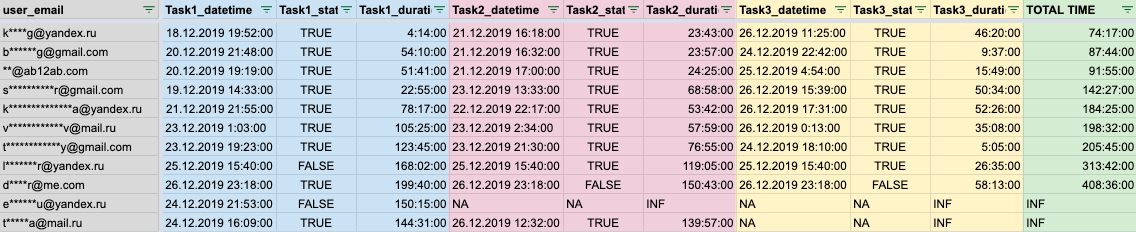

Чтобы легче было отслеживать потенциальные источники проблем сборки, привожу здесь сводную таблицу всех инструментов с их версиями и путями установки в созданном мной окружении. Обозначение «`{x32|x64}`» указывает, что пакет устанавливается в два разных каталога для 32- и 64-битной версии.

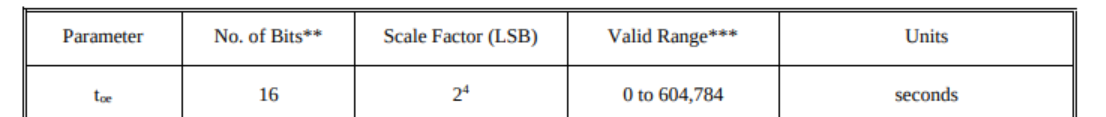

| Программа | Версия | Путь установки |

| --- | --- | --- |

| Visual Studio | 2010 Professional | `C:\Program Files (x86)\Microsoft Visual Studio 10.0\` |

| SDK | 7.1 | `C:\Program Files\Microsoft SDKs\Windows\v7.1\` |

| SDK | 8.1 | `C:\Programs\DevKits\8.1\` |

| WDK | 7.1.0 | `C:\WinDDK\7600.16385.1\` |

| ActivePerl | 5.26.1 Build 2601 x64 | `C:\Programs\Perl\` |

| ActivePython | 2.7.14.2717 x64 | `C:\Programs\Python\` |

| WiX | 3.11.1.2318 | `C:\Programs\WiX\` |

| Qt | 5.6.3 | `C:\Programs\Qt\5.6.3-x64\` |

| MinGW-64 | 4.5.4 | `C:\Programs\mingw64\` |

| Cygwin | - | `C:\Programs\cygwin64\` |

| SDL | 1.2.15 | `C:\Programs\SDL\x64\` |

| cURL | 7.74.0 | `C:\Programs\curl\{x32|x64}\` |

| OpenSSL | 1.1.1i | `C:\Programs\OpenSSL\{x32|x64}\` |

| gSOAP | 2.8.110 | `C:\Programs\gSOAP\` |

| libvpx | 1.7.0 | `C:\Programs\libvpx\` |

| libopus | 1.3.1 | `C:\Programs\libopus\` |

| MiKTeX Portable | 2.9.6942 | `C:\Programs\MiKTeX\` |

| NASM | 2.14.02 x64 | `C:\Programs\nasm\` |

| DocBook XML DTD | 4.5 | `C:\Programs\DocBook\xml\` |

| DocBook XSL Stylesheets | 1.69.1 | `C:\Programs\DocBook\xsl\` |

#### Особенности установки программ

В этом разделе я привожу указания или инструкции для отдельных пакетов, где процедура неочевидна или требует дополнительных шагов.

##### • Windows SDK v7.1

При установке могут возникнуть проблемы из-за устаревших версий компиляторов и рантайма: они не могут установиться поверх более новых версий, установленных с VS 2010, и инсталлятор считает это критической ошибкой. Необходимо либо отключить соответствующие галочки, либо предварительно удалить из системы пакеты с именами вида *«Microsoft Visual C++ 2010 Redistributable»*, *«Microsoft Visual C++ 2010 Runtime»*, *«Microsoft Visual C++ Compilers…»* (SDK установит старые версии пакетов, а Windows Update потом обновит их до актуальных).

Также обратите внимание, что для финальной сборки MSI-пакетов потребуется установить примеры программ (Windows Native Code Development -> Samples): в их составе идут скрипты, использующиеся сборочными правилами.

##### • Windows SDK v8.1

Достаточно установить только средства разработки (Windows Software Development Kit).

##### • WDK v7.1

Достаточно установить только сборочные окружения (Build Environments).

##### • Qt 5.6.3

Начиная с версии Qt 5.7.0 прекращена поддержка сборки в MSVC версий ниже 2012, поэтому используем 5.6.x.

Для Visual Studio 2010 официальные сборки отсутствуют, поэтому необходимо сначала собрать библиотеку из исходных кодов.

1. Распаковываем архив с исходным кодом Qt в каталог `C:\Programs\Qt\` и переименовываем полученный подкаталог `qt-everywhere-opensource-src-5.6.3` в `5.6.3-src`.

2. Рядом создаём каталог `build-x64`, в котором будет происходить сборка.

3. Открываем консоль, выполняем следующие команды для подготовки окружения:

```

md C:\Programs\Qt\build-x64

cd /d C:\Programs\Qt\build-x64

SET QTVER=5.6.3

"C:\Program Files\Microsoft SDKs\Windows\v7.1\Bin\SetEnv.Cmd" /Release /x64 /win7

COLOR 07

SET QTDIR=C:\Programs\Qt\%QTVER%-x64

SET PATH=%QTDIR%\bin;%PATH%

SET QMAKESPEC=win32-msvc2010

```

Команда `color` отключает зелёный цвет шрифта, устанавливаемый скриптом `SetEnv.Cmd`.

4. Теперь запускаем `configure.bat` из каталога `5.6.3-src`. Поскольку бо́льшая часть Qt в VB не используется, можно сильно ускорить сборку, отключив ненужные компоненты, но необходимо учитывать, что к некоторым опциям VB относится очень щепетильно. В частности, я наткнулся на следующее:

* OpenGL ES 2 не поддерживается (компиляция VB не может увидеть некоторые заголовочные файлы).

* Поддержка FreeType должна быть включена (без неё не соберётся плагин `qoffscreen`, использующийся в VB).Вот итоговая команда, которую я использовал у себя:

```

..\5.6.3-src\configure.bat -prefix c:\Programs\Qt\5.6.3-x64 -mp -opensource -confirm-license -nomake tests -nomake examples -no-compile-examples -release -shared -pch -no-ltcg -accessibility -no-sql-sqlite -opengl desktop -no-openvg -no-nis -no-iconv -no-evdev -no-mtdev -no-inotify -no-eventfd -largefile -no-system-proxies -qt-zlib -qt-pcre -no-icu -qt-libpng -qt-libjpeg -qt-freetype -no-fontconfig -qt-harfbuzz -no-angle -incredibuild-xge -no-plugin-manifests -qmake -qreal double -rtti -strip -no-ssl -no-openssl -no-libproxy -no-dbus -no-audio-backend -no-wmf-backend -no-qml-debug -no-direct2d -directwrite -no-style-fusion -native-gestures -skip qt3d -skip qtactiveqt -skip qtandroidextras -skip qtcanvas3d -skip qtconnectivity -skip qtdeclarative -skip qtdoc -skip qtenginio -skip qtgraphicaleffects -skip qtlocation -skip qtmacextras -skip qtmultimedia -skip qtquickcontrols -skip qtquickcontrols2 -skip qtscript -skip qtsensors -skip qtserialbus -skip qtserialport -skip qtwayland -skip qtwebchannel -skip qtwebengine -skip qtwebsockets -skip qtwebview -skip qtx11extras -skip qtxmlpatterns

```

5. Указанный каталог установки (опция `-prefix`) Qt записывает внутрь генерируемых промежуточных файлов исходного кода при конфигурировании, так что собранная библиотека будет помнить этот путь. Это приводит к тому, что при запуске Qt-приложение по умолчанию будет искать плагины по этому пути, и только если ничего не нашлось, обратится к собственному каталогу. В большинстве ситуаций это работает корректно, но если вдруг на целевой машине в каталоге `c:\Programs\Qt\5.6.3-x64` окажется отличающаяся сборка Qt (с другими флагами), то VB при запуске свалится с ошибкой.

Избежать этого можно двумя путями: либо добавить в каталог VB файл `qt.conf` с содержимым:

```

[Paths]

Plugins=.

```

либо подправить сохранённый в Qt путь установки, чтобы он по умолчанию указывал на каталог программы. Я пошёл по второму пути, чтобы итоговая установка VB выглядела более аккуратной. Для этого нужно открыть файл `C:\Programs\Qt\build-x64\qtbase\src\corelib\global\qconfig.cpp`, который создался конфигуратором, найти там строчку вида:

```

static const char qt_configure_prefix_path_str [512 + 12] = "qt_prfxpath=c:/Programs/Qt/5.6.3-x64";

```

и заменить там весь путь на точку, чтобы получилось следующее:

```

static const char qt_configure_prefix_path_str [512 + 12] = "qt_prfxpath=.";

```

Установка Qt при этом по-прежнему будет выполнена в указанный ранее каталог, потому что он уже сохранён в Makefile-ах. Это изменение затронет только поведение Qt-программ при их запуске.

6. Далее запускаем сборку командой `nmake`

7. Устанавливаем скомпилированную библиотеку командой `nmake install`

После завершения установки каталоги `build-x64` и `5.6.3-src` можно удалять.

##### • MinGW

Архив просто распаковывается в выбранный каталог установки.

##### • Cygwin

При установке необходимо отметить пакеты `make` и `yasm`.

##### • SDL

1. Распаковываем SDL в каталог `C:\Programs\SDL\x64\`.

2. Перемещаем всё содержимое `C:\Programs\SDL\x64\lib\x64\` на уровень выше (в `C:\Programs\SDL\x64\lib\`), каталоги `C:\Programs\SDL\x64\lib\x86` и `x64` удаляем.

##### • NASM

Распаковываем архив `nasm-2.14.02-win64.zip` в `C:\Programs\`, переименовываем полученный каталог `nasm-2.14.02` в `nasm`.

##### • OpenSSL

1. Для этой библиотеки нам по-прежнему нужны сборки под 32- и 64-битную архитектуру. Распаковываем архив OpenSSL два раза в каталог `C:\Programs\OpenSSL\`, переименовывая полученный подкаталог из `openssl-1.1.1i`, соответственно, в `openssl-1.1.1i-x32` и `openssl-1.1.1i-x64`.

2. Открываем консоль, собираем и устанавливаем 32-битную версию:

```

"C:\Program Files\Microsoft SDKs\Windows\v7.1\Bin\SetEnv.Cmd" /Release /x86 /win7

COLOR 07

set PATH=%PATH%;C:\Programs\nasm

cd /d C:\Programs\OpenSSL\openssl-1.1.1i-x32\

perl Configure VC-WIN32 no-shared --prefix=C:\Programs\OpenSSL\x32 --openssldir=C:\Programs\OpenSSL\x32\ssl

nmake

nmake test

nmake install

```

Конфигуратор может выдать страшное сообщение, что, дескать, не может найти компилятор. Не обращайте внимания, это он слегка не в себе.

Если вы не хотите использовать NASM, исключите отсюда модификацию переменной `PATH` и добавьте к вызову `Configure` параметр `no-asm`.

3. Открываем новую консоль, собираем и устанавливаем 64-битную версию:

```

"C:\Program Files\Microsoft SDKs\Windows\v7.1\Bin\SetEnv.Cmd" /Release /x64 /win7

COLOR 07

set PATH=%PATH%;C:\Programs\nasm

cd /d C:\Programs\OpenSSL\openssl-1.1.1i-x64\

perl Configure VC-WIN64A no-shared --prefix=C:\Programs\OpenSSL\x64 --openssldir=C:\Programs\OpenSSL\x64\ssl

nmake

nmake test

nmake install

```

Отказ от NASM делается аналогично 32-битной версии.

4. Каталоги `C:\Programs\OpenSSL\openssl-1.1.1i-x32` и `openssl-1.1.1i-x64` можно удалять.

##### • cURL

1. Как и с OpenSSL, здесь нам потребуется не только 64-битный, но и 32-битный вариант. Распаковываем архив cURL в каталог `C:\Programs\curl\`, переименовываем получившийся подкаталог из `curl-7.74.0` в `curl-7.74.0-x32`.

2. Открываем в редакторе файл `C:\Programs\curl\curl-7.74.0-x32\winbuild\MakefileBuild.vc`, находим там в районе строк 61–69 условный блок вида:

```

!IF "$(VC)"=="6"

CC_NODEBUG = $(CC) /O2 /DNDEBUG

CC_DEBUG = $(CC) /Od /Gm /Zi /D_DEBUG /GZ

CFLAGS = /I. /I../lib /I../include /nologo /W4 /wd4127 /GX /DWIN32 /YX /FD /c /DBUILDING_LIBCURL

!ELSE

CC_NODEBUG = $(CC) /O2 /DNDEBUG

CC_DEBUG = $(CC) /Od /D_DEBUG /RTC1 /Z7 /LDd

CFLAGS = /I. /I ../lib /I../include /nologo /W4 /wd4127 /EHsc /DWIN32 /FD /c /DBUILDING_LIBCURL

!ENDIF

```

и добавляем после него строчку:

```

CFLAGS = $(CFLAGS) /DCURL_DISABLE_LDAP

```

Если этого не сделать, то при сборке VB полезут ошибки линковки.

3. Открываем файл `C:\Programs\curl\curl-7.74.0-x32\winbuild\gen_resp_file.bat`, после первой строчки в нём (`@echo OFF`) вставляем команду:

```

cd .

```

Это фиктивная команда, которая ничего не делает, и задача её лишь в том, чтобы сбросить код `ERRORLEVEL`. В противном случае может возникнуть ситуация, когда этот код оказывается ненулевым ещё до запуска батника, а сам батник не выполняет ни одной команды, меняющей код возврата. В результате `nmake` считает, что батник вернул ошибку, и прерывает сборку.

4. Делаем копию каталога `curl-7.74.0-x32` под именем `curl-7.74.0-x64`.

5. Открываем консоль, собираем 32-битную версию и копируем необходимые файлы в целевой каталог:

```

"C:\Program Files\Microsoft SDKs\Windows\v7.1\Bin\SetEnv.Cmd" /Release /x86 /win7

COLOR 07

cd /d C:\Programs\curl\curl-7.74.0-x32\winbuild

md C:\Programs\curl\x32

nmake /f Makefile.vc mode=static WITH_SSL=static DEBUG=no MACHINE=x86 SSL_PATH=C:\Programs\OpenSSL\x32 ENABLE_SSPI=no ENABLE_WINSSL=no ENABLE_IDN=no

copy ..\builds\libcurl-vc-x86-release-static-ssl-static-ipv6\lib\libcurl_a.lib ..\..\x32\libcurl.lib

xcopy /E ..\builds\libcurl-vc-x86-release-static-ssl-static-ipv6\include\curl ..\..\x32\include\curl\

```

6. Собираем 64-битную версию, открыв новую консоль и выполнив команды:

```

"C:\Program Files\Microsoft SDKs\Windows\v7.1\Bin\SetEnv.Cmd" /Release /x64 /win7

COLOR 07

cd /d C:\Programs\curl\curl-7.74.0-x64\winbuild

md C:\Programs\curl\x64

nmake /f Makefile.vc mode=static WITH_SSL=static DEBUG=no MACHINE=x64 SSL_PATH=C:\Programs\OpenSSL\x64 ENABLE_SSPI=no ENABLE_WINSSL=no ENABLE_IDN=no

copy ..\builds\libcurl-vc-x64-release-static-ssl-static-ipv6\lib\libcurl_a.lib ..\..\x64\libcurl.lib

xcopy /E ..\builds\libcurl-vc-x64-release-static-ssl-static-ipv6\include\curl ..\..\x64\include\curl\

copy ..\builds\libcurl-vc-x64-release-static-ssl-static-ipv6\bin\curl.exe ..\..\x64\curl.exe

```

Обратите внимание, что, в отличие от 32-битной версии, здесь мы копируем ещё и `curl.exe`, он нам потом понадобится для скачивания образа гостевых дополнений.

7. Каталоги `C:\Programs\curl\curl-7.74.0-x32` и `curl-7.74.0-x64` можно удалять.

##### • libvpx

1. Распаковываем архив libvpx в каталог `C:\Programs\libvpx-build\`.

2. Запускаем Cygwin, в нём будем выполнять конфигурирование, сборку и установку библиотеки. В качестве целевой платформы будет указана Visual Studio 2010. При этом сборочная система попытается автоматически запустить сборку, но будет делать это с использованием `msbuild.exe`, который мне не удалось заставить работать корректно в имеющемся окружении. Вместо этого оказалось проще запустить отдельным шагом сборку самой Студией, благо она позволяет работать из командной строки. Впрочем, можно этот шаг выполнить и при помощи графической среды, если кому-то она привычнее, но в этом случае вам придётся к переменной `PATH` добавить путь `C:\Programs\cygwin64\bin` (или как-то иначе задать его в проекте), потому что там располагается ассемблер `yasm.exe`, необходимый для сборки. Итак, в терминале Cygwin выполняем следующие команды:

```

mkdir -p /cygdrive/c/Programs/libvpx-build/build64

cd /cygdrive/c/Programs/libvpx-build/build64

../libvpx-1.7.0/configure --target=x86_64-win64-vs10 --disable-install-bins --disable-examples --disable-tools --disable-docs --prefix=../../libvpx

make

"/cygdrive/c/Program Files (x86)/Microsoft Visual Studio 10.0/Common7/IDE/devenv.com" vpx.sln /Project vpx.vcxproj /Rebuild "Release|x64"

make install

```

3. Закрываем терминал Cygwin, больше он нам не понадобится. Каталог `C:\Programs\libvpx-build` можно удалять.

##### • libopus

1. Распаковываем архив opus в каталог `C:\Programs\libopus-build\`, переходим в подкаталог `opus-1.3.1\win32\VS2015`.

2. Проект рассчитан на более новую версию Visual Studio, и в 2010-й просто так не соберётся, надо внести немножко правок. Можно это сделать как через IDE, так в обычном текстовом редакторе. Я предпочёл второй путь. Итак, открываем в редакторе файл `opus.vcxproj` (остальные проекты нам не нужны) и проделываем следующие манипуляции:

1. Находим все строки с текстом

```

v140

```

и меняем версию с `v140` на `v100`. Если вы работаете в IDE, то эта опция в настройках проекта располагается на странице Configuration Properties -> General и называется «Platrofm Toolset». Не забудьте выбрать конфигурации и архитектуры в выпадающих списках в верхней части диалога.

2. Далее находим блок:

```

```

и добавляем туда тег:

```

ProgramDatabase

```

В настройках проекта Visual Studio это делается на странице Configuration Properties -> C/C++ -> General выставлением опции «Debug Information Format» в «ProgramDatabase (/Zi)». Собственно говоря, подойдёт и любое другое валидное значение из списка, база отладочной информации нас не интересует, просто при невалидном значении проект отказывается собираться.

3. Теперь собираем Release-конфигурацию для обеих архитектур (из оболочки VS или из командной строки) и копируем собранную библиотеку `opus.lib` и подкаталог `include\` в целевой каталог установки:

```

cd /d C:\Programs\libopus-build\opus-1.3.1\win32\VS2015

md C:\Programs\libopus\lib\x64

xcopy /E C:\Programs\libopus-build\opus-1.3.1\include C:\Programs\libopus\include\

"C:\Program Files (x86)\Microsoft Visual Studio 10.0\Common7\IDE\devenv.com" opus.sln /Project opus.vcxproj /Rebuild "Release|x64"

copy x64\Release\opus.lib C:\Programs\libopus\lib\x64\

```

4. Каталог `C:\Programs\libopus-build` можно удалять.

##### • gSOAP

Открываем архив, заходим в подкаталог `gsoap-2.8\gsoap` и распаковываем содержимое этого подкаталога в `C:\Programs\gSOAP\`. Для корректной сборки с OpenSSL 1.1.x требуется версия 2.8.41 или выше. Для более ранних версий потребуется наложить специальный [патч](https://github.com/CaptainFlint/virtualbox-winbuild-article/blob/master/misc/gsoap-openssl110.patch) (автор: [Mattias Ellert](https://sourceforge.net/p/gsoap2/patches/166/)). Можно это сделать вручную (формат достаточно очевидный: открываем поочерёдно указанные файлы, удаляем строчки, отмеченные минусами, и добавляем отмеченные плюсами; остальные строки помогают определить контекст), а можно взять стандартную утилиту `patch`, портированную для Windows, и натравить её.

##### • MiKTeX

1. Распаковываем архив в `C:\Programs\MiKTeX\`.

2. Открываем консоль и запускаем установку дополнительных модулей:

```

"C:\Programs\MiKTeX\texmfs\install\miktex\bin\mpm.exe" --verbose --install=koma-script --install=ucs --install=tabulary --install=url --install=fancybox --install=fancyvrb --install=bera --install=charter --install=mptopdf

```

##### • DocBook

Для распаковки архива XML DTD нужно создать отдельный каталог и поместить туда все файлы. Архив с XSL Stylesheets уже содержит нужный подкаталог, поэтому достаточно его просто распаковать и переименовать полученный подкаталог.

#### Последние штрихи

Подготовка к сборке почти завершена, остались несколько шагов. Если вы этого ещё не сделали, нужно скачать архив с исходными кодами VirtualBox нужной версии и распаковать его в удобное место. В качестве рабочего каталога я выбрал `C:\Devel\`; в него я распаковал архив исходных кодов и переименовал полученный каталог в `VirtualBox-src`.

##### • Добавление сертификатов

Если у вас нет полноценного сертификата, то рекомендуется создать хотя бы персональный (с ним проще загружать драйверы, чем совсем без подписи). Для этого нужно открыть консоль с повышенными привилегиями и выполнить в ней следующие команды, которые создадут и добавят в личное хранилище два сертификата (SHA-1 и SHA-256):

```

"C:\Program Files\Microsoft SDKs\Windows\v7.1\Bin\SetEnv.Cmd" /Release /x64 /win7

COLOR 07

makecert.exe -a sha1 -r -pe -ss my -n "CN=Roga and Kopyta Ltd" C:\Devel\testcert_1.cer

makecert.exe -a sha256 -r -pe -ss my -n "CN=Roga and Kopyta Ltd" C:\Devel\testcert_256.cer

certmgr.exe -add C:\Devel\testcert_1.cer -s -r localMachine root

certmgr.exe -add C:\Devel\testcert_256.cer -s -r localMachine root

```

Имя для сертификатов («Roga and Kopyta Ltd») и путь к файлам можно выбирать по своему усмотрению. Также нам потребуются цифровые отпечатки сгенерированных сертификатов. Откройте консоль управления сертификатами (запустите `certmgr.msc`), откройте там список персональных сертификатов. Дважды щёлкните на первом из сертификатов «Roga and Kopyta Ltd», в открывшемся диалоге перейдите на вкладку *Состав*. В поле «Алгоритм подписи» будет указано sha256RSA или sha1RSA. Далее, в самом конце списка будет поле «Отпечаток» со значением в виде последовательности шестнадцатеричных чисел. Скопируйте это значение куда-нибудь. То же самое повторите для второго из сертификатов. Не забудьте отметить, какой из них был SHA-256, а какой — SHA-1.

##### • Сборка xmllint

На одном из этапов потребуется также программа `xmllint`. Я не указывал её в списке требований, потому что необходимые исходники уже присутствуют в архиве VB. Сборочные правила не рассчитаны на автоматическую сборку этой утилиты, поэтому придётся сделать это самостоятельно. В качестве целевого каталога я выбрал `C:\Programs\xmllint`.1. Копируем каталог `C:\Devel\VirtualBox-src\src\libs\libxml2-2.9.4` в `C:\Programs\` (это необходимо, чтобы промежуточные объектные файлы не мешали сборке самого VB).

2. Открываем консоль и выполняем команды:

```

"C:\Program Files\Microsoft SDKs\Windows\v7.1\Bin\SetEnv.Cmd" /Release /x64 /win7

COLOR 07

cd /d C:\Programs\libxml2-2.9.4\win32

cscript.exe configure.js cruntime=/MT prefix=C:\Programs\xmllint iconv=no

nmake /f Makefile.msvc

nmake /f Makefile.msvc install

```

3. Удаляем каталог `C:\Programs\libxml2-2.9.4`.

##### • Различные правки VB

Прежде чем приступать к сборке, нам ещё потребуется внести кое-какие правки в исходные коды самого VirtualBox. Полный набор всех изменений выложен мной в виде отдельного патча, который можно просто наложить целиком на дерево VB (вручную или используя утилиту `patch`, которую потребуется скачать отдельно):

» [**vbox\_build.patch**](https://github.com/CaptainFlint/virtualbox-winbuild-article/blob/master/misc/vbox_build.patch)

Если всё наложилось корректно, то можно переходить к [следующему пункту](#final-touches-localconfig). Если же что-то не состыковалось и требуется разобраться с конкретным изменением, или просто вас интересуют подробности, какие именно правки были внесены и зачем, читайте далее. Имейте в виду, что описания здесь могут идти в не в том порядке, как в патче. Пути к файлам указаны относительно каталога с исходниками VB, `C:\Devel\VirtualBox-src`.1. Файл `configure.vbs`:

* Строка кода:

```

if Shell(DosSlashes(strPathVC & "/bin/cl.exe"), True) <> 0 then

```

заменяется на:

```

if Shell(DosSlashes(strPathVC & "/bin/cl.exe") & " /?", True) <> 0 then

```

Этот код отвечает за поиск и проверку компилятора, но не учитывает, что вызов `cl.exe` без аргументов возвращает ошибку (что трактуется как неподходящий компилятор). Добавление параметра «`/?`» запрашивает вывод справки, и код возврата перестаёт быть ошибочным.

* Теперь переходим к функции `CheckForCurlSub` и находим в ней следующий код:

```

if LogFileExists(strPathCurl, "include/curl/curl.h") _

And LogFindFile(strPathCurl, "libcurl.dll") <> "" _

And LogFindFile(strPathCurl, "libcurl.lib") <> "" _

```

Этот код выполняет поиск и проверку пути к libcurl, но он рассчитан только на использование динамически линкуемой версии библиотеки и, если не находит соответствующий DLL-файл, ругается некультурными словами. Поскольку мы собираем со статической версией, эту проверку надо поправить, удалив строчку с `libcurl.dll`, чтобы получилось:

```

if LogFileExists(strPathCurl, "include/curl/curl.h") _

And LogFindFile(strPathCurl, "libcurl.lib") <> "" _

```

* Следующая функция — `CheckForPython`, там есть генерация переменной `VBOX_BLD_PYTHON`:

```

CfgPrint "VBOX_BLD_PYTHON := " & strPathPython & "\python.exe"

```

Здесь нужно обратный слэш перед `python.exe` заменить на прямой: `"/python.exe"` (иначе некоторые проверки падают; вроде бы, для сборки это некритично, но выглядит неаккуратно).

* В Windows-версии конфигуратор не поддерживает libvpx и libopus, я добавляю их поддержку самостоятельно. Можно было, конечно, просто прохардкодить пути установки библиотек, но я предпочёл, чтобы конфигуратор проверял корректность установки и принимал путь через аргументы командной строки, как уже сделано для остальных компонентов. Поэтому я реализовал две проверочные функции, выглядящие следующим образом:

```

''

' Checks for libvpx

sub CheckForVpx(strOptVpx)

dim strPathVpx, str

strVpx = "libvpx"

PrintHdr strVpx

if strOptVpx = "" then

MsgError "Invalid path specified!"

exit sub

end if

if g_strTargetArch = "amd64" then

strVsBuildArch = "x64"

else

strVsBuildArch = "Win32"

end if

strLibPathVpx = "lib/" & strVsBuildArch & "/vpxmd.lib"

strPathVpx = ""

if LogFileExists(strOptVpx, "include/vpx/vpx_encoder.h") _

And LogFileExists(strOptVpx, strLibPathVpx) _

then

strPathVpx = UnixSlashes(PathAbs(strOptVpx))

CfgPrint "SDK_VBOX_VPX_INCS := " & strPathVpx & "/include"

CfgPrint "SDK_VBOX_VPX_LIBS := " & strPathVpx & "/" & strLibPathVpx

else

MsgError "Can't locate " & strVpx & ". " _

& "Please consult the configure.log and the build requirements."

exit sub

end if

PrintResult strVpx, strPathVpx

end sub

''

' Checks for libopus

sub CheckForOpus(strOptOpus)

dim strPathOpus, str

strOpus = "libopus"

PrintHdr strOpus

if strOptOpus = "" then

MsgError "Invalid path specified!"

exit sub

end if

if g_strTargetArch = "amd64" then

strVsBuildArch = "x64"

else

strVsBuildArch = "Win32"

end if

strLibPathOpus = "lib/" & strVsBuildArch & "/opus.lib"

strPathOpus = ""

if LogFileExists(strOptOpus, "include/opus.h") _

And LogFileExists(strOptOpus, strLibPathOpus) _

then

strPathOpus = UnixSlashes(PathAbs(strOptOpus))

CfgPrint "SDK_VBOX_OPUS_INCS := " & strPathOpus & "/include"

CfgPrint "SDK_VBOX_OPUS_LIBS := " & strPathOpus & "/" & strLibPathOpus

else

MsgError "Can't locate " & strOpus & ". " _

& "Please consult the configure.log and the build requirements."

exit sub

end if

PrintResult strOpus, strPathOpus

end sub

```

Далее в функции `usage`, где печатается справка по аргументам, приписывается вывод двух свежедобавленных:

```

Print " --with-libvpx=PATH "

Print " --with-libopus=PATH "

```

В начале функции `Main` находятся переменные, хранящие всевозможные пути к программам и библиотекам — там создаются две новых переменных:

```

strOptVpx = ""

strOptOpus = ""

```

Ниже идёт блок `select-case` с обработкой параметров командной строки, здесь добавляется код для двух новых аргументов:

```

case "--with-libvpx"

strOptVpx = strPath

case "--with-libopus"

strOptOpus = strPath

```

И наконец, практически в конце файла идёт цепочка вызовов всех проверочных функций, отвечающих за разные компоненты, и туда вписываются вызовы наших новых обработчиков:

```

CheckForVpx strOptVpx

CheckForOpus strOptOpus

```

2. Следующий файл — `src\VBox\Runtime\Makefile.kmk`. Находим там определения переменных `VBoxRT_LIBS.win` и `VBoxRT-x86_LIBS.win` и добавляем к ним `crypt32.lib` и `bcrypt.lib`. А именно, код:

```

VBoxRT_LIBS.win = \

$(PATH_SDK_$(VBOX_WINDDK)_LIB)/vccomsup.lib \

$(PATH_SDK_$(VBOX_WINDDK)_LIB)/wbemuuid.lib \

$(PATH_TOOL_$(VBOX_VCC_TOOL)_LIB)/delayimp.lib

```

заменяется на:

```

VBoxRT_LIBS.win = \

$(PATH_SDK_$(VBOX_WINDDK)_LIB)/vccomsup.lib \

$(PATH_SDK_$(VBOX_WINDDK)_LIB)/wbemuuid.lib \

$(PATH_TOOL_$(VBOX_VCC_TOOL)_LIB)/delayimp.lib \

$(PATH_SDK_$(VBOX_WINPSDK)_LIB)/crypt32.lib \

$(PATH_SDK_$(VBOX_WINPSDK)_LIB)/bcrypt.lib

```

(не пропустите обратный слэш после `delayimp.lib`!); и аналогично:

```

VBoxRT-x86_LIBS.win = \

$(PATH_SDK_$(VBOX_WINDDK)_LIB.x86)/vccomsup.lib \

$(PATH_SDK_$(VBOX_WINDDK)_LIB.x86)/wbemuuid.lib \

$(PATH_TOOL_$(VBOX_VCC_TOOL_STEM)X86_LIB)/delayimp.lib

```

заменяется на:

```

VBoxRT-x86_LIBS.win = \

$(PATH_SDK_$(VBOX_WINDDK)_LIB.x86)/vccomsup.lib \

$(PATH_SDK_$(VBOX_WINDDK)_LIB.x86)/wbemuuid.lib \

$(PATH_TOOL_$(VBOX_VCC_TOOL_STEM)X86_LIB)/delayimp.lib \

$(PATH_SDK_$(VBOX_WINPSDK)_LIB.x86)/crypt32.lib \

$(PATH_SDK_$(VBOX_WINPSDK)_LIB.x86)/bcrypt.lib

```

Это требуется для успешной линковки библиотеки `VBoxRT.dll`. Я не до конца разобрался в этой особенности: в дистрибутиве Oracle нет зависимости от библиотеки `crypt32.dll`, она там загружается динамически во время выполнения, поэтому, теоретически, LIB-файл добавлять не нужно. Однако если этого не сделать, линковщик не может найти некоторые функции и отказывается собирать библиотеку. Предполагаю, что это как-то связано с опциями сборки OpenSSL, но детально не разбирался, проще было добавить эту библиотеку в список. А зависимость от `bcrypt.dll` появилась при переходе на OpenSSL 1.1.1.

3. Если вы используете gSOAP версии 2.8.79 или выше, то требуется подправить файл `src\VBox\Runtime\r3\win\VBoxRT-openssl-1.1plus.def`, добавив куда-нибудь в общий список следующий набор строк:

```

OpenSSL_version_num

DH_generate_parameters_ex

DH_new

ASN1_STRING_get0_data

```

Этот список определяет набор функций, экспортируемых библиотекой `VBoxRT.dll`, включающей в себя OpenSSL. При линковке утилиты `VBoxWebSrv.exe`, в зависимости от используемой версии gSOAP, имеющихся экспортов может оказаться недостаточно, и тогда линковщик дополнительно подключает OpenSSL и тут же начинает материться из-за того, что эта внешняя OpenSSL начинает драться со своей копией, внедрённой внутрь `VBoxRT`. Добавление отсутствующих экспортов устраняет эту проблему.

4. Как я упомянул в начале статьи, сборку гостевых дополнений я пропускаю, но их ISO-образ в составе дистрибутива должен присутствовать. Сборочные файлы VB на такую конструкцию в целом рассчитаны, но они ожидают, что сам ISO-файл магическим образом появится в нужном месте в нужное время. У меня эта магия реализована в файле `src\VBox\Makefile.kmk`. Находим там блок кода вида:

```

ifdef VBOX_WITH_ADDITIONS

include $(PATH_SUB_CURRENT)/Additions/Makefile.kmk

endif

```

и после него добавляем определение сборочного правила для загрузки образа:

```

ifndef VBOX_WITHOUT_ADDITIONS_ISO

$(VBOX_PATH_ADDITIONS_ISO)/VBoxGuestAdditions.iso:

$(QUIET)$(MKDIR) -p $(@D)

$(VBOX_RETRY) $(TOOL_CURL_FETCH) http://download.virtualbox.org/virtualbox/$(VBOX_VERSION_STRING_RAW)/VBoxGuestAdditions_$(VBOX_VERSION_STRING_RAW).iso -o $@

endif

```

Если вы правите файлы самостоятельно, а не готовым патчем, учтите, что строки-команды должны начинаться с символа табуляции.

5. Сборка документации — одно из больных мест этого проекта. До версий 6.0 с ней не было никаких проблем, а потом вдруг полезли сплошные несостыковки. Я не знаю, в каких условиях документация собирается в Oracle (возможно, они используют \*NIX-подобную систему), но у меня различные компоненты то и дело теряли слэши в путях или, наоборот, получали лишние, и в итоге не могли найти нужные файлы из-за сбившихся соответствий в каталожных файлах. Методом научного тыка мне удалось в итоге подобрать комбинацию, с которой документация собралась без ошибок. В первую очередь была исправлена ошибка отсутствия одного из промежуточных целевых каталогов, из-за чего некоторые файлы не могли быть созданы. Это делается в файле `doc\manual\Makefile.kmk` в блоке кода:

```

define def_vbox_refentry_to_user_sect1

$$(VBOX_PATH_MANUAL_OUTBASE)/$(1)/user_$(2): $(3) \

$$(VBOX_PATH_MANUAL_SRC)/docbook-refentry-to-manual-sect1.xsl \

$$(VBOX_XML_CATALOG) $$(VBOX_XML_CATALOG_DOCBOOK) $$(VBOX_XML_CATALOG_MANUAL) \

$$(VBOX_XML_ENTITIES) $$(VBOX_VERSION_STAMP) | $$$$(dir $$$$@)

$$(call MSG_TOOL,xsltproc $$(notdir $$(filter %.xsl,$$^)),,$$(filter %.xml,$$^),$$@)

$$(QUIET)$$(RM) -f "$$@"

$$(QUIET)$$(call VBOX_XSLTPROC_WITH_CAT) --output $$@ $$(VBOX_PATH_MANUAL_SRC)/docbook-refentry-to-manual-sect1.xsl $$<

endef

```

Здесь после строчки с `$$(RM)` я добавил команду создания целевого каталога:

```

$$(QUIET)$$(MKDIR) -p "$$(@D)"

```

Битва со слэшами происходит в файле `doc\manual\Config.kmk`. Нормального решения проблемы мне найти не удалось, поэтому в качестве обходного пути я просто добавил инструкции для обработки «кривых» путей. Сначала после строки:

```

VBOX_FILE_URL_MAYBE_SLASH = $(if $(eq $(KBUILD_HOST),win),/,)

```

я создаю две новых переменных, которые дублируют существующие переменные, но превращают одиночный слэш после имени диска в тройной:

```

VBOX_PATH_MANUAL_SRC_SLASHED = $(subst :/,:///,$(VBOX_PATH_MANUAL_SRC))

VBOX_PATH_MANUAL_OUTBASE_SLASHED = $(subst :/,:///,$(VBOX_PATH_MANUAL_OUTBASE))

```

Чуть ниже находится правило для создания каталожного файла:

```

$(VBOX_XML_CATALOG): $(VBOX_PATH_MANUAL_SRC)/Config.kmk | $$(dir $$@)

$(call MSG_L1,Creating catalog $@)

$(QUIET)$(APPEND) -tn "$@" \

'xml version="1.0"?' \

'' \

'' \

' ' \

' ' \

' ' \

' ' \

' ' \

' ' \

' ' \

' ' \

' ' \

' ' \

' ' \

' ' \

''

```

Для каждой строки, использующей переменные `VBOX_PATH_MANUAL_SRC` и `VBOX_PATH_MANUAL_OUTBASE`, я добавил такую же, но с заменой этих переменных на определённые выше (строки с префиксом `file://` можно пропустить). В итоге получилось:

```

$(VBOX_XML_CATALOG): $(VBOX_PATH_MANUAL_SRC)/Config.kmk | $$(dir $$@)

$(call MSG_L1,Creating catalog $@)

$(QUIET)$(APPEND) -tn "$@" \

'xml version="1.0"?' \

'' \

'' \

' ' \

' ' \

' ' \

' ' \

' ' \

' ' \

' ' \

' ' \

' ' \

' ' \

' ' \

' ' \

' ' \

' ' \

' ' \

' ' \

''

```

Ещё ниже присутствует правило для генерации вспомогательного каталожного файла, начинающееся со строки:

```

$(VBOX_XML_CATALOG_MANUAL): $(VBOX_PATH_MANUAL_SRC)/Config.kmk | $$(dir $$@)

```

В нём выполняется аналогичная операция (одно из вхождений находится внутри for-макроса, там нужно быть внимательным со скобками). Кроме этого, в начале файла идут несколько строчек, ссылающихся на файлы в подкаталоге `common/`:

```

' ' \

' ' \

' ' \

```

С ними наблюдается обратная проблема — исчезновение слэшей после протокола. Это я смог обойти, поменяв целевой адрес (атрибут `uri`) на обычный путь вместо file-протокола, так что, с учётом предыдущей правки, эти строки превратились в следующий набор соответствий:

```

' ' \

' ' \

' ' \

' ' \

' ' \

' ' \

```

6. Если VB собирается с подписыванием, то для большинства исполняемых файлов выставляется флаг принудительной проверки подписи (опция компоновщика `/IntegrityCheck`). При наличии полноценного сертификата это не проблема. Однако если у вас самоподписанный сертификат, VB просто откажется запускаться после установки (даже в тестовом режиме). Я модифицировал файл `Config.kmk` таким образом, чтобы флаг добавлялся только при использовании полноценного сертификата (в качестве критерия «полноценности» я выбрал наличие кросс-сертификата в файле `LocalConfig.kmk`; см. [ниже](#final-touches-localconfig)). Набор исправлений заключается в следующем.

* Вставлен блок определения переменной `VBOX_INTEGRITY_CHECK`, которая будет использоваться вместо фиксированной опции:

```

if defined(VBOX_SIGNING_MODE) && defined(VBOX_CROSS_CERTIFICATE_FILE)

VBOX_INTEGRITY_CHECK := /IntegrityCheck

else

VBOX_INTEGRITY_CHECK := /IntegrityCheck:NO

endif

```

* Чуть ниже идёт вызов утилиты `editbin`:

```

$(VBOX_VCC_EDITBIN) /LargeAddressAware /DynamicBase /NxCompat /Release /IntegrityCheck \