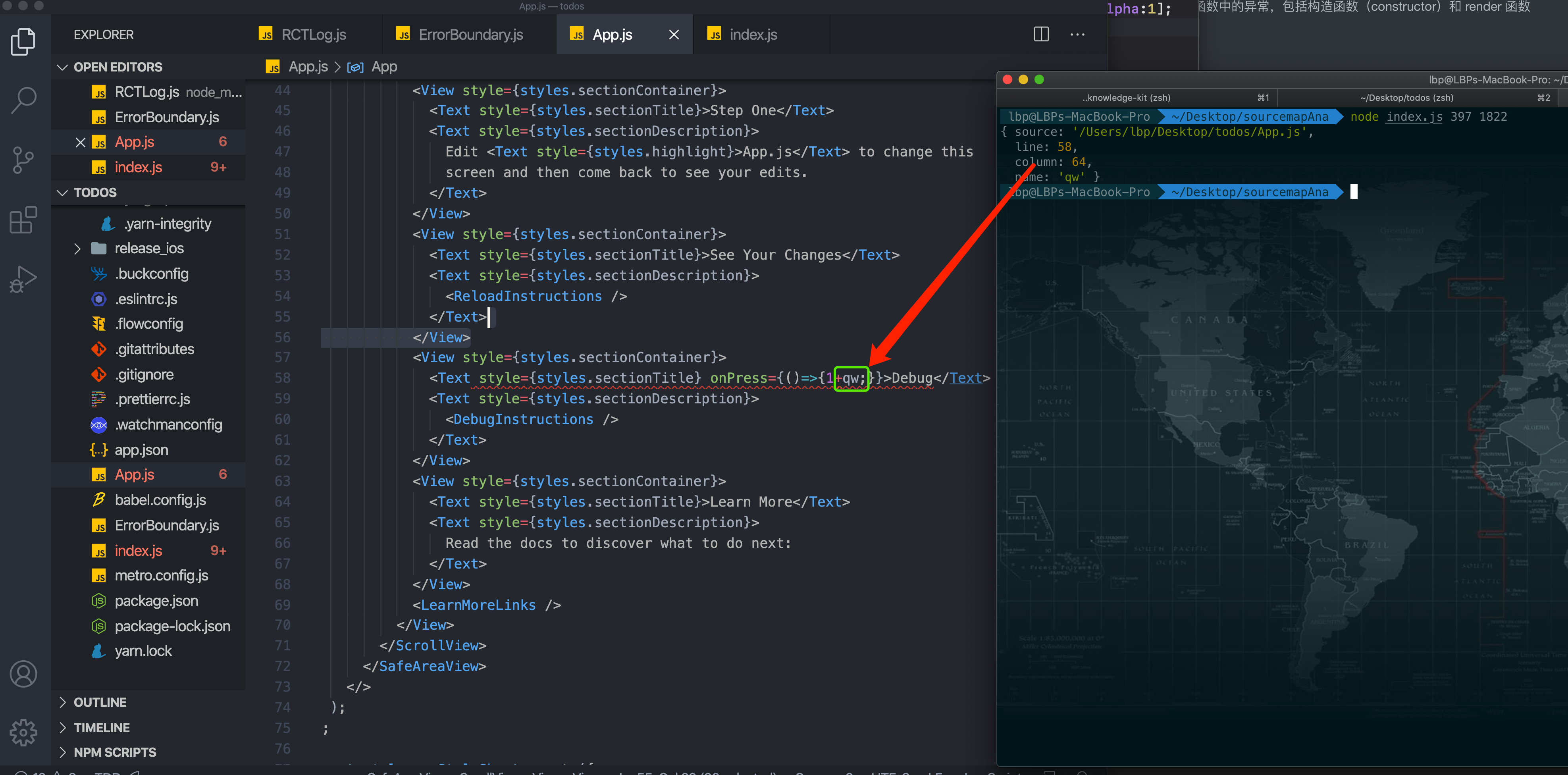

code

stringlengths 30

403k

| size

int64 31

406k

| license

stringclasses 10

values |

|---|---|---|

---

description: HTTP Server Timing

---

elton可以非常方便的获取各中间件的处理时长,获取统计时长之后,则可方便的写入相关的统计数据或HTTP响应的Server-Timing了。

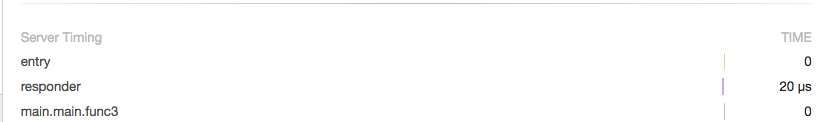

如图所示在chrome中network面板所能看得到Server-Timing展示:

```go

package main

import (

"github.com/vicanso/elton"

"github.com/vicanso/elton/middleware"

)

func main() {

e := elton.New()

e.EnableTrace = true

e.OnTrace(func(c *elton.Context, traceInfos elton.TraceInfos) {

serverTiming := string(traceInfos.ServerTiming("elton-"))

c.SetHeader(elton.HeaderServerTiming, serverTiming)

})

entry := func(c *elton.Context) (err error) {

c.ID = "random id"

c.NoCache()

return c.Next()

}

e.Use(entry)

// 设置中间件的名称,若不设置从runtime中获取

// 对于公共的中间件,建议指定名称

e.SetFunctionName(entry, "entry")

fn := middleware.NewDefaultResponder()

e.Use(fn)

e.SetFunctionName(fn, "responder")

e.GET("/", func(c *elton.Context) (err error) {

c.Body = &struct {

Name string `json:"name,omitempty"`

Content string `json:"content,omitempty"`

}{

"tree.xie",

"Hello, World!",

}

return

})

err := e.ListenAndServe(":3000")

if err != nil {

panic(err)

}

}

```

```

curl -v 'http://127.0.0.1:3000/'

* Trying 127.0.0.1...

* TCP_NODELAY set

* Connected to 127.0.0.1 (127.0.0.1) port 3000 (#0)

> GET / HTTP/1.1

> Host: 127.0.0.1:3000

> User-Agent: curl/7.54.0

> Accept: */*

>

< HTTP/1.1 200 OK

< Cache-Control: no-cache

< Content-Length: 44

< Content-Type: application/json; charset=utf-8

< Server-Timing: elton-0;dur=0;desc="entry",elton-1;dur=0.03;desc="responder",elton-2;dur=0;desc="main.main.func3"

< Date: Fri, 03 Jan 2020 13:08:50 GMT

<

* Connection #0 to host 127.0.0.1 left intact

{"name":"tree.xie","content":"Hello, World!"}

``` | 1,736 | MIT |

---

author: admin

comments: true

date: 2012-06-18 05:21:56+00:00

layout: post

slug: makefile-variables-and-assignments

title: makefile变量和赋值

wordpress_id: 400

categories:

- makefile

tags:

- make

- makefile

- 区别

- 大括号

- 括号

---

**makefile变量表示**

在makefile中,表示一个变量要用$(VAR) ${VAR}两种都行,但是在shell中必须要用大括号。其实makefile要求用小括号,只是在shell中解析用哪个都行。如果在makefile中要解析shell变量,要使用$${PWD}才可以。

**makefile赋值<!-- more -->**

VARIABLE = value

普通的赋值,如果使用值的时候会递归展开,并不是在定义的之后就把值赋好。

VARIABLE ?= value

只有在VARIABLE 为空的时候才赋值

VARIABLE := value

在声明的时候就把值给赋值好了,后面value的值改变不影响VARIABLE 。

VARIABLE += value

在VARIABLE 的值后面增加value的值。

> #example

a = orginal_value

b = $(a)

a = later_value

all:

@echo $(b)

运行make

#make

later_value

#example

a = orginal_value

b := $(a)

a = later_value

all:

@echo

$(b)

#make

original_value | 792 | MIT |

# tina-router

> An elegant enhanced router for Tina.js based Wechat-Mini-Program

[](https://www.npmjs.com/package/@tinajs/tina-router)

[](./LICENSE)

[](http://makeapullrequest.com)

## 快速上手

我们假设你已经在使用 [Tina](https://github.com/tinajs/tina) 和 [mina-webpack](https://github.com/tinajs/mina-webpack) 开发小程序项目。

### 安装

```bash

npm i --save @tinajs/tina-router

```

```javascript

/**

* <script> in /app.mina

*/

import Tina from '@tinajs/tina'

import router from '@tinajs/tina-router'

Tina.use(router)

App(......)

```

### 使用

```javascript

/**

* <script> in /pages/demo.mina

*/

import { Page } from '@tinajs/tina'

import { api } from '../api'

Page.define({

onLoad () {

api.fetchUser({ id: this.$route.query.id }).then((data) => this.setData(data))

},

methods: {

toLogin () {

this.$router.navigate(`/pages/login?from=${this.$route.fullPath}`)

},

},

})

```

## 常见问题

### 无法正确地自动获取底部 tab 列表

若 tina-router 无法正确地自动获取底部 tab 列表,请尝试将微信开发者工具的 "ES6 转 ES5" 功能关闭:

若仍不生效,可以在注册插件时手动设置:

```javascript

/**

* <script> in /app.mina

*/

import Tina from '@tinajs/tina'

import router from '@tinajs/tina-router'

Tina.use(router, {

tabs: [

'page/home',

'page/mine',

],

})

App(......)

```

## API

### Plugin.install

- 参数:

- ``{Object} Tina`` Tina

- ``{Object} config`` 同 ``createRouterMixin`` 中的参数 ``config``

- 说明:

以插件的形式安装入 Tina。

### createRouterMixin

- 参数:

- ``{Object} config``

- ``{Array <String>} tabs`` MINA [tabbar](https://mp.weixin.qq.com/debug/wxadoc/dev/framework/config.html#tabbar) 中的所有页面路径。

插件默认将自动从全局配置中读取该信息。

- 说明:

创建混合对象。

### 对页面 / 组件的注入

#### $route

- 说明:

路由信息对象。

**仅页面可用,混入组件不生效。**

##### path

- 类型: ``String``

- 说明:

当前页面的路径。

```javascript

// /pages/demo?foo=bar

Page.define({

onLoad () {

console.log(this.$route.path)

// '/page/demo'

},

})

```

##### query

- 类型: ``Object``

- 说明:

当前页面的参数对象。

与小程序中 `onLoad(Object query)` 传入的 `query` 不同,这里的 `$route.query` 会对各个值进行 `decodeURIComponent` 解码。

```javascript

// /pages/demo?foo=bar

Page.define({

onLoad () {

console.log(this.$route.query)

// { foo: 'bar }

},

})

```

##### fullPath

- 类型: ``String``

- 说明:

当前页面的完整路径。

```javascript

// /pages/demo?foo=bar

Page.define({

onLoad () {

console.log(this.$route.fullPath)

// /pages/demo?full=bar

},

})

```

#### $router

- 说明:

Router 实例。

### Router 实例

##### navigate(location, query)

- 参数:

- ``{String} location`` 前往的路径

- ``{Object} query`` query 对象

- 返回值: ``Promise``

- 说明:

前往具体的路径。

当目标路径属于导航栏标签 *(tabs)* 时,实际触发 ``reLaunch``

*(需正确地设置导航栏页面列表)* 。

```javascript

Page.define({

onLoad () {

this.$router.navigate('/page/home', { message: 'hi' })

},

})

```

##### redirect(location, query)

- 参数:

- ``{String} location`` 重定向的路径

- ``{Object} query`` query 对象

- 返回值: ``Promise``

- 说明:

重定向具体的路径。

当目标路径属于导航栏标签 *(tabs)* 时,实际触发 ``reLaunch``

*(需正确地设置导航栏页面列表)* 。

```javascript

Page.define({

onLoad () {

this.$router.redirect('/page/login')

},

})

```

##### switchTab(location)

- 参数:

- ``{String} location`` 重定向的路径

- 返回值: ``Promise``

- 说明:

切换到具体的一级页面 (属于导航栏标签的页面)。该方法运行效率更高,但不支持 query 参数。

```javascript

Page.define({

onLoad () {

this.$router.switchTab('/page/login')

},

})

```

##### back()

- 参数:

- 无

- 返回值: ``Promise``

- 说明:

后退。

```javascript

Page.define({

onLoad () {

this.$router.back()

},

})

```

##### isTab(location)

- 参数:

- ``{String} location`` 路径

- 返回值: ``Boolean``

- 说明:

返回某路径是否属于导航栏项。

*需正确地设置导航栏页面列表*

```javascript

Page.define({

onLoad () {

if (this.$router.isTab('/page/home')) {

console.log('homepage is one of the tabs')

}

},

})

```

## License

Apache-2.0 @ [yelo](https://github.com/imyelo) | 4,113 | Apache-2.0 |

---

title: 将 gitRepo 卷装载到容器组

description: 了解如何在容器实例中装载 gitRepo 卷以克隆 Git 存储库

ms.topic: article

origin.date: 06/15/2018

author: rockboyfor

ms.date: 11/02/2020

ms.author: v-yeche

ms.openlocfilehash: b5277de464bd354a4f9cff1c766f7c275936626c

ms.sourcegitcommit: 93309cd649b17b3312b3b52cd9ad1de6f3542beb

ms.translationtype: HT

ms.contentlocale: zh-CN

ms.lasthandoff: 10/30/2020

ms.locfileid: "93104988"

---

<!--Verified successfully-->

# <a name="mount-a-gitrepo-volume-in-azure-container-instances"></a>在 Azure 容器实例中装载 gitRepo 卷

了解如何在容器实例中装载 *gitRepo* 卷以克隆 Git 存储库。

> [!NOTE]

> 当前只有 Linux 容器能装载 *gitRepo* 卷。 虽然我们正致力于为 Windows 容器提供全部功能,但你可在[概述](container-instances-overview.md#linux-and-windows-containers)中了解当前的平台差异。

## <a name="gitrepo-volume"></a>gitRepo 卷

*gitRepo* 卷可在容器启动时装载目录,并将指定的 Git 存储库克隆到该目录。 在容器实例中使用 *gitRepo* 卷,可避免在应用程序中为执行此操作添加代码。

装载 *gitRepo* 卷时,可以设置三个属性以对卷进行配置:

| 属性 | 必须 | 说明 |

| -------- | -------- | ----------- |

| `repository` | 是 | 要克隆的 Git 存储库的完整 URL,包括 `http://` 或 `https://`。|

| `directory` | 否 | 存储库应克隆到的目录。 路径不得包含“`..`”,也不能以其开头。 如果指定“`.`”,存储库将克隆到卷的目录。 否则,Git 存储库将克隆到卷目录中给定名称的子目录。 |

| `revision` | 否 | 要克隆的修订的提交哈希。 如果未指定,则克隆 `HEAD` 修订。 |

## <a name="mount-gitrepo-volume-azure-cli"></a>装载 gitRepo 卷:Azure CLI

若要在使用 [Azure CLI](https://docs.azure.cn/cli) 部署容器实例时装载 gitRepo 卷,请在 [az container create][az-container-create] 命令中提供 `--gitrepo-url` 和 `--gitrepo-mount-path` 参数。 还可以指定要将卷克隆到其中的目录 (`--gitrepo-dir`) 和要克隆的修订版的提交哈希 (`--gitrepo-revision`)。

此示例命令将 Microsoft [aci-helloworld][aci-helloworld] 示例应用程序克隆到容器实例中的 `/mnt/aci-helloworld`:

<!--Not Avaialble on Microsoft [aci-helloworld]-->

```azurecli

az container create \

--resource-group myResourceGroup \

--name hellogitrepo \

--image mcr.microsoft.com/azuredocs/aci-helloworld \

--dns-name-label aci-demo \

--ports 80 \

--gitrepo-url https://github.com/Azure-Samples/aci-helloworld \

--gitrepo-mount-path /mnt/aci-helloworld

```

若要验证 gitRepo 卷是否已装载,请使用 [az container exec][az-container-exec] 在该容器中启动 shell 并列出目录:

```azurecli

az container exec --resource-group myResourceGroup --name hellogitrepo --exec-command /bin/sh

```

```output

/usr/src/app # ls -l /mnt/aci-helloworld/

total 16

-rw-r--r-- 1 root root 144 Apr 16 16:35 Dockerfile

-rw-r--r-- 1 root root 1162 Apr 16 16:35 LICENSE

-rw-r--r-- 1 root root 1237 Apr 16 16:35 README.md

drwxr-xr-x 2 root root 4096 Apr 16 16:35 app

```

## <a name="mount-gitrepo-volume-resource-manager"></a>装载 gitRepo 卷:Resource Manager

若要在使用 Azure 资源管理器模板部署容器实例时装载 gitRepo 卷,请首先填充模板的容器组 `properties` 节中的 `volumes` 数组。 然后,针对容器组中希望装载 *gitRepo* 卷的每个容器,在容器定义的 `properties` 节中填充 `volumeMounts` 数组。

<!--Not Avaiable on [Azure Resource Manager template](https://docs.microsoft.com/azure/templates/microsoft.containerinstance/containergroups)-->

例如,以下资源管理器模板创建了一个包含单个容器的容器组。 该容器克隆由 *gitRepo* 卷块指定的两个 GitHub 存储库。 第二个卷包括其他属性以指定要克隆到的目录和要克隆的特定修订的提交哈希。

<!-- https://github.com/Azure/azure-docs-json-samples/blob/master/container-instances/aci-deploy-volume-gitrepo.json -->

```json

{

"$schema": "https://schema.management.azure.com/schemas/2015-01-01/deploymentTemplate.json#",

"contentVersion": "1.0.0.0",

"variables": {

"container1name": "aci-tutorial-app",

"container1image": "microsoft/aci-helloworld:latest"

},

"resources": [

{

"name": "volume-demo-gitrepo",

"type": "Microsoft.ContainerInstance/containerGroups",

"apiVersion": "2018-02-01-preview",

"location": "[resourceGroup().location]",

"properties": {

"containers": [

{

"name": "[variables('container1name')]",

"properties": {

"image": "[variables('container1image')]",

"resources": {

"requests": {

"cpu": 1,

"memoryInGb": 1.5

}

},

"ports": [

{

"port": 80

}

],

"volumeMounts": [

{

"name": "gitrepo1",

"mountPath": "/mnt/repo1"

},

{

"name": "gitrepo2",

"mountPath": "/mnt/repo2"

}

]

}

}

],

"osType": "Linux",

"ipAddress": {

"type": "Public",

"ports": [

{

"protocol": "tcp",

"port": "80"

}

]

},

"volumes": [

{

"name": "gitrepo1",

"gitRepo": {

"repository": "https://github.com/Azure-Samples/aci-helloworld"

}

},

{

"name": "gitrepo2",

"gitRepo": {

"directory": "my-custom-clone-directory",

"repository": "https://github.com/Azure-Samples/aci-helloworld",

"revision": "d5ccfcedc0d81f7ca5e3dbe6e5a7705b579101f1"

}

}

]

}

}

]

}

```

前面的模板中定义的两个克隆存储库的生成目录结构如下:

```

/mnt/repo1/aci-helloworld

/mnt/repo2/my-custom-clone-directory

```

若要查看使用 Azure 资源管理器模板进行的容器实例部署示例,请参阅[在 Azure 容器实例中部署多容器组](container-instances-multi-container-group.md)。

## <a name="private-git-repo-authentication"></a>专用 Git 存储库身份验证

若要为专用 Git 存储库装载 gitRepo 卷,请在存储库 URL 中指定凭据。 通常,凭据采用用户名和个人访问令牌 (PAT) 的形式,授予对存储库的范围访问权限。

例如,专用 GitHub 存储库的 Azure CLI `--gitrepo-url` 参数将类似于以下内容(其中“gituser”是 GitHub 用户名,“abcdef1234fdsa4321abcdef”是用户的个人访问令牌):

```console

--gitrepo-url https://gituser:abcdef1234fdsa4321abcdef@github.com/GitUser/some-private-repository

```

对于 Azure Repos Git 存储库,请指定任何用户名(可以使用“azurereposuser”,如下例所示)并结合有效的 PAT:

```console

--gitrepo-url https://azurereposuser:abcdef1234fdsa4321abcdef@dev.azure.com/your-org/_git/some-private-repository

```

有关 GitHub 和 Azure Repos 的个人访问令牌的详细信息,请参阅以下内容:

GitHub:[创建命令行的个人访问令牌][pat-github]

<!--Not Available on Azure Repos: [Create personal access tokens to authenticate access][pat-repos]-->

## <a name="next-steps"></a>后续步骤

了解如何在 Azure 容器实例中装载其他卷类型:

* [在 Azure 容器实例中装载 Azure 文件共享](container-instances-volume-azure-files.md)

* [在 Azure 容器实例中装载 emptyDir 卷](container-instances-volume-emptydir.md)

* [在 Azure 容器实例中装载机密卷](container-instances-volume-secret.md)

<!-- LINKS - External -->

[aci-helloworld]: https://github.com/Azure-Samples/aci-helloworld

[pat-github]: https://help.github.com/articles/creating-a-personal-access-token-for-the-command-line/

<!--Not Available on [pat-repos]: /devops/organizations/accounts/use-personal-access-tokens-to-authenticate-->

<!-- LINKS - Internal -->

[az-container-create]: https://docs.microsoft.com/cli/azure/container#az_container_create

[az-container-exec]: https://docs.microsoft.com/cli/azure/container#az_container_exec

<!-- Update_Description: update meta properties, wording update, update link --> | 6,907 | CC-BY-4.0 |

#### 必要條件

- Azure 帳戶;您可以建立一個[免費帳戶](https://azure.microsoft.com/free)

- [Office 365](https://office365.com) 帳戶

在於邏輯應用程式中使用您的 Office 365 帳戶之前,請先授權該邏輯應用程式連線到您的 Office 365 帳戶。您可以在 Azure 入口網站上,從邏輯應用程式內輕鬆完成此操作。

請使用下列步驟來授權邏輯應用程式連線到您的 Office 365 帳戶:

1. 建立邏輯應用程式。在 Logic Apps 設計工具中,從下拉式清單中選取 [顯示 Microsoft Managed API],然後在搜尋方塊中輸入 "office 365"。選取其中一個觸發程序或動作︰

2. 如果您之前尚未建立與 Office 365 的任何連線,系統將會提示您使用 Office 365 認證來進行登入:

3. 選取 [登入],然後輸入您的使用者名稱和密碼。選取 [登入]:

這些認證會用來授權邏輯應用程式連線及存取您的 Office 365 帳戶。

4. 請注意,已建立連線。現在,請繼續進行您邏輯應用程式中的其他步驟:

<!---HONumber=AcomDC_0727_2016--> | 969 | CC-BY-3.0 |

---

title: 调试Kubernetes集群中的网络停顿问题

layout: post

category: k8s

author: 夏泽民

---

https://mp.weixin.qq.com/s/u5aEQhZTDtLrVdC8AO_ogQ

https://mp.weixin.qq.com/s/zoTOv7oFS0k86jKfL5azfQ

<!-- more -->

https://mp.weixin.qq.com/s/P9bVFtXeduZ8Lv-0vFaXAg

https://github.com/augmentable-dev/gitqlite | 286 | MIT |

# Button 按钮

### 基础按钮

通过 `type` 设置方按钮类型,可选值有 `default` `danger ` `primary ` `success ` `warning ` `link` 默认可不填。

可通过 `inline` 设置行内元素,不设置为块元素。

## 代码示例

```html

<Button type="primary">Primary</Button>

<Button type="success">Success</Button>

<Button type="warning">Warning</Button>

<Button type="danger">Danger</Button>

<Button type="default" inline>Default</Button>

<Button type="link" inline>Link</Button>

```

### 尺寸、边框

通过 `size` 设置方按钮类型,可选值有 `large` `default ` `small ` 默认可不填。

通过 `hairline` 设置细边框。

```html

<Button type="primary" size="large">Primary Large</Button>

<Button type="primary" size="default">Primary Default</Button>

<Button type="primary" size="small">Primary Small</Button>

<Button type="primary" hairline>Primary Hairline</Button>

<Button type="success" hairline>Success Hairline</Button>

<Button type="success" block>Success block</Button>

```

### 禁用

```html

<Button type="primary" disabled>Primary Disabled</Button>

```

## API

属性 | 说明 | 类型 | 默认值

----|-----|------|------

| type | 按钮类型,可选值为`default`、`danger`、`primary`、`success`、`warning`、`link`或者不设 | string | - |

| size | 按钮大小,可选值为`default`、`large`、`small` | string | `default`|

| disabled | 设置禁用 | boolean | false |

| onClick | 点击按钮的点击回调函数 | (e: Object): void | 无 |

| style | 自定义样式 | Object | 无 |

| inline | 是否设置为行内按钮 | boolean | false |

| hairline | 是否细边框按钮 | boolean | false |

| className | 样式类名 | string | 无 |

<!-- | activeStyle | ~~点击反馈的自定义样式 (设为 false 时表示禁止点击反馈)~~ | {}/false | {} | -->

<!-- | activeClassName | ~~点击反馈的自定义类名~~ | string | | -->

<!-- | loading | ~~设置按钮载入状态~~ | boolean | false | -->

<!-- | icon | ~~可以是 [Icon]组件里内置的某个 icon 的 type 值,也可以是任意合法的 ReactElement (注意: `loading`设置后此项设置失效)~~ | `string`/`React.Element` | - | -->

### 其他

`activeStyle` `activeClassName` `icon` 将在后期进行完善。 | 1,838 | MIT |

# 概述

Spring Boot 提供了 Maven 插件 [`spring-boot-maven-plugin`](https://docs.spring.io/spring-boot/docs/current/reference/html/build-tool-plugins.html#build-tool-plugins-maven-plugin),可以方便的将 Spring Boot 项目打成 `jar` 包或者 `war` 包。

* 考虑到部署的便利性,我们绝大多数 99.99% 的场景下,我们会选择打成 `jar` 包。这样,我们就无需在部署项目的服务器上,配置相应的 Tomcat、Jetty 等 Servlet 容器。

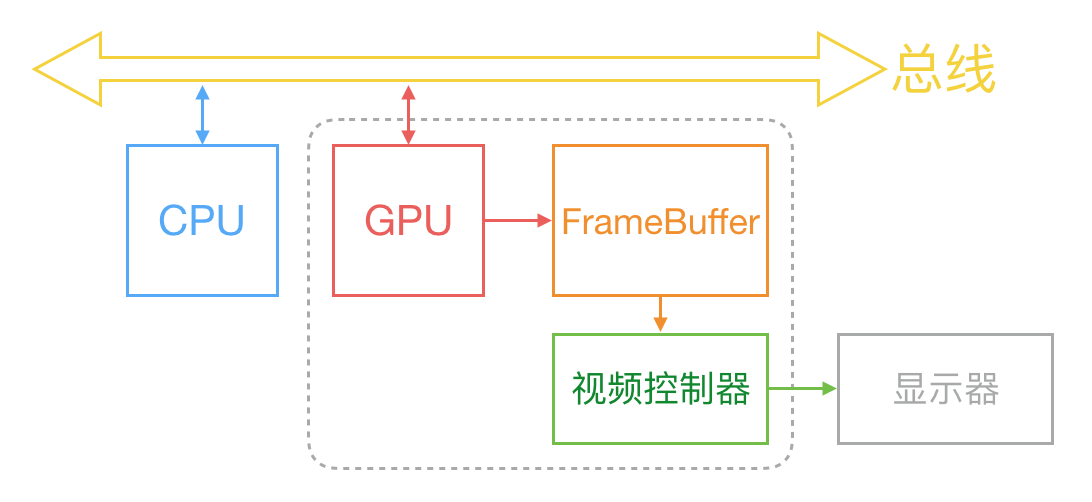

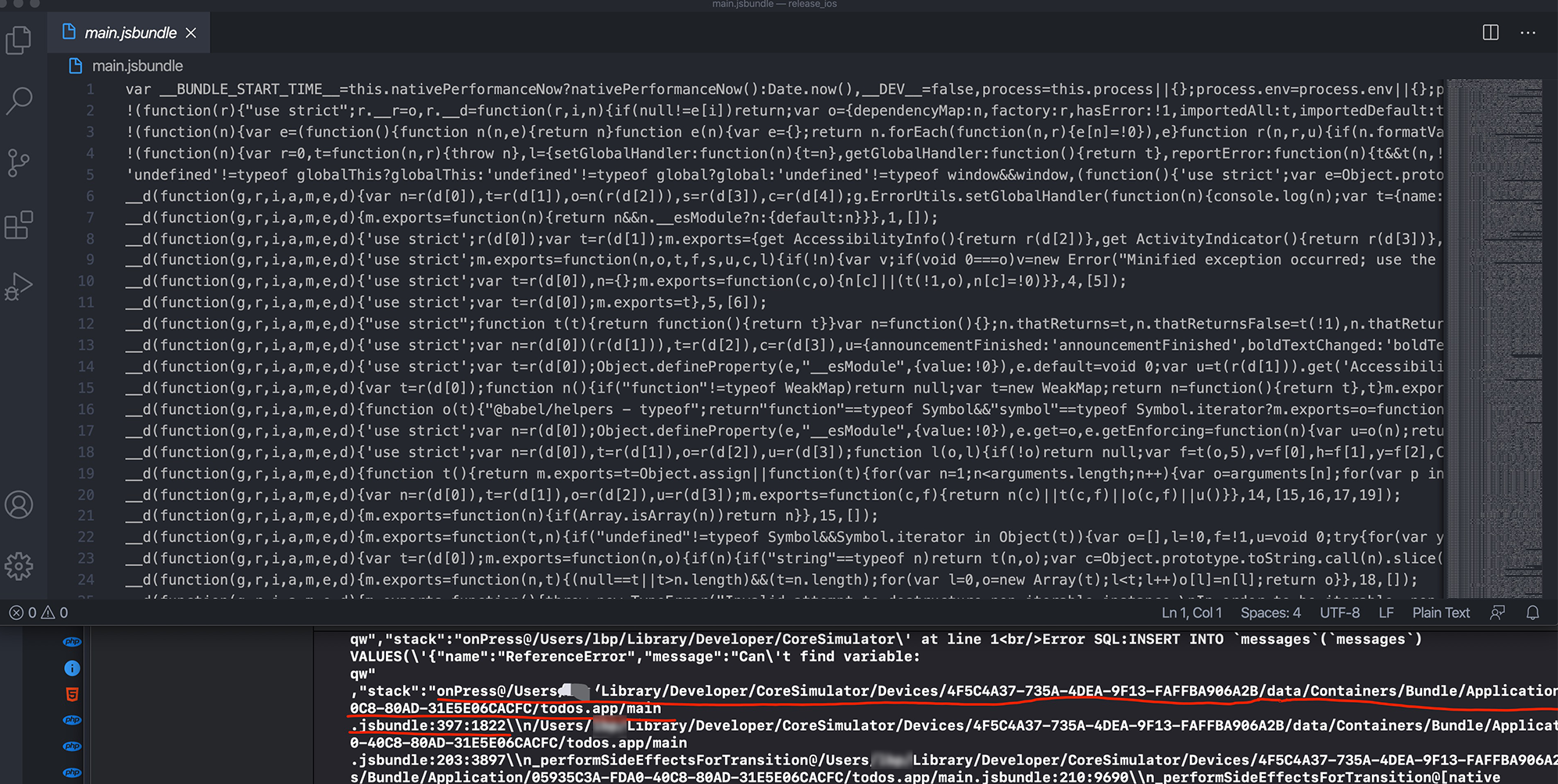

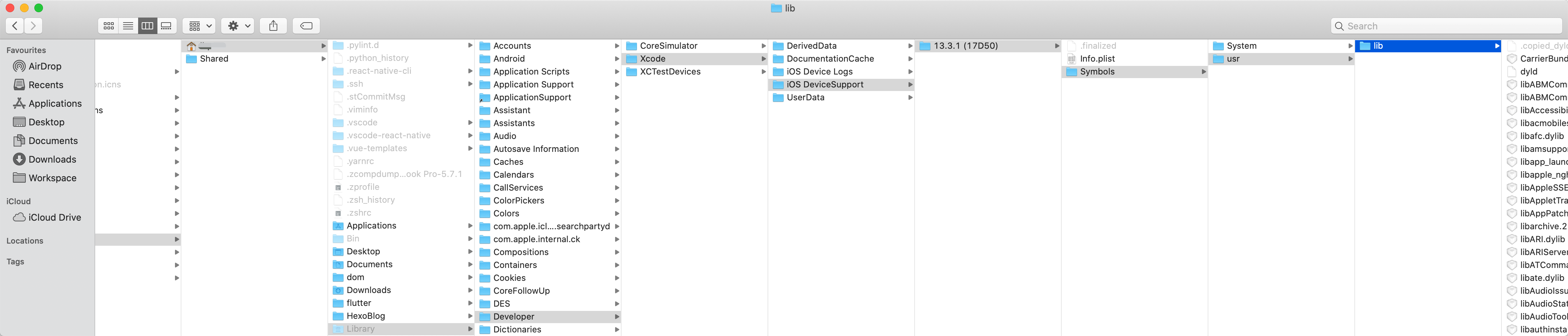

下面,我们来打开一个 Spring Boot `jar` 包,看看其里面的结构。如下图所示,一共分成四部分:

<img src="http://www.iocoder.cn/images/Spring-Boot/2019-01-07/01.png" width="75%"/>

- ① `META-INF` 目录:通过 `MANIFEST.MF` 文件提供 `jar` 包的**元数据**,声明了 `jar` 的启动类。

- ② `org` 目录:为 Spring Boot 提供的 `spring-boot-loader` 项目,它是 `java -jar` 启动 Spring Boot 项目的秘密所在,也是稍后我们将深入了解的部分。

- ③ `BOOT-INF/lib` 目录:我们 Spring Boot 项目中引入的**依赖**的 `jar` 包们。`spring-boot-loader` 项目很大的一个作用,就是**解决 `jar` 包里嵌套 `jar` 的情况**,如何加载到其中的类。

- ④ `BOOT-INF/classes` 目录:我们在 Spring Boot 项目中 Java 类所编译的 `.class`、配置文件等等。

先简单剧透下,`spring-boot-loader` 项目需要解决两个问题:

- 第一,如何引导执行我们创建的 Spring Boot 应用的启动类,例如上述图中的 Application 类。

- 第二,如何加载 `BOOT-INF/class` 目录下的类,以及 `BOOT-INF/lib` 目录下内嵌的 `jar` 包中的类。

# MANIFEST.MF

我们来查看 `META-INF/MANIFEST.MF` 文件,里面的内容如下:

```

Manifest-Version: 1.0

Implementation-Title: lab-39-demo

Implementation-Version: 2.2.2.RELEASE

Spring-Boot-Classes: BOOT-INF/classes/

Spring-Boot-Lib: BOOT-INF/lib/

Build-Jdk-Spec: 1.8

Spring-Boot-Version: 2.2.2.RELEASE

Created-By: Maven Archiver 3.4.0

Main-Class: org.springframework.boot.loader.JarLauncher

Start-Class: cn.iocoder.springboot.lab39.skywalkingdemo.Application

```

它实际是一个 **Properties** 配置文件,每一行都是一个配置项目。重点来看看两个配置项:

- `Main-Class` 配置项:Java 规定的 `jar` 包的启动类,这里设置为 `spring-boot-loader` 项目的 JarLauncher 类,进行 Spring Boot 应用的启动。

- `Start-Class` 配置项:Spring Boot 规定的**主**启动类,这里设置为我们定义的 Application 类。

> 小知识补充:为什么会有 `Main-Class`/`Start-Class` 配置项呢?因为我们是通过 Spring Boot 提供的 Maven 插件 `spring-boot-maven-plugin` 进行打包,该插件将该配置项写入到 `MANIFEST.MF` 中,从而能让 `spring-boot-loader` 能够引导启动 Spring Boot 应用。

可能胖友会有疑惑,`Start-Class` 对应的 Application 类自带了 `#main(String[] args)` 方法,为什么我们不能直接运行会如何呢?我们来简单尝试一下哈,控制台执行如下:

```

$ java -classpath lab-39-demo-2.2.2.RELEASE.jar cn.iocoder.springboot.lab39.skywalkingdemo.Application

错误: 找不到或无法加载主类 cn.iocoder.springboot.lab39.skywalkingdemo.Application

```

直接找不到 Application 类,因为它在 `BOOT-INF/classes` 目录下,不符合 Java 默认的 `jar` 包的加载规则。因此,需要通过 JarLauncher 启动加载。

当然实际还有一个更重要的原因,Java 规定可执行器的 `jar` 包禁止嵌套其它 `jar` 包。但是我们可以看到 `BOOT-INF/lib` 目录下,实际有 Spring Boot 应用依赖的所有 `jar` 包。因此,`spring-boot-loader` 项目自定义实现了 ClassLoader 实现类 LaunchedURLClassLoader,支持加载 `BOOT-INF/classes` 目录下的 `.class` 文件,以及 `BOOT-INF/lib` 目录下的 `jar` 包。

# JarLauncher

JarLauncher 类是针对 Spring Boot `jar` 包的启动类,整体类图如下所示:

<img src="https://img-blog.csdnimg.cn/img_convert/eb683727697492d3094302f072d339ba.png" width="45%"/>

> 友情提示:WarLauncher 类,是针对 Spring Boot `war` 包的启动类,后续胖友可以自己瞅瞅,差别并不大哈~

JarLauncher 的源码比较简单,如下图所示:

```java

public class JarLauncher extends ExecutableArchiveLauncher {

static final String BOOT_INF_CLASSES = "BOOT-INF/classes/";

static final String BOOT_INF_LIB = "BOOT-INF/lib/";

public JarLauncher() {

}

protected JarLauncher(Archive archive) {

super(archive);

}

@Override

protected boolean isNestedArchive(Archive.Entry entry) {

if (entry.isDirectory()) {

return entry.getName().equals(BOOT_INF_CLASSES);

}

return entry.getName().startsWith(BOOT_INF_LIB);

}

public static void main(String[] args) throws Exception {

new JarLauncher().launch(args);

}

}

```

通过 `#main(String[] args)` 方法,创建 JarLauncher 对象,并调用其 `#launch(String[] args)` 方法进行启动。整体的启动逻辑,其实是由父类 Launcher 所提供

父类 Launcher 的 `#launch(String[] args)` 方法,代码如下:

```java

// Launcher.java

protected void launch(String[] args) throws Exception {

// <1> 注册 URL 协议的处理器

JarFile.registerUrlProtocolHandler();

// <2> 创建类加载器

ClassLoader classLoader = createClassLoader(getClassPathArchives());

// <3> 执行启动类的 main 方法

// getMainClass() 返回的是 META-INF/MANIFEST.MF 里的 startClass

launch(args, getMainClass(), classLoader);

}

```

- `<1>` 处,调用 JarFile 的 `#registerUrlProtocolHandler()` 方法,注册 Spring Boot 自定义的 URLStreamHandler 实现类,用于 `jar` 包的加载读取。

- `<2>` 处,调用自身的 `#createClassLoader(List<Archive> archives)` 方法,创建自定义的 ClassLoader 实现类,用于从 `jar` 包中加载类。

- `<3>` 处,执行我们声明的 Spring Boot 启动类,进行 Spring Boot 应用的启动。

简单来说,就是整一个可以读取 `jar` 包中类的加载器,保证 `BOOT-INF/lib` 目录下的类和 `BOOT-classes` 内嵌的 `jar` 中的类能够被正常加载到,之后执行 Spring Boot 应用的启动。

## 1、registerUrlProtocolHandler

> 友情提示:对应 `JarFile.registerUrlProtocolHandler();` 代码段,不要迷路。

**这一步的原因**

* 因为 JDK 的 classLoader 只能加载一层 jar 包,对于 classPath 下 `a.jar/b.jar` 不会解析 b.jar(即 UrlClassPath 里的 jarLoader,默认只加载一层,对于常规打包方式(即不使用 maven 也不使用别的打包插件),例如 IDEA 自带的打 jar 包的方式,如果项目有依赖 jar 包的话,都会进行解压,然后把解压后的路径信息放在 META-INFO/INDEX.LIST)

<img src="https://img-blog.csdnimg.cn/20210301170933293.png?x-oss-process=image/watermark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L3dlaXhpbl80MzkzNDYwNw==,size_16,color_FFFFFF,t_70" width="25%"/>

* JarLoader

```java

Resource getResource(String var1, boolean var2) {

if (this.metaIndex != null && !this.metaIndex.mayContain(var1)) {

return null;

} else {

try {

this.ensureOpen();

} catch (IOException var5) {

throw new InternalError(var5);

}

// 直接从 jar 包下一级取(即用户编写的类)

JarEntry var3 = this.jar.getJarEntry(var1);

if (var3 != null) {

return this.checkResource(var1, var2, var3);

} else if (this.index == null) {

return null;

} else { // jar 包如果存在解压后的依赖(即存在 META-INFO/INDEX.LIST)

HashSet var4 = new HashSet();

// 根据 META-INFO/INDEX.LIST 里的信息取

return this.getResource(var1, var2, var4);

}

}

}

```

JarFile 是SpringBoot 里继承 `java.util.jar.JarFile` 的子类,如下所示:

```java

public class JarFile extends java.util.jar.JarFile {

// ... 省略其它代码

}

```

OK,介绍完之后,让我们回到 JarFile 的 `#registerUrlProtocolHandler()` 方法,注册 Spring Boot 自定义的 URL 协议的处理器。代码如下:

```java

// JarFile.java

private static final String PROTOCOL_HANDLER = "java.protocol.handler.pkgs";

private static final String HANDLERS_PACKAGE = "org.springframework.boot.loader";

/**

* Register a {@literal 'java.protocol.handler.pkgs'} property so that a

* {@link URLStreamHandler} will be located to deal with jar URLs.

*/

public static void registerUrlProtocolHandler() {

// 获得 URLStreamHandler 的路径

String handlers = System.getProperty(PROTOCOL_HANDLER, "");

// 将 Spring Boot 自定义的 HANDLERS_PACKAGE(org.springframework.boot.loader) 补充上去

System.setProperty(PROTOCOL_HANDLER, ("".equals(handlers) ? HANDLERS_PACKAGE

: handlers + "|" + HANDLERS_PACKAGE));

// 重置已缓存的 URLStreamHandler 处理器们

resetCachedUrlHandlers();

}

/**

* 重置 URL 中的 URLStreamHandler 的缓存,防止 `jar://` 协议对应的 URLStreamHandler 已经创建

* 我们通过设置 URLStreamHandlerFactory 为 null 的方式,清空 URL 中的该缓存。

*/

private static void resetCachedUrlHandlers() {

try {

URL.setURLStreamHandlerFactory(null);

} catch (Error ex) {

// Ignore

}

}

```

目的很明确,通过将 `org.springframework.boot.loader` 包设置到 `"java.protocol.handler.pkgs"` 环境变量,从而使用到自定义的 URLStreamHandler 实现类 Handler,处理 `jar:` 协议的 URL。

## 2、createClassLoader

> 友情提示:对应 `ClassLoader classLoader = createClassLoader(getClassPathArchives())` 代码段,不要迷路。

### 2.1 getClassPathArchives

首先,我们先来看看 `#getClassPathArchives()` 方法,它是由 ExecutableArchiveLauncher 所实现,代码如下:

```java

// ExecutableArchiveLauncher.java

private final Archive archive;

@Override

protected List<Archive> getClassPathArchives() throws Exception {

// <1> 获得所有 Archive

List<Archive> archives = new ArrayList<>(

this.archive.getNestedArchives(this::isNestedArchive));

// <2> 后续处理

postProcessClassPathArchives(archives);

return archives;

}

protected abstract boolean isNestedArchive(Archive.Entry entry);

protected void postProcessClassPathArchives(List<Archive> archives) throws Exception {

}

```

> 友情提示:这里我们会看到一个 Archive 对象,先可以暂时理解成一个一个的**档案**,稍后会清晰认识的~

#### 2.1.1 `this::isNestedArchive`

`this::isNestedArchive` 代码段,创建了 EntryFilter 匿名实现类,用于过滤 `jar` 包不需要的目录。

```java

// Archive.java

interface Entry {

boolean isDirectory();

String getName();

}

interface EntryFilter {

boolean matches(Entry entry);

}

```

这里在它的内部,调用了 `#isNestedArchive(Archive.Entry entry)` 方法,它是由 JarLauncher 所实现,代码如下:

```java

// JarLauncher.java

static final String BOOT_INF_CLASSES = "BOOT-INF/classes/";

static final String BOOT_INF_LIB = "BOOT-INF/lib/";

@Override

protected boolean isNestedArchive(Archive.Entry entry) {

// 如果是目录的情况,只要 BOOT-INF/classes/ 目录

if (entry.isDirectory()) {

return entry.getName().equals(BOOT_INF_CLASSES);

}

// 如果是文件的情况,只要 BOOT-INF/lib/ 目录下的 `jar` 包

return entry.getName().startsWith(BOOT_INF_LIB);

}

```

- 目的就是过滤获得,`BOOT-INF/classes/` 目录下的类,以及 `BOOT-INF/lib/` 的内嵌 `jar` 包。

#### 2.1.2 `this.archive.getNestedArchives`

`this.archive.getNestedArchives` 代码段,调用 Archive 的 `#getNestedArchives(EntryFilter filter)` 方法,获得 `archive` 内嵌的 Archive 集合。代码如下:

```java

// Archive.java

List<Archive> getNestedArchives(EntryFilter filter) throws IOException;

```

Archive 接口,是 `spring-boot-loader` 项目定义的**档案**抽象,其子类如下图所示:

<img src="https://img-blog.csdnimg.cn/img_convert/b2a6b42265139165c9f5a96bd3af4bc2.png" width="45%"/>

- ExplodedArchive 是针对**目录**的 Archive 实现类。

- JarFileArchive 是针对 **`jar` 包**的 Archive 实现类。

**根 archive 的创建**

* 我们在 ExecutableArchiveLauncher 的 `archive` 属性是怎么来的呢?答案在 ExecutableArchiveLauncher 的构造方法中,代码如下:

```java

// ExecutableArchiveLauncher.java

public abstract class ExecutableArchiveLauncher extends Launcher {

private final Archive archive;

public ExecutableArchiveLauncher() {

try {

this.archive = createArchive();

} catch (Exception ex) {

throw new IllegalStateException(ex);

}

}

protected ExecutableArchiveLauncher(Archive archive) {

this.archive = archive;

}

// ... 省略其它

}

// Launcher.java

public abstract class Launcher {

protected final Archive createArchive() throws Exception {

// 获得 jar 所在的绝对路径

// 例如 /Users/yunai/Java/SpringBoot-Labs/lab-39/lab-39-demo/target/lab-39-demo-2.2.2.RELEASE.jar

ProtectionDomain protectionDomain = getClass().getProtectionDomain();

CodeSource codeSource = protectionDomain.getCodeSource();

URI location = (codeSource != null) ? codeSource.getLocation().toURI() : null;

String path = (location != null) ? location.getSchemeSpecificPart() : null;

if (path == null) {

throw new IllegalStateException("Unable to determine code source archive");

}

File root = new File(path);

if (!root.exists()) {

throw new IllegalStateException(

"Unable to determine code source archive from " + root);

}

// 如果是目录,则使用 ExplodedArchive 进行展开

// 如果不是目录,则使用 JarFileArchive

return (root.isDirectory() ? new ExplodedArchive(root)

: new JarFileArchive(root));

}

}

```

* 根据根路径**是否为目录**的情况,创建 ExplodedArchive 或 JarFileArchive 对象。

JarFileArchive.getNestedArchives()

* JarFileArchive:有一个重要的包含关系:JarFileArchive -> JarFile -> Url

```java

public List<Archive> getNestedArchives(EntryFilter filter) throws IOException {

List<Archive> nestedArchives = new ArrayList();

// 因为 Archive 实现了 Iterator

// 会遍历当前 JarFileArchive 里 jarFile 的下一级

Iterator var3 = this.iterator();

while(var3.hasNext()) {

Entry entry = (Entry)var3.next();

// 如果是BOOT-INF/classes/ 或 BOOT-INF/libs/

if (filter.matches(entry)) {

// 再把 entry 里对应的 jarFile 包装成 JarFileArchive

nestedArchives.add(this.getNestedArchive(entry));

}

}

return Collections.unmodifiableList(nestedArchives);

}

protected Archive getNestedArchive(Entry entry) throws IOException {

JarEntry jarEntry = ((JarFileArchive.JarFileEntry)entry).getJarEntry();

// 如果不是 Jar 包,即 BOOT-INF/classes/

// UnpackedNestedArchive 不会再往下解析

if (jarEntry.getComment().startsWith("UNPACK:")) {

return this.getUnpackedNestedArchive(jarEntry);

} else {

try {

JarFile jarFile = this.jarFile.getNestedJarFile(jarEntry);

return new JarFileArchive(jarFile);

} catch (Exception var4) {

throw new IllegalStateException("Failed to get nested archive for entry " + entry.getName(), var4);

}

}

}

```

### 2.2 createClassLoader

然后,我再来看看 `#createClassLoader(List<Archive> archives)` 方法,它是由 ExecutableArchiveLauncher 所实现,代码如下:

```java

// ExecutableArchiveLauncher.java

protected ClassLoader createClassLoader(List<Archive> archives) throws Exception {

// 获得所有 Archive 的 URL 地址

List<URL> urls = new ArrayList<>(archives.size());

for (Archive archive : archives) {

urls.add(archive.getUrl());

}

// 创建加载这些 URL 的 ClassLoader

return createClassLoader(urls.toArray(new URL[0]));

}

protected ClassLoader createClassLoader(URL[] urls) throws Exception {

return new LaunchedURLClassLoader(urls, getClass().getClassLoader());

}

```

基于获得的 Archive 数组,创建自定义 ClassLoader 实现类 LaunchedURLClassLoade,通过它来加载 `BOOT-INF/classes` 目录下的类,以及 `BOOT-INF/lib` 目录下的 `jar` 包中的类。

### 2.3 LaunchedURLClassLoader

LaunchedURLClassLoader 是 `spring-boot-loader` 项目自定义的**类加载器**,实现对 `jar` 包中 `META-INF/classes` 目录下的**类**和 `META-INF/lib` 内嵌的 `jar` 包中的**类**的**加载**。

```java

public class LaunchedURLClassLoader extends URLClassLoader {

public LaunchedURLClassLoader(URL[] urls, ClassLoader parent) {

super(urls, parent);

}

}

```

- 第一个参数 `urls`,使用的是 Archive 集合对应的 URL 地址们,从而告诉 LaunchedURLClassLoader 读取 `jar` 的**地址**。

- 第二个参数 `parent`,设置 LaunchedURLClassLoader 的**父**加载器。这里后续胖友可以理解下,类加载器的**双亲委派模型**,这里就拓展开了。

LaunchedURLClassLoader 的实现代码并不多,我们主要来看看它是如何从 `jar` 包中加载类的。核心如下图所示:

<img src="https://img-blog.csdnimg.cn/img_convert/0b51304c325f7b929238886e205113f9.png" width="65%"/>

- `<1>` 处,在通过**父类(URLClassLoader )** 的 `#getPackage(String name)` 方法获取不到指定类所在的包时,**会通过遍历 `urls` 数组,从 `jar` 包中加载类所在的包**。当找到包时,会调用 `URLClassLoader#definePackage(String name, Manifest man, URL url)` 方法,设置包所在的 **Archive** 对应的 `url`。

- `<2>` 处,调用**父类(URLClassLoader )** 的 `#loadClass(String name, boolean resolve)` 方法,加载对应的类。

如此,我们就实现了通过 LaunchedURLClassLoader 加载 `jar` 包中内嵌的类。

## 3、launch

> 友情提示:对应 `launch(args, getMainClass(), classLoader)` 代码段,不要迷路。

### 3.1 getMainClass

首先,我们先来看看`#getMainClass()` 方法,它是由 ExecutableArchiveLauncher 所实现,代码如下:

```java

// ExecutableArchiveLauncher.java

@Override

protected String getMainClass() throws Exception {

// 获得启动的类的全名

Manifest manifest = this.archive.getManifest();

String mainClass = null;

if (manifest != null) {

mainClass = manifest.getMainAttributes().getValue("Start-Class");

}

if (mainClass == null) {

throw new IllegalStateException(

"No 'Start-Class' manifest entry specified in " + this);

}

return mainClass;

}

```

从 `jar` 包的 `MANIFEST.MF` 文件的 `Start-Class` 配置项,,获得我们设置的 Spring Boot 的**主**启动类。

### 3.2 createMainMethodRunner

然后,我们再来看看 `#launch()` 方法,它是由 Launcher 所实现,代码如下:

```java

protected void launch(String[] args, String mainClass, ClassLoader classLoader)

throws Exception {

// <1> 设置 LaunchedURLClassLoader 作为类加载器

Thread.currentThread().setContextClassLoader(classLoader);

// <2> 创建 MainMethodRunner 对象,并执行 run 方法,启动 Spring Boot 应用

createMainMethodRunner(mainClass, args, classLoader).run();

}

```

该方法负责最终的 Spring Boot 应用真正的**启动**。

- `<1>` 处:设置 createClassLoader 创建的 LaunchedURLClassLoader 作为类加载器,从而保证能够从 `jar` 加载到相应的类。

- `<2>` 处,调用 `#createMainMethodRunner(String mainClass, String[] args, ClassLoader classLoader)` 方法,创建 MainMethodRunner 对象,并执行其 `#run()` 方法来启动 Spring Boot 应用。

下面,我们来看看 **MainMethodRunner** 类,负责 Spring Boot 应用的启动。代码如下:

```java

public class MainMethodRunner {

private final String mainClassName;

private final String[] args;

/**

* Create a new {@link MainMethodRunner} instance.

* @param mainClass the main class

* @param args incoming arguments

*/

public MainMethodRunner(String mainClass, String[] args) {

this.mainClassName = mainClass;

this.args = (args != null) ? args.clone() : null;

}

public void run() throws Exception {

// <1> 加载 Spring Boot

Class<?> mainClass = Thread.currentThread().getContextClassLoader().loadClass(this.mainClassName);

// <2> 反射调用 main 方法

Method mainMethod = mainClass.getDeclaredMethod("main", String[].class);

mainMethod.invoke(null, new Object[] { this.args });

}

}

```

- `<1>` 处:通过 LaunchedURLClassLoader 类加载器,加载到我们设置的 Spring Boot 的主启动类。

- `<2>` 处:通过**反射**调用主启动类的 `#main(String[] args)` 方法,启动 Spring Boot 应用。这里也告诉了我们答案,为什么我们通过编写一个带有 `#main(String[] args)` 方法的类,就能够启动 Spring Boot 应用。

# 小结

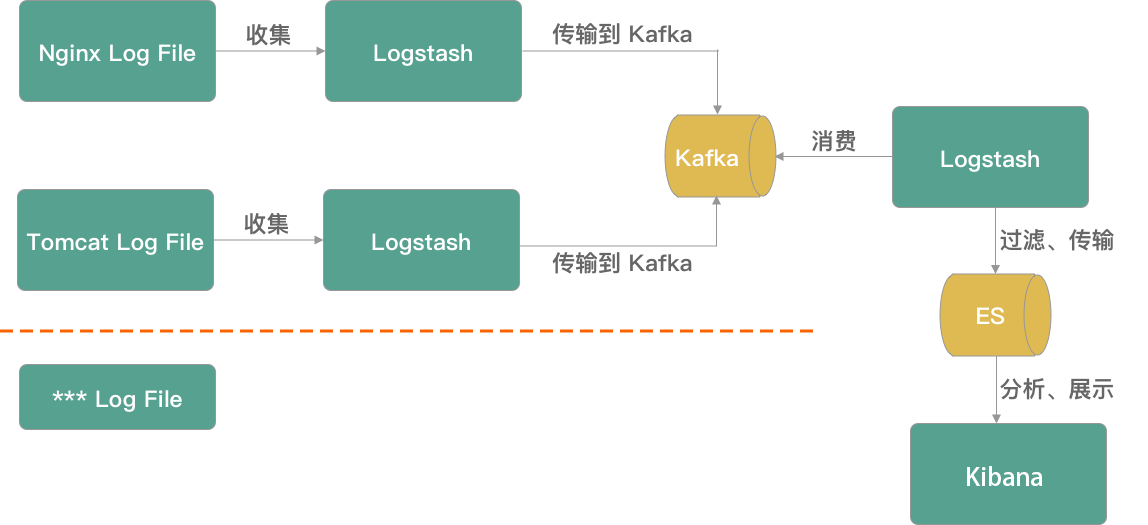

总体来说,Spring Boot `jar` 启动的原理是非常清晰的,整体如下图所示:

[](http://www.iocoder.cn/images/Spring-Boot/2019-01-07/30.png)Spring Boot `jar` 启动原理

**红色**部分,解决 `jar` 包中的**类加载**问题:

- 通过 Archive ,实现 `jar` 包的**遍历**,将 `META-INF/classes` 目录和 `META-INF/lib` 的每一个内嵌的 `jar` 解析成一个 Archive 对象。

- 通过 Handler,处理 `jar:` 协议的 URL 的资源**读取**,也就是读取了每个 Archive 里的内容。

- 通过 LaunchedURLClassLoade,实现 `META-INF/classes` 目录下的类和 `META-INF/classes` 目录下内嵌的 `jar` 包中的类的加载。具体的 URL 来源,是通过 Archive 提供;具体 URL 的读取,是通过 Handler 提供。

**橘色**部分,解决 Spring Boot 应用的**启动**问题:

- 通过 MainMethodRunner ,实现 Spring Boot 应用的启动类的执行。

当然,上述的一切都是通过 Launcher 来完成引导和启动,通过 `MANIFEST.MF` 进行具体配置。 | 17,421 | Apache-2.0 |

# 2021-08-30

共 19 条

<!-- BEGIN -->

<!-- 最后更新时间 Mon Aug 30 2021 23:06:31 GMT+0800 (China Standard Time) -->

1. [《扫黑风暴》导演亲自答](https://www.zhihu.com/search?q=扫黑风暴)

1. [前妻指控李阳家暴女儿](https://www.zhihu.com/search?q=李阳家暴)

1. [前国际奥委会主席罗格去世](https://www.zhihu.com/search?q=罗格)

1. [电影《失控玩家》](https://www.zhihu.com/search?q=失控玩家)

1. [《理想之城》主演亲自答](https://www.zhihu.com/search?q=理想之城)

1. [EDG 晋级 LPL 总决赛](https://www.zhihu.com/search?q=EDG)

1. [华夏航空一航班冲出跑道](https://www.zhihu.com/search?q=华夏航空)

1. [斗破苍穹第四季 24 集](https://www.zhihu.com/search?q=斗破苍穹)

1. [教育部要求不得设置重点班](https://www.zhihu.com/search?q=重点班)

1. [华为海外发布 EMUI 12](https://www.zhihu.com/search?q=华为 EMUI12)

1. [QGhappy 世冠杯夺冠](https://www.zhihu.com/search?q=QGhappy)

1. [QQ 音乐限制专辑重复购买](https://www.zhihu.com/search?q=QQ音乐)

1. [DK 战胜 T1 LCK 夏季赛夺冠](https://www.zhihu.com/search?q=DK)

1. [梅西上演巴黎首秀](https://www.zhihu.com/search?q=梅西)

1. [残奥会中国队被取消一金一银](https://www.zhihu.com/search?q=残奥会)

1. [吴谢宇不服死刑判决](https://www.zhihu.com/search?q=吴谢宇)

1. [全国网游用户锐减](https://www.zhihu.com/search?q=网络游戏)

1. [《光恋》齐司礼生日卡](https://www.zhihu.com/search?q=光与夜之恋)

1. [媒体发文批评游戏圈](https://www.zhihu.com/search?q=手机游戏)

<!-- END --> | 1,156 | MIT |

---

layout: post

title: How to seek job?

subtitle:

author: tanchao

date: 2016-08-10 20:56:17 +0800

categories: career

tags: career

---

# 关于找工作

以下内容转载自:[***Random Mumble***](http://randommumble.blogspot.com/),初衷是方便国内朋友浏览。

如有不便请与我联系删除,谢谢。

感谢原作者分享!

以及一些我现在(2016-08-10)的理解和建议({==黄底==})

不知为何MD渲染和我想象的不一致,还是有道云笔记吧,看[这里](http://note.youdao.com/share/?id=9f205f59f0f0fb0c825730f81dfa37f9&type=note)

## BEGIN

---

---

---

## 关于找工作(〇 前言)

== 此文原发于mitbbs的jobhunting版。我的原创,并非转载。 ==

先声明一下,纯属个人经验,不负法律责任的啊 — 开玩笑了,当然不会故意误导的。会不会是象国内的某些记者一样,拿着不知道哪儿捡来的破烂当宝贝?有这个可能,但是可能性不大。至少不会是故意编瞎话骗人。

说起来是有不少经验/想法的,估计一次也说不完,想到哪儿说到哪儿吧。按老美的习惯,先给个提纲(agenda):

1. 简历

2. cover letter (对不起,实在不知道中文怎么说。丢人啊,邯郸学步的当代版)

3. 面试

4. 找工作期间(有点倒叙了。原因以后解释 — 怕挨砖)。

还是按照老美的习惯,讲正题前先跑题 — 背景知识(background).

(谁在扔鸡蛋?在老美的地头混,不学老美的门路,怎么去和老美斗?)

俺的“理论”可是科班,去老美的一个帮助找工作(outplacement, career placement)的公司,认认真真学来的。当然了,学习班里什么样的人都有,教练教的要顾及多数人,很多和俺的工程师背景不适用,所以俺也就基本上是左耳进右耳出了。有些有印象的,还是会提一提的,毕竟不是所有人都是工程师。

## 关于找工作(一 简历【之一】)

首先澄清一下,resume 和CV都是简历,名字不同,用处不同,写法也不一样。各位(特别是离开学校不太久的)先看一看自己的简历,是不是既可以当resume用,也可以当cv用?或者你根本分不清这两个有什么区别?如果答案是是的话,恭喜你,你找工作的第一个大障碍已经找到了。现在可以把你的简历扔到垃圾桶里了。

那么,resume和cv有什么区别?要总结出区别,挺不容易说清楚的。从用处上说吧,如果你要找工业界的工作,你需要resume; 如果找学校,国家实验室的科研工作,你需要cv。 那么如果是工业界的研发呢?多数情况下,你需要resume。(我其实想说绝大多数情况下的,怕有人鄙视我 — 你才见过多少世面?)

明确了这个,俺就讲一讲resume的写法吧。

resume第一个要求:短。一页纸最好,不过估计大家都是经验累累,成绩硕硕的,一页

纸大概不够。那就两页吧,不过主要内容要在第一页上。什么?两页还不够,您老人家实在是比俺还唐僧。那些自我评定留着到面试时和老美/老印昏天黑地地胡侃再用吧。

为什么要短?因为有调查,绝大多数的简历是先被人事部(Human Resource, HR)的审核。又有调查,HR平均只花20秒看一份简历。您老人家的简历那么长,就算有拿诺贝尔奖的实力,HR的人有时间看么?(且不说他/她能不能看懂)。更何况,他/她把你这么优秀的候选人(candidate)错误地毙掉了,他/她会有什么损失吗?

长度限制住了,字体呢?俺的一点小诀窍:如果你是用word之类的软件准备的resume (

这点后面会讲), 先把字体换了。大家都用一样的sans serif,HR的人也会审美疲劳不是。用什么字体,有一个不二之选:==Garamond==. 为什么?先把你的换了,你就知道为什么了。

附带声明,Garamond (其实是一个修正版的)在苹果的地位相当于==MS sans serif== 在微软的地位。俺不是果轮,不过喜欢苹果的MacOS/OSX胜过喜欢微软的windows倒是事实。

其实还有一个技术原因:有一些公司用OCR(又邯郸学步了),Garamond一定会兼容,别的字体不一定。– 还是那个老问题,如果HR的人要多在你的简历上费工夫(而且不是一点半点–你能指望HR的人计算机玩的多溜?),你自己掂量一下你的机会吧。{==字体不兼容的话会转换为默认字体,所以不要使用自己喜欢的但是小众的字体,除非你准备发pdf版本==}

字体有了,大小呢?间距呢?==正文大小以11号为宜==,实在紧张用10号。再小了费眼,大

了吓人。一段的==标题(section titles)用12号==,你的==名字用14号==。间距是单行就行,但是段与段之间一定要空行,而且每段不要超过4行。同样的原则,不能累着HR的先生/小姐/叔叔/阿姨/。。。{==我个人的习惯是不空行,完全靠调节段落格式前后间距来负责空间美╮(╯_╰)╭==}

## 关于找工作(一 简历【之二】)

要写resume,得用软件吧。基本上只有一个选择:office (word) 2003。有人会说了,那破玩意,早淘汰了。我用office 2007/2010, openoffice, latex, 等等等等,或者我保存为pdf。我的意见:word 是烂,但没办法。为什么?

1. 很多公司还在用office 2003,不是因为没钱,而是公司的软件通常都要落后一些。想想吧,一个公司至少几十台机器,赶潮流升级了,出了虫子(bug)不得把IT的人累死?office 2007的文件也许能用office 2003打开(得安装一个程序包),但你愿意不愿意用你的工作机会去试一试?有一点基本可以保证,如果HR的人打不开你的文件,哪怕坐他/她旁边的人能毫不费力的打开,你的机会也差不多到头了。

2. 很多公司存电子文件,只接受.doc文件。

3. 很多时候(特别是通过recruiter的时候),他们要修改一下你的简历的,最常见的是

删去你的通信方式。原因不一,比如避免公司绕过recruiter直接去和候选人谈(这样

recruiter就赚不到钱了), 或者公司的规定(避免地域歧视)。{==doc不会错的不过现在docx也没有什么问题毕竟又过去很多年了Windows都10了==}

## 关于找工作(一 简历 【之三】)

下面开始详细解释resume的写法。请参考(随机找来的)样板 — google image 搜索”resume sample”,第一个结果,http://www.resume-resource.com/exleg3.html。 我们只用格式,不用它的内容。

1. 名字:

14号字, 全大写,第一个字母大一些(不是你手动调大的,word里==格式选all capital==,你原来大写的字母会比原来是小写的个头大一些)。

如果你的名老美很难念(是念不出来,念得准不准没关系,你知道是找你的就行),可以加一个英文名,用引号括起来。比如,ZUXIE “SOCCER” QU。 加引号是告诉他们那部分在正式文件里是没有的,免得HR的人用你的”全名“去调查,调查出一个”查无此人“。

名字后面加不加头衔(PH.D., MBA, RN什么的),取决于要申请的位置有没有明确要求某一个学位。通常说起来,加不加都一般没什么大问题,但以不加更保险一些。

名字的下面(样板里地址的地方),如果你有绿卡/公民,可以写上(11号字, 斜体,可能需要bold)”US Permanent Resident” /“US Citizen”。当然如果您老人家已经把名字改了,就不必了。

(不是哪个学校有位中国人教授就给自己起了一个完全美式的名字?–以前看到的,细节不记得了。谁给考考古?)

2. 下一行,电话,地址,email:

11号字,照抄样板的格式就行。 注意”telephone”, ”address”, “email” 这些词完全不出现,因为谁也不会把niuren@hotmail.com当成电话号码。

电话建议留8AM-6PM开机的手机。如果你的手机比较忙(朋友多,或者忙着谈恋爱),建议去搞一个prepaid的。个人推荐, 如果可以找到闲置的verizon的手机,所在地verizon的信号也好的话,买pagepluscellular的卡(号),价格便宜量又足。[Edit Aug/2010: apparently there have been some changes that make my recommendations invalid. Please check this blog for (hopefully ) up-to-date recommendations. http://blog.wenxuecity.com/myindex.php?blogID=46849 ]强烈不建议买verizon或者ATT的prepaid (太贵)。

email建议用私人的(gmail之类)。==新申请一个专门用来找工作==比较好。你如果是在用gmail (web interface),可以设置自动去取别的新开的信箱的信,这样就不用换来换去了。

地址用家庭地址,强烈不建议用工作/学校的地址。如果不想列出具体的门牌号,可以去邮局租一个信箱,没多少钱的。和手机,email一样,专门用来找工作,比较容易管理。

3.下一行,一条贯穿文本宽度的线 ,单的双的都可以。怎么搞出来?google is your friend.

{==连续输入三个-或者=如---然后敲回车看看==}

## 关于找工作(一 简历 【之四】)

最重要的一块来了,睡觉的同学醒一醒。

4. 下面是正文了。第一块: qualification,但是不要标题行(样板里的 “QUALIFICATION”)。 为什么?脱裤子放P,浪费宝贵的空间。更重要的是,HR的人要多看一行没用的东东。这一段怎么写?说难也难,说容易也容易,因为基本上是八股文。

有同学问了:objective一段哪儿去了?答案很简单,不需要。因为也是脱裤子放P的事(后面讲到cover letter的时候会讲如何放这个P。 cover letter会在resume的前面,所以resume就不需要再重复了。– 以老美的唐僧风格,这实在是难得。)有一个HR的 VP(老美)告诉我,有objective的简历,或者出自在校学生之手,或者是古董级的简历。不管是哪个,都反映了简历的作者对自己职业发展及其重要的文档都没下够工夫。”The objective section has been unnecessary for at least ten years. Having it in the resume does nothing more than leaving a somewhat negative impression.”

那么qualification这一块到底怎么写呢?给个样板(独家产品,转载请付版税):

第一句:先把招工广告上的职位(比如,senior nuclear engineer) 抄上。在前面加上“评价”自己的褒义词。什么褒义词?什么好听说什么,experienced (这个慎重,不是不好,而是因为后面还要经常用experience这个词,会“撞车”,读起来不顺), motived, diligent, proven, 等等, 自己网上找吧。然后,

后面加 with 100 years of experience in nuclear bomb making之类的自我吹嘘, 具体语言请参照老印的简历 – 瞧不起老印?人家老印绝对是这方面的专家。

细心的会注意到这不是一句话,只是一个短语。对了,要的就是短语。后面几句也是。

第二句,第三句,甚至第四句,全都差不多,注意和招工广告对应上。给个例子:excellent hands-on skills building an atomic bomb from dog poo.

要点有三:1. 要敢于给自已客观的,正确的,不谦虚的评价。怎么样才算合格?这么说吧,只要没说“地球离了我不转”都不算太过分。2.长度要合适,总共四行,可以少一行,不可以多。即, 每一句都是控制在短于一行或者一行多一点点的长度。排版是要两头对齐。3. 要敢于用demonstrated, proven, exceptional 此类的形容词。

从一定程度上讲,你能不能通过/混过HR这一关,一大半在这一段上面。你的目标是15秒之内把他/她忽悠晕。有一个简单的测试方法:找一个不太熟的人,最好也不懂你的专业,(朋友的朋友)让他/她看30秒你的简历,然后把简历收回来,开始问问题,看看他/她能对这一段的内容有多少印象。

如果招工广告上有非常详细的要求(软件啦[office这样的大路货就算了],仪器啦),可以跟上一个小列表(bullet list),三到四项。比如:50 years of solid experience operating dog-poop-scooping machines.

又有人要问了:你总提招工广告,岂不是每个广告的写一份???我没说一份简历打天下吧。每个广告一份简历看起来挺罗嗦的,其实没什么。你只要能捣鼓出第一份,剩下的照猫画虎就是了。

补充一点:关于评价自己:对学生而言,要强调well-trained, diligent/hard-working, proactive (不要直接用这个词,想办法表述出来你学习的风格不是老板指哪儿才打哪儿), 以及wide range of knowledge (举个例子吧,如果你学的是机械, 可以强调你还懂材料,电子,甚至物理,化学,当然这些要和你的本行相关)。有工作经验的人,要强调这些方面:hands-on (特别是如果你的背景偏理论和数值),motivated, customer-driven, result-driven, versatile, team-work, leadership(如果找比较高的位置 — technical leadership也是leadership)。

{==注意到区分对待!!!有没有工作经验和**不是**一份简历打天下==}

## 关于找工作(一 简历 【之五】)

5. 下一块:EXPERIENCE。只要这个词就好了,样板里的PROFESSIONAL EXPERIENCE有脱裤子放P之嫌。有不是应召做男朋友/女朋友/老公/老婆/女婿/媳妇,谁关心你的PERSONAL EXPERIENCE?

如果你是在校或者刚毕业的学生找工业界的工作,建议你把这一块放在EDUCATION的前面,除非你在学校里只上课,别的什么都没干。如果你已经有工作经验。。。没有商量的余地。

EXPERIENCE (还有后面的EDUCATION)要按时间==倒叙==(最近的经历在最前面)。格式可以照抄样板的。基本上是这个样:

职称(Nuclear Scientist), 11号字,斜体,黑体, 左对齐。

另起一行,左对齐,公司/学校, 镇子, 州。比如, ATOMIC DOGPOO INC, Dogtown, DG, 11号, 大小写照样板来。

同一行,右对齐,开始-结束。 比如, 1900-Present. 只列年份就可以。

有同学说了,俺的经验太牛,在一个公司被提升了5次,怎搞?答案:您的位置那么高了,还来听俺罗嗦,what’s wrong with you? –开玩笑的,别见怪。对你的情况,如果位置是类似的, 建议合并到一起。比如变成这样: Junior Nuclear Scientist (1900-1910), Senior Nuclear Scientist (1910 – 1950), Super-senior Nuclear Scientist (1950 – present).

之下的内容就有门道了,先留点悬念,请仔细研究样板里的EXPERIENCE有什么最大的特点?

答案是– 每一条都是以动词开始的。其实样板并不很好,更好的应该是以动词的过去时开始,因为现在时可以理解成工作任务的描述,不代表你一定做过。

用动词有什么意义?这得从简历的目的说起。公司看简历的目的是什么?一个非常非常重要的原因是看你过去做过什么。注意,关键词是“做过”, 不是“什么”。中国人习惯强调“什么”,因为做的怎么样是不言而喻的,谁愿意哪壶不开提哪壶啊?可是老美不一样,你不说自己做的好我怎么知道你做的好啊?(唐僧的传人)所以一定要强调”做过”(所以是过去时)。

另一个要点(样板里体现的不好),要==强调结果==, 因为公司找你是要解决问题赚钱的。你做得再漂亮,不解决实际问题也没用。至于怎么做的,在面试前基本上没人关心。(等你去工作以后,就更没有人关心了)

要点明确了,怎么做呢?和QUALIFICATION那段差不多,要用(老美的说法)“powerful keywords”。哪些算呢?developed, advanced, solved, improved, reduced (cost), organized, led。 那些不算呢?worked (废话,你拿了公司/学校的钱,当然要干活了), studied, served, collaborated, supported (除非你要找非常低的位置或者秘书之类的工作), contributed(基本没用)。有点概念了没有?

有同学反映了:我刚毕业没多久, 没什么好说的。其实工作过的很多人也一样(包括我),因为很多工作每天就是固定的程序 — 太新的东西不容易带来直接经济效益,而公司的第一目标是要赚钱的,所以稳定自然是第一位的了。我坚决反对无中生有(万一面试遇上明白人,你能拿到的工作也拿不到了),但是建议大家要学会从无聊的工作里找到闪光点。 对工作的人来说,这个工作给公司带来了什么效益(不一定是直接的金钱,当然如果是的话更好)。举个例子吧,也许你琢磨出来的小改进让一个零件的成本降低1毛钱(没什么吧),可是公司一年要生产1000万个,你就可以说reduced annual cost by $1Million(厉害不?),或者产量只有10个,可是原来的成本是4毛,你可是reduced cost of the critical part by 25% (那个零件到底是不是critical, 谁能核实?)。【 这里有一个不太诚实的招数(我学的),如果你有大概的印象/估计,凑一个偏大的数。因为牵扯到钱(商业秘密),具体数是没法核实的。而对你的简历而言,有实际数字绝对是很有说服力的。一点警告,别吹的过头,让人家揪着小辫子你就完蛋了。】试着从赞助你做那个项目的公司的管理层想一想,他们为什么愿意花这个钱?找到了这个原因,你也就知道该怎么写了。 {==请认真体会领悟贯彻本段==}

对还在学校/刚离开学校的人来说,好像又跑题了。我打包票:没有。学校里也是一样的,你老板能搞到钱,还是有原因的。什么?老板当初就是不知道怎么骗来钱的?那也没关系,去和老板聊聊,别太露骨的问问“如果那个项目成功了,会有什么样的应用?”是啊,项目还没完呢/已经给废了,可是你的工作不也推进了项目的进展吗?无论多么难看的工作,闪光点总是有的,就看你能不能发掘出来了。我见过的最牛的,是实验做了三年,试验了n种方法,没有一种成功。结果老哥(老美)写的是”comprehensively evaluated existing experimental techniques on … and demonstrated the necessity for developing technology in new directions”, 还被认为是”very impressive work”,拿到了工作。

另外一个问题:对学生而言,列什么项目?很简单,所有和专业相关的,只有不是那么课的学期论文,都可以列,哪怕是你只给老板帮忙了一个星期。为什么不列学期论文?原因是为未来的面试未雨绸缪:万一被问出来是学期论文,你想问你的人郁闷不郁闷?(既然问你,自然是对那个项目有兴趣了)

当然凡事都不是绝对的(impossible is nothing, 呵呵),如果你实在想列,也不是完全不能,只是要慎重,做好被穷追猛打的准备。学期论文的问题主要有两个:1.缺乏实际意义; 2. 为了应付工事。如果你能把这两点的回答准备好,尽管列。给你一点提示吧:如果论文来自于实际问题(比如,分析911世贸大楼倒掉的工程原因)或科研课题,要抓住这一点狠强调。如果是用来练手的题目,得好好琢磨琢磨怎么说怎么这么花费了远超过课程要求的精力去做的。

好了,现在去总结分析你过去若干年有多牛了吧。打开你的简历草稿,往多里列,目标:至少填满一个纸。什么?不是说简历最好一页吗?这么多哪放得下?不用担心,现在是草稿, 先列出来以后再根据需要筛选。

EXPERIENCE这一块是简历里最最重要的一部分,因为一个公司要了解你,差不多唯一的方法就是看你做过什么。这么说吧,能不能过recruiter/HR那一个基本上靠QUALIFICATION,而能不能过技术方面的第一关基本上靠EXPERIENCE。所以,EXPERIENCE 要占简历总长度的30-50%(甚至更长)。

## 关于找工作(一 简历 【之六】)

6. 下一块:PATENTS。这一块不是必须的,因为多数人都没有专利,但是如果你有的话,把它提到前面来。为什么?一个字,钱。别忘了,公司找你是为了赚更多的钱的。你有专利,至少说明了几个事实:1. 你有创造力; 2. 你的创造力有经济意义。 要知道,申请专利是一个费时费钱的事,如果没有潜在的经济效益,公司是不会去费那事的。

有工作过的同学问了:Invention disclosure算不算?回答这个问题之前,我们先给不知道invention disclosure是什么东东的同学解释一下。所谓的invention disclosure, 通常是公司为了留下“原创”性的工作的法律依据,而要求职工提交给公司的律师的文件。一项发明/改进能不能申请专利,你说了不算,我说了也不算,得律师说了才算。所以很多公司都鼓励职工写invention disclosure,甚至把invention disclosure和业绩/奖金挂钩。对公司来说,invention disclosure变不成专利申请通常不会损失什么,可是如果漏掉了专利,可亏大发了。所以公司的政策常常是宁可错交3000,不可漏过一个。这种情况下,你说invention disclosure的意义大不大?

7. 再下一块:AWARDS。这下许多同学高兴了:这玩意,咱哥们多的是。抱歉,多数(比如奖学金什么的)恐怕没什么用。但是如果你有全国性的奖,哪怕是针对每个行业的,一定要列出来。简单的标准,如果奖项牵扯到多个学校/公司,基本上可以算。为什么?因为那说明你的成绩得到了同行的认可,不是一般的牛。所以如果有同学得过,比如说,美国化学会的最佳论文, 千万不要谦虚。

好了,容易让人郁闷的两块过去了,可以开讲每个人都得写的部分了。

7a. 再下一个:CERTIFICATION, 如果你有什么相关的认证的话。

## 关于找工作(一 简历 【之七】)

8. 最常见(基本上每份简历里都有)也容易是最没用的部分来了:EDUCATION.

差不多没干招工广告的第一条都是关于学位要求的,而且HR的人在怎么忽略 你的简历,总要看一看你的出身是什么。不是俺搞出身论,牛校出来的人就是要占一些便宜,这是没办法的事。那为什么说这一部分容易是最没用的部分?

请您看看你的简历,是不是这样的?

Ph.D, Web Posting, University of Nowhere, Some Town, SomeState, 2000

Advisor: Professor Post A. Lot

Thesie/Dissertation: On How to Create 1,000,000 Posts in an hour

差不多? 你刚刚浪费了HR的给你的宝贵的20秒里的1/3.为什么说是浪费了?因为由于的信息只有第一行。剩下的部分对HR的人来说就是天书,对管技术的呢?也基本上是天书。这又为什么?

先说ADVISOR。测试:10秒钟,列举你所在一行的排前五位的大牛。有多少人能说出来?恐怕多数人都做不到吧。所以如果你的老板不是Albert Einstein这样的牛人+名人,你其实完全可以说你的老板是Professor Random Mumble, 效果是差不多的。什么?你的老板就是本行业的前五名的大牛?那么只有两种情况你要列出老板的名字:1. 你要去的公司做的东东刚好是你老板出名的领域(你还是得先搞清楚那个公司技术上把关的人和你老板不是对头 — 文人相轻的事不是只有中国才有); 2. 能影响是否招你的人是你老板的本人/fan/学生/哥们/朋友/小舅子(这个好像也不太安全)– 如果是这种情况,你也不需要靠resume去通关,有更有效的方法(以后再讲)。

再说论文:不客气的说,完全(100%)没有用处。ADVISOR至少还有可能因为name recognition给你帮点忙,论文的题目只能浪费所有人的时间。说的难听点,你的学位已经拿/骗(比如我)到手了,学位论文的历史使命也就结束了。

那么EDUCATION到底要写成什么样?有三个版本:

版本一(适用于有若干(>5)年经验的老油条):

Ph.D. in Web Posting, 2005, University of Internet, Cybertown, Cyberstate

M.S. in Web Posting, 2001, University of Internet, Cybertown, Cyberstate

B.S. in Goofing Around, 2000, University of Nowhere, Notown, China

版本二(适用于有 < 5年经验的新鲜油条):

Ph.D. in Web Posting, 2005, University of Internet, Cybertown, Cyberstate

research was focused on developing new methods to create 1,000,000 posts in a day.

M.S. in Web Posting, 2001, University of Internet, Cybertown, Cyberstate

thesis work/research was focused on….

B.S. in Goofing Around, 2000, University of Nowhere, Notown, China

concentration: playing video games all day long

版本三(适用于没有经验的生油条):

Ph.D. in Web Posting, 2005, University of Internet, Cybertown, Cyberstate GPA= 4.0

research was focused on …..

responsible for maintaining the … equipment in the xxx Lab. (put a couple [1- 3] descriptions of your activities besides taking courses)

M.S. in Web Posting, 2001, University of Internet, Cybertown, Cyberstate GPA= 3.9

thesis work/research was focused on….

responsible for maintaining the … equipment in the xxx Lab. (put a couple [1- 3] descriptions of your activities besides taking courses — do not resue what you mentioned already)

B.S. in Goofing Around, 2000, University of Nowhere, City, China GPA= 0.1

concentration: playing video games all day long

格式注意: 1. 学位 (不包括专业)和年份是黑体; 2. 注意没有学校的zip和具体的地址; 3. 如果是中国的学校,不要列省/自治区; 4. GPA=xxx右对齐。

有同学提了:我读博士/硕士期间做的东西就不提了?要提, 但不是这儿,应该是在EXPERIENCE里(你的头衔是research assistant).

## 关于找工作(一 简历 【之八】)

到这儿,你的简历就差不多了。如果你有论文,可以加一小节 SELECTED PUBLICATIONS,列1到3篇, 最好是在比较牛的杂志上的。

不要有的部分:Objective(已经讲过了), Interests/Hobbies/etc (没人关心,而且与你的工作基本无关。唯一的例外是如果你是跑马拉松的, 想办法把这一条塞到什么地方去 — 公司里的人往往有家有业,没多少时间参加体育活动,所以最流行的锻炼方式是跑步。如果你是跑马拉松的,说好听的是反映了你这个人有毅力,实际的情况是遇上被共鸣的机会比较多。), references (所有人都是“available upon request”)。

草稿弄好了,下一步怎么办?存文件。把你的文件名命名为 ZUQUO-SOCCER-QU-SR-NUCLEAR-ENGR-ALQAEDA.DOC. 即, 你的名字-工作位置-公司名字。其中,公司名(Al Qaeda)是给你看的,剩下的是给HR准备的 — 设想一下,HR的计算机某个文件夹里有20个my resume.doc, 头大不大?他/她的头大了,拿谁出气?

然后,开始读。一个词一个词的读,坚决断绝拼写错,语法错,单复数错,时态错之类的小问题。自己读(每天吃饭前读一遍),发动所以能发动的人读(老婆/老公/女朋友/男朋友, 同学,朋友),最好能找到native speaker帮你读(可以贿赂顿饭什么的),但是不建议找不认识的人(因为不太会用心)。

然后,就是改。刚开始时改得面目全非是很正常的。总要有三五七八个(不是三千五百七十八)版本才会基本定型。然后就可以广而告之了。如何广而告之后面再讲。

关于找工作(一 简历 【之九】)

讲了这么多写resume的细节,有没有体会出最根本的指导思想是什么?

其实说出来很简单 — 当然对新毕业/还在校的同学来说,这有点难 –要给公司一个==雇你的理由==。算一算经济账吧,公司雇一个人(professional)的开支大概是所付工资的1.5倍(老美劳动统计局的数据,http://www.bls.gov/news.release/ecec.t01.htm),如果你不能给公司赚回这么多钱,公司为什么要雇你?所以当你读你的resume的时候,这个问题要时时响在你的耳边:我过去的经历能不能说服他们我有足够的能力给公司带来好处?记住这儿的关键词是“==过去的经历==”– 公司不是NBA, 靠potential是找不到工作的。

这一点搞清楚,写cv也就不是很难了。想一想,看cv的人需要什么样的人? 当然是能做科研的。所以和科研相关的东西就需要突出了(你如果要找工业界的工作,强调科研很容易把别人吓着)。具体表现在哪儿呢?(我所接触的科研类的工作,基本上都要求有博士学位,所以我的看法就限于那个范围了)

1. 博士论文做的是什么?老板是谁?这个有点不合理,但是没办法:如果你的老板牛/人气广,你的机会要好得多。

2. 发了什么论文?什么样的杂志?被引用多少次?

这两条决定了你的cv和resume要有本质的不同:resume里education和publication是尽量精简,而cv里这两块要详细。

那么如果你的“出身”不是很好怎么办?很遗憾,这个世界不公平,不过你的机会也不是没有。因为多数情况下,博士之后的科研与博士论文不是完全一样的。所以出身固然重要,更重要的是你所受的做科研的训练。怎么在CV中体现出你受了良好的训练?一个重要的部分是experience。 这儿,和resume 又不一样了:resume要强调解决实际问题,强调结果; cv要强调的是怎么做的,具体说就是你琢磨出了什么新鲜独门的招数。说到招数,给个开武馆的类别吧:工业界要找到相对于武馆的工作人员,打群架是要好用;科研圈子要找到是武馆的正式弟子,基本套路要熟,最有吸引力的还是有开创新局面能力的好苗子。(日月神教这样的不算数)

具体的细节就不讲了(我也讲不好 –经历有限)。

一个小建议:如果你还和你的老板/导师有联系,建议你找机会(一起喝个咖啡什么的)和老板好好谈一谈,一个重要的方面是让老板不客气地评价一下你的学术水平,毕竟你老板见过的世面比你多多了。知道了自己的弱项,现补可能来不及了,但是你在面谈的时候可以有意识的避开那些方面–能读出Ph.D.的,学术上都是有两把刷子的,可别哪壶不开提哪壶。

最后明确一下工业界/科研圈子的分类(好象应该在最前面):通常说起来,学校(如果你去做教授/postdoc/research scientist), 国家实验室基本上都是科研圈子,工业界大多数是工业界(废话)/非学术圈子。有几个注意的:

1. 大公司的研发不一定是科研圈子(因公司而异),甚至有的公司的研发的不同部门定位都不一样。这个没有一刀切的标准,只有你自己想办法去打听了(有一个不一定管用的方法:看他们的论文多少。说不一定管用是因为很多公司【有可能是大多数】是基本不允许发文章的 –牵涉到公司的商业机密)。

2.好象药厂的研发部门普遍都是要有postdoc经历的。我道听途说,不负法律责任啊。

3.有些公司(比如consulting公司)看起来不起眼,research其实是很牛的。如果你申请他们的工作,做好被问的稀里哗啦的准备(因为那儿的人虽然未必是牛人,但在他/她所做的一块去很有可能是非常的牛,基本上对没在那个题目上下过大工夫/有过相当的经验的人是见一个灭一个)。

罗里八嗦写了这么长,希望能对你准备简历有一点帮助。基于我的经验,你去outplacement/career placement公司培训,或者找专业写手,他们能给你的也就这么多了。所以如果你原来有这方面的预算,我有一个小小的建议:把预算的90%留给你自己,剩下的10%拿去帮助需要帮助的人。如果你现在是处于骑驴找马的阶段,建议把比例变成75%/25%. 如果你想不出去帮助谁,我还有两个建议:1. 海外中国教育基金会(Overseas China Education Foundation), http://www.ocef.org; 2.帮助陈伟宁的遗孀和小女儿(http://chenweining.org)。声明:我不是清华/北大的,也不认识她们。

{==虽然无须donation,请你常怀感恩之心,若能乐于助人更佳==}

## 关于找工作(二 Cover Letter)

准备好了简历,下一个文档就是cover letter了。其实对衡量你是否是一个好的候选人来说,cover letter的作用==几乎是零==(很多情况下主管技术工作的人或者雇人经理根本见不到cover letter)。那么为什么还要准备cover letter呢?答案和简历的qualification那一段差不多 — 主要目的是帮助你顺利度过/混过recruiter/HR这一关。{==这是大实话 所以内推优先 social network优先==}

写cover letter也是有固定的套路的,而且这个套路更简单(一两个字)。不过俺已经吊了大家这么长时间的胃口了,就再多吊一会儿吧。

先说说recruiter/HR是怎么衡量一个候选人的。简历里的qualification毋庸置疑是非常非常重要的,但是qualification其实还不是他们/她们的“第一印象”。第一印象是什么?就是cover letter了。这么说吧, 找工作就和(通过介绍人)找对象差不多,小伙/姑娘再好,介绍人那儿没有好印象,要再进一步也不容易吧?那么怎么留下一个好印象呢?差不多唯一的办法就是想办法减轻介绍人的工作负担了。所以俺的罗嗦一下recruiter/HR是怎么衡量一个申请人会不会的。

有一点基本可以确定,recruiter/HR对你的专业所知非常有限。可是他们/她们 也要工作不是?怎么办呢?很简单,把招工广告拿过来,把简历拿来,对照招人的要求一二三四五六七, 一条条的比较,符合一条打一个勾,最后数有多少个勾–勾越多的越好。有同学说了,你不是说他们只花20秒吗?哪有时间来一条条地过?没错,他们是没时间。大多数人根本过不了前20秒这一关,所以也不会被打勾了。那么为什么要在讲cover letter的时候提这个呢?还是一个原因:减轻recruiter/HR的工作负担。试想如果你已经替他/她老人家做了这项工作了,他/她对你的印象也会好很多不是。再说了,有些要求你马马虎虎可以算达到,也可以算没达到,你先入为主地说达到了,也多少占一些便宜吧。

好了,进入正题:cover letter 怎么写?正式书信的格式不用我提了吧(如果不清楚,去随便那个图书馆找本书信格式的书看看)。cover letter的主体有一个模式(就是我说的一两个字的样板):Q-letter。现在你知道了,网上随便google吧。我给一个我用的版本:

第一段:I am writing in response to your recent advertisement for a Nuclear Scientist (用招工广告里的title) (position opening # 12345) on your website/monster.com/careerbuilder.com/wherever(选一个,或者类似的). Based on my experience/background(选一个,或者排列组合,不要用“/”), I believe I am a good/strong candidate for the position.

简单不简单?别的什么话都不需要说,没用。

第二段:查入一个三列,4-6行的表格。左面一列(第一列), 题头(11号字,全大写, 或者变黑体)YOUR NEEDS; 右边一列(第三列), 题头MY QUALIFICATION. 第二列空着,不用。

下一行开始,左面一列,抄招工广告里的具体要求,基本上是copy&paste;右边一列,对应的你的资历。

这么 列上3-5条就可以了,再多了recruiter/HR也没空看。

然后,把表格的线/框全去掉,修改字体(表格里的字体常常和文本里的不一样),对齐,表格的宽度(总宽度比正文的宽度稍小,第二列用来调节左面和右面的距离)/高度,让这个表格看不大出来是一个表格。

第三段:Thank you for your considerations. If you would like to discuss further about my qualifications, please do not hesitate to contact me via email at (把简历里的email地址抄过来) or via telephone at 123-1234-567 (知道为什么前面建议搞一个prepaid的手机专物专用了吧?)。I look forward to talking with you.

然后, Sincerely, 空三四行(签名用),敲上你的名字(和简历里的要一致)。

有了这个样板,申请每个位置时把列表里的内容改一改就差不多了。(简历也要相应的改一下)

下一步,把cover letter和简历合成一个文件(不是压缩成一个文件啊),即第一页是cover letter, 第二(三)页是简历。用简历的文件名(参见前面讲过的文件命名方案)。

都弄好了,就可以email给recruiter了。Email很简单:

Dear Mr/Ms xxx,

I am writing … (把cover letter的第一句话抄上). Attached please find the cover letter and my resume.

Thank you.

Job Hunter

下一步,就是等鱼上钩了。

学习班里教的:cover letter里最后一句和recruiter约一个时间电话联系 I look forward to talking with you over the phone this coming Friday (大概两三天后吧)between 10 and 11 AM. 我个人不喜欢这样做,一是觉得有些唐突(如果recruiter刚好那时候忙,你这不是添乱吗?), 再者感觉没必要,反正他/她给你的时间就是20秒,你或者过关,或者不过关,有什么好废话的。如果你过关了,他/她自然会和你联系;如果你不过关,再去罗里八嗦,第一未必会改变他/她的想法,第二搞不好你就此被打入冷宫(recruiter一定会再有类似的工作机会的),那可亏大发了。

## 关于找工作(二1/2 简历/cover letter的补充说明)

前面详详细细地解释了简历和cover letter怎么写会对HR/recruiter的喜好,据说应该是有效的(俺去的那个outplacement 公司大大小小有百十号人,如果教的东东不管用,要维持下去大概也不容易吧?)。当然不管用的时候也是有的,比如公司根本不用recruiter。(俺做hiring manager的时候公司里的HR只负责把简历输入到数据库里,俺得一个一个看。虽然不至于每个只用20秒,但一个小时看个四五十是没有问题的。)那种情况下能不能过关主要靠申请人的实际经验了。可是(1)作为申请人你是无法预知你会遇到这种情况的; (2)即使是hiring manager直接看,读起来容易些也不会有副作用,所以我的建议是尽量照着模板来。也许刚开始把自己的简历改成模板的样子比较费劲,但俺的经验是后面的修改就轻松多了。

当然俺的经验毕竟有限,所以如果您有不同的意见,欢迎评论/分享。

{==俺想开发一个软件帮助这些可怜的HR分析简历,你们觉得咋样==}

## 关于找工作(二3/4 常见问题FAQ)

== 需要的话,这个帖子会不断更新 ==

Q:这些东东可靠不可靠/管用不管用?是不是楼主在闭门造车?

A: 管用不管用要你自己去试。俺的感觉还是有帮助的。大多数内容是基于俺在一个叫Right Management的公司听的课总结/抄袭下来的。如果你感兴趣,可以去他们的网站看一看http://www.right.com。据他们自己说他们是北美同类公司里最大的。俺感觉他们教的东东基本上是靠谱的,但是考虑到去听课的人什么背景都有,有些东西不是很适用,所以俺根据他们讲的主题思想发挥了一下(多数发挥都和他们的专业人士讨论过)。举个例子吧:在experience里,他们讲的要==强调结果==,举的例子是marketing方面,开发了什么什么方案拓展了多大多大的市场。对做技术的人来说,俺就给发挥成解决了什么样什么样的问题了(最好还有导致了多少多少的额外利润/生产率提高)。

Q: 这些信息对非工程师有用吗?

A: 应该是有用的。象我提起过的,我的本行是工程,所以只能提一些我觉得合理的观点。至于这些观点是不是最好?俺不知道,也不可能知道。俺费了牛劲解释为什么的原因就是希望你能触类旁通,把自己的优势放到招人的人感觉舒服的地方。

Q: 我就没见过一页的简历。。。

A: 同意你的观点。我也很少见一页的简历(特别是当申请人有研究生学位的时候)。事实上, 我的简历也是2页,但是主要的内容(qualification 和 experience 【俺的工作历史比较长,做过的东西跨度也比较大】)都在第一页上,第二页其实只要一半多一点的样子,都是不得不列的东东(education, patents, 等等)。俺的recruiter说他曾经想帮我压缩到一页,可是实在是放不下。 所以俺的建议是一页最好,两页也凑合。也许有的行业惯例是长篇大论,但至少俺做招人经理的时候是没耐心看长篇大论的(其实我基本上只看qualification 和experience,大概靠谱了才去看education什么的)

Q: 我有几十篇论文,怎么列?

A: 俺曾经负责招过研发工程师(R&D engineer, research scientist),也负责招过“普通”的工程师(比如application engineer)。俺的经验是文章太多未必是好事,因为有时会有先入为主的印象:做科研太牛的人转型到工业界比较吃力。当然凡事不能一概而论,你如果是申请去要拼技术的地方(比如大药厂的研发,石油公司的研发,一部分小的consulting firm),论文多应该不是坏事。俺的建议是宁缺勿滥,牛杂志上的要列,很一般的杂志上的和会议论文就不要列了(因为很多会议论文是可以随便发的,不需要经过peer review的过程,所以容易给人一个错误的印象:这个人没有多少像样的东西,靠发会议论文凑数混学位)。当然,如果你所在的行业对会议论文要求也是很严(是整个行业,不是某一个会议),又另当别论。

Q:你能不能把你的简历贴出来给大家看看?

A:抱歉,我的经历有一些相当特殊的东西(比如在某年做某方面的东西),即使把细节略去,同行也基本上能猜出我是谁,所以我很不倾向于把简历(即使是修改过的)贴出来。

Q:你能不能帮我改一下简历?

A:再次抱歉,原则上俺不能。主要原因是俺的空余时间非常不固定,没法保证时间/质量。以后也许会考虑适当地帮一下。但是即使是帮的话,数量也不会大。

## 关于找工作(三 广而告之【之一】)

简历准备好了,下一步就是想办法把自己“卖” 出去了。可是怎么“卖”呢?

中国人有句老话:“酒香不怕巷子深”,又有“敏于行,慎于言”,可惜在老美这儿统统行不通(好象在中国也行不通)。从某种意义上讲,要有效地推销自己,必须得把自己“广而告之” — 你想想, 如果招工的人根本不知道世上还有你这么一个人,机会能到你的头上吗?

以俺的经验,找工作大概有三条路,一条条的讲吧。

第一条路:最简单的方法,通过网络找。这主要是两件事。1. 挂简历; 2. 看广告。

先说挂简历。建议把你的简历放到两个大的网站:monster.com 和 careerbuilder.com。这两个网站基本上是属于“通用型”网站,recruiter基本上都会去看一看的。用什么格式的简历呢?pdf版或者word版。俺倾向于pdf版,因为有的网站太“聪明”,会把你的word文件的格式弄乱。除了这两个网站,你可以放到一些比较“专门”的网站,比如你如果是做计算机相关的,还可以放到dice.com上。简历挂上去之后,这一部分工作就基本算结束了。你要做的只剩下等鱼儿自己上钩了。

稍微跑题一下:建议不要把简历放到太多的网站山。因为一旦你把简历挂到网站上,你的简历基本上就是公共信息了,recruiter能看到,伪recruiter也能看到,而且伪recruiter会不屈不挠地试图说服你。怎么鉴别伪recruiter?俺也没办法。基本上靠直觉吧,如果有什么来的太简单(比如说让你直接去on-site interview什么的 — 不是没有,很少),多留点心吧。一点小经验,如果你的专业与保险业没有什么关系,那些邀请你去interview的保险公司(的分支/代理), 比如比较臭名昭著的metlife和aflec, 基本上是逗你玩的。他们会说“我们有很多很成功的雇员和你一样是工程背景,。。。”什么的,好象你可以一步迈入finance挣大钱了。事实是什么呢?你确实会很容易那到工作,但也仅此而已。固定的工资基本上是没有的,搞不好你还得自己掏培训费,自己买工作用品等等。高收入有没有?当然有,只有你一个月卖出多少份保险。

2.看广告。现在网络这么发达,好多以前几乎不可能得到的信息,都可以很容易的找到了。招工信息也是这样。俺的建议是每天拿出0.5-1个小时,在网上看有什么新的工作机会。一点小窍门:你不一定要去monster啊,careerbuilder啊,yahoo hotjobs啊,dice啊什么的一遍又一遍的搜索. 现在有很多“检索”网站,提供“一站式”服务,即你只要去一个网站,他们可以替你搜索若干网站。俺用的是indeed.com, 基本上可以包括绝大部分工作信息,每天把最多七八页招工信息列表看一看,也就是半个小时的事。另外一个类似网站是simplyhired.com。大同小异。

说到网络,俺有一些小的经验:

1. 搜索的关键词覆盖的范围越宽越好。的确,会有很多不着调的搜索结果,可是也会有很多你容易漏掉的结果会出来。举个例子吧,如果你做的是机械控制, 只搜索"mechanical"会比搜索“mechanical & control” 得到多的多的结果(当然也包括不太着调的,比如修房子的mechanical engineer)。

2. 关于indeed.com的小tips: (1) 不要轻信indeed给出的招工广告的“年龄”,因为indeed有时候(比较经常)会把很古老的招工广告翻出来当成新的。所以最好再用google查一下那个具体的广告,有时你会发现那个广告已经在那儿好几个月了。 (2) indeed上的工资水平过滤(左面的面板)基本上可以忽略,很多数时候不着调。

3. 提防利用找工作的人的心态赚黑心钱的公司。比如有一个网站叫6figurejobs.com(他们还有很多别的域名), 建议你躲着一点。如果你不幸在他们的网站上注册了,他们会不停的骚扰你,甚至会给你提供一些免费的服务(好象有一本书,还有免费的resume review), 然后会和你电话约谈,给你一个去一个号称花了几百万研究出来的什么找工作的网站(忘了叫什么名字了)的帐号,其实目的就是吓唬你,让你和他们签约,让他们帮你找工作。签约费据说在七八千的量级(你付给他们),而且绝对没有“不满意退款”一说。类似的公司还有很多。所以如果有公司联系你,你要做的第一件事是去google公司的名字,看看他们到底是干什么的。第二件事比第一件重要的多(因为6figurejobs.com网站看起来挺正式),去google 公司名字+spam,你会发现你不是第一个他们试图想骗的人。

4. 有一个网站叫jobfox.com。 这个网站说起来还不能算黑心网站,但是他们的所谓的"smarter approach"基本上是胡言乱语,实在没必要在这个网站浪费时间。

5. 网上有很多专业的简历修改服务,收费几十到几百不等。俺个人的建议是没有必要用他们的服务。有几个更有效的方法。(1)如果你还在学校的话,可以去学校的career center/career office寻求帮助。那儿的人多少都是受过一些训练的,有些还本身就是专业写手,他们应该可以给你一些建议; (2)去图书馆找关于写简历的书照猫画虎; (3)[比较无耻的自我宣传] 看俺博客里的经验。这些经验是俺第一手的积累。如果说专业写手/书上写的是武术套路的话,俺的就是军体拳,虽然不太好看,管用还是挺管用的。

## 关于找工作(三 广而告之【之二】)

找工作的第二条路:recruiter。recruiter, 也就是常说的head hunter, 是专门的以帮公司招人为生的人/公司。recruiter 大概有两类:1. (通常是比较大的公司)他们常常和一些公司有合同,是那些公司的exclusive recruiter。也就是说,如果那个公司要通过recruiter招人,他们必须通过这家公司。这样的好处是什么呢?如果一个公司每年招的人比较多,通过签一个exclusive recruiter, 他们通常只要付一个固定的费用(有时会根据招人的数目稍做调整),这样往往比雇用一批non-exclusive要省钱。2. non-exclusive recruiters。简单的说,招人的公司把招人信息放出去,一堆recruiter帮他们招人, 谁找到了谁拿commission。

明白了这个区别,对“recruiter为什么问我申请过这个位置没有?”的答案应该很清楚了吧—对他们来说,如果你已经被毙过,他们就没必要浪费时间了。而对你来说,等于间接地告诉了你他们不是exclusive的(他们有可能是别的公司的exclusive recruiter)。

如果有recruiter和你联系,你该怎么办呢?第一,约一个时间电话里细谈(如果是recruiter直接打电话给你,让他们把工作位置的信息email给你,同时找个借口[现在不方便说话什么的]另外约时间)。问什么?因为你需要做第二步的工作:调查和工作位置相关的背景内容,比如什么公司,公司的主要业务是什么,要找的是干什么的人。记住,打有准备之仗会大大增加你成功的几率。然后就是和recruiter的电话了。

电话里你该做的第一件事就是在开始的“how are you doing?”之类的废话之后,想办法(比如“thank you for your interest. Before we start, can I ask you a question?“)问第一个问题:“are you an exclusive recruiter for them?” 因为答案会给你一些线索。比如,如果他们是exclusive recruiter, 你基本上可以确定是招人的公司考虑的有限的几个人之一,而如果他们不是exclusive recruiter, 你有可能只是一大堆潜在候选人中的一个。另外,exclusive recruiter通常对招人公司很了解,甚至直接认识hiring manager, 所以他们会(只要你去问)告诉你面试要注意什么,面试人都有什么样的背景, 等等有用的信息。

不管是不是exclusive recruiter, 对找工作的你来说都是免费的服务(如果有向你要钱的,比如6figurejobs.com这样的,躲着点),而且他们在绝大多数情况下会极力帮助你的(比如帮你改简历,准备面试)。原因很简单,只有你成功了,他们才有钱赚— 对non-exclusive recruiter来说,成功一个拿一个的commission (顺便说一句,这个commission可不是小数目,行业的标准据说是所招的人的两个月的工资 — 不是被招的人出, 而是招人的公司出); 对exclusive recruiter来说,成功一个剩下的工作量就少一个。

俺个人对和recruiter的谈的态度是实事求是,有一说一,原因在“面试”一节里。

如果recruiter对你比较满意,他们会去和公司谈(他们会告诉你他/她下一步的计划),你基本上可以开始着手准备hiring manager的电话interview了。这个电话interview基本上是板上钉钉的,因为不需要花公司什么钱。— 俗不俗?凡事都是以钱来衡量的。

那么怎么找recruiter呢?等他们自己上钩是一个办法。还有一个办法是靠别人推荐。再有一个办法是半主动出击:如果招工广告是列出了让你联系的人的名字,google他的公司地址,然后在cover letter里的收信人一块里直接用他/她的名字/地址。这实际上是一点心理学的小花招,据说这样会使收信人中文感觉比较重要。心情好一些,就会愿意帮忙一些。那么如果没有联系人的名字怎么办?还是心理学的小花招。cover letter的题头(就是dear xxx一行)写dear hiring executive。当然收你的信的人一般也就是个打工仔,可是被人尊称为executive还是挺爽的不是?

## 关于找工作(三 广而告之【之三】)

找工作的第三条路:==关系网==。俺个人的感觉,这是==**最**==有效的方法。因为如果有“内线”,你成功的几率大大的大大的(不是俺输重复了)增加了。另外很多情况下,你的“内线”可以帮你探听一些内部消息,这些内部消息可是无价之宝吧。

那么怎么找内线呢?首先,如果你要找工作,除非你是在骑驴找马,不能悄没声地找。先给你的朋友,哥们,姐们发一封email:“兄弟打算找工作了,简历在附件里,你们谁知道合适的机会拉兄弟一把啊”。也许你会问,某某朋友没在工作,这个email就免了吧。俺的答案是,发封email又不花钱(网络真是好啊,寄封信还得四毛多呢),您老人家省什么省?朋友不工作, 你就知道朋友的朋友(的朋友)也不工作?有的时候,工作机会会“莫名其妙”地出来。给你们讲一个真实的例子吧。俺的一个朋友,悄没声地找了小半年,也没什么动静。后来老哥无意中和平时一起打网球的一个人(A) 提起,当时也没有什么动静。A去教会,和B(我的朋友不认识B)闲聊是提起来,B说,“唉,好像我老婆公司在招人,我给问问吧。” B的老婆是做会计的,按理说也不着调(俺的朋友是做计算机的)。可是小公司里就那么多中国人,随便问了问,结果真有一个组在打算招人。于是大概两三个星期后,我的那个朋友去面试了,然后拿到了Offer。最绝的是,那个招人信息根本就没公开过。这个例子也许有点不可思议,可是很多事情就是不可思议的。你如果不去试一下,就是有不可思议的事情也轮不到你的头上啊。

第二个办法:如果你还在学校的话,或者离开学校没多久的话,并且还你的老板/导师的关系还可以,去骚扰你的老板/导师。他/她应该会有一些关系(肯定比你的多)。虽然他/她不一定会直接帮你,你总可以虚心地请教一下“去什么行业比较合适?”吧?他给你的建议往往是他有熟人的行业。这样即使他/她不直接帮你,保不准你要申请的位置的hiring manager是知道他呢。当然如果老板肯帮忙(很多老板都愿意帮忙的,有学生毕业也是衡量教授的工作的一个方面),事情就好办多了。特别是如果他/她愿意帮你联系他/她以前的学生,你的便宜可占大了— 至少对俺来说,如果俺的老板发话说如果有机会帮帮忙,俺一定会大大的上心的。

第三个办法:linkedin。 你有没有linkedin的帐号?没有的话,赶紧去申请一个,然后把你认识的人统统加进去。linkedin的最大的好处是你可以看到某个人是你的第几层关系网上的 – 朋友(contact)是第一层,朋友的朋友是第二层,朋友的朋友的朋友是第三层。我不记得在哪儿看过,在这个世界上,任何两个人之间的关系网都不超过四(五,六,不记得具体是几了,总之是一个不大的数)层,也就是说从你开始,你认识的人的n(n 不大)次方可以包括世界上任何一个人。这个信息有什么用呢?如果你想申请某个公司的位置,而公司要求你直接到网站去投简历,那样的话你的几率基本上是和买彩票差不多(除非你的简历一下子把他们镇住)。这时候你就可以去linkedin看看,有没有那个公司有没有什么人是在你的关系网里。如果有,你会看到你们之间的联系(你的第一/二层关系网上的朋友)是谁,找你的朋友, 请他/她帮忙。如果你把你的学校(大学,研究生)都列上了,有时候你会找到校友(尽管你们入学的时间可能相差了十几年)。有了这一点共同点,你就可以试图把你的校友加到你的关系网里,然后请他/她帮忙了— 如果你的背景差不多,多数人是愿意帮忙的(只是把简历转发给HR而已,而且很多公司有referral bonus)。但是如果人家不想帮忙,也不要有怨言,以为公司里招人有时候针对性是非常强的,背景差一点都不行。而作为公司里的雇员来说,如果推荐的人太离谱,也不太好(以后再推荐人就不太好用了)。

用linkedin还有一个好处:很多很多recruiter都用linkedin,而且有成百上千的contact。你和他们/她们建立关系,你的关系网一下子就增大了很多。另外如果你拿到了on-site interview的日程安排,你也可能能在linkedin上查到要见的人的背景(不建议你把他/她加为contact,会让人不舒服)。

第四个办法是俺从Right Management的学习班上听来的,没实践过,不过俺打赌大多数找工作的同学都没听说过这档子事:在美国有很多networking group,说白了就是找工作的人的碰头会。这儿有一个目录:http://www.job-hunt.org/job-search-networking/job-search-networking.shtml 。 俺的猜想是networking group对象俺一样的工程师可能帮助不太大,因为象俺们这样的工程师是靠技术吃饭的,太专门话,不是象sales,marketing之类的专业性不是非常的强。当然俺是乱猜的,你如果有时间,自己去参加几次也没有什么害处。如果你打算去,准备好一个"30 seconds sales pitch", 基本上就是以三四句话概括一下你的背景和你想要找的工作(和你简历里的qualification差不多),练熟了,因为你会被要求做一个自我介绍(要不然别人怎么知道你是哪路神仙?)

{==对于软件工程师或者创业者而言 现在很多技术讨论会还有meetup是很不错的渠道 尤其是技术人才 找找业内论坛或者知名博主发起的一些活动 当地线下最好 见到真人交流沟通一下 如果合适效果完全相当于内推 说实话 那些读MBA的不也是多认识些高富帅白富美知道些人生赢家的机会么==}

## 关于找工作(四 面试)

好了,现在有公司的人给你打电话/发email约谈了。恭喜你,你基本上已经度过了做没谱/不着调/撞大运的一关了。接下来是什么程序呢?

一般说来,公司的面试会是两步:1.电话面试 (telephone interview); 2. 面对面面试(on-site interview).

先说电话面试:电话面试有可能是两个电话。第一个,和recruiter/HR谈。找一个基本上没什么担心的,因为recruiter/HR对你的技术能力的判断力几乎是零。他们打电话的目的一般是想搞清楚一些非技术的问题, 比如你的身份问题,是否需要搬家,什么时候available, 等等。对这些问题就实话实说好了,因为很多事情(比如身份问题)不是个人/公司能控制了的。相对来说,recruiter给你打电话要好办一些,因为他们通常会尽量帮助你(别忘了,他们的收入是和帮助公司招到人挂钩的, 有的甚至是直接挂钩[招到一个人,拿一个人的钱])。

一个很普遍的,让很多人不舒服的问题是recruiter有时会问你对工资的期望值是多少。我的经验是如果你有大概的概念,不妨直言(反正俺都是明着说的)。提醒一下,如果你是骑驴找马,而现在的工作有奖金,记得把奖金包括进去。recruiter问这个问题的原因很简单:如果你的期望值是10万,而那个位置最多给7万,那就不要浪费大家的时间了。

{==建议给个range 也可以直接让HR先说职位offer的range==}

同时,你可以问recruiter这些问题:1. 那个位置的pay band 是多少? (如果recruiter问你的期望值是多少,而你基本上没概念的话,可以用这个问题来反问recruiter — 当然得委婉一点,比如:I’m quite flexible on the level of pay, may I ask you what the pay band for that position is?) 2. 如果recruiter提起和hiring manager 的电话面试,可以问他/她 hiring manager的背景以及面试需要注意哪些方面。正常情况下,recruiter会尽量帮助你的。

下一步,就是技术方面的面试了。你能不能拿到工作,这一步是至关重要的。遗憾的是,这一步也是最没法准备的。为什么?很简单,前面过HR/recruite关,HR/recruiter的训练都是大同小异的,所以可以对症下药;而技术方面,隔行如隔山,而且参与面试的人有各种各样的风格(多数公司都没有固定的面试问题),能不能说服他们你是合适的人选,只有靠你自己的能耐了。

那么是不是说只有去碰运气了?也不完全是。面试之前,至少有一项准备工作:==调查==一下公司的背景以及面试你的人的背景(如果可能的话)。公司的背景包括主要的业务(总不能人家问你“对我们公司知道什么?”回答“nothing‘吧),最近的新闻(一般公司的主页上会有,另外google), 主要的竞争对手等等。面试你的人的背景有什么用?通常情况下,他们未必都是你的同行(比如有的人是工程师,有的人是学物理的,有的人是做marketing的),知道了会和什么样的人面谈,才好有的放矢的准备啊。面谈的时候,也可以有选择地吹吹牛。

面试的程序有什么呢?基本上是两块:1. presentation and/or hands-on project. 2. 和不同的人面谈。hands-on project好象在找软件工程师的工作是特别普遍。俺不是学软件的,所以也没什么经验。建议去网上(比如mitbbs)找”面经“。 presentation对工作经验不多的申请人来说几乎是必须的(对多年工作经验的人来说,做presentation有时不现实, 因为大多数公司里做的东西是不能随便出去讲的)。面试时的presentation其实和学校里的差不多,( 当然每个人在学校里受的训练也不一样),但是要注意淡化技术细节,把重点放在解释清楚到底是怎么做的。原因很简单,在学校里做presentation, 听众基本上都是同行,所以你可以不厌其烦地讲解细节,把别人都灌晕了才牛;而在公司里,第一同行未必占多数,再者基本上没人喜欢看公式,特别是说话管用的经理们。如果你不能用大白话把你的东西讲清楚,你觉得经理们会不会帮你说话?

至于和不同的人面谈,俺能给的经验就两条:1. 要尽量给人留下一个容易相处的印象。为什么?因为以后大家要做同事的。虽然未必会做同一个项目,但谁也不能断定以后绝对不会合作。如果有一个P股上的痛(hehe, 老美的说法,pain in the *ss), 不是给自己找麻烦吗?2. 吹牛不要紧,不要漏。特别是和技术背景强的人聊天,他/她问某个问题,通常是有一定概念的。如果你乱吹,牛皮吹破了,你的面试成绩也就差不多了。其实有时候老老实实说”我所知有限“也不一定是坏事,因为有时候面试的人是故意来看你到底懂多少的。

几个与面试相关的非技术经验:

1. 面试前一天,最好开车去面试地点一趟。熟悉一下路程,以防万一第二天路上耽搁(比如有时候公司的门面很小,或者gps不准确)。

2. 面试时西装革履(除非公司明确告诉你不需要)。建议开车时把西装挂起来,到了公司再穿上。进了房间后,可以把西装脱下来。

3. 比约定的面试时间提前大概10分钟到。如果到早了,在公司的停车场等一会儿;如果迟到(最好不要),提前打电话给hiring manager告诉大概会迟到几分钟。

4. 面谈后记得要名片。在面试后的24小时内给每个人发一封感谢的email。内容可以基本一样,但是要每人一封(不要群发)。多数情况下,对方不会回你的email,那是正常的,没有什么可紧张的。

{==这个很重要 你要相信他面试了这么多人 如果没什么人给他发感谢信 你很突出 如果大部分人给他发感谢信 你很突兀==}

5.最重要的一点,放松。要相信自己的实力。

## 关于找工作(五 找工作的心态问题【之一】)

技术细节基本讲完了,下面开始讲一点虚的 — 找工作的心态问题。

先声明一下,俺找工作的时候一没身份的压力,二没经济的压力(或者是在骑驴找马,或者是正拿着被裁的package,开开心心地领着失业救济"度长假"),所以有可能是站着说话不腰疼。您要是正一肚子火呢,等消消气再来看。

其实找工作的心态说起来非常简单,就一句话:“要相信自己的实力”。想想您老人家背井离乡,飘洋过海地跑到这个地方来,说着鸟语,看着写满鸟字的书,还拿到了鬼子都不容易拿到的老鸟学位(骂死他/屁挨着地),搞定个把鸟工作还不只是时间早晚的问题。咱们和老美相比差什么?一是不太清楚他们游戏的规则/套路(这个希望俺费牛劲写的这些帖子能管点用),二是没有老美的关系网(先天不足,没法子,老美到了中国还不是一样没辙?),第三个就是中国人普遍太谦虚,以致于有些畏畏缩缩(不是wsn的ws),不敢/不会象老美一样装牛B。

所以俺说根本的根本是要有自信,要有近于自大的自信。你自信满满了,写的简历才能吓住人(因为你做的东西只能用一个字概括:牛),面试时才能说服人,(就算稍微吹点牛,别人也不敢乱问啊)。你也许会觉得俺在说胡话,俺是故意这么说的,因为中国人普遍认技术挂帅,总觉得别人能看出来自己的技术有多牛。技术要好是对的,但它顶多是七分,剩下的三分可就得靠吆喝,忽悠之类的软能耐了。有一点您可以基本放心,您在怎么自信满满,和很多老印/老美比起来也是小儿科的很。(by the way, 那样的老美基本上是无知者无畏,老印吗,就不好说了)

找着了这个根源因素,网上(特别是mitbbs上)找工作的时候常见的“什么什么可怎么办啊?”这样的问题也就不能成为问题了(怎么象方鸿渐的成名演讲的语气?)。下一节具体晒一晒那些不成为问题的问题。

## 关于找工作 — 文摘之一

=== 说明 ===

文摘系列没有固定的计划/蓝图,我在网上看到的东西随看随贴,会穿插于正常的“关于找工作”系列之中。

=== 说明结束 ===

(文摘之一)

小背景: Steve Allard是我打过一点交道的recruiter(他一度反复游说我去一家startup)。此人的能耐大小不清楚,但磨嘴皮子的工夫那是相当的美国,基本上能把死的说成活的。

介绍这个背景的原因是希望不要给你留下我支持/推荐或者不支持/不推荐他的印象。只是觉得他写的一些东东有些道理,所以给大家节省一点时间,做个压缩饼干式的文摘。

有时间/兴趣的话,原文(英文)在这儿:http://talentretriever.wordpress.com/2009/04/16/6-steps-to-a-winning-resume/

要点:

获奖简历6要素:

1. 目标明确。

【俺的评论】即俺所说的有一个大框,根据实际情况照方下药。所不同的是他强调的是以简历作者的追求为准则(以人为本嘛),俺说的是以招工单位的要求为参考准则—前面提过了,俺的一套往好听里说是军体拳(实用,但不好看),往不好里说就是野路子,有点偏阴损。

2. 列表(bullet items),但是也不要全列表。

【俺的评论】和俺说的基本一致,两三句三四句易读的话(短语),然后是列表。

3. 具体,有数据,可以吹牛[他没敢明着说],但不能漏

【俺的评论】和俺说的基本一致

4. 动词

【俺的评论】和俺说的一致, 动词开头,挑吓人的词用

5. 废话少说

【俺的评论】和俺说的又一致,宝贵的空间不要用来说屁话(实在想说屁话,象俺一个开个博客)。还有,俺说的不要列reference也提到了(讲的比俺讲的还生动)

6. 短

【俺的评论】老美能做到这一点可不简单,我看他们的教材/文章有90%以上是废话连篇,又臭又长。

呵呵,看来俺业余也可以琢磨着干干recruiter的活了。

另外这一片也可一看,是关于如果使用linkedin的,俺就不摘要了。 http://talentretriever.wordpress.com/2010/03/03/building-your-linkedin-brand/

现在有工作的同学可以看看这个:http://talentretriever.wordpress.com/2010/05/04/“but-i-have-a-job-and-i’m-happy-”/, 有点意思。不过俺建议不要被他完全忽悠了,俺就是对他太客气,被他穷追猛打了两个星期(那个位置简直就是照着俺的背景/经验写的,也难怪他不屈不挠。不幸的是那个startup实在是太绿了,俺实在是不敢冒险赌一把)。

剩下的文章基本上没必要看,主要是写给公司看的。这家伙也许正在努力给自己找铁饭碗。

给他免费做一个广告吧:你如果想和他联系,可以在linkedin上找到他。

## 关于找工作 — 文摘之二

== 感谢zjh67同学同意俺免费用他的原创文章 ==

MITBBS 上zjh67的文章,面试的真实例子分析,非常有帮助。 原文在这儿: http://www.mitbbs.com/article_t/THU/31222293.html

【俺的点评】这个经历和俺有一次招人的情况机会一模一样。中国人一般技术基础是不错的,但是吃亏在两三个方面:

1. 技术面太窄。我见过不少自己的东西搞得很熟的,但是也仅限于自己的那一点东西。其实不需要你对别的多么精通,大概有些印象, 能马马虎虎说一说就可以了。因为工作以后的东西通常和你以前做的是不同的,如果看不到你的触类旁通的能力,公司是会很犹豫的;

2. 太学术化。在校的时候做presentation是越复杂越好,可是在公司里更重要的是别人能大概听懂你的东西。在去面试之前,要想办法搞清楚那个公司的风格是什么—有的公司(比如consulting)很注重研究,但更多的公司是希望找到的人能短平快地解决问题。在准备presentation的时候,可以有两个方法:(1)对每一个公式都问一下自己:这个公式删去的话,我还能不能把我的做法大概讲出来?追根究底的话,你会发现绝大多数公式都没有必要出现。(2)找一个对你的东西没有多少概念的同行(比如新进实验室的小师弟),看看他能不能基本上跟着你的思路走。要记住,公司的任务是要赚钱的。如果你的工作不解决实际问题,或者你的方法先进的别人根本听不懂,做的再漂亮也没用。说到底,最重要的东西不是你做的细节有多漂亮(能拿到学位,在细节上都是有两把刷子的),而是你的分析问题,解决问题,表述问题的能力。为什么要用表述问题的能力?管理层对你做什么总得有点概念吧,另外一个重要的原因就是你迟早是要和别人合作的,曲高和寡可不好办。

3. 和第二点差不多,但是可能短时间内不太容易提高:基本概念要清楚。这个不是指你能把基本定理背出来,还是要真的明白为什么一个问题可以那样做。举个材料力学的例子吧,悬臂梁理论是解决工字钢相关的问题的一个基本工具(大学二年级的东西,学机械,土木,航天,力学的人大概都能把公式从头到尾推出来),可是你有没有注意什么情况下不能用悬臂梁理论?

= 以下为转发的文章 ====

我在一家半导体设备公司任职。前些日子我们组有两个机械设计工程师的位置空缺。印度同事推荐了许多印度人。 我也通过别人介绍联系了两个师弟。可是面试结果下来,offer 全给了小印。虽然参加面试的六人中有两个小印manager, 但我的感觉是师弟们的背景和表现和小印们相比的确差强人意,落选当在情理之中。我想在这里将过程简单回顾一下,希望对其他正在或将来要找工作的师弟师妹们能有所帮助。 由于各个行业各个公司各个小组的情况不尽相同, 所言不当之处还请各位包涵, 就当是他山之石吧。

首先要说明的是我们要招的机械工程师必须具备很强的分析问题能力。当然基本的专业训练如结构应力,流体传热,材料应用等是不可缺少的。

师弟A:

本科和硕士都在清华,有机械和材料的背景。即将从一工程排名前20的学校博士毕业,无工作经验。据说其导师是行业中的牛人。在面试前我和他通过几次电话,请他至少要做一个准备,那就是用5 分钟的时间总结一下他所完成的最重要的项目。这是因为在他之前我们面试了一个明大的小印硕士,他准备了一份非常漂亮的彩色打印的presentation,highlight 了他所承担的项目,而且简明扼要地介绍了他所面对的问题、难点,解决问题的思路,得到的结果,优缺点以及后续工作等等,给我们所有的面试人员留下深刻印象。由于他是硕士,我问的几个问题他都没能正确回答,但是他尽了最大努力从他所理解的机理出发试图得到正确答案。这使得我这个对小印有所抵触的人都在心里赞叹。

回到师弟A。面试那天他的 attitude其实很不错。我不知道他是否按我的提示做好了准备,因为我本人在给他面试时并没有谈及这些。在面试结束后的讨论会上,我们的CTO(白人)坚决反对雇用A,理由是他对所承担的博士课题缺乏深度的了解,而且只局限于他所做项目本身而已(他的课题是一个大课题中的一部分),他对上下游的情况几乎一问三不知。这不是一个博士应有的表现。所以尽管personally他觉得A是个good guy

,他还是反对。一个资深的白人工程师也持反对态度。他向A提了一个压力计算的工程问题,他本期望A能将问题简化,给出一个估计值(量级之内)。可是A却告诉他要构造一个模型然后用simulation软件找到答案。所以这个资深工程师的结论是A缺乏工程师的素养,不会猜结果。两个小印manager的评价倒并不很负面,其中一个表示他持中性。另一个觉得对fresh的博士不能要求太高,有些方面毕竟工作后才能学到。可是我们组招人的标准是全体一致通过。就这样这个位置给了那个明大的小印硕士。

师弟B:

本科在清华,流体背景。硕士在北大,应用力学。工程排名前20 的学校博士毕业,专攻传热模拟计算。在一个专业咨询公司工作了3-4年后,刚失掉工作。我找他除校友因素外还因为他的博士学校在传热领域很强。由于A的前车之鉴,我再三嘱咐他要做好相应的准备。可是面试的结果B还不如A,一是他的知识面窄。即使是他专攻的传热领域,他的基本素养也没有给人留下印象。二是他的精神面貌没有表现出他对所应聘工作的兴

趣和热情。所有面试人员都觉得他是为面试而面试。其后我们又面试了一个明大的小印应届博士(不明白为什么来这么多明大的。估计都是其中一个小印manager引荐的)。他对他的博士课题充满了激情(有关energy harvest在交通领域的应用),也看得出他的确在研究中下了大功夫。和前一个小印一样,他对不知道答案的问题敢于从基础知识出发尽最大努力去分析。结果他也拿到了offer。

总结一下:

1.也许大家在平时要注意知识的积累,尤其是专业知识面要宽,不要只局限于博士课题。对于所做课题,一定要200%地了然于胸,包括来龙去脉,问题难点,解决方法,独到之处,局限性,等等。

2.未必要记住什么公式,但一定要了解物理现象的本质和机理。清华的学生应该在这上面有优势。

3.做好面试的准备。要对所面试职位表现出一定的了解和兴趣。不然你来面试干嘛。正确理解面试人员的问题。不清楚一定要问。回答问题要言简意赅,击中要害。

衷心希望师弟师妹们能找到理想的工作,学有所用。

## 关于找工作的补充【之一】

记不记得俺提到过的experience里要用“吓人”的动词? 给你们一个小列表 (不是我的原创,不记得从哪儿抄来的了)。注意(1)全都是过去时; (2) 没有studies, investigated, worked on, supported 这些无关痛痒的词。

1. Accelerated 35. Empowered 69. Motivated

2. Accomplished 36. Enabled 70. Negotiated

3. Achieved 37. Encouraged 71. Obtained

4. Acted 38. Engineered 72. Operated

5. Adapted 39. Enhanced 73. Orchestrated

6. Administered 40. Enlisted 74. Organized

7. Allocated 41. Established 75. Originated

8. Analyzed 42. Evaluated 76. Overhauled

9. Approved 43. Examined 77. Oversaw

10. Assembled 44. Executed 78. Performed

11. Attained 45. Expedited 79. Pinpointed

12. Boosted 46. Focused 80. Planned

13. Budgeted 47. Forecasted 81. Prepared

14. Built 48. Formulated 82. Prioritized

15. Calculated 49. Founded 83. Processed

16. Catalogued 50. Generated 84. Produced

17. Chaired 51. Guided 85. Reconciled

18. Coached 52. Harnessed 86. Repaired

19. Collaborated 53. Identified 87. Researched

20. Communicated 54. Illustrated 88. Revitalized

21. Compiled 55. Implemented 89. Selected

22. Consolidated 56. Improved 90. Solved

23. Coordinated 57. Increased 91. Spearheaded

24. Created 58. Initiated 92. Stimulated

25. Cultivated 59. Instituted 93. Strengthened

26. Decreased 60. Integrated 94. Succeeded

27. Demonstrated 61. Introduced 95. Surpassed

28. Designed 62. Invented 96. Synergized

29. Developed 63. Launched 97. Troubleshot

30. Diagnosed 64. Led 98. Uncovered

31. Directed 65. Maintained 99. Upgraded

32. Documented 66. Managed 100. Utilized

33. Doubled 67. Mastered

34. Educated 68. Mediated

## 关于找工作(五 找工作的心态问题【之二】)

长周末临时决定去探望一个朋友,耽误了接着往下写,见谅******

所谓“不成为问题的问题”,基本上是在bbs上,网上论坛上差不多每个星期都会见到的一些问题。从俺个人的角度看,大多数问题都已经被回答过若干次了— 当然俺这个观点大有站着说话不腰疼的嫌疑,因为想当初俺找工作时也有差不多的疑问。俺有一个比喻,找工作这件事就和骑自行车差不多,当你没经过(还不会骑)的时候,它看起来挺神秘/吓人,但是一旦你知道了是怎么回事,真的是没有什么门道。

列一下俺常看到的“问题”。假如某个问题恰巧是您问过的,而俺的意见/答案比较不好听,请包涵。

1. 没接到HR/recruiter的电话,怎么办?

没什么要担心的。如果他们真的觉得你的背景很合适的话,会在给你打电话的。即使不给你打电话也无妨,你的机会本来也不是很好— 如果好的话,他们通常会给你给你留言。(顺便说一句,如果你有一个专物专用的手机,这样的事就不太会发生了)。

2. 约好了电话面试,我被放鸽子了。。。

如果是对方(特别是hiring manager)和你约的某个时间给你打电话却没打过来,那说明他们不想要你了—。。。—骗你的,当然不是了。要知道hiring manager没有专职的, 也就是说,他/她还有别的工作要做,而招人面试的优先级通常不会很高。所以他/她可能哪儿耽误了(如果hiring manager约了几个电话面试,晚点的情况非常常见),也可能一时脱不开身(如果他/她临时和老板开会,总不能把老板晾那儿吧), 也可能就是忘了(谁让你的优先级太低呢)。那么遇到这样的情况怎么办?在约好的开始时间之后大概15分钟给对方打一个电话。如果他在办公室(即使是在讲电话),一般会马上和你说一下的;如果不在,给他/她留个言,客客气气地说明你没接到电话,然后告诉对方什么时候找你比较方便。遇到这样的事你偷着乐吧,hiring manager多多少少有点理亏了,面试时会对你松一点点。

3. 电话/on-site面试过了,多长时间有动静?

你现在才想起来问这个问题?早干什么去了?这个问题的答案,只有hiring manager才知道—如果你后面还有好几个要面试的人,等个几个星期也不是什么新鲜事。所以在面试的最后,hiring manager通常会问你还有什么问题吗?这个时候要就得问他下一步的计划和时间表(plan & timetable)。(当然还要问别的问题)hiring manager给你的时间表就是你应该开始关心(如果到时还没有动静的话)的时间表。

如果过了他们/她们告诉你的时间还没有动静,写封email或者打个电话问一问,有的时候公司里有别的事情耽误了,但是公司一般不会逐个通知候选人。问一问不会损失什么的。

4. 某某位置是个什么级别的位置?

这个问题除了那个公司的人没有人能回答你。同样的位置,在有点公司可能是要10年以上的经验才会拿到,在另外一个公司可能只要有研究生学位就可以拿到。俺曾经遇见过一个做了好几年senior staff scientist的老哥,当时俺的敬仰那是如滔滔江水,后来才知道他以前的公司Ph.D.工作三到五年基本上全可以升到senior staff scientist的位置。(那个公司再往上的位置是没有任何修饰的scientist)

有时候从job description上大概可以看出位置的高低。最可靠的途径还是电话面试时直接问HR / Recruiter / Hiring Manager.

先这些吧。如果有什么问题,尽管问。

## 关于找工作的补充【之二】

如果你还是对你的简历不放心,这个网站列了一些职业写简历的网站:

http://www.resumeobjective.info/Reviews-of-Resume-Writing-Services.html

我不知道那个网站和他们所列的网站的关系,但是俺的感觉是这个钱实在是没必要花 — 简历再难写,总比您的硕士/博士学位容易吧?当然您如果想花钱买个安心,也没人拦着您不是。

还有一个很多人注意不到的找工作的地方:你所在(想去的)州的就业办公室。名字各个州不一样,有的叫office of employment, 有的叫labor force development,还有的直接归Department of Labor管。网上查一下,应该很容易找到相应的网址的。在那些网站上,一般会有job board,有时候公司直接到那些"官方"的job board上贴广告(特别是如果他们想找有工作经验的)。另外,你可以找一下离你住的地方近的office, 他们有时会有免费的讲座,还有网络,打印,复印,简历修改等等服务(有可能是免费的)。

## 关于找工作 — 文摘之三

找教授位置的同学必读:http://quattro.me.uiuc.edu/~jon/ACAJOB/index.html

Professor Dantzig 是UIUC机械科学与工程系(不知道是那个神人想出来的名字,没听说过有“机械科学”这档子事)faculty recruiting committee的主席,他所写的建议绝对是第一手的信息,如假包换。

即使你不找faculty的位置,建议你也读一读,有些东西可以借鉴。你也可以看到CV和resume有多大的不同—如果你的resume写成Prof Dantzig给的CV sample那样,你被HR/recruiter毙掉的可能性相当的高。

## 关于找工作的补充【之三】

经常在网上看到有同学发帖子说运气极好/极糟被是中国人面试。俺自己曾经参与过若干次面试,而且因为俺的技术头衔比较高,如果要招的方向与俺的差不多,俺的意见有时是决定性的。事实上,曾经有被大家不看好的人因为俺的意见而给招进来的,也有大家都看好的人被俺一句话废掉的。所以估计被俺面试过的人对俺也是毁誉参半,而且可能是毁>>誉。

为什么说这些?是因为俺打算讲一讲俺作为“面试官”心里是怎么想的。当然俺的想法不一定有代表性,但是普遍性应该还是有一点的。

先晒晒俺的背景。俺马马虎虎可以算是学机械的,但是俺在学校里是做实验的日子用一只手就可以数的过来,也就是说俺的东西基本上是玩虚的(理论,计算什么的)。再有就是俺做学生时,特别是离屁挨着地学位比较远的时候,没少因为脑袋犯糊涂被老板臭骂(现在想想老板的脾气真好啊,居然忍住了没揍俺),所以现在俺看一个人行不行/牛不牛的标准第一是看他/她做东西的大方向对不对头,也就是脑袋清楚不清楚—细节可以学,经验可以积累,脑袋糊涂可不好办。

俺觉得俺的这个调调在负责技术的“面试官”中间还是有一定普遍性的,特别是如果你是Ph.D.并且/或者申请的是R&D的位置。(别的情况,直接跳到下面的3)。当然“面试官”的水平也参差不齐—技术头衔高不代表技术水平高,但是不幸的是技术头衔高的人的意见往往比较管用—所以不排除他/她看不出来你的水平高低乱评一气的情况。不过如果你不幸遇上了技术一塌糊涂的“面试官”,而他又被你这个超级高手当成了低低手把您给毙了,你要学会看事情的积极方面:如果你去了那家公司,向那个“面试官”汇报(他/她当然要指导你的工作了),你会不会心情好?

现在假定“面试官”的技术水平与其技术头衔相称(呵呵,恬不知耻地说,比如俺),你怎么做能赢呢?有几个方面:

1. 你对自己的东东(Ph.D.论文,或者presentation的东西)要熟。这个熟不是说要抠多小的细节,而是说要对为什么做这个,做的思路是什么,理论基础是什么,别的可选的方案有什么,为什么选现在的做法,现在的做法有什么不足,这些看起来无厘头的问题要想清楚。清楚到什么程度?要清楚到能和同行针尖对麦芒地就这个题目辩论的地步—当然不是要你去和别人辩论。为什么这么强调这个问题呢?直接的原因是如果你在细节问题上被问倒,通常问题不会太大;可是如果在大方向(技术名词,approach)上说不清楚,或者给人留下一个你只是跟着老板跑的印象,可大大的不好办。

有同学说了,我就是老板指哪儿我打哪儿,怎么办?赶紧去问老板啊。通常情况下你老板应该会很高兴的(俺知道俺当时[不是要找工作的时候]去问老板,老板那个高兴啊[榆木疙瘩总算开窍了],直接拉俺出去吃了一顿);

2.大方向明确了,怎么做也是一个门道。记不记得俺前面提过被presentation里的公式尽量省略?是有原因的。你讲自己的东东,底下的听众通常是多少有一点概念,但是其实不懂。那么你想想在三四十分钟内他们/她们能理解你三/四/五年的心血的百分之几?(想想你在学校里听讲座,能听明白多少?)可是还是要对你有些技术上的观点吧?这个观点从哪儿来?几个途径:(A)你看起来对自己的东东有没有自信心?这个就是上面第一点要解决的问题; (B)你讲的清楚不清楚?同样,不是细节清楚不清楚,而是大框架清楚不清楚。这就需要你有能力把阳春白雪给白菜豆腐化,用大白话把高深的东东讲清楚。而大白话和罗里八嗦的公式是不沾边的。另外,你讲的过程中,肯定有人听着听着就跟不上了,那个时候再看到满眼的公式,大概谁也没兴趣了。

记住,做presentation最理想的结果,是别人听完你的presentation, 能大概说出你是这么这么做的,可是具体细节一概不知。

那么是不是就彻底不要公式了?当然不是。有些不得不用的(by the way, 那样的很少很少),还得留着。其他的,转移到backup slides里,预备有人和你死抠公式。

3. presentation重点是给人留下你学有所专的印象。但是仅有专是不够的(俺曾经毙过一个presentation非常好,博士论文也很有深度/难度的—老哥后来以同样的presentation拿到了教授的位子),另外一个可能更重要的方面就是你对专业知识的"杂"和"活"。这个通常在一对一的面试时被考察。从某种程度上说,这个"杂"和"活"其实是决定你能不能拿到工作的主要因素。

俺通常会问一些稀奇古怪的问题(比如给我一个悬臂梁/Bernoulli梁不适用的例子)或者一些很基本的问题(比如问学流体力学的,固体材料的弹性塑性变形是怎么回事?)或者一些和被面试人专业相关的东东(比如和做材料加工的人扯扯thermocouple的设计和选择)。这些东西说起来都是挺恶毒的,因为你根本没办法临时准备。更恶毒的是,有些是期待你明白的,有些是看看你有没有概念(有时候没有概念也没什么,但是如果你不懂装懂又被我抓到,你基本上就被俺毙掉了)。所以能给你的建议就是放松,把你的真实水平发挥出来。这么想:即使被废,也没什么,反正和俺这么恶毒的人共事也没有可期待的。

遇到不会的问题时的具体的建议:如果是非常基础的问题,老老实实说不会;如果是具体一些的问题,可以先说不是很确定答案(这句话不要用的过度,用的太多会给人一个不自信的印象,大大的不妙),然后说我可以试着这么做,blah blah。(参见前面贴的文摘之二),这样的话会给人留下一个此人不是死读书,读死书的人的印象,是大大的好事。(其实还有一个原因:俺个人一般不这么做,但是俺知道有人拿自己工作中的难题去考面试的人。想想如果你能给他/她支点(歪)招,他/她还能不大说你的好话?)

如果你现在有时间,把那些“introduction to。。。”的书翻出来看前两三章吧。

4. 另外一个决定你能不能拿到工作的主要因素,是你与人相处的能力。每个“面试官”都在衡量,如果我以后和这个人同事,会不会别扭?这个没有什么办法,如果你的性格太内向/外向,注意收敛一下(一句话不说的木头没人喜欢,叽叽喳喳的喜鹊也让很多人头痛)。一般人说起来应该都没有什么问题的。如果你的口语不好,也不要担心,只要你能维持正常的谈话,一般不会被挑剔的(你的电话面试已经通过了不是?)。另外也不要紧张,因为紧张也没什么用。

5. 俺觉得去面试最重要的心态是自信和淡定,或者说是战术上重视(因此认真准备,在技术上吓死他们),战略上藐视(一方面充满自信,一方面想清楚就算拿不到offer也没什么,权当攒经验值了,这样你就不会紧张了)。俺在前面的回帖里说过,不要给自己找什么“这可是dream job”这种自己和自己过不去的心理压力。一个工作好不好,不是简简单单的技术内容+工资水平决定的,你不去经历,你永远不会知道那个工作是不是你的dream job。(别的不说,再好的工作,让你赶上一个指手画脚,容不得人的老板,每十分钟检查一次你的工作,你还dream不dream?)

6. 一些小小小小的建议:

(1)不要一见面试的人是某国人就有心理预定位(stereotype)。俺不讳言俺不怎么待见老印,但俺也认识很多非常出色的老印。每个人都是不一样的,某国人怎么样,可能整体上(统计上)和文化背景有关,但个体上和国籍无关。