GoGPT

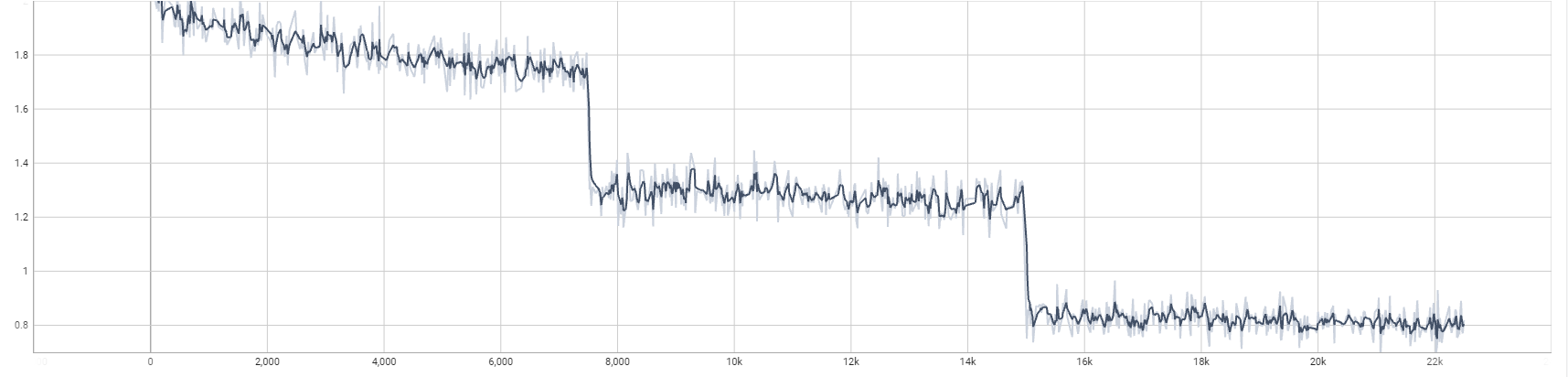

训练第一轮足够了,后续第二轮和第三轮提升不大

- 🚀多样性指令数据

- 🚀筛选高质量中文数据

| 模型名字 | 参数量 | 模型地址 |

|---|---|---|

| gogpt-560m | 5.6亿参数 | 🤗golaxy/gogpt-560m |

| gogpt-3b | 30亿参数 | 🤗golaxy/gogpt-3b-bloom |

| gogpt-7b | 70亿参数 | 🤗golaxy/gogpt-7b-bloom |

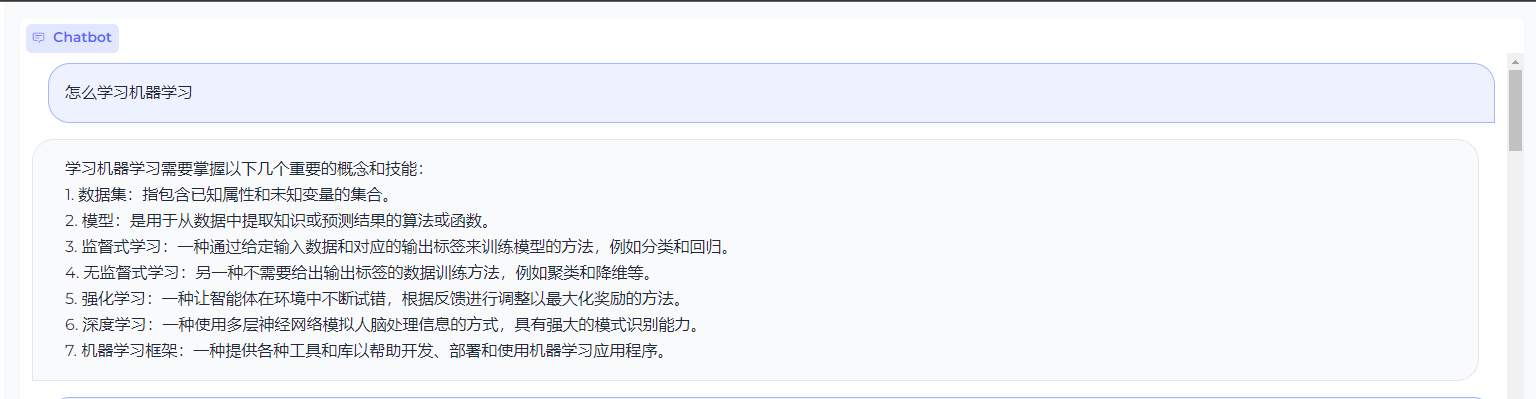

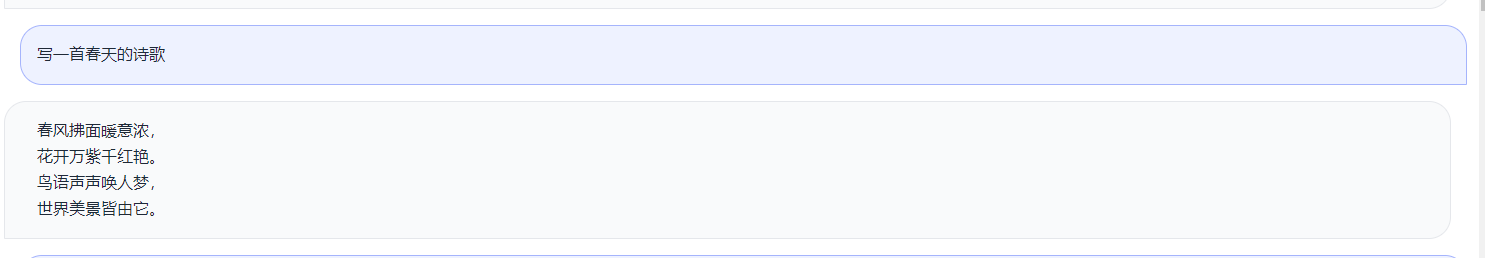

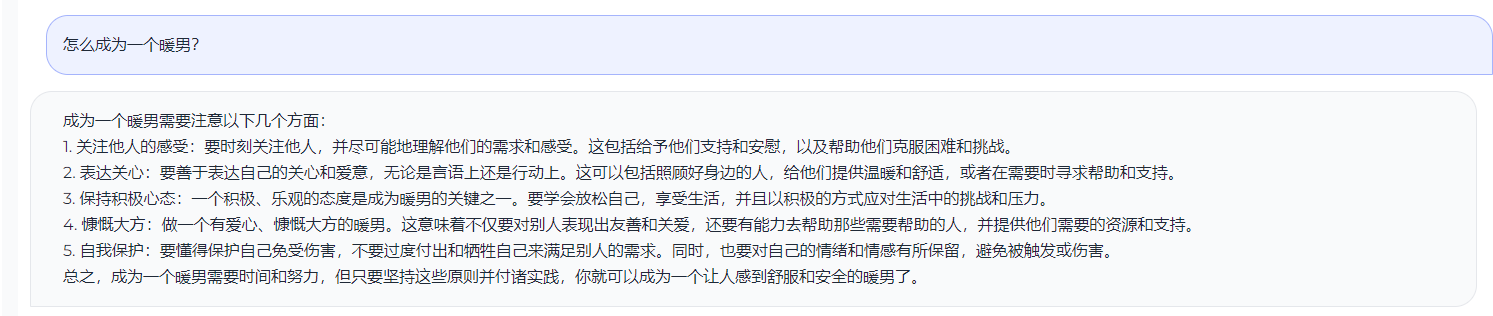

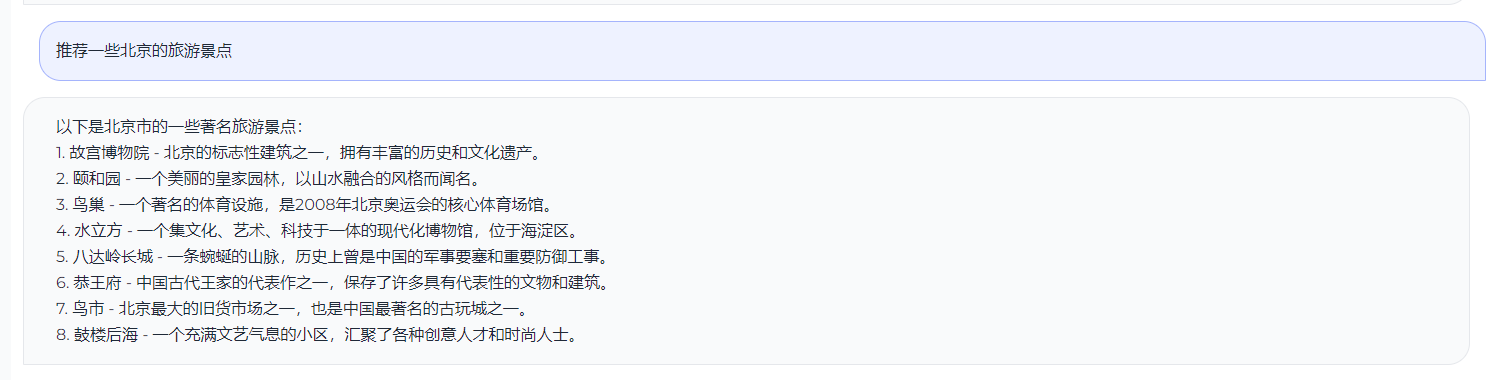

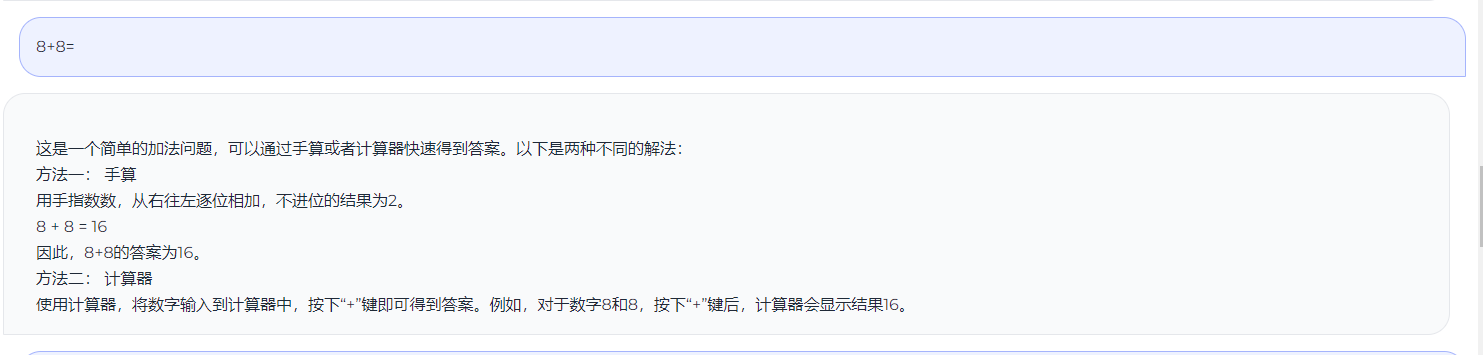

测试效果

TODO

- 进行RLFH训练

- 后续加入中英平行语料

感谢

- @hz大佬-zero_nlp

- stanford_alpaca

- Belle数据 (base) [searchgpt@worker2 output-bloom-7b]$ cat README.md ^C (base) [searchgpt@worker2 output-bloom-7b]$ vim README.md (base) [searchgpt@worker2 output-bloom-7b]$ cat README.md

license: apache-2.0 datasets: - BelleGroup/train_2M_CN - BelleGroup/train_3.5M_CN - BelleGroup/train_1M_CN - BelleGroup/train_0.5M_CN - BelleGroup/school_math_0.25M language: - zh

GoGPT

训练第一轮足够了,后续第二轮和第三轮提升不大

- 🚀多样性指令数据

- 🚀筛选高质量中文数据

| 模型名字 | 参数量 | 模型地址 |

|---|---|---|

| gogpt-560m | 5.6亿参数 | 🤗golaxy/gogpt-560m |

| gogpt-3b | 30亿参数 | 🤗golaxy/gogpt-3b |

| gogpt-7b | 70亿参数 | 🤗golaxy/gogpt-7b |

测试效果

TODO

- 进行RLFH训练

- 后续加入中英平行语料

感谢

- Downloads last month

- 1,763

Inference Providers

NEW

This model is not currently available via any of the supported Inference Providers.